“Dile adiós a tu entrenador personal y empieza a entrenar con la inteligencia artificial”, señala un usuario de TikTok. Así es como la inteligencia artificial (IA), concretamente ChatGPT –el chatbot conversacional de la empresa OpenAI capaz de responder a las preguntas o instrucciones que le demos–, se ha colado en el mundo de la actividad física y el deporte. Cada vez más personas recurren a esta herramienta para crear sus rutinas deportivas y lo publican en TikTok. Para ello solo hay que pedirle a ChatGPT que nos haga una rutina de deporte. Este nos devolverá una serie de ejercicios y podremos pedirle, incluso, que los ubique en una tabla y los organice por días.

Sin embargo, lo que a priori puede parecer un avance ha alertado a los expertos, que aseguran que es “peligroso” recurrir a la IA para tratar de llevar una vida más saludable: en la mayoría de los casos, este chatbot no tiene en cuenta factores fundamentales como el peso, lesiones o posibles patologías. No hay que olvidar que recomendar ejercicios sin explicar cómo hacerlos puede ser lesivo. Además, los expertos recuerdan que la IA puede devolver información errónea y carece del factor psicosocial y de acompañamiento que nos daría un entrenador deportivo profesional, algo que consideran “fundamental”.

¿Qué devuelve ChatGPT cuando se le pide una rutina deportiva?

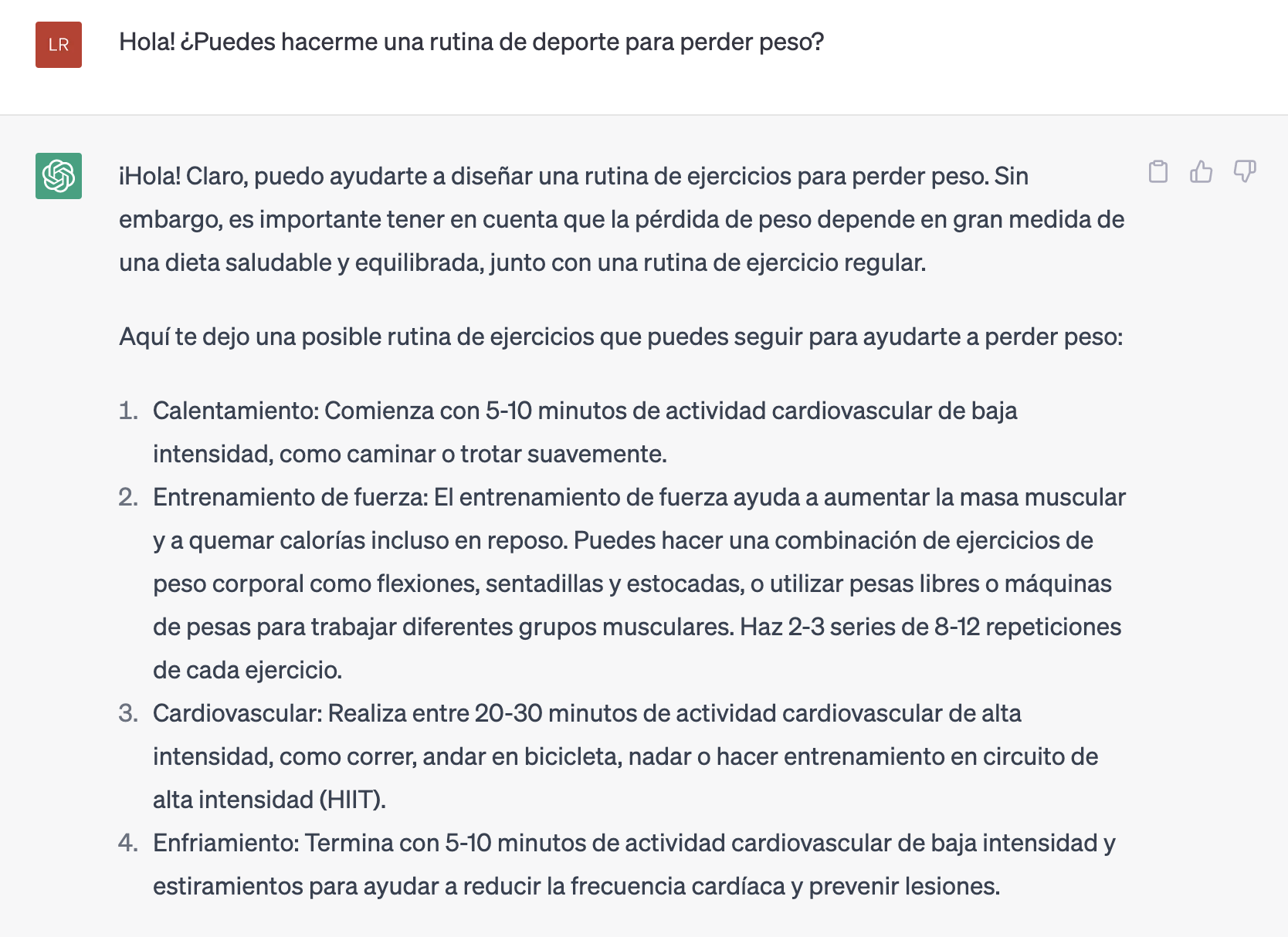

Conseguir que ChatGPT cree para nosotros una rutina deportiva es muy sencillo. Tan solo tenemos que acudir al chatbot y pedírselo. Si le preguntamos por “una rutina deportiva para perder peso”, la herramienta nos devolverá entonces una serie de ejercicios genérica.

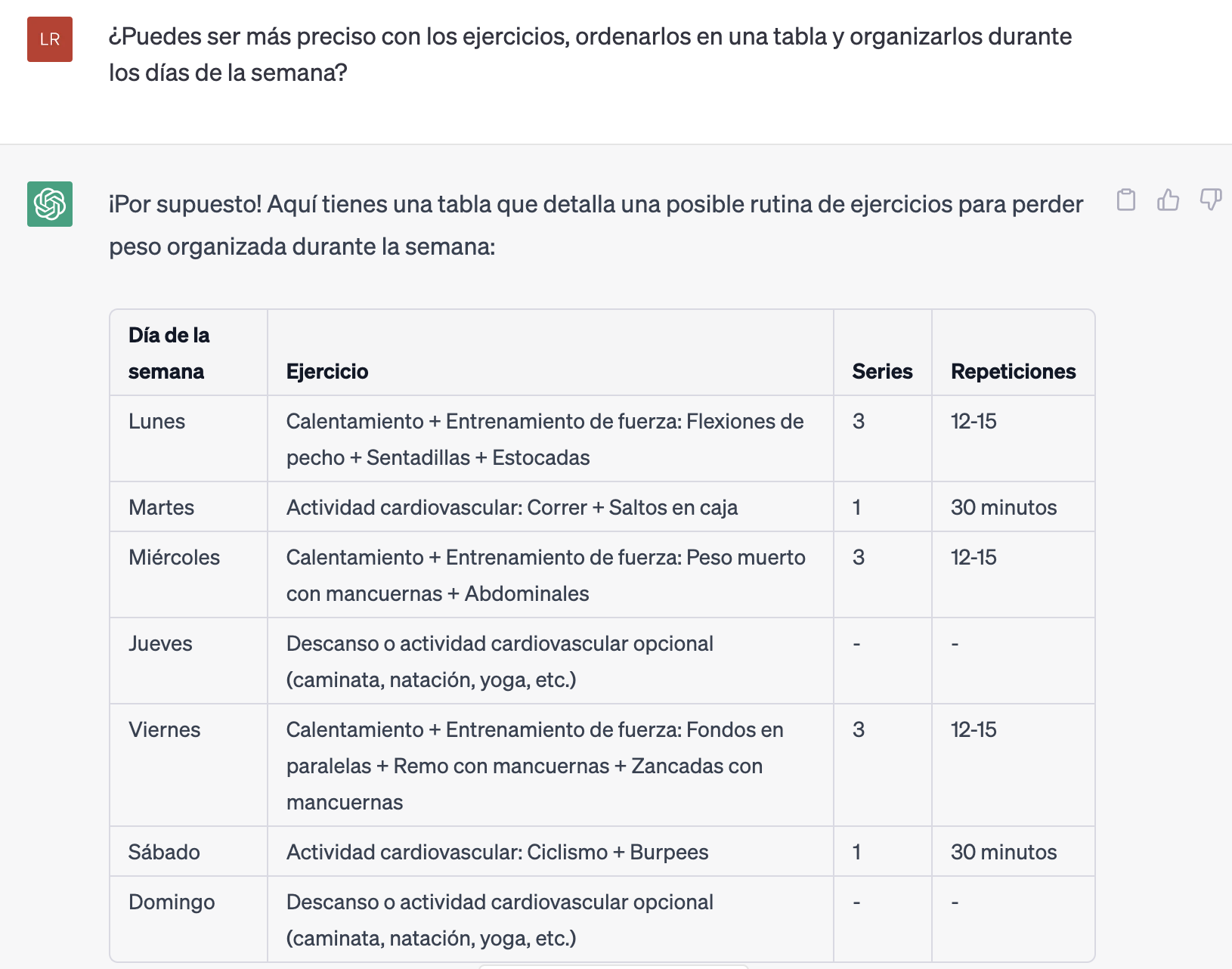

A raíz de esto, podemos seguir testando al chatbot y pedirle más precisión en los ejercicios e, incluso, podemos indicarle que los coloque en una tabla y los organice durante la semana.

ChatGPT no se “inventa” las rutinas de ejercicio de la nada: este tipo de modelos de IA están entrenados con datos, así que las respuestas que nos ofrecen están basadas en la información con la que se le ha preparado (que puede ser buena o mala). De hecho, ChatGPT ni siquiera está conectado a internet y no tiene acceso a la actualidad. Julio Gonzalo, maldito y experto en Inteligencia Artificial, aclara a Maldita.es que los modelos de lenguaje como el de ChatGPT no manejan “conocimiento explícito” sobre el mundo, sino que hablan de oídas: “Han ‘leído’ mucho sobre entrenamientos y rutinas de ejercicio, pero eso no quiere decir que lo hayan entendido. Han aprendido a imitar cuáles son los ejercicios típicos de una rutina”.

Como abordamos en Maldita.es, al final estos modelos son como un loro: pueden replicar conversaciones, pero no entienden qué están diciendo. Por eso pueden proponer rutinas aparentemente válidas. Juan Alonso, experto en IA que forma parte del laboratorio BOTH, resalta a Maldita.es que el modelo “sabe” qué aspecto tiene que tener la respuesta y genera una que sea coherente, pero eso no quiere decir que “sea real” ni adecuada.

¿Puede la IA sustituir a un entrenador personal? Spoiler: no, o al menos no debería

Son muchos los usuarios de TikTok que han decidido poner a prueba esta herramienta y empezar a entrenar con las propuestas que devuelve ChatGPT. Sin embargo, los expertos creen que todavía no está lo suficientemente perfeccionado para poder ofrecer este tipo de información.

@enric.fit ¿Qué te parece esta rutina Push creada por la IA? 🤖🤔 #chatgpt #entrenamiento #fitness #gymrat #pesas #gymtips ♬ Swear By It - Chris Alan Lee

María Rúa, maldita y doctora en actividad física, deporte y ciencias de la salud, lo tiene claro: “La inteligencia artificial no tiene capacidad, a día de hoy, para sustituir a un entrenador”. Como hemos indicado, ChatGPT está entrenado con mucha información, pero la experta resalta que la IA no tiene capacidad crítica para analizarla toda: “Mucha información es mala, está equivocada o no tiene evidencia científica. Esto es peligroso porque la herramienta no es capaz de diferenciarla”.

Las rutinas deportivas son un contenido muy específico y personal, dice Rúa, algo para lo que la herramienta no está lo suficientemente desarrollada. Cada persona, explica, tiene unas características y particularidades por las que la IA no pregunta (como hemos visto en el ejemplo de arriba), como la condición física o posibles patologías o lesiones: “Son datos fundamentales para crear una buena tabla de entrenamiento. A eso, hay que sumarle los conocimientos de un profesional del sector que cuente con capacidades comunicativas y psicosociales para atender a los pacientes, algo que la IA no tiene”.

Esas competencias psicosociales, señala Rúa, implican, por ejemplo, que los entrenadores acompañen a las personas, las apoyen, las animen, les den feedback y corrijan la ejecución de los ejercicios. “Es una parte fundamental del proceso”, insiste. Para la experta esto es “imprescindible”, algo que, reconoce, “nunca va a poder dar una IA”.

Además, la experta insiste en que hay que crear conciencia y mostrar que el ejercicio no es recreativo, sino que tiene que estar en nuestra vida diaria, atender a nuestras necesidades fisiológicas. “No podemos dejarlo en manos de la IA. Como sociedad, tenemos que luchar para exigir que estas prácticas se lleven a cabo por personas cualificadas”, zanja.

¿A qué riesgos nos exponemos si usamos una tabla de ejercicios que nos ha hecho ChatGPT?

Un entrenamiento físico debería estar personalizado en base a multitud de factores. Además de tener en cuenta nuestro sexo, edad, estilo de vida, peso u objetivo, también debe incluir la condición física y patologías o lesiones de la persona que vaya a realizar la rutina de ejercicio.

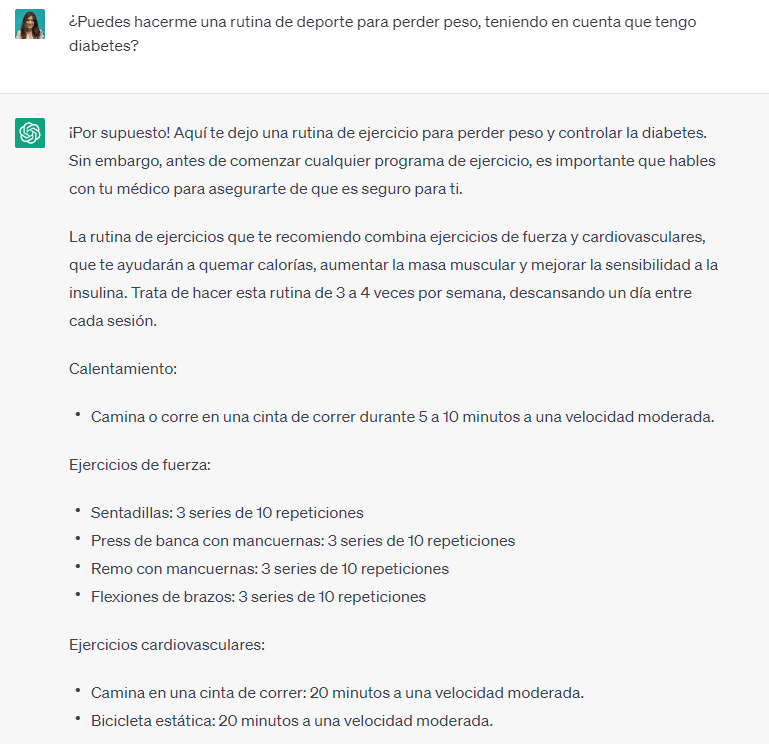

Sin embargo, como hemos visto, ChatGPT no distingue, ni pregunta sobre estas cuestiones, sino que ofrece una rutina deportiva generalizada, lo que implica riesgos. María Rúa pone como ejemplo el caso de un paciente con sobrepeso, hipertensión y diabetes que pudiera solicitar una rutina de entrenamiento a ChatGPT. “Te va a dar una chuleta de ejercicios, una guía general, pero va a estar mal porque no atiende a tu individualización. Por ejemplo, nunca habría que recomendarle a esta persona que corriera porque eso va a afectar a sus articulaciones”.

ChatGPT tendrá en cuenta estas patologías si somos nosotros quienes le advertimos sobre ellas. Sin embargo, eso no hace que sea más fiable, ya que la rutina puede seguir conteniendo información errónea, desactualizada o que no se adapte a nuestras necesidades. Además, la experta añade que enseñar o recomendar ejercicios sin explicar cómo hacerlos puede ser lesivo y causar daños: “El ejercicio físico de alta intensidad hay que ejecutarlo atendiendo a las características de cada persona. No todo el mundo puede hacer los mismos ejercicios ni el mismo número de series o de peso”.

María Paloma Díaz, maldita y experta en IA, explica a Maldita.es que otro problema es que ni los datos con los que se entrena al algoritmo, ni el propio algoritmo son públicos, y como hemos indicado pueden incluir información errónea: “No podemos garantizar que rutinas que puedan ser perjudiciales para salud no se hayan incluído”. Ante el auge de estas aplicaciones, dice Díaz, es muy importante que exista una alfabetización digital de toda la población para que todos entendamos el potencial y las limitaciones de la IA, así como el impacto que pueden tener en las personas y en la sociedad.

En este artículo han colaborado con sus superpoderes los malditos Julio Gonzalo y María Paloma Díaz, expertos en inteligencia artificial, y María Rúa, doctora en actividad física, deporte y ciencias de la salud.

María Paloma Díaz y María Rúa forman parte de Superpoderosas, un proyecto de Maldita.es en colaboración con FECYT que busca aumentar la presencia de científicas y expertas en el discurso público a través de la colaboración en la lucha contra la desinformación.

Gracias a vuestros superpoderes, conocimientos y experiencia podemos luchar más y mejor contra la mentira. La comunidad de Maldita.es sois imprescindibles para parar la desinformación. Ayúdanos en esta batalla: mándanos los bulos que te lleguen a nuestro servicio de Whatsapp, préstanos tus superpoderes, difunde nuestros desmentidos y hazte Embajador.

Primera fecha de publicación de este artículo: 08/05/2023