Los sistemas de reconocimiento de emociones se pueden emplear para detectar las emociones básicas de una persona (como la alegría o la tristeza) a partir de sus expresiones usando sistemas basados en inteligencia artificial (IA). Esta tecnología se puede aplicar en ámbitos como la medicina o la seguridad vial, pero también se está usando para tratar de estudiar la reacción de los comensales ante un plato de comida, una propuesta que ha lanzado el Instituto Tecnológico de Aragón, o buscar tratamientos para personas con trastorno del espectro autista, como con la iniciativa que ha puesto en marcha la Universidad Miguel Hernández de Elche.

Sin embargo esta tecnología puede generar escenarios de discriminación y reforzar sesgos raciales, sobre todocuando se utiliza para la categorización de personas, para la toma de decisiones o en sistemas de videovigilancia. Además, la información sobre nuestro comportamiento se puede usar para obtener otra muy sensible, como datos sobre nuestra salud mental, por lo que está especialmente protegida por el Reglamento General de Protección de Datos.

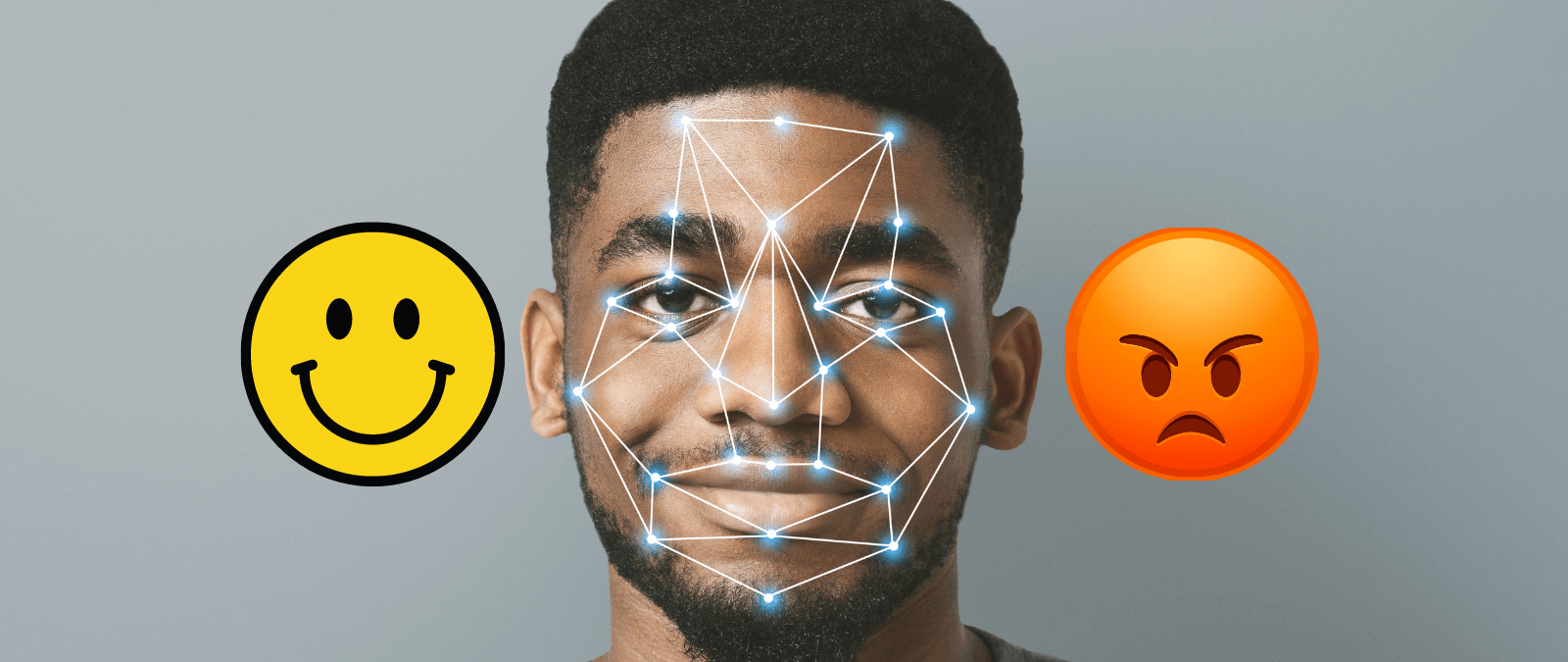

Estos sistemas se pueden emplear para detectar nuestras emociones en base a nuestras expresiones

Los sistemas de reconocimiento facial permiten identificar a una persona de manera casi inequívoca a partir de detalles de su rostro, como la forma de la mandíbula o la distancia entre los ojos, gracias al uso de la inteligencia artificial. Pero nuestra cara no sólo puede servir para identificarnos, también se puede usar para analizar nuestro estado de ánimo a través de lo que se conoce como reconocimiento de emociones: el estudio de las emociones de una persona a partir de sus expresiones faciales.

A diferencia del reconocimiento facial, que sólo estudia las características de nuestros rasgos, el reconocimiento de emociones emplea IA para analizar elementos como el tamaño de nuestra sonrisa o cuánto fruncimos el ceño y así saber si estamos alegres, tristes o enfadados. También puede estudiar otros elementos, como el tono de nuestra voz o nuestros movimientos corporales a partir de vídeos o audios.

Pasos del reconocimiento de emociones a partir de reconocimiento facial. Fuente: EDPS.

Pero no es una ciencia exacta porque, al igual que el reconocimiento facial, funciona en base a una probabilidad: asocia ciertas expresiones con determinadas emociones y calcula un porcentaje en base a esta relación. Inés Cano, asociada en Nuevas Tecnologías en Aledra Legal, especializada en IA y maldita que nos ha prestado sus superpoderes, detalla las emociones “se infieren de la apariencia de nuestra cara y nuestro

cuerpo”, un proceso en el que “existe cierto margen de error”. Esto genera dudas de hasta qué punto estos sistemas son confiables porque cada persona puede expresar sus emociones de una manera diferente.

Victor Rabadan, arquitecto en confiabilidad del sitio (SRE) y maldito que nos ha prestado sus superpoderes, detalla que dos personas no experimentan el mismo tipo de tristeza y que su reconocimiento es algo muy subjetivo, lo que dificulta estos análisis. Cano incide en que las emociones tienen una “naturaleza efímera”, por lo que es importante comprender para qué se van a utilizar y su finalidad concreta. Aquí puedes encontrar más información sobre el funcionamiento del reconocimiento de emociones y su eficacia.

El reconocimiento de emociones tiene aplicaciones en el ámbito sanitario, en seguridad vial y en marketing

En los últimos años el reconocimiento de emociones está en alza gracias al desarrollo y la democratización de la inteligencia artificial: “Donde antes se creaban algoritmos manuales para reconocer emociones, ahora se pone un motor de IA, que es mucho más eficiente a la hora de detectar patrones que un humano”, asegura Rabadan.

Estos sistemas pueden tener distintas aplicaciones. En el ámbito sanitario se puede emplear para ayudar a personas con discapacidad visual a entender las expresiones faciales y la comunicación no verbal de las personas a su alrededor. También se pueden usar en el tratamiento para otro tipo de condiciones. Por ejemplo, la Universidad Miguel Hernández de Elche está investigando cómo el uso de estos sistemas puede ayudar al tratamiento de personas con trastorno del espectro autista.

Esta tecnología también se puede aplicar para estudiar la reacción de una persona ante un estímulo, como la comida. El Instituto Tecnológico de Aragón ha desarrollado un sistema para estudiar la reacción de los comensales ante un menú, una herramienta que puede ser útil a la hora de mejorar la carta de un restaurante.

El reconocimiento de emociones también tiene usos dentro de los estudios de mercado, como analizar las reacciones de los espectadores a una película o el comportamiento de un consumidor en campañas de marketing, y en seguridad vial se pueden aplicar para examinar el estado del conductor y detectar si está en condiciones para ponerse al volante, como el proyecto Genius que está desarrollando la multinacional Antolin.

Estos sistemas tienen limitaciones y no pueden detectar mentiras ni emociones complejas

Pero hay casos en los que esta tecnología aún presenta dificultades, como para detectar mentiras a partir del rostro de una persona. Tampoco pueden identificar las emociones de una persona que lleve tapada la cara con una mascarilla y estos sistemas tienen complicaciones para analizar tonos e inflexiones de la voz que se corresponden con sentimientos y acciones más elaboradas, como puede ser el sarcasmo.

Rabadan explica que estos sistemas tampoco pueden detallar por qué se producen estos sentimientos y su extensión. Pueden emplearse para reconocer un sentimiento de tristeza, pero no arrojan datos sobre cómo de profunda es ni a qué se corresponde. En resumen, a los sistemas de reconocimiento de emociones les cuesta entender sentimientos complejos, analizar en qué contexto se dan y tampoco son capaces de adivinar nuestras intenciones. Por ejemplo, puede interpretar como felicidad una sonrisa que ponemos para salir de una situación incómoda.

Esta tecnología no es infalible y puede crear escenarios de discriminación o reforzar sesgos raciales

El mal uso de estos sistemas también tiene riesgos y pueden crear escenarios de discriminación. Dos personas pueden no mostrar las emociones de una misma manera y, aunque ambas experimenten alegría, el sistema puede detectar sólo a una. Esto genera muchas dudas éticas sobre sus aplicaciones.

El problema se agrava cuando estos sistemas se utilizan para la categorización de personas o para la toma de decisiones, sobre todo si no tienen en cuenta las diferencias culturales y raciales entre ellas, ya que cada sociedad puede expresar las mismas emociones de maneras diferentes. “El reconocimiento facial ya es un sesgo en sí mismo”, argumenta Rabadan.

Un estudio de la Universidad de Maryland muestra que los sistemas de reconocimiento de emociones suelen relacionar a las personas negras con emociones como el enfado más que a las blancas, pese a que ambas mantengan el mismo gesto. Esto puede generar situaciones de injusticia si se emplean estas herramientas en sistemas de videovigilancia o en procesos laborales. Aquí puedes encontrar más información sobre los sesgos del reconocimiento de emociones.

Para evitar escenarios de discriminación, el artículo 22 del Reglamento General de Protección de Datos (RGPD) da derecho a los ciudadanos a “no ser objeto de una decisión basada únicamente en el tratamiento automatizado” que pueda tener efectos jurídicos. Cano señala que tanto el Comité Europeo de Protección de Datos (CEPD) y el Supervisor Europeo de Protección de Datos (SEPD) consideran que la IA para detectar emociones es “altamente indeseable y debería estar prohibida excepto casos específicos”. La AI Act, la propuesta de reglamento del Parlamento Europeo para regular la Inteligencia Artificial, también prohibirá el uso del reconocimiento de emociones en diferentes ámbitos, como el laboral y el escolar.

Aunque nuestros sentimientos no están considerados como un dato personal, el reconocimiento de emociones usa nuestros datos biométricos: rasgos de nuestro físico y comportamiento que nos identifican de forma inequívoca. Lo que significa que nadie nos puede realizar uno de estos análisis sin nuestro consentimiento, ya que estaría infringiendo la RGPD. Aquí puedes encontrar más información sobre el uso de datos biométricos.

En este artículo han colaborado con sus superpoderes la maldita Inés Cano, asociada en Nuevas Tecnologías en Aledra Legal, y Victor Rabadan, arquitecto en confiabilidad del sitio (SRE).

Inés Cano forma parte de Superpoderosas, un proyecto de Maldita.es en colaboración con FECYT que busca aumentar la presencia de científicas y expertas en el discurso público a través de la colaboración en la lucha contra la desinformación.

Gracias a vuestros superpoderes, conocimientos y experiencia podemos luchar más y mejor contra la mentira. La comunidad de Maldita.es sois imprescindibles para parar la desinformación. Ayúdanos en esta batalla: mándanos los bulos que te lleguen a nuestro servicio de WhatsApp, préstanos tus superpoderes, difunde nuestros desmentidos y hazte Embajador.