¡Buenas, malditas y malditos! Bienvenidos un día más al consultorio de Maldita Tecnología, donde resolvemos todas esas dudas que se os pasan por la cabeza relacionadas con el mundo digital. Hoy respondemos dos preguntas relacionadas con la manera en la que la tecnología analiza nuestra cara. Por un lado, analizamos hasta qué punto es seguro ceder a una empresa nuestros datos biométricos para que nos presten un servicio. Por otro lado, explicamos cómo analizan los algoritmos los tonos de la piel de las personas, a raíz de que Google haya anunciado que ha cambiado su sistema de clasificación de imágenes en las que aparece gente.

¡Quédate y te lo contamos! Si tienes más preguntas relacionadas con la tecnología y el mundo digital, somos todo oídos: enviadlas a nuestro Facebook, a Twitter o a nuestro chatbot de WhatsApp (+34 644 229 319), o simplemente dejadlas en este formulario o mandando un mensaje al correo [email protected].

¿Es seguro dar mis datos biométricos para que la organización de un maratón busque fotos que me hayan hecho durante la carrera?

Madrid acogió en abril de 2022 el maratón Rock ‘n’ Roll Running Series, en el que los participantes eran fotografiados por la organización (como en cualquier otro evento deportivo de estas características, podríamos decir). La particularidad de esta carrera es que, una vez finalizada, podías comprar las fotos que habían sacado y, para buscarlas entre el catálogo, ofrecían la opción de buscarlas mediante un sistema de reconocimiento facial. A raíz de este uso específico de la tecnología, nos habéis preguntado hasta qué punto es seguro ceder nuestros datos biométricos y si es proporcional.

Lo primero es señalar que usar alguno de nuestros datos biométricos para tareas cotidianas se está volviendo cada vez más común. Usamos la huella dactilar o nuestros rasgos faciales para desbloquear el móvil, para abrir aplicaciones o para autorizar operaciones en él, por ejemplo. También es habitual en algunos sitios o establecimientos pagar con la palma de la mano o usando una vez más la huella.

En estos casos, algunos de los puntos más importantes a tener en cuenta desde el punto de vista de la seguridad y la privacidad eran la confianza que tuviésemos en la empresa que íbamos a tratar y si se produciría una transferencia de datos a otras compañías. Es decir, ¿qué va a hacer la empresa con esos datos una vez los tenga? ¿Y cuánto tiempo se los va a quedar?

Algunas de estas consideraciones también pueden aplicarse al caso del maratón en Madrid: podemos preguntarnos si confiamos lo suficiente en la empresa que gestiona el sistema de reconocimiento facial y el catálogo de fotos y si nos conviene que traten y usen nuestros datos biométricos para hacer una búsqueda en un catálogo de fotos.

Quizás llegados a este punto te estés preguntando qué diferencia hay entre un selfie que les podamos mandar y una foto de primer plano que un fotógrafo pueda haber sacado durante la carrera. Si ya tienen varias fotos de mí, ¿qué más me da mandarles un selfie? La respuesta es sencilla: quizás tienen un catálogo con varias fotos de ti que pueden usar (porque así lo autorizamos al participar y aceptar su política de privacidad), pero no cuentan con tu autorización para tratar, almacenar o usar tus datos biométricos. Ahí está la clave.

“Estos datos son considerados como de carácter sensible y esto significa que básicamente no pueden ser tratados a no ser que cumplan con una serie de requisitos. Por ejemplo, para su tratamiento, el usuario debería dar su consentimiento explícito para los fines especificados”, nos explica nuestra también maldita Carolina Torrent, especialista en ciberseguridad y ciberinteligencia.

Es el caso del maratón, el programa de reconocimiento facial del catálogo de fotos lo gestiona la plataforma Sportograf, que en su política de privacidad específica que se apoya en nuestro consentimiento para tratar nuestros datos desde el momento en el que subimos el selfie. También aseguran que eliminan la imagen tras el proceso.

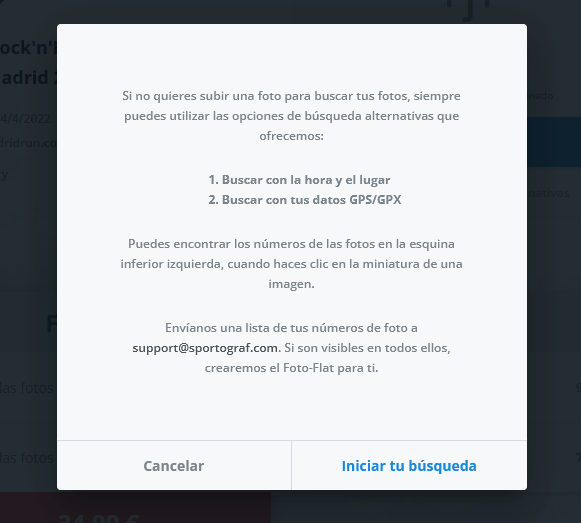

Para evaluar el uso de un sistema de reconocimiento facial, es importante conocer si existen alternativas, es decir, que se proporcione otro método para obtener el mismo resultado que no implique tratar esos datos. En el caso de los pagos con alguno de nuestros datos biométricos, está el pagar en efectivo o con una tarjeta. En este, el sistema da una opción de búsqueda alternativa con la que podemos buscar las fotos por la hora y el lugar por el que se pasó durante la carrera o usando los datos GPS (los corredores son geolocalizados durante el maratón).

Además de una clara exposición de motivos sobre el uso que se le va a dar a los datos y pedir el consentimiento, Torrent recuerda que “también sería importante que tengan unas medidas de seguridad muy específicas para el almacenamiento y correcta protección de estos datos, así como para el acceso a ellos, registrando quién, cuándo y para qué han sido consultados”, señala.

Sobre el uso de datos biométricos para realizar pagos, nuestro maldito Jorge Francos, consultor y analista de sistemas nos explicaba que “se debe tener en cuenta, que pese a que las empresas que manejan estos datos (principalmente por control de accesos) tienen unos estándares de seguridad especiales para ellos, su precio en el mercado negro es muy alto, por lo que en los ataques a empresas, son un objetivo prioritario”. De modo que guardarlos con extremo cuidado es indispensable.

No olvidemos tampoco de las consideraciones legales: antes de implantar un sistema de biometría, se debe realizar lo que se denomina una evaluación de impacto. “El objetivo de este estudio es analizar la necesidad y proporcionalidad del sistema y los riesgos asociados. En definitiva, se trata de una autoevaluación para determinar que el sistema no afecta de forma grave a la privacidad de las personas a las que va dirigido y para detectar los riesgos para la seguridad, reputación, privacidad, etc. que puede tener el uso de la tecnología”, explica el abogado especializado en protección de datos Jorge Campanillas en este artículo en The Conversation.

Al final, estas recomendaciones se pueden aplicar a casos generales en los que se use una tecnología como el reconocimiento facial para una necesidad ‘menor’ que podría resolverse usando un método alternativo. “Habitualmente, este tipo de datos se usa para sistemas de seguridad en los que se utilizan datos como la huella dactilar o el reconocimiento facial como método de acceso a dispositivos o a centros de alta seguridad. Siendo menos habitual su uso para eventos de este tipo, por lo tanto, sería algo a considerar por el usuario que cede sus datos”, expone Torrent.

La especialista también apunta como recomendación general para controlar nuestra exposición que “la mejor forma de que nuestros datos no se vean comprometidos o expuestos siempre va a ser hacer un uso responsable de ellos y no cederlos a la ligera, ya sea para hacer uso de un simple descuento, para un evento o para fines cuyo beneficio no sea tan alto como el valor del dato que cedes”, además de leer siempre “con detenimiento cómo se hará el tratamiento de estos datos y una vez tengamos la imagen completa, hacer una decisión consciente”.

“No obstante, si finalmente se cediera el uso de estos datos, siempre se puede solicitar que se borren tras la relación comercial con esta carrera o con la empresa a la que se hayan cedido, para evitar de esta forma que sigan almacenándolos”, remarca.

¿Qué importancia tienen los tonos de piel que se elijan para los algoritmos que reconocen a personas en imágenes?

No paramos de hablar del reconocimiento facial. Es muy probable que te suene por leerlo en medios de comunicación, en redes sociales como Facebook o Instagram e incluso en situaciones de nuestro mundo analógico, como al ir a embarcar un avión en un aeropuerto. Sin embargo, hay muchos tipos de reconocimiento de imágenes, no solo el que identifica a una persona a partir de una foto de su cara. La tecnología que ‘reconoce’ imágenes se programa para que sepa que en una imagen aparece un árbol, un gato o una moto y etiquetarlo como tal.

En el caso de las personas, también se puede aplicar el reconocimiento de imágenes, sin que tenga que usarse necesariamente reconocimiento facial. En este caso, el programa informático reconoce que en la imagen hay una persona, aunque no sepa quién es. Te hablamos a fondo de cómo funcionan estos sistemas en este artículo sobre cómo funcionan los filtros de redes como Instagram o TikTok.

El problema es que, a lo largo de los años, nos hemos encontrado con que los algoritmos de empresas destacadas por su trabajo con la inteligencia artificial, como Google o Meta (Facebook), han presentado graves problemas a la hora de clasificar a personas con la piel oscura. Incluso, han llegado a etiquetar imágenes de personas con la piel negra como si fuesen simios. El caso de Google fue muy sonado en 2015 y a Facebook le pasó recientemente, en 2021. También ha tenido problemas Twitter: los parámetros de su algoritmo de reconocimiento de imágenes tendían a destacar las imágenes en las que salían personas con la piel blanca al recortarlas. La primera reacción de las empresas era común: salir a disculparse por el error, pero sin dejar de usar la tecnología. Twitter, concretamente, sí que hizo un análisis interno para comprobar si su algoritmo podría presentar sesgos (la conclusión fue que sí).

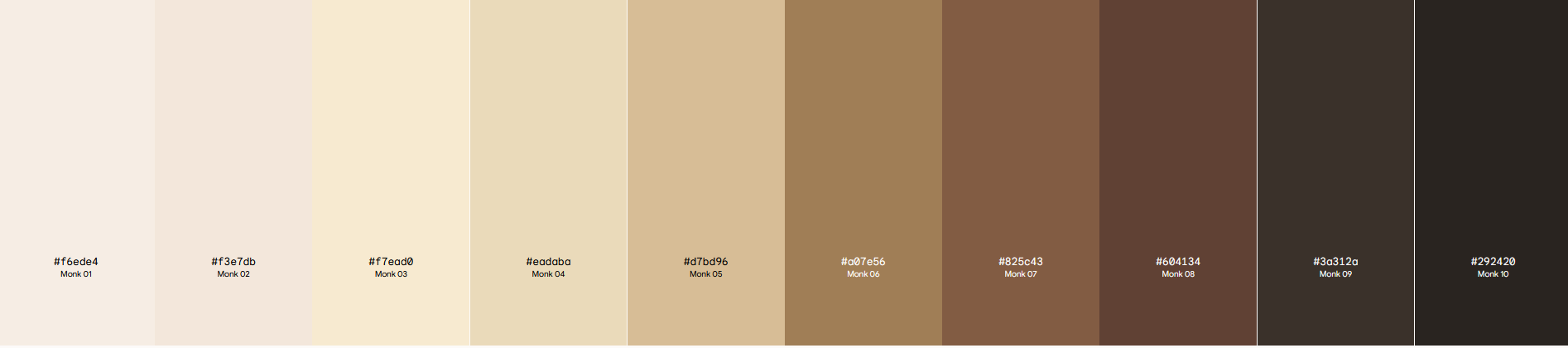

En esta línea, en mayo de 2022, Google anunció que estaba colaborando con el sociólogo y profesor de Harvard Ellis Monk para implementar una escala diseñada para ser “más inclusiva con el espectro de tonos de piel que vemos en la sociedad”. De aquí sale la escala de tonos de piel Monk (Monk Skin Tone o MST en inglés), que incluye diez tonos diferentes que, según dicen, son más “representativos”, especialmente de las personas con la piel negra.

“La escala MST nos ayudará tanto a nosotros como a la industria tecnológica en general a crear conjuntos de datos más representativos para poder entrenar y evaluar los modelos de inteligencia artificial en equidad, que resultará en funcionalidades y productos que funcionen mejor para todos y para todos los tonos de piel. Por ejemplo, utilizamos la escala para evaluar y mejorar los modelos que detectan rostros en las imágenes”, escribe en el blog de Google Tulsee Doshi, jefa de Producto e Inteligencia Responsable de la empresa.

Según informa Google, aplicarán esta escala en sus productos de clasificación de imágenes basados en inteligencia artificial, como la búsqueda de imágenes en Google o “Photos”, su programa de almacenamiento y etiquetado de imágenes disponible para Android.

Timnit Gebru, una exinvestigadora en ética de la Inteligencia Artificial en Google, trabajó en esta acción antes de que fuese despedida por la empresa por señalar que en el desarrollo de la tecnología se estaban obviando importantes consideraciones de los fallos que tienen hacia las personas racializadas y ciertas minorías. Asegura que ella introdujo el trabajo de Ellis Monk en Google, a pesar de que la echasen de su puesto por poner en evidencia la posición de la multinacional ante los temas relacionados con la IA y el racismo. Su caso desembocó en una polémica global.

Thank you Google for talking about the "pioneering" gender shades study & talking about the Monk scale that I introduced you to :)

— Timnit Gebru (@timnitGebru) May 11, 2022

I met Dr. Ellis Monk when I was interviewing at Harvard

https://t.co/IGCZh5YrzQ

Sabemos que el reconocimiento de imágenes clasifica en ocasiones de forma errónea a las personas -en el peor de los casos, confundiéndolas con primates-, y también que el reconocimiento facial presenta más fallos y falsos positivos cuando analizan a personas negras, especialmente si hablamos de las mujeres, tal y como te hemos contado en otras ocasiones en Maldita.es.

“El problema de base de cuando se dice que la IA es racista viene de reconocer la existencia de la raza a nivel fenotípico”, señala Javier Sánchez Monedero, investigador en inteligencia artificial del Data Justice Lab y la Universidad de Córdoba y miembro de AlgoRace. Para evaluar el rendimiento de un algoritmo, se piensa en hacer “subescalas por distintos tonos de piel u oscuridad” para que los sistemas no fallen, ya que los errores provienen de la falta de representación de la piel oscura.

Implementar este tipo de ‘subescalas’ contempla que el problema que presentan estas tecnologías es el “binarismo” que se asocia a que solo haya personas “blancas” o “negras”. Para explicarlo, el especialista pone un ejemplo usado en la medicina: “Es como si en vez de asumir que solo hay jóvenes y ancianos, se van estableciendo rangos de edad en diez en diez. En medicina esto se llama estratificación de la muestra: hasta tal rango de edad se recomienda una dosis y hasta el siguiente otra”, expone.

Desde Maldita.es, nos hemos puesto en contacto con Google para preguntar por la aplicación de esta escala y para conocer cuál utilizaban previamente, pero al momento de publicación de este artículo no hemos recibido respuesta.

¡Un minuto más!

No somos técnicos o ingenieros pero contamos con mucha ayuda de personas que son expertas en su campo para resolver vuestras dudas. Tampoco podemos deciros qué servicio usar o dejar de usar, solo os informamos para que luego decidáis cuál queréis usar y cómo. Porque definitivamente, juntos y juntas es más difícil que nos la cuelen.

Si tenéis cualquier duda sobre esta información o cualquier otra relacionada con la manera de la que te relacionas con todo lo digital, háznosla llegar:

En este artículo ha colaborado con sus superpoderes la maldita Carolina Torrent, especialista en ciberinteligencia.

Gracias a vuestros superpoderes, conocimientos y experiencia podemos luchar más y mejor contra la mentira. La comunidad de Maldita.es sois imprescindibles para parar la desinformación. Ayúdanos en esta batalla: mándanos los bulos que te lleguen a nuestro servicio de Whatsapp, préstanos tus superpoderes, difunde nuestros desmentidos y hazte Embajador.