Están circulando contenidos que acusan a Maldita.es y a Newtral de “censurar” publicaciones de carácter político en Facebook con etiquetas de “contenido delicado”. Esta advertencia la incluye Facebook en los posts que la propia red social ha considerado que pueden contener imágenes o contenido gráfico sensible para los usuarios, pero no tiene nada que ver con la actuación de los verificadores. Es falso que dicho contenido haya sido marcado como “delicado” por parte de los verificadores: es una decisión única y exclusiva de Facebook en base a sus normas comunitarias que no tiene nada que ver con el trabajo de las organizaciones de fact-checking.

Las organizaciones de fact-checking que colaboran con Facebook en el programa de verificación por parte de terceros, como Maldita.es, Newtral, EFE Verifica y AFP en España, pueden señalar como “falso”, “parcialmente falso”, “alterado” o “falto de contexto” un contenido que circula por la red social, pero en ese caso el aviso que se muestra es diferente y siempre se muestra un artículo en el que explicamos con fuentes y datos por qué se ha marcado así el contenido.

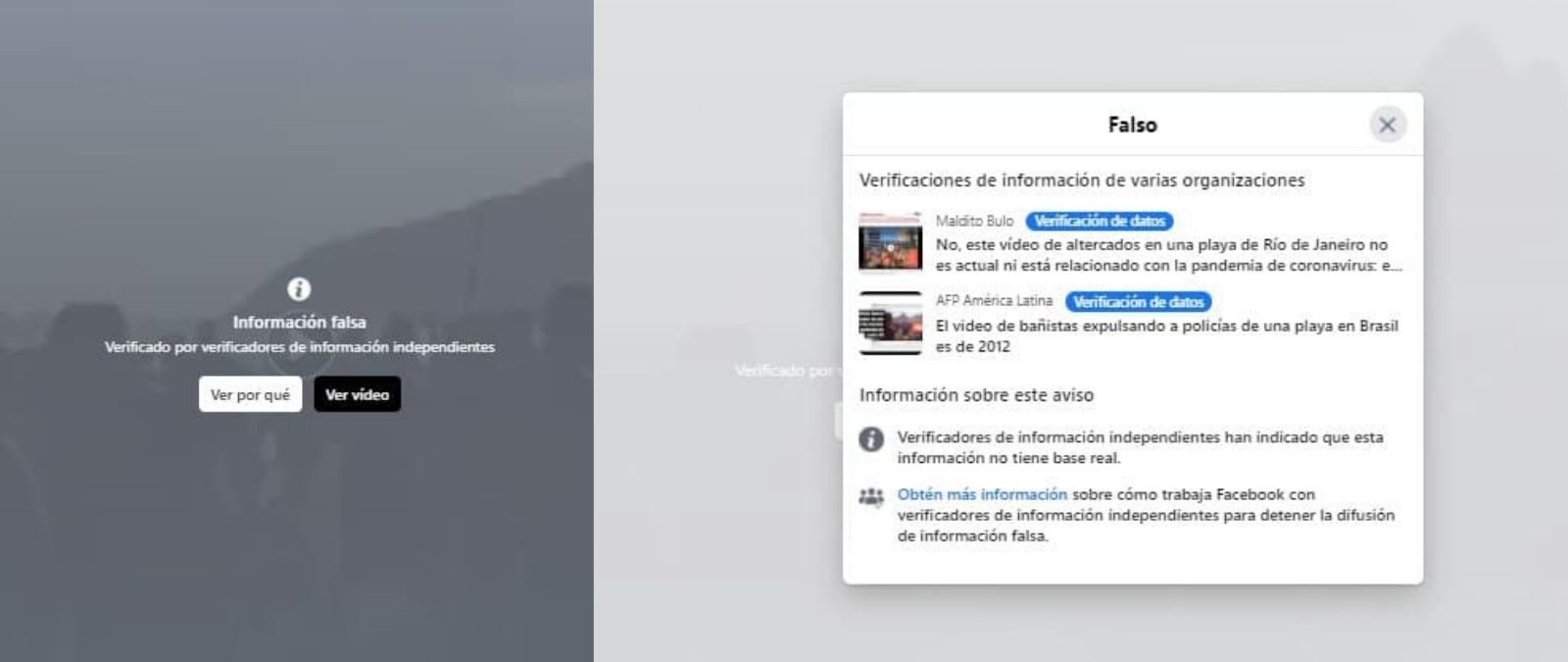

Cuando un fact-checker independiente ha verificado que un contenido es falso, no aparece una etiqueta que advierte de material “delicado”, sino una que señala que hay “información falsa”. Además, siempre se da la opción de “ver por qué”. En ningún caso se restringe el acceso al contenido ni se borra, sólo se aporta esta información previa.

Cómo funciona el programa de verificación de datos externo de Facebook

En marzo de 2019, Maldita.es, junto a otros organizaciones de verificación y medios, se sumó al programa de verificación de datos por parte de terceros de Facebook. En él ya participaban más organizaciones de fact-checking internacionales y su objetivo es reducir la desinformación que se difunde en la plataforma al dar la opción a los usuarios de leer desmentidos que proporcionan pruebas y datos frente a contenidos falsos o parcialmente falsos. ¿Cómo funciona? Cuando detectamos una información falsa o que necesita contexto, redactamos un artículo en base a nuestra metodología, pero Facebook no nos puede decir nunca qué tenemos que desmentir y qué no.

Una vez redactado el artículo, Facebook coloca un aviso al contenido en cuestión, que como decimos no se borra ni se retira de la plataforma y sigue siendo accesible para cualquier usuario; reduce su impacto y avisa a todos los usuarios que han interaccionado previamente con el contenido de que ha sido marcado como falso. Además, para aquellas páginas que monetizan su contenido en la plataforma (lo publicitan para darle más visibilidad) puede, si son reincidentes, limitar esta capacidad temporalmente.

Lo que hace Facebook es colocar una advertencia encima de algunas publicaciones que alerta de que contienen “información falsa” que ha sido “verificada por verificadores de información independientes”. Junto al botón de “ver por qué”, sigue apareciendo la opción de acceder al contenido. Si pinchamos en el motivo, nos aparecen enlazados los diferentes artículos que han escrito al respecto no solo Maldita.es sino cualquier fact-checker que pertenezca al programa:

Los verificadores no marcan un contenido como “delicado”. Las categorías de desinformación que podemos tratar son las siguientes: falso, mixto, título falso, verdadero, no aplicable, sátira, opinión, fuente de noticias bromistas y no calificado.

Como ya contamos en este extenso artículo sobre el funcionamiento de Maldita.es, sigue siendo Facebook quien toma ciertas decisiones: es la plataforma quien avisa a las personas que han interactuado en algún momento con el contenido desmentido; reduce su visibilidad en el feed en hasta un 80%; y además limita la capacidad de la página que lo haya subido de publicitar contenidos. Estas son medidas que toma Facebook y que los verificadores no controlan.

Por qué no tiene nada que ver con las advertencias que pone la propia red social

El programa de verificación de terceros no tiene nada que ver con las normas que establece la propia red social. En este post, Facebook alerta de que pueden aparecer avisos de contenido sensible o delicado en algunas publicaciones si estas contienen una foto o un vídeo “inapropiado o difícil de ver para ciertas personas”. También en caso de que estén visibles “solo para personas mayores de 18 años”.

El contenido que Facebook marca como “delicado” tampoco se retira de la plataforma. Únicamente aparece tras un aviso para dar la opción al usuario de elegir si quiere verlo o no. Eso sí, es Facebook y sólo Facebook quien elige qué contenido entra bajo este paraguas y cuál no.

¿Qué considera Facebook que es un contenido delicado”?

Según sus Normas Comunitarias, estos avisos pueden aparecer en “contenido violento o gráfico”. Las razones que da a los usuarios sobre por qué colocan ese aviso previo a una publicación incluyen que hay personas que pueden sentirse “molestas” ante una foto, que el contenido puede ser “cruel” o “insensible” u “ofensivo” o “perturbador”.

La red social dice en el apartado de “Contenido gráfico y violento” que permiten “contenido gráfico (con algunas limitaciones) para concienciar a las personas sobre determinados asuntos” y pone como ejemplo la vulneración de los derechos humanos o los actos de terrorismo. Explica que hay “diferentes niveles de sensibilidad” en esas discusiones, por lo que añade “una etiqueta de advertencia al contenido particularmente gráfico o violento para que no accedan a él personas menores de 18 años y para que sean conscientes de la naturaleza gráfica o violenta del contenido antes de hacer clic para verlo”.

En cuanto al caso concreto de la publicación con las declaraciones de Alejandro Fernández, la compañía ha afirmado a Maldita.es que la marcaron como "contenido delicado" por "error" y que ya han retirado el aviso. *

Facebook no explica cómo decide qué contenidos llevan este aviso o no. Tampoco sabemos si esa decisión la toma automáticamente un algoritmo o si hay intervención humana. La compañía no ha respondido a esta cuestión, que consultamos desde Maldita.es.

La transparencia es clave para una moderación de contenidos creíble

En todos los debates sobre cómo mejorar la lucha contra la desinformación en las redes sociales, Maldita.es siempre insiste en que el primer paso es que las grandes plataformas sean más transparentes en sus políticas de moderación. Si el usuario no sabe por qué toman ciertas decisiones, como la de poner una advertencia de “contenido sensible”, puede interpretarlo como una censura caprichosa. Para que su política de moderación sea creíble, una plataforma tiene que explicar cómo se toman esas decisiones y en función de qué datos objetivos. Y ceñirse siempre a la misma metodología.

* Hemos actualizado esta pieza para incluir la respuesta de Facebook a nuestra consulta.

Primera fecha de publicación de este artículo: 23/04/2021