En lo que llevamos de 2023, se han lanzado dos cartas abiertas a la inteligencia artificial (IA); cartas encabezadas por personas muy conocidas en la industria y que manifiestan preocupaciones en torno a esta tecnología.

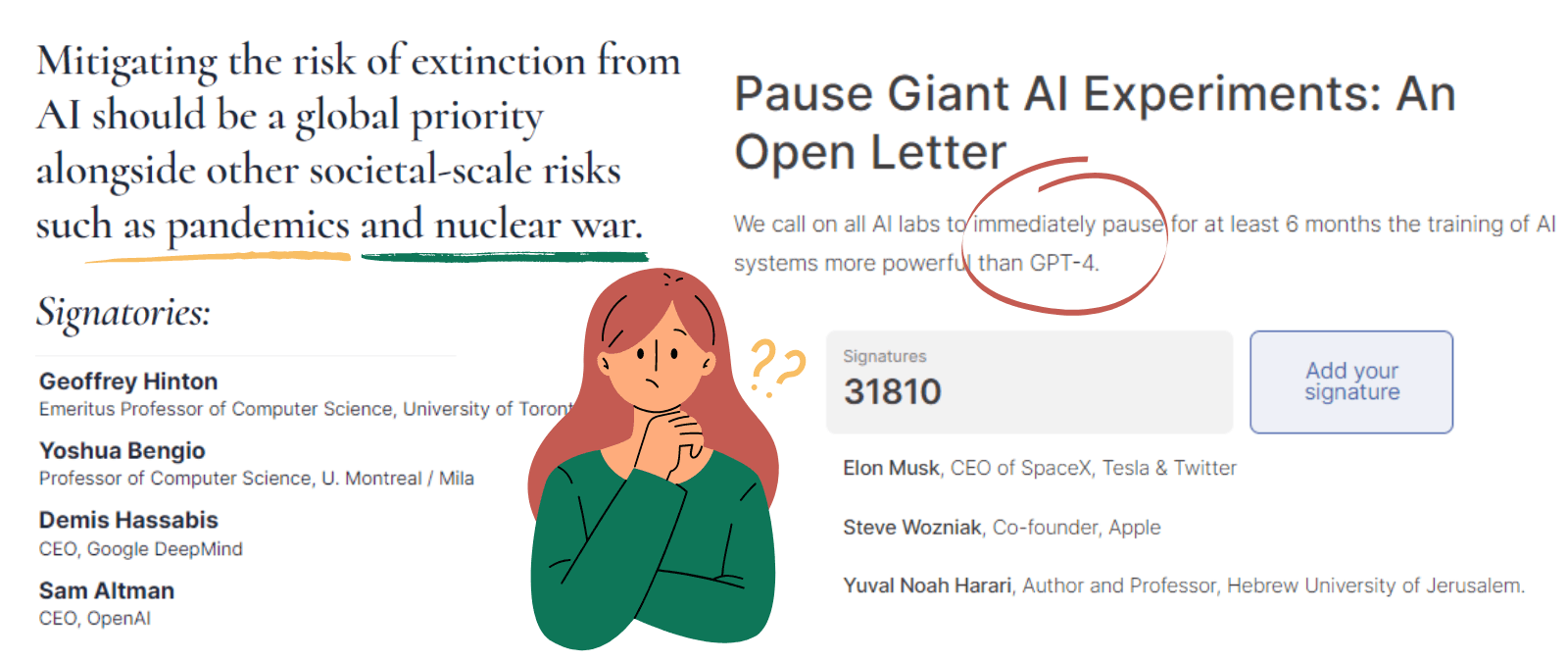

En la primera, del 22 de marzo, cientos de expertos pedían parar (durante seis meses) “la peligrosa carrera y los experimentos gigantes de la inteligencia artificial hasta que se alcance una hoja de ruta común”. En el escrito se solicita que los sistemas sean más precisos, seguros, interpretables, transparentes, robustos y neutrales, y se pide establecer como tecnología límite GPT-4, la última y más avanzada inteligencia artificial de OpenAI, la compañía de investigación de IA creadora de ChatGPT. Aquí se puede leer la carta íntegra. Entre sus firmantes, empresarios, académicos e intelectuales como Elon Musk, Steve Wozniak (cofundador de Apple), Yuval Noah Harari y Carles Sierra (director del Instituto de Investigación de Inteligencia Artificial del CSIC).

La segunda se publicó el 30 de mayo y contiene exactamente 22 palabras (en inglés). En ella se pide equiparar el riesgo de la inteligencia artificial a otros prioritarios como las pandemias y la guerra nuclear. No se hace referencia a ninguna moratoria ni nada más concreto. Se puede leer aquí, y la firman entre otros Sam Altman (CEO de la propia OpenAI), Demis Hassabis (Google DeepMind), y los investigadores Geoffrey Hinton y Yoshua Bengio, los llamados “padrinos de la inteligencia artificial” y Premio Turing en 2018.

¿Tiene todo esto sentido? ¿Es la situación con la IA tan alarmista? ¿Realmente se puede “parar” el desarrollo de la inteligencia artificial? Hablamos en la Maldita Twitchería Tecnológica con seis expertos de distintos ámbitos para entender qué está pasando desde el enfoque universitario, de investigación y de las empresas, y el punto de vista de la ética, derechos civiles, políticas públicas y legislación.

“Abordar la inteligencia artificial en un diálogo a cuatro partes: la ciencia, la industria, la sociedad y el derecho”

¿Tiene sentido una moratoria de la inteligencia artificial, como pide la primera carta? “Parar, ¿qué? ¿La investigación a todo tipo de aplicaciones, el uso comercial, el uso de ciertos gobiernos…? El planteamiento es impreciso”, se pregunta Teresa Rodríguez de las Heras, profesora titular de Derecho Mercantil y miembro de los Grupos de Expertos de la Comisión Europea sobre IA, Plataformas y Data Sharing.

La experta cree que hay una gran incertidumbre y que por eso “la respuesta está demasiado centrada en los riesgos e ignora los enormes beneficios que nos puede dar la IA si se asegura que el control está donde debe estar”. Por supuesto que “tiene riesgos, sería muy ingenuo ignorarlos, porque además está teniendo un impacto social de gran calado, pero plantearlo de manera tan alarmista me parece que centra el discurso en un problema que se va a abordar de forma poco serena y tranquilizadora”, explica a Maldita.es.

¿Cómo abordarlo entonces? Rodríguez de las Heras considera que no desde la prohibición de la tecnología, sino desde sus usos y con un diálogo a cuatro partes: la ciencia, la industria, la sociedad y el derecho o la política. “Si los mensajes vienen solo de un ángulo, paralizan a la población o hacen que la regulación tenga que actuar de forma precipitada; no es la mejor manera”, añade.

¿Se puede hacer algo a nivel global? “En este tema hay elementos de geopolítica muy delicados. En Naciones Unidas se está trabajando para desarrollar principios en el uso de inteligencia artificial. Llegar a un consejo global es absolutamente deseable, óptimo e ideal, pero muy complicado”, concluye.

“La inteligencia artificial no deja de ser un programa de ordenador”

Javier Sánchez Monedero, investigador Beatriz Galindo en Universidad de Córdoba y experto en inteligencia artificial, coincide con Rodríguez de las Heras y se pregunta qué quiere decir una pausa global de la IA: “¿A qué nos referimos, dejamos de investigar, dónde empieza la IA y la estadística? Porque en las universidades la mayoría de las investigaciones se centran en simulaciones por ordenador, métodos estadísticos de análisis…”.

En este sentido recuerda que la inteligencia artificial “no deja de ser un programa de ordenador”.

La diferencia es que ahora se nos ha presentado al público general de manera muy accesible. “Los modelos de IA que hacían resúmenes o generaban código automáticamente ya se habían desarrollado antes, pero te daban un formulario web espartano; ahora se presenta esta interfaz que habla en primera persona y nos hace preguntarnos si tienen conciencia. No es naif, porque tiene mucho que ver con el éxito de ChatGPT”, considera Sánchez Monedero.

“El mal uso está en pensar que esto es algo que sirve para todo y que no requiere ningún tipo de supervisión humana”

Hemos hablado de algunos de los riesgos que puede conllevar la inteligencia artificial: luces y sombras de la que genera imágenes, los peligros de difundir sin contexto un contenido creado por IA y escenarios en los que un chatbot puede generar un daño. ¿Hay algún riesgo equiparable a una guerra nuclear o una pandemia, como ejemplifica la segunda carta?

Ángel Delgado Panadero, ingeniero de inteligencia artificial y machine learning en Paradigma Digital, y maldito que nos ha prestado sus superpoderes, cree que en ese manifiesto se ha intentado hacer un enfoque general para que todo el mundo estuviera de acuerdo, en contraposición a la primera. “La primera carta estaba enfocada en que no querían que aparecieran más algoritmos y se estaba poniendo una empresa (OpenAI) como límite de lo que se debe hacer al mencionar GPT-4. En cambio, la segunda carta parece más amplia porque no se puede estar en contra de regular los riesgos de la IA”, explica.

Sin embargo, considera que la comparación no ha sido acertada: “Tiene que preocuparnos la inteligencia artificial porque debe haber una legislación al respecto sólida como la que habría en caso de guerra nuclear o pandemia, pero no se puede equiparar”.

Además, Delgado coincide con Rodríguez de las Heras y Sánchez en que “se habla de la IA como si fuera un ente pero es un abanico muy amplio y no tiene sentido el concepto de parar la inteligencia artificial, ¿parar el qué?”. Desde el punto de vista de la industria, Delgado cuenta que cuando una empresa quiere una IA suele ser para automatizar o simplificar casos de uso muy concretos y controlados, y con una aplicación beneficiosa. Por ejemplo, algoritmos de IA para una empresa de gestión de flotas para saber cómo llenar un camión de forma óptima, diseñar la ruta y satisfacer toda la demanda. “Creo que el mal uso está en pensar que esto es algo que sirve para todo y que no requiere ningún tipo de supervisión humana”, resume.

“La empresas deben plantearse principios éticos y de responsabilidad ante la inteligencia artificial”

La inteligencia artificial también debe abordarse desde un punto de vista ético y responsable. Por eso preguntamos sobre estas cartas a Mónica Villas, autora de 'Manual de ética aplicada a la IA', asesora de tecnología y docente. “Creo que la segunda carta es un poco exagerada y busca llamar la atención. No veo dónde vamos a acabar en guerra nuclear ni una pandemia. Pero sí que estoy convencida de que hay que alcanzar un acuerdo global, y nos queda mucho”, indica Villas.

Antes de esperar a que llegue esa regulación, Villas anima a que se haga algo también desde dentro de las propias compañías: “A las empresas les tiene que empezar a preocupar no solo la parte monetaria, también la de responsabilidad y reputación, y plantearse unos principios éticos. Tenemos que pensar qué estamos haciendo con la IA, porque la responsabilidad es humana y no podemos delegarla a las máquinas”.

La experta recuerda que además de hablar del tema ético hay que poner límites, pensar en sesgos, ver qué datos está usando la IA y tener en cuenta la privacidad. “Al final se trata de volver al sentido común, la responsabilidad y el pensamiento crítico, y la regulación nos puede ayudar; en eso somos referentes en Europa”, concluye.

“Hay preocupaciones muy concretas y aplicaciones muy reales que sí están pasando a día de hoy”

Si miramos a los riesgos, también hay que mirar en cómo afectan directamente a las personas. Por eso, “desde el punto de vista de la sociedad civil nos interesa cómo se va a regular la inteligencia artificial, y pedimos que se garantice la protección de los derechos fundamentales en el reglamento de la IA”, sostiene Diego Naranjo, director de incidencia política en la agrupación European Digital Rights (EDRi).

Naranjo cree que “derivar la atención a una posible máquina tipo Terminator que va a acabar la humanidad distrae de otras amenazas reales, como el cambio climático o una guerra nuclear, para los que no necesitamos inteligencia artificial”. También distrae de una serie de prácticas relacionadas con la IA que sí habría que vigilar: la identificación biométrica remota en espacios públicos, el reconocimiento facial, el uso de la policía predictiva, reconocimiento de las emociones o el uso de la IA en inmigración.

“Lejos de llamar a esos mensajes tan alarmistas hay preocupaciones muy concretas y aplicaciones muy reales que sí están pasando a día de hoy. La idea no es parar la tecnología, pero sí regularla. Estamos en un momento crucial”, concluye Naranjo.

“Si para regular no escuchamos todas las voces, lo que se cree no será valioso”

Los expertos han mencionado constantemente la importancia de la regulación y, aunque pueda parecer que va por detrás de la tecnología, se está avanzando a gran velocidad si se compara con la regulación a redes sociales y otras plataformas, considera Marina Sacristán, asistente de Políticas Públicas en Maldita.es.

“Ahora tenemos muy claro que hay que regular, nos parece obvio que hay riesgos. Esto es un avance de dónde se venía antes, cuando las grandes tecnológicas eran intocables, ¿cómo íbamos a parar la innovación? Hasta 2022 no hemos tenido una Ley de Servicios Digitales (DSA) europea”, recuerda Sacristán. Pero ya no estamos ahí, especialmente en Europa: “Se habla del efecto Bruselas, porque la Unión Europea fue una de las primeras en regular a las plataformas y poco a poco se están proponiendo leyes”, añade.

Como decía al principio Rodríguez de las Heras, mencionando una conversación coral entre ciencia, industria, sociedad y derecho, Sacristán cree que “si para regular la inteligencia artificial no escuchamos todas las voces, lo que se cree no será valioso”.

En este artículo ha colaborado con sus superpoderes el maldito Ángel Delgado Panadero, ingeniero de inteligencia artificial y machine learning en Paradigma Digital.

Gracias a vuestros superpoderes, conocimientos y experiencia podemos luchar más y mejor contra la mentira. La comunidad de Maldita.es sois imprescindibles para parar la desinformación. Ayúdanos en esta batalla: mándanos los bulos que te lleguen a nuestro servicio de Whatsapp, préstanos tus superpoderes, difunde nuestros desmentidos y hazte Embajador.