Desde que la inteligencia artificial (IA) comenzó a automatizar procesos y ser cada vez más autónoma, se están dando situaciones donde hay que identificar quién es responsable si algo sale mal. Los ejemplos más claros son los accidentes en los que hay un coche autónomo implicado, problemas con drones que causen daños o incidentes con máquinas que funcionen con IA. En esos casos nos imaginamos robots causando un daño físico, y esto es algo que ya se está analizando para poder regularlo.

Pero, ahora que estamos viviendo la carrera por la IA en forma de chatbot conversacional, ¿qué pasa si un modelo de IA, como ChatGPT o YouChat, contesta algo que tiene consecuencias? Como incitar a un usuario a decir 'Heil Hitler’ o difundir conspiranoias. Aunque no haya una acción física por parte de un chatbot, lo que responde puede también generar daños. En ese caso, ¿de quién es la responsabilidad?

¿En qué escenarios podría un chat de inteligencia artificial generar un daño?

“Desde un punto de vista jurídico, la responsabilidad se activa cuando se produce un daño, y entonces hay que identificar quién es el responsable y quién va a indemnizar ese daño”, sintetiza a Maldita.es Teresa Rodríguez de las Heras, docente y miembro del grupo de expertos en Nuevas Tecnologías, Prevención y Seguro en la Comisión Europea.

¿Qué tipo de daño puede generar un modelo conversacional de inteligencia artificial? Sabemos que estos sistemas no siempre contestan la verdad y que todos los chatbots conocidos pueden registrar errores en sus respuestas. Los efectos de esto pueden ser muy distintos.

Puede que el chatbot “facilite información sobre que no te debes vacunar, un diagnóstico médico erróneo o diga que cierto tipo de setas es comestible, pero en realidad sean altamente tóxicas y se produzca una consecuencia tan grave como un fallecimiento”, ejemplifica Rodríguez de las Heras. Con sus respuestas también podría acusar a una persona de corrupción o presentar resultados que digan que ha habido fraude en unas elecciones, y que esto provoque una reacción violenta y un asalto al Capitolio.

También podría compartir una información que afirme que va a bajar el precio de las casas y que “esto haga que la gente venda sus inmuebles de forma alocada”, dice la experta. Para Rodríguez de las Heras, hay un interés colectivo que se puede ver amenazado por la desinformación, ya que atender a las respuestas de un chatbot de IA puede causar “un supuesto general de confusión y una sensación de no poder distinguir qué informaciones son correctas y cuáles no”. Javier Morales y Diana Loyola de la Universidad Pontificia Comillas escribieron en The Conversation que la propagación de información falsa podría venir también de la falta de contexto y entendimiento de las implicaciones éticas, culturales o políticas de los que carecen este tipo de modelos.

Estos casos serán “supuestos de responsabilidad” cuando a partir de este tipo de informaciones se produzca “un daño que se deba indemnizar, ya sea físico, económico o moral, como por ejemplo un daño reputacional”. Sin embargo, “no todos los supuestos van a generar responsabilidad y por tanto no todos van a permitir aplicar las soluciones que estamos tratando de desarrollar a nivel europeo”, especifica la experta.

¿Puede la IA ser un sujeto con responsabilidad? Aún no hay nada establecido a nivel legal, pero podrían ser responsables el desarrollador de la IA o el que la usa

Pensemos entonces que hay un chatbot impulsado con inteligencia artificial que “genera” un daño con “sus” respuestas. En esa frase que acabas de leer le hemos asignado una acción en primera persona y ha sonado natural. Es habitual leer expresiones en las que la inteligencia artificial (IA) es un sujeto activo, como si se tratara de una persona que hace o posibilita una acción. Lo hemos visto en titulares como “La inteligencia artificial atribuye a Lope de Vega una obra anónima del fondo de manuscritos de la Biblioteca Nacional” o “La inteligencia artificial permite entender el lenguaje de los cerdos”. Precisamente un usuario nos preguntó si la IA puede ser considerada un sujeto.

Pero, ¿a quién nos referimos cuando decimos “la inteligencia artificial”? ¿A la tecnología como ente, a las personas que la han programado, a las personas que generaron los datos con los que se ha entrenado, a las personas que la usan? Son muchas preguntas pero, de momento, pocas certezas, aunque la Comisión Europea está trabajando en ello y ha analizado tres posibilidades desde el punto de vista jurídico.

La primera idea fue considerar que el sistema de IA por sí mismo es responsable como si fuera una “persona electrónica”, una propuesta que se ha pospuesto de manera indefinida y no se aplica a nivel europeo, detalla Rodríguez de las Heras: “Esto implica que ChatGPT necesita tener un patrimonio con el que compensar a la víctima. ¿Quién lo utiliza, quién lo gestiona, qué ocurre si lo gasta? Es una idea sugerente pero en la práctica está llena de lagunas”.

La segunda propuesta es considerar que este chatbot, como otro sistema de IA, es un producto. “En ese escenario, causa daño cuando tiene un defecto y hacemos responsable al productor del sistema, que puede ser la empresa en términos generales que lo ha desarrollado”, indica la experta. El problema es que muchas veces el error puede provenir de otros aspectos, como “que aprenda mal, que la información con que se vaya nutriendo sea errónea o que la persona que lo está entrenando le dé un refuerzo equivocado”. Por eso este escenario tampoco responde a todas las dudas.

La tercera solución es considerar al chatbot una herramienta que alguien utiliza para algo y el responsable sería el operador, es decir, la persona que lo usa. Por ejemplo, “si soy un hospital y uso el chatbot para diagnósticos médicos, yo soy responsable de que cometa errores; o si lo uso como chat para resolver quejas porque soy un banco o como asistente virtual para proporcionar recomendaciones sobre qué producto adquirir”, como podría pasar en una tienda online, añade Rodríguez de las Heras.

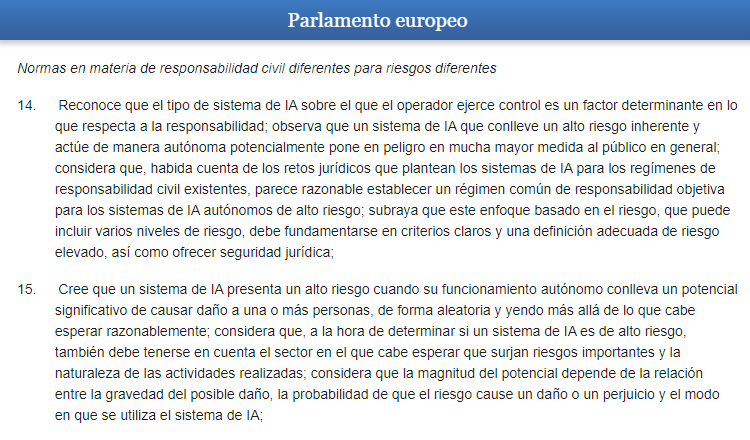

El nivel de responsabilidad de productor o usuario podría variar según el riesgo y la autonomía del sistema de IA

Elena Gil, abogada experta en derecho digital y protección de datos y cofundadora de Tech and Law, coincide con Rodríguez de las Heras en que todavía quedan años de tramitación, cambios y debates, pero cree que “hay una dirección clara de la Unión Europea para regular todo esto”.

Por ejemplo, Gil señala el Informe 2020/2014/INL del Parlamento Europeo sobre recomendaciones destinadas a la Comisión sobre un régimen de responsabilidad civil en materia de inteligencia artificial. “Como una IA se basa en técnicas de aprendizaje automático y va aprendiendo y cambiando de comportamiento con el tiempo, el Parlamento proponía varios escenarios de riesgo. Por ejemplo, para las IA que operan en escenarios de riesgo alto, si son totalmente autónomas, la empresa sería responsable. La responsabilidad sería menos directa cuanto menos autónomo sea el sistema de inteligencia artificial”, explica Gil.

Todas estas cuestiones, a nivel legal, pertenecen al derecho civil y a la regulación de la responsabilidad contractual o extracontractual: “Es responsabilidad contractual si hay un contrato entre las partes (por ejemplo, una versión de pago de un sistema de IA) o extracontractual si no hay contrato”. Gil subraya esto último porque es importante para entender la complejidad de lo que hay que regular: “Un ejemplo sería resolver si un supermercado es responsable de una persona que se haya caído haciendo la compra porque el suelo estaba mojado en un día de lluvia. Se analizan al detalle todas las circunstancias del caso y se decide si pudo evitarse con algo de cuidado y diligencia, o si era imprevisible. Con una IA todo este proceso será más complejo”.

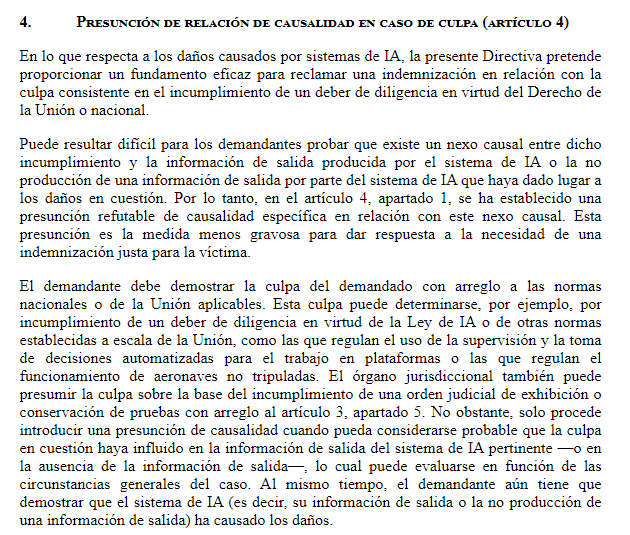

En este sentido, en septiembre de 2022 la Comisión Europea presentó una propuesta de directiva sobre adaptación de las normas de responsabilidad civil extracontractual de la inteligencia artificial, donde abordan escenarios para demandas por daños y perjuicios por “información de salida” de una IA.

De momento, supuestos y escenarios siguen sobre la mesa y las normativas se siguen discutiendo para que, como indica en The Conversation María Isabel Montserrat de la Universitat de les Illes Balears, se garantice que la aplicación de las investigaciones de inteligencia artificial a la realidad social y empresarial se produzca en un marco jurídico adecuado. Por su parte, ChatGPT dice que esto aún está en evolución y echa balones fuera. Quizá los chatbots también deban ir buscándose un abogado especializado.