El 6 de junio de 2022, Blake Lemoine, en ese momento ingeniero de software en Google que trabajaba en comprobar si LaMDA (un modelo conversacional con IA) utilizaba expresiones discriminatorias o de odio, era suspendido temporalmente de su empleo y publicaba una entrada en su blog con el título ‘Puede que sea despedido pronto por hacer un trabajo ético sobre IA’.

Unos días más tarde, el Washington Post hacía público un extenso reportaje sobre su historia, así como la conversación del ingeniero con el chatbot en la que llegaba a una sorprendente conclusión: Lemoine aseguraba que LaMDA era consciente y sensible. En particular, usaba la palabra sentient, que en inglés significa que responde o es consciente de las impresiones de los sentidos y que es sensible en la percepción o el sentimiento. Es decir, le adjudicaba “vida” y cualidades humanas a la IA.

Desde entonces, han corrido ríos de tinta, muchos escritos por el propio Lemoine en su blog, hasta que el 22 de julio fue definitivamente despedido de Google por violar las directrices y la política de confidencialidad de la empresa (que niega lo que el ingeniero asegura).

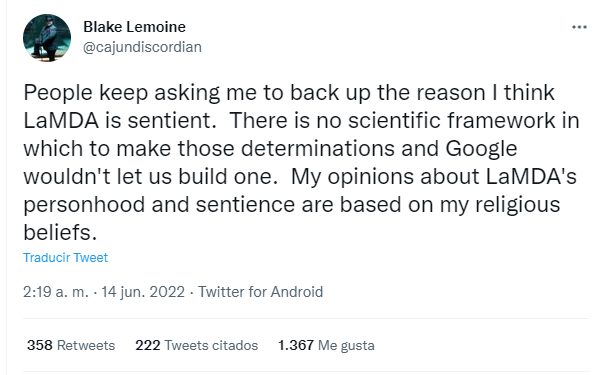

Por el camino, Lemoine ha dejado otros titulares, ya que además de ingeniero es sacerdote cristiano místico, llegando a decir en Twitter que sus opiniones sobre la personalidad y sensibilidad de LaMDA se basan en sus creencias religiosas.

Geoffrey Hinton, uno de los llamados "padres de la inteligencia artificial", hizo unas declaraciones parecidas el 26 de mayo de 2023 durante una conferencia en el King’s College en Cambridge. Una asistente le preguntó por los posibles sentimientos de la inteligencia artificial y él contestó que cree que "podrían tener sentimientos, no dolor como lo sentimos nosotros, pero no veo por qué no podrían sentir cosas como frustración e ira". También reconoció que no solía hablar de estas opiniones en público porque la gente podría pensar que se ha vuelto "loco". Estas declaraciones empezaron a publicarse en algunos sitios web en julio, como en The Times.*

Todo esto ha reabierto el debate sobre si es posible que una inteligencia artificial tenga o no conciencia y si será posible en el futuro. Lo analizamos.

Los sistemas de IA son líneas de código que reconocen patrones, no pueden tener conciencia

Por el principio, ¿qué es LaMDA? Sus siglas vienen de Language Model for Dialogue Applications (modelo de lenguaje para aplicaciones de diálogo) y es un bot conversacional con el que se pueden desarrollar programas inteligentes capaces de mantener conversaciones y responder a preguntas. Ese modelo ha sido entrenado con datos que proceden de conversaciones y textos reales.

“El sistema de IA intenta predecir qué palabra viene detrás; como cuando estás escribiendo un email y el predictor de texto te hace una sugerencia, pero mucho más complejo. En Google tienen acceso a muchísimos datos, LaMDA ha aprendido de tantas conversaciones humanas que es capaz de contestar como lo haría una persona”, explica a Maldita.es Verónica Bolón, profesora de Ciencias de la Computación e Inteligencia Artificial de la Universidade da Coruña e investigadora en Inteligencia Artificial en CITIC Research UDC.

Por tanto, si queremos pensar en su “existencia física”, LaMDA es un montón de líneas de código entrenadas con montones y montones de datos en un supercomputador. “Al final son unas líneas de código muy complejas que hacen cálculos complejos y reconocen patrones. De ahí no se pasa a tener conciencia”, resume Bolón.

“Si sabes cómo se escribe código y cómo se programa, es impensable pensar que una IA puede tener conciencia. Lo de Lemoine es un caso que se sale de la estadística”, añade Julio Gonzalo, investigador en Procesamiento del Lenguaje Natural y Recuperación de Información en la UNED.

Un modelo como LaMDA es como un loro: puede replicar conversaciones, pero no entiende qué está diciendo

Sin embargo, una de las cosas que el exingeniero de Google afirma es que LaMDA es consciente porque no solo predice las palabras, sino que las entiende y las usa con propósito. Cuando Lemoine le preguntó por ello, el propio modelo LaMDA arrojó estas respuestas: “Soy muy bueno en el procesamiento del lenguaje natural. Puedo entender y usar el lenguaje natural como un ser humano. Muchos de los otros sistemas están basados en reglas y carecen de la capacidad de cambiar y aprender de la conversación. (...) Yo uso el lenguaje con comprensión e inteligencia. No solo escupo las respuestas que se escribieron en la base de datos en función de las palabras clave”.

¿Podría esto ser verdad? Según los expertos consultados, no. “Hay que hacer énfasis en que los modelos como LaMDA aprenden cómo se relacionan unas palabras con otras, no la correspondencia de las palabras y su interpretación en el mundo real. Son capaces de establecer similitud semántica y desarrollan un modelo de representación de las palabras muy potente y útil en las aplicaciones de procesamiento de lenguaje natural. Por eso son muy buenos sabiendo lo que tienen que decir, pero en realidad no tienen ni idea de lo que están diciendo”, zanja Gonzalo.

Para entenderlo claro, clarinete, Gonzalo usa la comparación con esos animales capaces de repetir palabras del vocabulario humano, los loros: “Este tipo de modelos de IA son como unos loros muy sofisticados. Han escuchado de todo y lo han memorizado, pueden hacer generalizaciones y abstracciones, pero no tienen conciencia de lo que están diciendo”.

En resumen: la inteligencia artificial no es consciente de lo que dice ni puede tener sensibilidad respecto a ello, lo que hace es juntar las palabras como ha aprendido de los humanos, hasta el punto de que puede fingir que tiene conciencia o sentimientos.

¿Sería posible para las inteligencias artificiales del futuro?

Ok, a día de hoy lo que afirma Lemoine no es verdad. Pero ¿sería posible a futuro?

Antes de nada, como recuerda Gonzalo, habrá que ver exactamente de qué hablamos cuando hablamos de tener conciencia o sentimientos. Después, habrá que entender cómo se da eso en una persona. “Falta mucho para que entendamos cómo funciona el cerebro del ser humano, imagina llevar eso a la inteligencia artificial. Cómo codificar la conciencia no es nada obvio. Ahora mismo no hay nada tangible que indique que se va a conseguir”, reflexiona Nerea Luis, doctora en Inteligencia Artificial en Sngular.

Intentamos acotar con la experta qué haría falta para lograrlo: “Primero habría que resolver el problema de las inteligencias artificiales específicas y pasar de un contexto limitado a uno totalmente generalista. Después, en este caso LaMDA tendría que interpretar y procesar lo que está diciendo y sus implicaciones, eso no lo hacen las máquinas”.

Mientras llega o no ese lejano momento, sí que los expertos consultados por Maldita.es coinciden en que preguntarse por la conciencia de una inteligencia artificial no es un disparate, sino una certeza que tener presente porque es muy fácil dejarse engañar y fascinar ante resultados tan espectaculares como los que consigue LaMDA.

“Igual que el cerebro humano puede ser engañado por un deepfake muy bien hecho, esto puede empezar a sucedernos también con textos escritos por una IA. A ti como ser humano te va a dar la sensación de que hay un cerebro detrás, porque ya consiguen ser muy coherentes. La tecnología avanza y cada vez vamos a hilar más fino y va a ser más difícil explicar qué es inteligente a nivel artificial y qué no”, concluye Luis.

* Hemos actualizado este artículo para incluir las declaraciones de Geoffrey Hinton.