Sucede a todas horas, cada minuto: te haces una fotografía mientras estás de viaje, en un sitio emblemático o en cualquier rincón de tu ciudad; la subes a una red social como Instagram y utilizas la opción de la ubicación para identificar el lugar; quizá también incluyes el nombre de la ciudad, la plaza o el monumento en los hashtags.

Comienzan a llegar los likes de los amigos o de personas que han visitado la misma localización, y no nos preocupamos de mucho más. Pero el avance de tecnologías como la inteligencia artificial (IA), la biometría y la conectividad ponen de manifiesto escenarios que antes no ocurrían; por ejemplo, que se pueda rastrear nuestra ubicación (un riesgo que a veces subestimamos) o que se pueda obtener información de lo que hacemos en nuestra vida cotidiana sin que seamos conscientes. Este mes hemos visto un nuevo ejemplo de ello.

El 12 de septiembre, el desarrollador y artista belga especializado en tecnología Dries Depoorter lanzó un proyecto llamado The Follower, con el que consigue localizar a personas -tanto anónimas como influencers- gracias a sus fotografías de Instagram y a los vídeos que obtiene de cámaras abiertas que emiten imágenes en Internet. Hablamos de cámaras apostadas en distintos lugares públicos, normalmente abiertos, que en su mayoría tienen funciones de videovigilancia, pero están abiertas al público. ¿Habías pensado alguna vez que alguien podría escanear miles de ellas a la vez para encontrarte? Es exactamente eso lo que hace este proyecto y lo que nos hace plantearnos qué usos se le podrían llegar a dar.

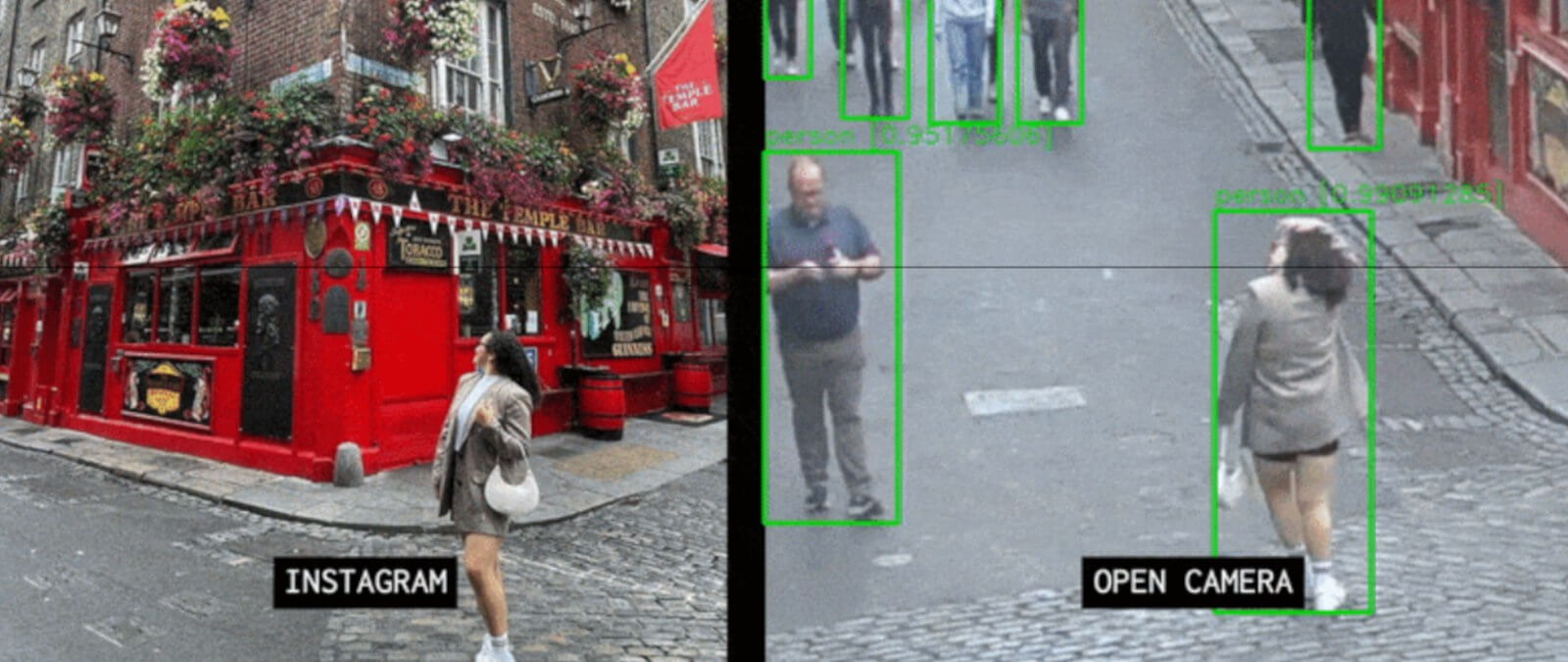

El ‘software’ compara imágenes de Instagram con grabaciones de CCTV e identifica a las personas en el lugar en que tomaron la fotografía

El desarrollador, Dries Depoorter, explica en su página web cómo funciona este software. Primero, recoge durante semanas una selección de grabaciones de cámaras abiertas de Internet. Estas cámaras pueden encontrarse en YouTube, al alcance de cualquiera. Por ejemplo, se puede ver en tiempo real un gran ángulo de Times Square en Nueva York, la calle llena de hoteles casinos Las Vegas Strip y una parte del distrito Shinjuku en Tokio a vista de pájaro posado en una farola. Hay incluso aplicaciones para móvil, como Live Earth Cam, que recogen este tipo de visualizaciones en directo.

Son flujos de imágenes constantes de acceso público, las conocidas tecnologías de “videovigilancia” que englobamos en los Circuitos Cerrados de Televisión (CCTV). Muchas urbes, como Madrid, Londres, Singapur, Ciudad de México y especialmente ciudades en China, las tienen. Este tipo de cámaras no se pueden instalar en cualquier sitio, y su autorización depende de quién lo haga, con qué fines y en qué espacios, como os explicamos en Maldita.es.

El siguiente paso que indica el desarrollador consiste en extraer todas las fotos de Instagram etiquetadas con las mismas ubicaciones que las de las cámaras abiertas. Como hemos comentado al principio, esto se puede hacer a través de la localización de la publicación y también de los hashtags utilizados (pero requiere usar programas informáticos diseñados para ello).

Por último, el software que ha creado compara la imagen de Instagram con las imágenes grabadas, y busca coincidencias de las personas que están en ellas gracias a inteligencia artificial, como explicó en una publicación. Como puede verse en los ejemplos siguientes, el software va rastreando y otorgando puntuaciones a las personas (que identifica como person; también reconoce coches) que se mueven en el vídeo, según se asemejen más o menos a la persona de la fotografía de Instagram. Es decir, va consiguiendo una identificación de la imagen.

Con todo, el software puede identificar el momento exacto en que una fotografía se hizo en una ubicación determinada.

¿Es el proyecto una aplicación graciosa o atenta contra nuestra intimidad?

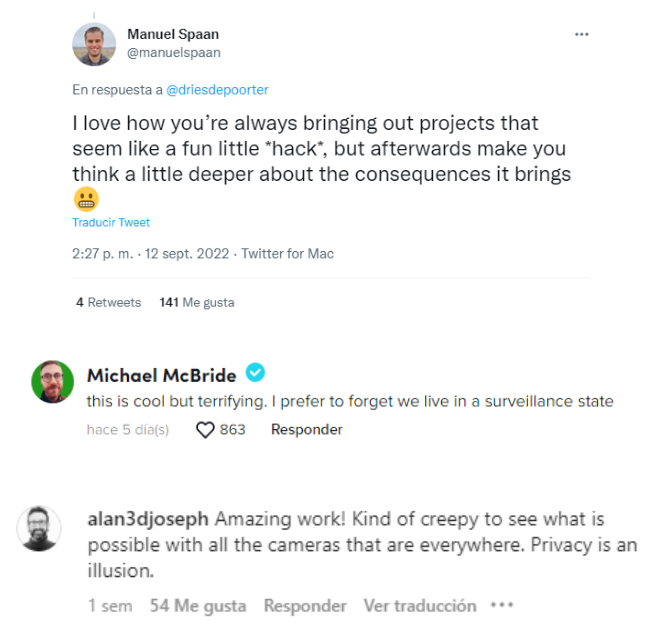

¿Tú qué opinas? El lanzamiento de este software y sus demostraciones han abierto un debate en el mundo digital: mientras muchas personas encuentran la aplicación divertida por su identificación de influencers, otros señalan que en realidad es una prueba más de que el reconocimiento de personas es mucho más fácil de lo que nos pintan.

En TikTok, nos encontramos respuestas a un vídeo en el que un usuario explica este software y que reúne más de 4 millones de reproducciones y, en unos de los comentarios como “prefiero olvidar que vivimos en un estado de vigilancia”. “La privacidad es una ilusión”, decía otro usuario en Instagram, que se inquietaba al ver todo lo que se puede hacer con estas cámaras que están por todas partes.

El analista especializado en tecnologías emergentes y derechos digitales en AccessNow, Daniel Leufer, compartía la misma línea de pensamiento en su Twitter: “Es un proyecto genial y espeluznante que utiliza IA para escanear imágenes de CCTV, ver cómo coinciden con fotos de influencers en Instagram y rastrearlas. La fácil disponibilidad de herramientas de IA como esta significa que debemos reevaluar los riesgos que plantean los CCTV, ya que las posibilidades de acoso y seguimiento se han disparado”.

El trinomio IA, biometría y videovigilancia puede resultar en pérdida de la privacidad, acoso y discriminación

La democratización de la tecnología es buena (y necesaria) en muchos sentidos, pero también hay que valorar qué riesgos entraña en otros casos. Por un lado, la fácil accesibilidad de herramientas de inteligencia artificial, identificación de imágenes y biometría puede ser peligrosa en escenarios como este. "Este proyecto revela lo aterradoramente fácil que es utilizar los rostros de las personas [biometría] para rastrearlas en tiempo y espacio de forma increíblemente intrusiva y siniestra”, indica Ella Jakubowska, responsable de Políticas Públicas sobre biometría y reconocimiento facial en European Digital Rights (EDRi), una de las principales organizaciones europeas dedicadas a la defensa de los derechos digitales y los riesgos de la biometría

Es verdad que es un software con resultados asombrosos que podría tener otros usos, como también lo tienen otras herramientas disponibles de forma pública, como PimEyes, que han sido reivindicadas por sus desarrolladores como una forma de “capacitar a las personas para encontrar sus propias imágenes en línea”, matiza la especialista a Maldita.es. “Pero hemos visto la facilidad con la que estas herramientas pueden ser utilizadas por cualquiera, lo que hace que sea enorme el potencial de acoso y hostigamiento (que afectará de manera desproporcionada a las mujeres y a grupos minoritarios)”, afirma Jakubowska. Por ejemplo, se podría localizar a qué hora ha estado una persona en cierto sitio, hacer un seguimiento e inferir su ubicación actual.

Por si fuera poco, unido a los posibles riesgos de estos desarrollos tecnológicos, por otro lado está la restricción de privacidad que puede suponer la videovigilancia. IA, reconocimiento facial y CCTV pueden ser un combo peliagudo, como recuerda la especialista, porque no solo puede ser utilizado por personas a nivel individual: también por la policía, gobiernos locales o empresas, lo que podría conducir “a una vigilancia masiva, a la invasión de la privacidad e incluso a una amenaza existencial para la democracia”.

Según la experta, la prevalencia masiva de la videovigilancia ha allanado el camino en muchos países europeos a la vigilancia masiva por reconocimiento facial: “Ambas suponen un riesgo para los derechos humanos y a menudo se despliegan de forma discriminatoria. Pero la amenaza se amplifica con la aplicación de algoritmos. Con el reconocimiento facial u otro tipo de vigilancia biométrica, las personas pueden ser identificadas de forma omnipresente y constante a gran escala”. En Maldita.es os hemos hablado a fondo de por qué es necesario regular esta tecnología.

Legislación para evitar que el uso de estas tecnologías pueda impactar en procesos policiales y vigilancia masiva

Las consecuencias de la videovigilancia también puede ahondar en debates sobre los propios procesos policiales y de investigación. ¿Qué sucede si estabas en el momento inadecuado en el lugar más inoportuno? ¿Podrían acusarte por unas imágenes en vídeo y una identificación facial? Según Jakubowska, esto podría dar la vuelta a la presunción de inocencia: “En lugar de llevar a cabo investigaciones sobre sospechosos, la policía nos podría tratar directamente a cada uno de nosotros como un potencial sospechoso".

"Bajo una constante vigilancia biométrica masiva, nos convertimos en códigos de barras andantes, tratados como objetos”, añade. La experta lo compara con el rastreo de un paquete que hayamos pedido en Amazon o cualquier otra compra online: al igual que este se podría rastrear, también se nos podría rastrear a nosotros en espacio y tiempo.

Esto seguramente parezca ir un paso mucho más allá, ¡si solo venimos de un inofensivo software que identifica nuestras imágenes de Instagram!, puede que nos digamos… Pero la experta alerta de que esta vigilancia podría ir intensificándose a medida que lo haga “el potencial y el abaratamiento de la IA, la conexión entre las bases de datos biométricos y policiales, y en algunos casos (como en un proyecto en los Países Bajos) incluso la conexión con los datos educativos y de bienestar".

¿Cómo tratar de evitar que ese momento no llegue? ¿Podría incluirse en la legislación de la biometría ciertos tipos de CCTV y esta conjunción de tecnologías? Jakubowska así lo cree: "Si se aprueba de forma contundente, la prohibición de la vigilancia masiva biométrica a nivel de la Unión Europea impediría que las tecnologías de CCTV se utilicen para el reconocimiento facial en los espacios públicos”.

La especialista señala que incluso algunos legisladores han sugerido enmiendas al futuro Reglamento Europeo de la Inteligencia Artificial de la Comisión Europea, que prohibirían expresamente la creación de bases de datos mediante el scraping de las fuentes de CCTV, las redes sociales o cualquier otro método masivo.

Mientras la regulación llega, es importante es saber que la tecnología tiene luces y sombras, y no todo es blanco o negro. Lo mejor que podemos hacer es informarnos y tomar conciencia de los riesgos que pueden acarrear ciertas prácticas en redes sociales, de modo que podamos tomar decisiones en nuestra vida digital con la mayor cantidad de información posible.