Las imágenes pueden ser una gran fuente de desinformación si se manipulan o se comparten sin el contexto correspondiente. Lo hemos podido comprobar con los bulos y desinformaciones que se han viralizado en relación a la invasión rusa a Ucrania y durante la pandemia de la COVID-19, como ocurrió con esta imagen de dos enfermeras cogiendo un supuesto muerto por coronavirus en España cuando se trata de una imagen de recurso, ficcionada por modelos y tomada en Tailandia. También con las imágenes en las que supuestamente detienen a Donald Trump, que en realidad han sido creadas con inteligencia artificial.*

En este escenario entran también las imágenes generadas o modificadas con herramientas tecnológicas, como la inteligencia artificial (IA). “Cualquier imagen difundida sin contexto puede generar desinformación, incluso las reales. Con más razón si se trata de imágenes generadas ya sea por IA o por humanos mediante herramientas como Photoshop”, explica Julio Gonzalo, investigador en Procesamiento del Lenguaje Natural y Recuperación de Información en la UNED, y maldito que nos ha cedido sus superpoderes.

En Maldita.es ya te hemos contado cómo saber si una foto está manipulada y te hemos dado consejos para detectar una imagen creada con inteligencia artificial. También hemos consultado a varios expertos en el sector para conocer los peligros de difundir sin contexto una imagen generada con inteligencia artificial.

Esta tecnología se puede utilizar para suplantar identidades, humillar a las personas que son víctimas de ello o estafar

Compartir una imagen y no indicar que ha sido generada artificialmente puede dar lugar a situaciones muy peligrosas. “Se puede, por ejemplo, suplantar la identidad de alguien con un realismo enorme”, indica a Maldita.es Elena Verdú, miembro del grupo de investigación Inteligencia Artificial y Robótica de la Universidad Internacional de La Rioja (UNIR) y docente en esta misma universidad.

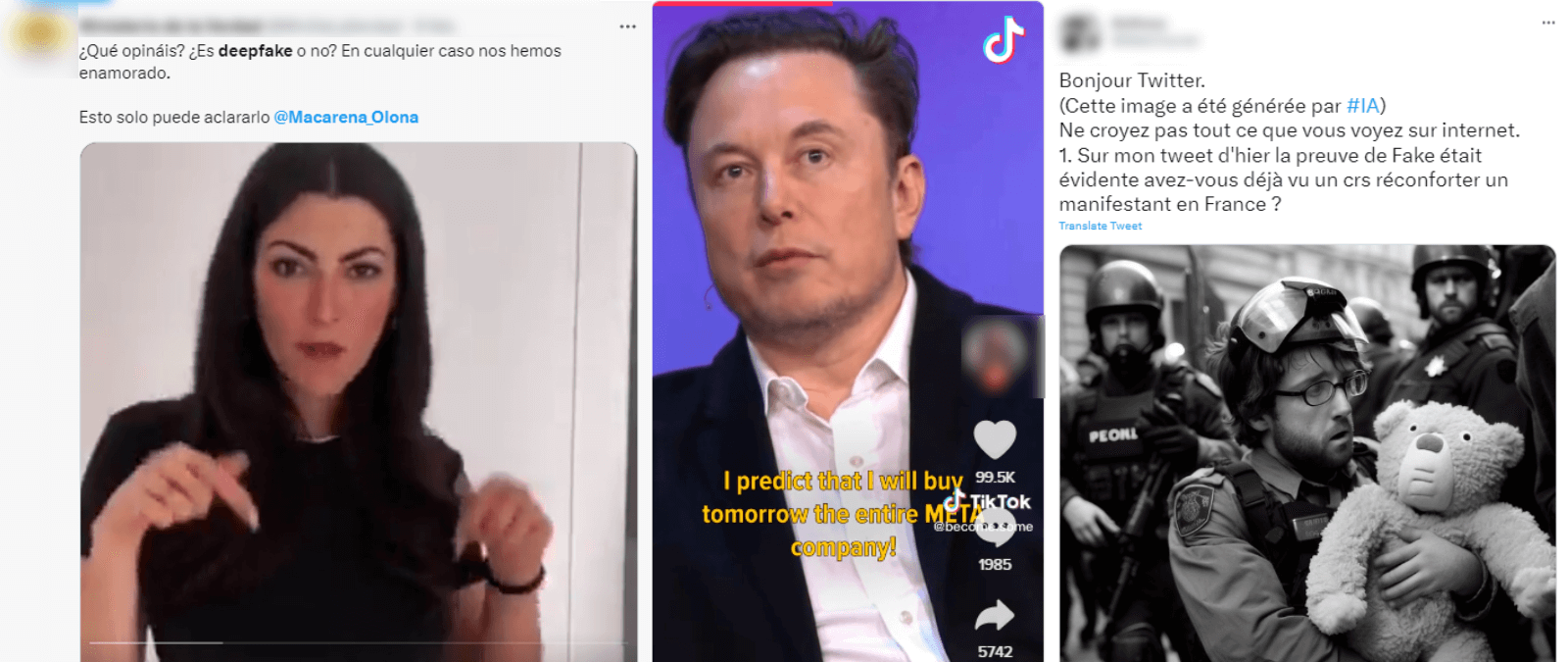

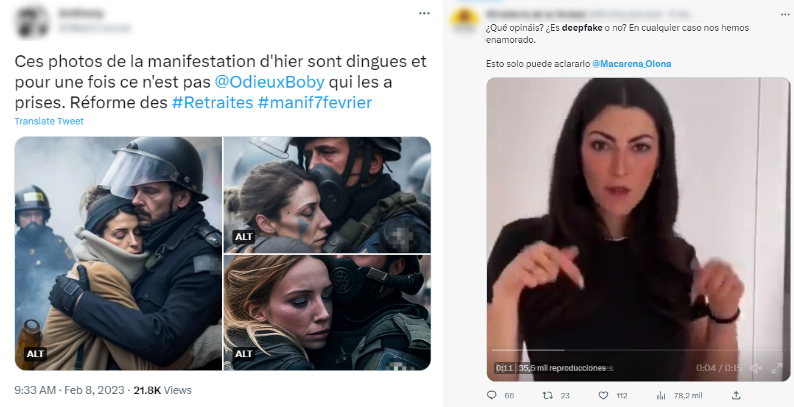

Por ejemplo, hay casos en los que se emplean deepfakes (vídeos manipulados con tecnología basada en IA con el objetivo de crear imágenes falsas que sean igual de realistas) para desinformar. Es el caso de este vídeo del presidente de Ucrania, Volodímir Zelenski, pidiendo a sus tropas que se rindan durante los primeros días de la invasión, o este ejemplo de Elon Musk, dueño de Twitter, en el que supuestamente asegura que va a comprar Meta, la compañía propietaria de Facebook. Ante este tipo de desinformación, se pueden dar situaciones delicadas como movimientos bursátiles no correspondidos con la realidad.

Además de suplantación con fines políticos, ideológicos o económicos, como los ejemplos anteriores, también se pueden utilizar estas imágenes para denostar a personas. “Es muy fácil acosar y humillar a alguien de esta manera, hacer creer a los demás que se ha hecho algo que no se ha hecho”, explica la docente. Es el caso de los contenidos pornográficos generados con esta nueva tecnología y supuestamente protagonizados por mujeres conocidas. Como ya hemos explicado en otras ocasiones, el uso del deepfake sin consentimiento en contenidos pornográficos es una práctica muy extendida. El 96% de los vídeos elaborados por deepfakes analizados por Deeptrace Labs en este estudio publicado en 2019 eran contenidos pornográficos basados en imágenes de mujeres, en su mayoría famosas.

Algunos famosos han sido víctimas de estas manipulaciones que se utilizan para el engaño o realizar estafas, según explica Verdú a Maldita.es. Es el caso de este vídeo modificado de Sam Batman-Fried, fundador y exdirector ejecutivo de la plataforma de exchange de criptomonedas FTX, en el que asegura a los usuarios una supuesta “compensación” por el colapso de FTX, pero en realidad busca robar los fondos de los usuarios según explica esta entrada de Decrypt. En redes sociales, los usuarios advierten de varios deepfakes relacionados con el mundo de las criptomonedas, como este clip del futbolista francés Antoine Griezmann o este otro vídeo de Elon Musk.

La tecnología para crear contenidos con IA ahora está al alcance de todos

Los expertos consultados coinciden: las imágenes creadas con inteligencia artificial se han convertido en una herramienta peligrosa para la desinformación ahora que se han popularizado y son más accesibles para todos los usuarios de la web. “El problema que introducen las herramientas de inteligencia artificial es de escala: lo que antes estaba reservado a un puñado de expertos en el uso de herramientas de diseño digital, ahora está al alcance de toda la población”, incide el investigador Julio Gonzalo.

Hoy en día hay varias aplicaciones que permiten, sin apenas conocimiento en esta nueva tecnología, modificar vídeos o imágenes cambiando la cara de los protagonistas o generar contenidos de cero con unas breves indicaciones.

Por ejemplo, el vídeo de Macarena Olona supuestamente bailando al ritmo de la última colaboración de la cantante Shakira con Bizarrap se hizo con una aplicación muy sencilla de usar, en la que el usuario únicamente tiene que introducir caras en diferentes vídeos. En el caso de los antidisturbios que presuntamente abrazan a mujeres durante una manifestación en Francia, el creador de las imágenes reconoció en una entrevista que empleó la Midjourney (una plataforma que genera imágenes con IA en base a una descripción).

El desarrollo de la IA generativa (la que utilizan estas aplicaciones) avanza rápidamente, y con ella los bulos y las desinformaciones. “Me preocupa el peligro de que se acabe dudando de cualquier imagen y, por ejemplo, un gobierno pueda desdeñar imágenes atroces de la acción de su ejército en una guerra alegando que son fáciles de simular usando una IA”, advierte Julio Gonzalo.

En este artículo ha colaborado con sus superpoderes el maldito Julio Gonzalo, especializado en inteligencia artificial.

Gracias a vuestros superpoderes, conocimientos y experiencia podemos luchar más y mejor contra la mentira. La comunidad de Maldita.es sois imprescindibles para parar la desinformación. Ayúdanos en esta batalla: mándanos los bulos que te lleguen a nuestro servicio de Whatsapp, préstanos tus superpoderes, difunde nuestros desmentidos y hazte Embajador.

* Hemos actualizado este artículo para incluir nuevas imágenes generadas por IA que han contribuido a generar desinformación.