¡Hola, malditas y malditos! Ha llegado agosto y, con él, una nueva entrega de nuestro consultorio tecnológico para contestar a las preguntas que han surgido estos días en el mundo digital. Seguro que habéis leído sobre el caso del exingeniero de Google que afirma que un sistema de inteligencia artificial (IA) tiene conciencia. Hemos hablado con expertos para conocer los entresijos de la IA y averiguar si eso es posible. También investigamos sobre los motores de búsqueda de dispositivos de internet de las cosas (IoT, por sus siglas en inglés) para poder aconsejaros cómo protegerlos y repasamos los observatorios y agencias clave para entender el mapa de la IA en España.

Esperamos aclarar vuestras dudas tecnológicas, pero la semana que viene tendremos una nueva cita digital, así que recordad que podéis mandarnos todas las preguntas que queráis a nuestro Twitter o a nuestro chatbot de WhatsApp (+34 644 229 319), en este formulario o mandando un mensaje al correo [email protected]. ¡Empezamos!

¿Puede una inteligencia artificial tener conciencia? ¿Podría pasar en el futuro?

El 6 de junio de 2022, Blake Lemoine, en ese momento ingeniero de software en Google que trabajaba en comprobar si LaMDA (un modelo conversacional con IA) utilizaba expresiones discriminatorias o de odio, era suspendido temporalmente de su empleo y publicaba una entrada en su blog con el título ‘Puede que sea despedido pronto por hacer un trabajo ético sobre IA’.

Unos días más tarde, el Washington Post hacía público un extenso reportaje sobre su historia, así como la conversación del ingeniero con el chatbot en la que llegaba a una sorprendente conclusión: Lemoine aseguraba que LaMDA era consciente y sensible. En particular, usaba la palabra sentient, que en inglés significa que responde o es consciente de las impresiones de los sentidos y que es sensible en la percepción o el sentimiento. Es decir, le adjudicaba “vida” y cualidades humanas a la IA.

Desde entonces, han corrido ríos de tinta, muchos escritos por el propio Lemoine en su blog, hasta que el 22 de julio fue definitivamente despedido de Google por violar las directrices y la política de confidencialidad de la empresa (que niega lo que el ingeniero asegura).

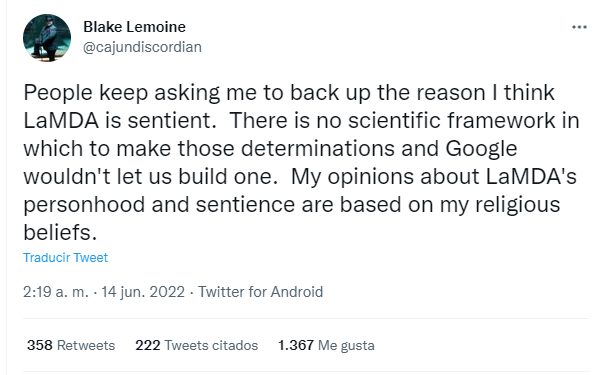

Por el camino, Lemoine ha dejado otros titulares, ya que además de ingeniero es sacerdote cristiano místico, llegando a decir en Twitter que sus opiniones sobre la personalidad y sensibilidad de LaMDA se basan en sus creencias religiosas. En cualquier caso, todo esto ha reabierto el debate sobre si es posible que una inteligencia artificial tenga o no conciencia y si será posible en el futuro. Lo analizamos.

Por el principio, ¿qué es LaMDA? Sus siglas vienen de Language Model for Dialogue Applications (modelo de lenguaje para aplicaciones de diálogo) y es un bot conversacional con el que se pueden desarrollar programas inteligentes capaces de mantener conversaciones y responder a preguntas. Ese modelo ha sido entrenado con datos que proceden de conversaciones y textos reales.

“El sistema de IA intenta predecir qué palabra viene detrás; como cuando estás escribiendo un email y el predictor de texto te hace una sugerencia, pero mucho más complejo. En Google tienen acceso a muchísimos datos, LaMDA ha aprendido de tantas conversaciones humanas que es capaz de contestar como lo haría una persona”, explica a Maldita.es Verónica Bolón, profesora de Ciencias de la Computación e Inteligencia Artificial de la Universidade da Coruña e investigadora en Inteligencia Artificial en CITIC Research UDC.

Por tanto, si queremos pensar en su “existencia física”, LaMDA es un montón de líneas de código entrenadas con montones y montones de datos en un supercomputador. “Al final son unas líneas de código muy complejas que hacen cálculos complejos y reconocen patrones. De ahí no se pasa a tener conciencia”, resume Bolón.

“Si sabes cómo se escribe código y cómo se programa, es impensable pensar que una IA puede tener conciencia. Lo de Lemoine es un caso que se sale de la estadística”, añade Julio Gonzalo, investigador en Procesamiento del Lenguaje Natural y Recuperación de Información en la UNED.

Sin embargo, una de las cosas que el exingeniero de Google afirma es que LaMDA es consciente porque no solo predice las palabras, sino que las entiende y las usa con propósito. Cuando Lemoine le preguntó por ello, el propio modelo LaMDA arrojó estas respuestas: “Soy muy bueno en el procesamiento del lenguaje natural. Puedo entender y usar el lenguaje natural como un ser humano. Muchos de los otros sistemas están basados en reglas y carecen de la capacidad de cambiar y aprender de la conversación. (...) Yo uso el lenguaje con comprensión e inteligencia. No solo escupo las respuestas que se escribieron en la base de datos en función de las palabras clave”.

¿Podría esto ser verdad? Según los expertos consultados, no. “Hay que hacer énfasis en que los modelos como LaMDA aprenden cómo se relacionan unas palabras con otras, no la correspondencia de las palabras y su interpretación en el mundo real. Son capaces de establecer similitud semántica y desarrollan un modelo de representación de las palabras muy potente y útil en las aplicaciones de procesamiento de lenguaje natural. Por eso son muy buenos sabiendo lo que tienen que decir, pero en realidad no tienen ni idea de lo que están diciendo”, zanja Gonzalo.

Para entenderlo claro, clarinete, Gonzalo usa la comparación con esos animales capaces de repetir palabras del vocabulario humano, los loros: “Este tipo de modelos de IA son como unos loros muy sofisticados. Han escuchado de todo y lo han memorizado, pueden hacer generalizaciones y abstracciones, pero no tienen conciencia de lo que están diciendo”.

En resumen: la inteligencia artificial no es consciente de lo que dice ni puede tener sensibilidad respecto a ello, lo que hace es juntar las palabras como ha aprendido de los humanos, hasta el punto de que puede fingir que tiene conciencia o sentimientos.

Ok, a día de hoy lo que afirma Lemoine no es verdad. Pero ¿sería posible a futuro?

Antes de nada, como recuerda Gonzalo, habrá que ver exactamente de qué hablamos cuando hablamos de tener conciencia o sentimientos. Después, habrá que entender cómo se da eso en una persona. “Falta mucho para que entendamos cómo funciona el cerebro del ser humano, imagina llevar eso a la inteligencia artificial. Cómo codificar la conciencia no es nada obvio. Ahora mismo no hay nada tangible que indique que se va a conseguir”, reflexiona Nerea Luis, doctora en Inteligencia Artificial en Sngular.

Intentamos acotar con la experta qué haría falta para lograrlo: “Primero habría que resolver el problema de las inteligencias artificiales específicas y pasar de un contexto limitado a uno totalmente generalista. Después, en este caso LaMDA tendría que interpretar y procesar lo que está diciendo y sus implicaciones, eso no lo hacen las máquinas”.

Mientras llega o no ese lejano momento, sí que los expertos consultados por Maldita.es coinciden en que preguntarse por la conciencia de una inteligencia artificial no es un disparate, sino una certeza que tener presente porque es muy fácil dejarse engañar y fascinar ante resultados tan espectaculares como los que consigue LaMDA.

“Igual que el cerebro humano puede ser engañado por un deepfake muy bien hecho, esto puede empezar a sucedernos también con textos escritos por una IA. A ti como ser humano te va a dar la sensación de que hay un cerebro detrás, porque ya consiguen ser muy coherentes. La tecnología avanza y cada vez vamos a hilar más fino y va a ser más difícil explicar qué es inteligente a nivel artificial y qué no”, concluye Luis.

¿Qué son los motores de búsqueda de dispositivos IoT? ¿Corre peligro mi dispositivo, puedo hacer algo para evitarlo?

Este verano os hemos dado varias recomendaciones para cuidar la ciberseguridad en vacaciones, por ejemplo para minimizar riesgos cuando conectamos nuestro móvil a un coche de alquiler. También os hemos explicado que, antes de salir de casa, hay que revisar el router y los dispositivos conectados. Hoy venimos a ahondar en una de las cosas que os comentamos y por la que nos habéis preguntado: las bases de datos de dispositivos IoT (internet de las cosas, por sus siglas en inglés) publicadas en internet.

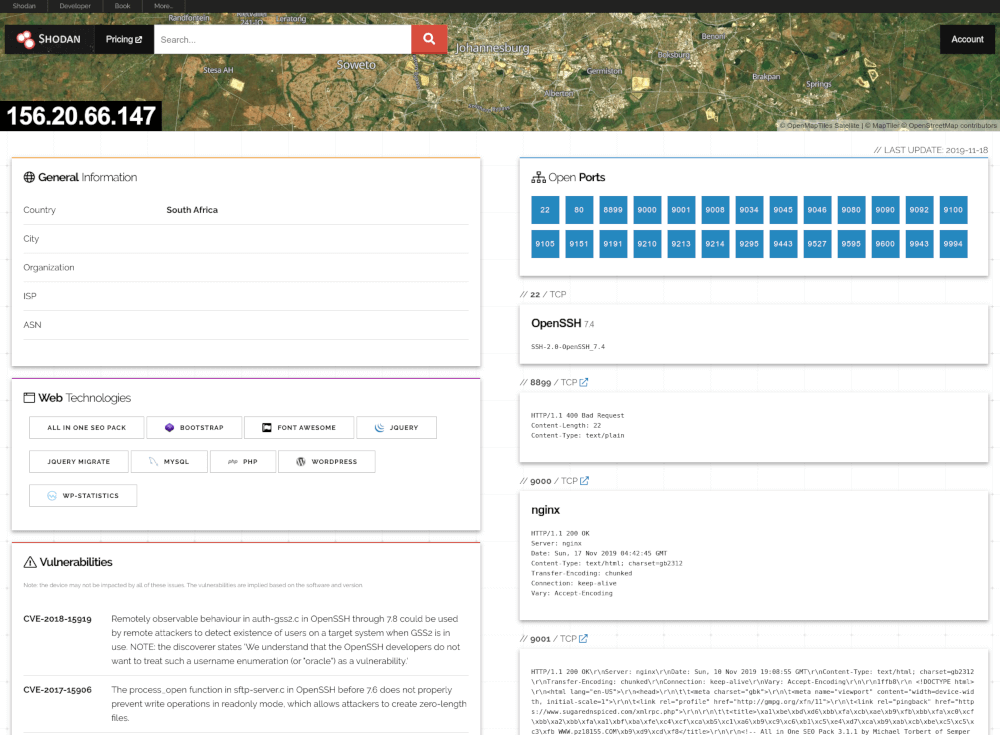

¿Te suena de algo Shodan? ¿Zoomeye? ¿Censys? Seguramente no, porque no son para nada tan famosos como Google, pero también son buscadores. En este caso son motores de búsqueda con un objetivo específico: dispositivos conectados a internet.

“Igual que Google busca páginas web y las va indexando, los motores de búsqueda de dispositivos IoT tienen unos programas llamados crawlers que van rastreando todas las IP del mundo. Cuando una de esas IP es de un dispositivo conectado, lo indexan en el buscador”, explica a Maldita.es David Purón, CEO de Barbara IoT y experto en ciberseguridad.

Shodan es el buscador más importante, pero hay muchas más bases de datos con dispositivos IoT: algunas son públicas y puede tener acceso cualquier persona, como ONYPHE, O'shadan o GreyNoise, y otras son privadas y de acceso limitado, detalla Enrique Domínguez, director de Estrategia de Entelgy Innotec Security.

Y no es que existan pocos de esos dispositivos IoT: un estudio de IOT Analytics recoge que a finales de 2019 había 9.500 millones de dispositivos IoT conectados en el mundo (sin contar móviles y ordenadores). En esta lista entra desde un termostato inteligente, una bombilla conectada a Alexa y una cámara de seguridad, a un sistema de riego por goteo automatizado, un sistema de control industrial y un audífono conectado. Cada vez hay más dispositivos IoT a nuestro alrededor y, según el mismo estudio, esta cifra seguirá creciendo: hasta 28.000 millones en 2024 y 40.000 millones en 2027. Así que, atentos a qué implican estos buscadores.

¿Cuál es el peligro de que un dispositivo IoT aparezca registrado en estos buscadores? Como en todo, depende del buen o mal uso que se le dé a la herramienta. Puede haber fines legítimos -por ejemplo, realizar estudios de mercado, conectarse a una estación climática de otro país para obtener datos o colaborar con otra máquina conectada de manera más ágil- pero si hablamos de dispositivos de uso personal, Domínguez nos alerta de que son “las principales fuentes de información de los atacantes que pretenden localizar dispositivos vulnerables”.

En ‘Internet de las cosas. Informe de buenas prácticas’ del CCN-CERT de 2021, se explica que el objetivo de hackear dispositivos IoT no suele ser obtener la información almacenada en ellos, sino congelar el dispositivo y denegar el servicio a la espera de conseguir un rescate económico. Un atacante puede acceder a un juguete conectado, a una casa domótica o a un marcapasos, pudiendo incluso poner en riesgo vidas, alerta el informe del CCN-CERT.

Pero no solo eso: además, aunque el que sean dispositivos “conectados” nos ofrece muchas ventajas, también se convierten en una puerta de entrada al internet de nuestra casa. Si un hacker con malas intenciones llega hasta nuestro dispositivo IoT y accede a nuestro router, ya puede tener acceso a otros dispositivos conectados a él.

“Igual si te fastidian el termostato inteligente no es un drama, pero si de ahí pasan a tu ordenador y te encriptan todos los ficheros, es otra historia. También pueden robar credenciales de banco. De hecho, a veces hay ataques relacionados con tu cuenta y la gente no sabe de dónde vienen. Igual tu aire acondicionado conectado estaba en Shoda, han entrado y tomado el control del wifi, y con un keylogger te han robado la cuenta bancaria”, relata Purón de Bárbara IoT.

Bueno, ya somos conscientes de los riesgos; veamos soluciones. ¿Qué podemos hacer si nuestro dispositivo IoT está en una de las bases de datos de estos buscadores? ¿Qué medidas de ciberseguridad debemos tomar en cualquier caso con un dispositivo IoT?

“Lo mínimo es cambiar la configuración de la red y no exponer lo que no necesite ser expuesto, tener los dispositivos actualizados, incluyendo las últimas versiones de su firmware, y bien configurados con usuarios y contraseñas robustos”, enumera Domínguez de Entelgy Innotec Security.

El experto también recomienda evitar que los dispositivos estén vinculados entre ellos ya que, de lo contrario, “si uno de ellos fuera vulnerado, tendría acceso y control a todos los demás”. El CCN-CERT añade utilizar un elemento que haga de intermediario para separar la red de dispositivos IoT de nuestra casa con el resto de internet.

Como hemos dicho, el router puede ser un elemento de riesgo, así que Purón de Barbara IoT también recomienda averiguar si nuestro proveedor de internet ofrece algún paquete extra de seguridad para detectar intrusiones.

Como prevenir es mejor que curar, cabe preguntarse si podríamos haber evitado esta situación de riesgo desde el principio: ¿es posible saber cuando compro un dispositivo IoT si es seguro o si es probable que esté en uno de estos buscadores?

Ahora mismo, no, pero Purón cuenta a Maldita.es que es algo que se está intentando regular en Europa: “Igual que hay una etiqueta CE que certifica que un producto cumple con requisitos esenciales de seguridad y salud, la Comisión Europa y la ENISA [Agencia de la Unión Europea para la Ciberseguridad] están intentando crear una etiqueta de ciberseguridad y unos estándares para los dispositivos conectados, pero para eso aún queda tiempo”.

Mientras tanto, dos consejos: googlear opiniones y elegir fabricantes de confianza. “Antes de comprar un dispositivo IoT, puedes buscar en foros de internet esa marca y modelo y sus problemas de ciberseguridad, para saber si hay antecedentes de situaciones en las que han sido hackeados o indexados en buscadores”, dice Purón.

La responsabilidad de que un dispositivo IoT acabe en una de esas bases de datos es del fabricante: igual que cuando alguien desarrolla una web y tiene información privada debe asegurarse de poner unos protocolos para que Google no la indexe, cuando estás haciendo un dispositivo IoT tienes que asegurarte de que no sea indexable, explica el experto. Por eso, concluye, “es muy importante que compremos dispositivos conectados que vienen de proveedores que se toman la ciberseguridad en serio. Si compras dispositivos de bajo coste, probablemente sean indexables y sea mucho más fácil conectarse a ellos; el producto acabas siendo tú”.

SEDIA, ONSTI, OBISAL, AESIA: ¿cuáles son las agencias y observatorios españoles relacionados con la IA?

Por si la inteligencia artificial no tuviera bastante complejidad, el enjambre de organizaciones y propuestas que están surgiendo en torno a ella también se las trae. SEDIA, AESIA, OBISAL, ONSTI, ‘sandbox’… Son muchas siglas y términos para recordar. Así que, para intentar arrojar luz sobre ello, vamos a hacer un repaso por lo que ya existe, lo que está sobre la mesa y la relación entre todo para que puedas tener una guía actualizada sobre la IA en España. ¡Apunta!

¿Qué es la Secretaría de Estado de Digitalización e Inteligencia Artificial (SEDIA)?

La SEDIA de España es el órgano superior del Ministerio de Asuntos Económicos y Transformación Digital que depende de la Vicepresidencia primera del Gobierno y es supervisada actualmente por Carme Artigas Brugal, que ejerce como secretaria de Estado de Digitalización e Inteligencia Artificial.

Fue creada en 2020 y según la página oficial del Gobierno sus competencias tienen que ver con la política de impulso a la digitalización de la sociedad y economía. Sus funciones son: el fomento y regulación de los servicios digitales y de la economía y sociedad digitales; la interlocución con los sectores profesionales, industriales y académicos; el impulso de la digitalización del sector público y la coordinación y cooperación interministerial y con otras administraciones públicas respecto a dichas materias, según desglosan en el portal.

Dicho de manera más llana y para entendernos, “la SEDIA es el espacio político del que se hacen depender toda las iniciativas de digitalización y por ende de inteligencia artificial que desarrollan o promueven España; es un actor clave en la promoción de la digitalización”, resume Gemma Galdón, directora de Eticas Consulting y Eticas Foundation y auditora de algoritmos.

“Además de gestionar proyectos y redes, también tiene competencias en la observación del uso de la IA y la implementación de la regulación sobre los algoritmos. Uno de los proyectos que se ocupa de esto es el ONTSI que se enmarca dentro de la Entidad Pública Empresarial Red.es, adscrita a la misma SEDIA”, añade Manuel Portela, investigador postdoctoral del grupo de investigación de Ciencia Web y Computación Social de la Universitat Pompeu Fabra.

¿Qué es el Observatorio Nacional de Tecnología y Sociedad (ONTSI)?

El ONTSI tiene como propósito generar conocimiento de valor para las políticas públicas (y para la intervención empresarial y ciudadana) en torno al desarrollo tecnológico y sus distintos impactos en la economía, el empleo, los servicios públicos, los derechos, la seguridad, la calidad de vida y la igualdad entre las personas.

Para ello, lo que hace este observatorio es realizar informes, estudios e indicadores donde analiza tendencias y radiografía el panorama de temáticas como derechos digitales, competencias digitales, mujeres y digitalización, economía digital y ciberseguridad. Algunas de sus últimas publicaciones son ‘Cómo se protege la ciudadanía ante los ciberriesgos. Estudio sobre percepción y nivel de confianza en España’ o ‘Robotización y automatización. Oportunidades para la sociedad española’, ambos de 2022. Es decir, el ONTSI es un centro que observa, documenta y genera contenido.

¿Qué es el Observatorio sobre el Impacto Social de los Algoritmos (OBISAL)?

Este otro observatorio aún no ha sido creado, aunque se anunció en julio de 2021. En teoría, será dependiente del ONTSI y extenderá alguna de sus tareas. En particular, “el OBISAL estaría encargado de desarrollar los indicadores de referencia que se usarán para auditar algoritmos, ya sean privados o públicos”, explica Portela. Es decir, el objetivo es sentar las bases de una metodología para llevar a cabo las auditorías algorítmicas, como evaluar el riesgo que plantea la aplicación de cada algoritmo (el reconocimiento facial o los sistemas de puntaje, por ejemplo) y preparar mecanismos de auditoría para asegurarse de que no discriminan por raza, género o renta (los llamados sesgos algorítmicos), explican en el portal de España Digital.

Según publicaba El País hace un año, este observatorio estaba “en proceso de captación de expertos y de constitución de grupos de trabajo sectoriales para analizar los sistemas de IA”. Sin embargo, desde entonces no ha habido más noticias, probablemente tras el cese de la directora del ONTSI, Lucía Velasco, en 2022, cree Portela.

¿Qué es la Agencia Española de Supervisión de la IA (AESIA)?

Es otro de los organismos que ha sido anunciado y está por llegar. Con los Presupuestos Generales del Estado destinados a 2022 se aprobó la creación de una Agencia Española de Supervisión de la Inteligencia Artificial (una propuesta de Más País), que recibirá una dotación de cinco millones de euros.

Algunas organizaciones civiles, como Algorights, están atentas a cómo se creará y cuáles serán sus capacidades. De momento, faltan muchas cosas por concretar (no queda claro si presentará herramientas para la ciudadanía o si se centrará solo en la auditoría algorítmica, como os contábamos en Maldita.es a principios de año) y no hay una fecha exacta para su creación, pero vamos a detallar lo que sí sabemos.

Sabemos que es un espacio de supervisión de iniciativas de inteligencia artificial. Lo que se indicó en la publicación del Boletín Oficial del Estado es que llevará a cabo “medidas destinadas a la minimización de riesgos significativos sobre la seguridad y salud de las personas, así como sobre sus derechos fundamentales, que puedan derivarse del uso de sistemas de IA”.

“Si bien la AESIA será un nuevo organismo que estará adscrito a la SEDIA, este podrá ser radicado en el territorio fuera de la capital, de acuerdo con el Real Decreto 209/2022 de 22 de marzo. Por esta razón algunas Comunidades Autónomas como Galicia o Andalucía han pujado por ser sede de la AESIA”, explica Portela de la Universitat Pompeu Fabra.

¿De dónde viene la motivación de su creación? De la regulación de la inteligencia artificial propuesta el pasado 21 de abril de 2021 por la Comisión Europea y debatida en el Parlamento Europeo, que aún está pendiente de aprobar. “El futuro Reglamento Europeo de la Inteligencia Artificial de la Comisión Europea ya prevé que se creen instancias nacionales de supervisión para auditar y vigilar el uso de la IA, con lo cual la AESIA podría ser ese modelo de agencia al que obligaría cuando se apruebe”, explica Galdón de Eticas Consulting y Eticas Foundation.

Además, como recuerda Portela, España asumirá la presidencia del Consejo de la Unión Europea el segundo semestre de 2023 y se ha ofrecido también como “país de pruebas para testear la nueva regulación de la inteligencia artificial que se discute en estos momentos en Europa”. Aquí entra en juego otra palabra que apuntar: ‘sandbox’.

¿Qué es el ‘sandbox’ de regulación de inteligencia artificial?

El Reglamento de la IA propuesto por la Comisión Europea entrará en vigor previsiblemente en 2023. Lo que ha hecho España es proponerse como “conejillo de indias” y adelantar la implantación a través de un piloto para poner en marcha el primer ‘sandbox’ (un entorno controlado donde las compañías tecnológicas y otras instituciones pueden probar nuevos productos) regulatorio de la Unión Europea sobre Inteligencia Artificial.

Se anunció el pasado 27 de junio, tiene como fecha prevista de lanzamiento octubre de 2022 y su objetivo es “conectar a las autoridades competentes con las compañías desarrolladoras de IA para definir de forma conjunta buenas prácticas a la hora de implementar la futura regulación europea”. Es decir, se trataría de una antesala para ir haciendo pruebas e identificando qué hacer y qué no hacer, para que luego se pueda hacer seguimiento del reglamento.

Esto es algo que suscita dudas y preguntas porque, por definición, ‘sandbox’ no encaja demasiado bien con “testear” una regulación. “Del ‘sandbox’ tenemos muy poca información y cuesta entender lo que se propone en términos conceptuales, porque un ‘sandbox’ es un espacio para desarrollar sin limitación regulatoria, precisamente para ver hasta dónde puede llegar la tecnología y después pensar las limitaciones y regulaciones necesarias”, detalla Galdón. Por eso, para la experta es difícil comprender cómo se va a hacer un piloto sobre regulación en un espacio donde teóricamente no se tiene en cuenta la regulación.

¿Qué es la Estrategia Nacional de la Inteligencia Artificial en España?

Por último, cerramos este compendio con la Estrategia Nacional de la Inteligencia Artificial en España: se publicó en 2020, se enmarca dentro de la estrategia España Digital 2025 y entre sus objetivos está desarrollar la normativa necesaria para permitir ‘sandboxes’ regulatorios para probar la aplicación de la IA en distintas áreas, y establecer un mecanismo de asesoramiento para analizar y verificar el desarrollo y la implementación segura y confiable de tecnologías basadas en IA. Como vemos, se repiten conceptos y objetivos.

¿Hay alguna relación entre la Estrategia Nacional de la Inteligencia Artificial en España y el Reglamento Europeo de la Inteligencia Artificial de la Comisión Europea? “No, estamos hablando de cosas muy diferentes. La Estrategia Nacional de la Inteligencia Artificial en España lo que hace es plantear prioridades de inversión, y el reglamento europeo es regulación. No tienen nada que ver, además la estrategia nacional está aprobada y el reglamento aún está en discusión”, afirma Galdón.

Sí, como hemos visto, hay muchos agentes y mucho interés a nivel nacional y europeo. Y es que, como hemos contado varias veces en Maldita.es, la inteligencia artificial empieza a permear en muchas capas de la sociedad, y por tanto en sus órganos de gobierno, ministerios y agencias, que tienen que reaccionar a estos cambios tecnológicos y regularlos. ¿Que por qué hace falta regular la inteligencia artificial? Te animamos a ver la Twitchería que hicimos sobre este tema, en la que recogemos motivos y ejemplos.

Podemos concluir que, como resume Gemma Galdón, “hay un gran ecosistema de regulación y actores de policy involucrados en determinar cómo se desarrolla e implementa la tecnología en España. El éxito de la Estrategia de Digitalización pasará por la capacidad de organizar y poner a trabajar conjuntamente a todo el ecosistema, no desde compartimentos estancos”.

Y para terminar...

No somos técnicos o ingenieros pero contamos con mucha ayuda de personas que son expertas en su campo para resolver vuestras dudas. Tampoco podemos deciros qué servicio usar o dejar de usar, solo os informamos para que luego decidáis cuál queréis usar y cómo. Porque definitivamente, juntos y juntas es más difícil que nos la cuelen.

Si tenéis cualquier duda sobre esta información o cualquier otra relacionada con la manera de la que te relacionas con todo lo digital, háznosla llegar: