Anteriormente, os hemos hablado de por qué cuando los deepfakes llegaron a oídos del público no suponían una gran amenaza a la hora de desinformar. Estos son vídeos reales manipulados con tecnología basada en inteligencia artificial con el objetivo de crear imágenes falsas que sean igual de realistas. O en palabras mucho más simplonas: sustituir la cara, el cuerpo o la voz de una persona por otra en un vídeo. Sin que lo notemos, claro.

Este proceso pasa por una serie de técnicas que no sólo afectan a la imagen, sino también al sonido. Si una persona está hablando se puede modificar también su voz para que aunque al manipularlo quien hable sea una persona diferente, siga pareciendo real. No toda manipulación de un vídeo entra en la definición de deepfakes.

Por ejemplo, se difundió mucho un vídeo de la presidenta de la Cámara de Representantes de EEUU, Nancy Pelosi, a quien acusaban de ir borracha porque lo habían ralentizado. Para que pareciese real, lo que hicieron fue modular su tono de voz para que esta no se volviese grave al ir más lento (esto ocurre cuando se ralentiza un vídeo). Estos casos son más comunes: en Maldita.es os hemos hablado también de cómo simplemente ralentizando un vídeo se puede atacar a políticos por su forma de hablar.

Sí lo son unas imágenes manipuladas del ex primer ministro italiano, Matteo Renzi, insultando. Pero no es lo más común. Hace unos meses vimos a un político indio usando un deepfake para dirigirse a su público en inglés, un idioma que no hablaba, de forma voluntaria y también lo hemos visto en el programa de El Intermedio en España, que utilizaron este recurso para simular un debate entre Iñigo Errejón y Pablo Iglesias entre otros.

Deepfakes y desinformación

En el ámbito de la desinformación, esta técnica es muy atractiva para los que la diseminan. Imaginaos el desconcierto que causaría en la opinión pública ver a un político diciendo algo totalmente disparatado o contrario a sus ideales. Formar a la ciudadanía para detectar la manipulación del discurso público se volvió un indispensable para prevenir caer en estas trampas, ya que suponen la misma amenaza que otros tipos de desinformación. En Maldita.es, uno de los objetivos principales es ayudaros con esa formación.

Britt Paris, profesora en la Universidad de Rutgers en EEUU y coautora de un informe de Data & Society sobre deepfakes, recuerda que la relación entre la desinformación y la manipulación audiovisual ya existía: “Cuando se popularizó la fotografía y se quiso utilizar como evidencias en los tribunales, los jueces la rechazaban porque no entendían la tecnología y pensaban que no sería precisa”.

En los últimos años no se han observado tantos ataques contra políticos con el objetivo de crear una desinformación usando deepfakes como se habría pensado. Por ejemplo, acaban de darse las elecciones americanas, un escenario muy polémico por el enfrentamiento entre Donald Trump y Joe Biden, sin que se hayan usado estas técnicas.

Los deepfakes de políticos más conocidos suelen usarse en entornos controlados precisamente para mostrar que algunos pueden llegar a estar muy perfeccionados. Por ejemplo, este del presidente norcoreano Kim Jong Un (en el que no se le ve parpadear en 40 segundos de vídeo):

¿Dónde los estamos viendo sin ser conscientes?

“Cuando vemos deepfakes en informativos aparecen solamente para alertarnos de sus peligros; y cuando los vemos en programas, el acabado es malo, 'de andar por casa'. Se hace adrede para que el público entienda lo que es y sólo se emplee con fin humorístico o paródico”, explica a Maldita Tecnología Graciela Padilla Castillo, profesora en la Universidad Complutense de Madrid y autora del estudio “Alfabetización moral digital para la detección de deepfakes y fakes audiovisuales”.

En realidad, donde sí hemos visto que esta tecnología se usa y es efectiva es en otros ámbitos: especialmente el del cine y también en la pornografía.

¿Qué tipo de tecnología está detrás?

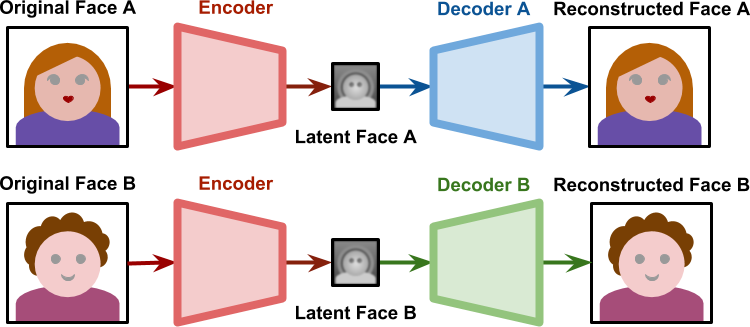

En otros artículos os hemos explicado qué son las redes neuronales y para qué podrían utilizarse en el reconocimiento de imágenes, por ejemplo con los filtros de Instagram o TikTok. Para los deepfakes también se utilizan diferentes tipos de redes neuronales (un tipo de tecnología del campo de la inteligencia artificial) llamadas “autoencoders” y “generativas adversariales (GAN en inglés)”.

En este grupo entran los sistemas informáticos creados para "generar” un contenido nuevo a partir de uno ya existente. Intervienen componentes llamados codificadores y descodificadores. Al primero se le da una imagen para que este la "comprima" y poder obtener una copia sobre la que trabajar. El descodificador, a su vez, construye otra imagen a partir de esa copia en base a ciertas variables que hayan elegido sus creadores. Los decodificadores se entrenan con muchísimas imágenes de la persona de modo que vayan ganando cada vez más precisión.

Contándolo de una manera muy, muy simplificada, una vez que se han entrenado suficiente los decodificadores (que son los que van a generar la imagen nueva), se intercambian para que cada uno construya una imagen nueva a partir de la copia.

“Hacer un buen deepfake supone solamente entre 4 y 10 horas de trabajo. Es un tiempo mínimo para los resultados que se pueden obtener”, sostiene Padilla. Uno de los peligros que identifica esta profesora es que esta tecnología sí que está relativamente a mano para los especialistas que quisieran usarla, ya que su código fuente puede consultarse.

Técnicas usadas para detectar un deepfake

Su uso en España y en Europa no está directamente regulado pero sí incurre en un delito si afecta a la protección del honor, la intimidad, la propia imagen, etc. El reto, afirma, está en que la gente conozca que su uso en según qué contextos es un delito y que tengan la capacidad de detectarlos y denunciarlos. Hay redes sociales que también los han prohibido, como Facebook o YouTube.

Ahora bien, ¿son fáciles de detectar los deepfakes? “La tecnología del deepfake, lamentablemente, cumple unos estándares medios y sus mayores hándicaps son que es difícil detectarlos en pequeñas pantallas”, asegura Padilla. No es lo mismo que los vídeos se visualicen en una pantalla de ordenador con buena resolución a que lo hagan en una tablet o un teléfono móvil, donde los fallos más evidentes pueden pasar desapercibidos.

Esos fallos sí que están más o menos identificados gracias a las investigaciones que se han hecho en el campo de la comunicación: las personas que aparecen en los vídeos parpadean menos o con menos frecuencia, la boca puede no estar del todo definida en su interior, hay pequeños temblores o faltas de encaje entre el cuello y la cabeza, etc.

Si están bien hechos siguen siendo un tipo de producción difícil de detectar para un usuario que no está acostumbrado a tratar con ellas. Especialmente, si el tema va en línea con lo que esa persona piensa. Por ello, la recomendación a la hora de enfrentarse a un vídeo que huele raro, aparte de ser observadores, pasa por aplicar el sentido común como con cualquier otro tipo de desinformación. Y si tienes dudas, haz búsquedas, pregunta, pero no compartas.

“Afortunadamente, la amenaza es menor a las potencialidades negativas que se preveían tras su invención. En este entorno creo que el reto estaría entonces en cuidar y vigilar la comunicación interpersonal y en esas formas de venganza, de acoso o de bullying [por ejemplo, con el porno de venganza]. Ahí sí sigue siendo una amenaza”, concluye Padilla.

Primera fecha de publicación de este artículo: 12/11/2020.

Primera fecha de publicación de este artículo: 12/11/2020