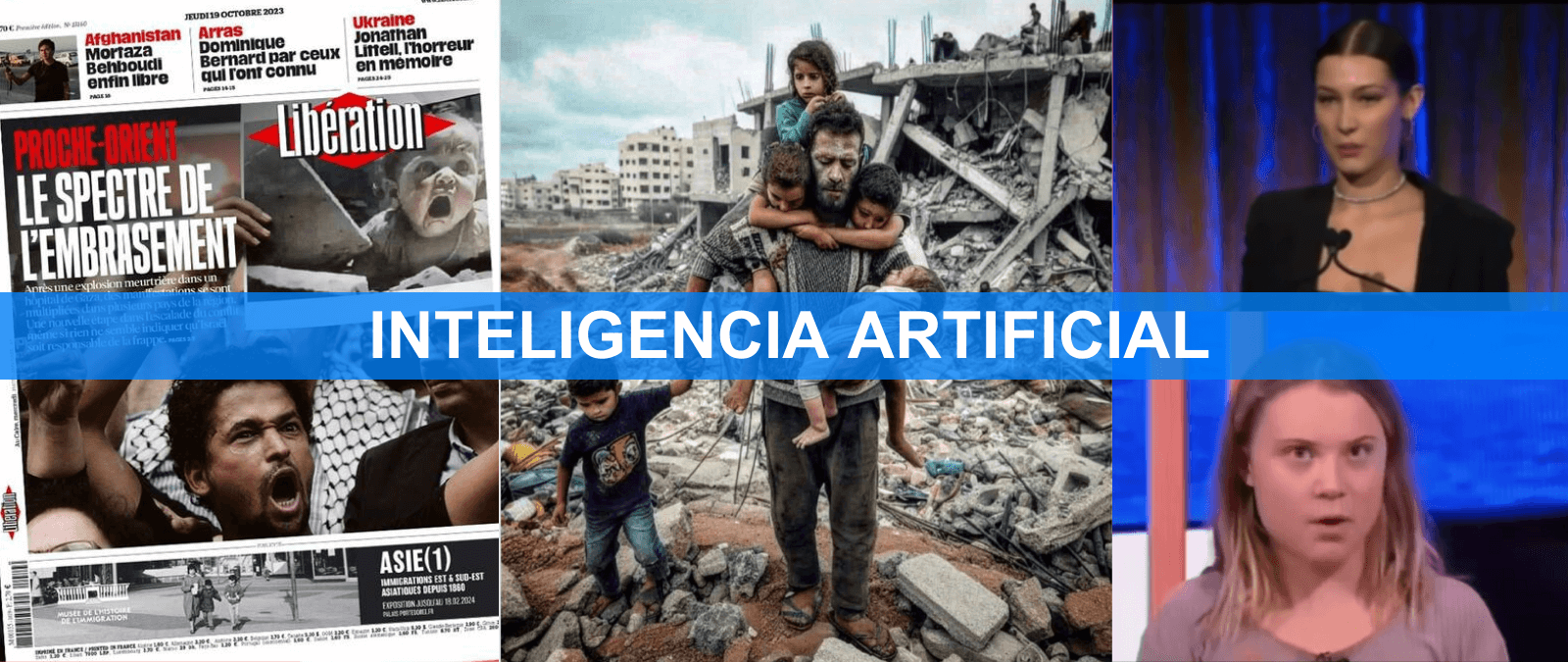

Desde que comenzaran los ataques entre Hamás e Israel el 7 de octubre de 2023 la desinformación no ha parado de circular en redes sociales. Entre los vídeos de conflictos anteriores presentados como si fueran de este y los contenidos que cuestionan a las víctimas del conflicto también se están difundiendo bulos creados con la ayuda de la inteligencia artificial (IA). Ya sea a través de imágenes de supuestas víctimas de los bombardeos en Gaza o vídeos manipulados (en ocasiones deepfakes) y voces clonadas para suplantar la identidad y alterar el discurso de figuras relevantes, como la activista Greta Thunberg o la modelo Bella Hadid, esta tecnología se ha adentrado en parte de la desinformación que día a día desmentimos en Maldita.es.

Cómo se emplean imágenes generadas con IA para desinformar sobre los ataques de Israel y Hamás

A las pocas horas del ataque que Hamás lanzó sobre Israel el 7 de octubre de 2023 comenzó una crisis de desinformación (de la que ya hemos desmentido más de 70 bulos hasta la fecha en que se publica este artículo) en la que las redes sociales se llenaron de imágenes que no guardaban relación con la situación de Gaza. A diferencia de otros conflictos bélicos, los contenidos generados con inteligencia artificial han comenzado a jugar un papel más relevante en esta campaña de desinformación. Aunque la inteligencia artificial no ha protagonizado una ola de bulos masiva en este conflicto (al contrario de lo que apuntaban algunas de las predicciones más apocalípticas), sí que está jugando un rol más destacado que en la invasión de Rusia contra Ucrania, según Wired y Poynter.

Desde Maldita.es hemos analizado algunas de estas imágenes, como esta supuesta fotografía de un padre rescatando a sus hijos heridos de un bombardeo en Gaza. Aunque la imagen parezca real, presenta signos de que ha sido creada con inteligencia artificial: caras borrosas y ojos hundidos, un número inusual de dedos, deformidades en extremidades… Todo ello son indicios de que esta imagen en realidad se trata de una imagen generada con esta tecnología y no es real.

No es el único contenido que ha circulado mostrando a supuestas víctimas del conflicto. Según Shayan Sardarizadeh, periodista de BBC Verify, desde que comenzaron los ataques se han difundido diferentes imágenes que habrían sido creadas con IA, como un supuesto acto de apoyo a Palestina durante un partido del Atlético de Madrid o supuestas fotografías de niños víctimas de las bombas.

Estas imágenes se aglutinan en diferentes narrativas, principalmente sobre el sufrimiento de la población civil en Gaza y el apoyo a las diferentes fuerzas del conflicto, según DW. También se ha viralizado una imagen que reflejaría la supuesta entrada de las tropas israelíes a la ciudad de Gaza y que según DW ha sido creada con inteligencia artificial.

Libération ha incluido una de estas imágenes dentro de sus contenidos editoriales mientras que Adobe las comercializa

Estas imágenes creadas con inteligencia artificial también han dado el salto de las redes sociales a otro tipo de publicaciones y que en algunos casos se han difundido como reales, ya que por el momento es difícil identificarlas. En la portada del 19 de octubre de Libération, uno de los principales medios de Francia, se puede observar cómo un manifestante sujeta una supuesta fotografía de un bebé que habría sido afectado por los bombardeos en Gaza. Pero la imagen del niño no es real y ha sido creada con IA, según ha reconocido la propia publicación, como parte de su mensaje editorial.

Libération ha asegurado que “muchos de los carteles que se muestran en las manifestaciones en realidad fueron creados con IA, que en los últimos meses se ha convertido en la base artística de las protestas” e incide en que “el centro de la foto es el manifestante enfadado, para quien la verdad importa poco”.

Este caso no es el único. Adobe Stock Photo, el servicio de venta de fotografías de la compañía Adobe, también ha comenzado a comerciar con imágenes creadas con inteligencia artificial que diferentes usuarios habrían subido a la plataforma, avisando que han sido creadas por IA. Según VICE, Adobe habría puesto a la venta imágenes creadas con IA sobre el alcance del conflicto, como recreaciones de los daños en los edificios tras las explosiones, pero que se han comenzado a difundir como reales. Bajo títulos como 'Edificios destruidos por un cohete lanzado por militantes de la Franja de Gaza', estas imágenes han aparecido en otras publicaciones para ilustrar los avances del ejército israelí en Gaza, pese a que como decimos, Adobe señala que han sido generadas con esta tecnología, según Crikey.

También se difunden vídeos manipulados y voces clonadas con declaraciones falsas sobre el conflicto

El uso de esta tecnología no se limita a la creación de imágenes, sino que también se han creado otros contenidos audiovisuales para desinformar sobre el conflicto. En Reino Unido se ha viralizado un supuesto audio del alcalde de Londres, Sadiq Khan, en el que habría desestimado el Día del Recuerdo (conmemoración de los fallecidos en tiempos de guerra) para favorecer las manifestaciones en apoyo a Palestina. Pero se trata de una voz clonada (aquellas voces que imitan el habla de una persona en concreto) y Khan nunca ha pronunciado estas palabras.

Desde Maldita.es también hemos desmentido vídeos manipulados con técnicas de inteligencia artificial (si se usan redes neuronales, hablamos de deepfakes) en los que se suplanta la identidad de otras figuras relevantes para desinformar sobre el conflicto. En redes sociales se viralizaron supuestas declaraciones de la modelo estadounidense de ascendencia palestina Bella Hadid, en la que habría mostrado su apoyo a Israel después de “aprender verdaderamente el contexto histórico”. Pero es un bulo: estas imágenes no son reales y la actriz nunca ha hecho estas declaraciones.

También se ha aprovechado el conflicto para difundir desinformación sobre otros personajes, como la activista medioambiental Greta Thunberg. Según un vídeo que se viralizó en redes sociales, Thunberg habría pedido usar “misiles biodegradables” y “granadas veganas” ya que las “guerras siempre son malas, sobre todo para el planeta”. Pero las declaraciones son falsas y el vídeo fue manipulado por la cuenta Snicklink, que se define con sátira. Una práctica que hemos visto en otras desinformaciones similares.