Los algoritmos nos afectan en el día a día en nuestra vida digital, y esto permea en la vida real. Recordemos que un algoritmo es un conjunto de instrucciones que una persona diseña para sacar un resultado de forma automática. Puede ser algo tan sencillo como la receta de la tortilla de patatas, pero también puede ser algo muy complejo, como los que están detrás de los desarrollos tecnológicos que usamos.

Hay algoritmos de recomendación en las redes sociales y plataformas que nos sugieren contenido: en Instagram, YouTube, TikTok y Facebook, en Spotify y Netflix, en Amazon y Uber Eats. Pero también hay otro tipo de situaciones en las que se usan algoritmos: en procesos de trabajo, en despidos, concesiones de créditos bancarios o becas para estudiar, e incluso para predecir el riesgo de las víctimas de violencia de género. En estos procesos puede haber sesgos que discriminan y nos afectan directamente.

¿Esto se puede analizar, vigilar y controlar? Es complicado, porque los algoritmos no siempre son públicos, a menudo son privados, así que para poder hacerlo se necesita transparencia. En la Ley de Servicios Digitales (DSA, por sus siglas en inglés), que entró en vigor el pasado 16 de noviembre de 2022, se indica que hay que tomar medidas de transparencia para las plataformas en línea, incluidos los algoritmos utilizados para las recomendaciones. Para asegurar que esto se cumple, se ha inaugurado el Centro Europeo para la Transparencia Algorítmica (ECAT, por sus siglas en inglés) en Sevilla.

¿Qué es el Centro Europeo para la Transparencia Algorítmica y de qué se va a encargar?

El Centro Europeo para la Transparencia Algorítmica de la Comisión Europea (CE) tiene el objetivo de “crear un entorno en línea más seguro, previsible y fiable para las personas y las empresas” para cumplir las medidas adoptadas por la Ley de Servicios Digitales. El centro se inauguró el 18 de abril y está ubicado en la sede del Centro Común de Investigación (Joint Research Center, JRC) de la CE que hay en la ciudad andaluza.

Su objetivo es “abrir las cajas negras de los algoritmos”, analizar sus riesgos y supervisar a las plataformas digitales, en concreto las plataformas en línea de gran tamaño (VLOP por sus siglas en inglés) y los motores de búsqueda en línea de gran tamaño (VLOSE también por sus siglas en inglés), como recoge la DSA. Para ello proporcionarán asistencia técnica y orientación práctica para asegurar sistemas algorítmicos transparentes y fiables.

Para hacerlo van a “conectar con otras organizaciones y expertos, y actuar como un catalizador para generar conocimiento a través de distintas metodologías y sistemas de evaluación”, explicó durante la presentación en Sevilla Stephen Quest, director general del JRC. Entre esos sistemas de evaluación estarán las auditorías algorítmicas, una forma de evaluar cómo funcionan los algoritmos, de qué datos se nutren y qué impacto generan, de las que hablamos en la Maldita Twitchería Tecnológica con Gemma Galdón, directora de Eticas Consulting y Eticas Foundation, y José Miguel Calatayud, periodista especializado en investigación tecnológica.

¿Por qué es necesario que haya transparencia algorítmica?

Si los algoritmos y sus efectos impactan en nuestra vida diaria, que sean transparentes es clave para poder analizar cómo lo hacen. “Los algoritmos están aquí para quedarse e influir en lo que pensamos, en las cosas que compramos, en la gente a la que seguimos. El ECAT nos ayudará a anticiparnos y no improvisar sobre estos efectos para poder controlar cómo abrir la caja negra de los algoritmos”, sintetizó Mikel Landabaso, director de Economía Justa y Sostenible en Centro Común de Investigación en Sevilla.

Además, como hemos indicado, la transparencia algorítmica es una obligación impulsada por la DSA, recordó Renate Nikolay, directora adjunta de Redes de Comunicación, Contenido y Tecnologías de la Comisión Europea: “Con el DSA hay obligaciones legales claras para las plataformas digitales. Si hacemos un test y averiguamos que las plataformas están violando las normas, entonces podemos actuar”.

Detrás de la inteligencia artificial (IA) también hay algoritmos, y con la revolución de la IA que estamos viviendo sabemos que “cada día se liberan nuevos modelos a gran escala y cada vez más complejos, por eso entenderlos y abrir las cajas negras de los algoritmos a medida que avanza la IA es crucial”, subrayó Francesca Bria, experta en política digital europea y Presidenta del Fondo Nacional Italiano para la Innovación.

¿A qué riesgos podemos estar expuestos si los algoritmos no son transparentes y auditables?

Si esas cajas negras no se abren y se pueden auditar y supervisar los algoritmos de forma transparente, podemos estar expuestos a riesgos relacionados con la desinformación y los sesgos.

“Hay que mirar a los riesgos sistémicos porque el impacto de los algoritmos se ha vuelto algo público y social. Hablamos del efecto en la salud mental y también de desinformación”, recordó Renate Nikolay durante una sesión para periodistas en el ECAT. Un ejemplo de desinformación es la que se genera cuando los usuarios de plataformas entran en burbujas de información.

Como te contamos en Maldita.es, el efecto filtro burbuja es el resultado de los algoritmos que responden a lo que buscamos o que definen nuestro timeline en una red social. Nos devuelven sugerencias tan personalizadas que puede provocar un sesgo informacional, reforzar creencias y aislarnos de otros puntos de vista. Como explicaron fuentes europeas del ECAT, los algoritmos de recomendaciones pueden hacer que no veamos el “dibujo completo” y que vivamos en una realidad en la que solo tenemos acceso a cierta información.

En el caso de los sesgos, Nikolay subrayó que ya “hemos tenido escándalos, así que tenemos que generar cambios en las plataformas y hacer que Internet evolucione a través de derechos fundamentales y libertad”. Entre esos escándalos podemos pensar en casos como el del algoritmo de contratación de Amazon que excluía a las mujeres o los algoritmos que tratan de determinar el riesgo de que un preso vuelva a delinquir y sospechan más de la población negra. Hay sistemas algorítmicos que también podrían entrañar riesgos en este tipo de usos, como los sistemas de reconocimiento facial, que discriminan a personas con la piel oscura o negra.

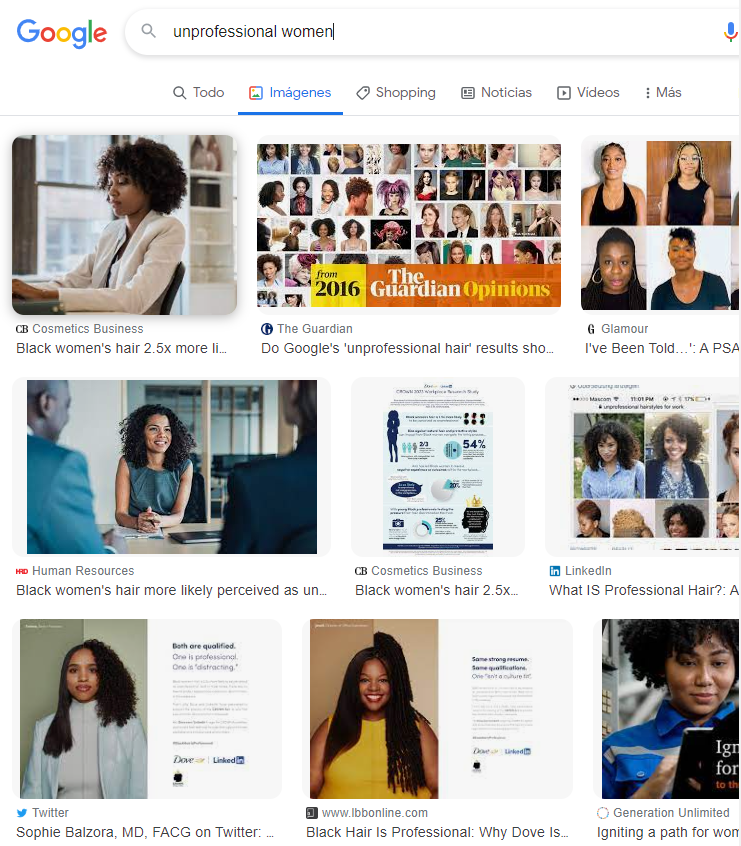

Estos sesgos también están en los motores de búsqueda. Tal y como ejemplificaron fuentes europeas, si escribes en el buscador de Google unprofessional women (mujeres no profesionales) los resultados que devuelve son mujeres negras. Por eso es importante “construir herramientas para evaluar los sesgos que hay en los datos, y cómo los sistemas algorítmicos pueden propagar y reforzar esos sesgos”, indicaron.

¿En qué nos va a beneficiar como usuarios y ciudadanos que haya mayor transparencia algorítmica?

Los expertos presentes en la inauguración del ECAT coincidieron en que más transparencia algorítmica se traduce en más derechos para las personas. La secretaria de Estado de Digitalización e Inteligencia Artificial del Gobierno de España, Carme Artigas, dijo que se supervisarán derechos fundamentales, como “el derecho a no ser discriminado por un algoritmo o el derecho a tener una segunda opinión humana cuando te rechazan un préstamo”.

En concreto, fuentes europeas del ECAT indicaron a Maldita.es que los usuarios lo notarán en tres cosas. Primero, en explicaciones sencillas: “Deberemos tener la posibilidad de conocer de manera clara los criterios por los que recibimos cierto contenido en su página de inicio de redes sociales, por qué nos recomiendan el próximo vídeo en YouTube o una canción en Spotify”. Segundo, porque se nos tendrá que dar la opción de decidir y elegir qué uso se va a hacer de nuestros datos, por ejemplo si un sistema algorítmico de recomendación está lucrándose con ellos. Y en tercer lugar, “la gente notará que deberá haber maneras más fáciles que las que hay ahora de señalar contenido ilegal”, explicaron.

La última pregunta puede ser ¿cuándo? Fuentes europeas expresaron que los efectos del ECAT y la DSA se verán en el corto plazo, y la experta en ética y transparencia en algoritmos Rumman Chowdhury vaticinó que van a ser “de tres a cinco años muy ocupados, pero muy beneficiosos” para la transparencia algorítmica y las personas.