Nuestros perfiles en redes sociales se analizan habitualmente con diferentes objetivos. Es el caso de estudios que usan programas basados en inteligencia artificial para tratar de predecir si una persona está deprimida, tiene tendencias suicidas o puede llegar a desarrollar una enfermedad como el alzheimer. Como lo lees: programas informáticos que ‘leen’ lo que publicamos en Facebook o Instagram y consideran si corremos el riesgo de entrar en un estado depresivo. Ahora bien, ¿hasta qué punto son fiables y cómo se usan hoy en día?

Cómo funcionan los engranajes: analizar texto y más texto

Lo primero es explicar cómo funcionan, ya que cumplen un objetivo muy específico, pero a la vez utilizan los mismos métodos que cualquier otro sistema de inteligencia artificial que analiza textos: en la Maldita Twitchería hemos entrado a fondo en este tema. “El funcionamiento del sistema es como cualquier otra tarea de clasificación de textos o tarea en la que, dado un texto, se trata de asignarle una clase o categoría. En nuestro caso, tenemos como entrada al sistema los textos escritos por un usuario en una red social, y tenemos que asignarle una etiqueta del tipo ‘con riesgo de suicidio’ o ‘sin riesgo de suicidio”, resume a Maldita.es Laura Plaza, profesora titular y miembro del grupo de procesamiento de lenguaje natural (PNL) de la UNED.

Plaza incide en que “los ejemplos deben ser lo más parecido posible a los textos finales con los que trabajará el sistema”. O sea, que a estos sistemas no se les muestran notas de suicidio o textos escritos por una persona que sufre depresión, sino publicaciones en redes sociales que una persona previamente ha marcado como un posible caso de riesgo o no. “Algunos estudios acuden a redes de pacientes de depresión, ansiedad y otros problemas mentales, y toman de ahí conversaciones entre los distintos usuarios”, señala la especialista. Como ejemplo, pone la plataforma Reddit, “una fuente interesante” con “grupos específicos también de problemas mentales”.

“También los historiales clínicos electrónicos son otra fuente de datos súper importante para el procesamiento de lenguaje natural”, añade Rui He, doctorando en el Grammar Cognition Lab de la Universidad Pompeu Fabra.

Un especialista clasifica los textos según si "tienen riesgo" o "no tienen riesgo"

En el caso de una situación tan delicada como el suicidio, Plaza explica que “se suele contar con la colaboración de expertos en enfermedades mentales para que etiqueten los textos extraídos según su valoración sobre si el usuario que los escribe puede o no llegar a cometer suicidio”. O sea, que en realidad todo pasa por el filtro de una persona especialista que valora si puede haber una tentativa o no. No es tan fácil conseguir ejemplos reales de publicaciones de personas que han intentado suicidarse o se han suicidado para estos casos o, como mínimo, personas diagnosticadas con depresión, por ejemplo, para participar en un estudio.

¿Y cómo se sabe qué ejemplos o qué datos son los que hay que buscar? Rui He detalla a Maldita.es que lo que se suele buscar son “señales lingüísticas” que estén presentes en los textos: “Palabras emocionales como ‘bueno’, ‘amor’, ‘odio’, ‘asqueroso’ serán muy importantes, igual que los emojis”, explica.

Lourdes Araujo, catedrática de universidad en el área de conocimiento de Lenguajes y Sistemas Informáticos, añade también “aspectos como un mayor uso de pronombres en primera persona, de términos relacionados con algún problema (peso o comidas en el caso de anorexia, por ejemplo), mayor o menor cantidad de exclamaciones o emoticonos”, como señales que suelen detectar este tipo de sistemas.

“La precisión de las predicciones depende de la calidad y de la cantidad de los datos. Los posibles sesgos en los datos (por ejemplo que se hayan entrenado con datos de personas jóvenes, que no representan bien a personas de edad) son un aspecto que es imprescindible considerar”, recuerda Araujo.

Lo vemos con este estudio realizado con publicaciones en español: para entrenar al sistema que analizaba los posts, se usaron como referencia 513 tuits clasificados como posibles casos de suicidio y 346 frases evaluadas por médicos clínicos. En él admiten la dificultad de acceder a informes médicos y también señalan algunas limitaciones: la falta de representación que hay en Twitter para entrenar un modelo informático, ya que al fin y al cabo la mayoría de usuarios son hombres blancos de edad media.

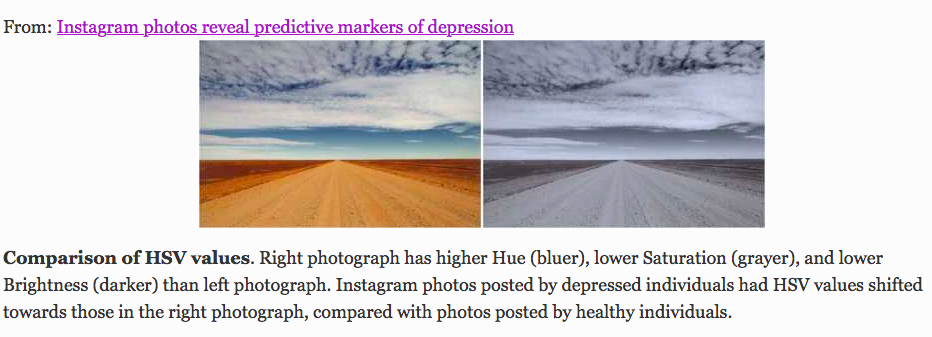

Otro estudio se basaba en el análisis de imágenes, en vez de texto, y concluía que las fotos publicadas en Instagram por personas con depresión “eran más proclives a ser más azuladas, grisáceas y oscuras, y a recibir menos likes”: “Los usuarios de Instagram con depresión de nuestra muestra tenían una mayor preferencia por filtrar todos los colores de las fotos y mostraban aversión a las fotos iluminadas artificialmente”.

Incluso Facebook lleva experimentando desde 2017 con programas de inteligencia artificial dedicados a la “prevención del suicidio”: “Nuestra tecnología utiliza señales, como frases en publicaciones y comentarios que muestran preocupación por parte de amigos y familiares, para identificar posible contenido relacionado con el suicidio y la autolesión. En general, las publicaciones que suelen indicar un riesgo inminente de lesión, incluyen comentarios como ‘Dime dónde estás’ o ‘¿Alguien sabe algo de él/ella?’”. Sin embargo, aclaran que “los algoritmos no desempeñan ninguna función clínica o de diagnóstico y no pueden diagnosticar ni tratar ninguna enfermedad mental o de otro tipo”, sino que lo único que hacen es buscar estas señales para reducir su visibilidad, eliminarlos de la plataforma o, en todo caso, que lo revise el personal que asiste a los usuarios.

Las máquinas no pueden (ni deben) dar diagnósticos médicos

Piensa que estos programas informáticos no se desarrollan para ‘hacer de médico’: una máquina no nos debería dar un diagnóstico médico. Su labor es, por tanto, crear una forma de hacer un escaneo más o menos rápido por las redes sociales y alertar a las personas involucradas de que alguien puede sufrir algún problema de salud mental, por lo que, según los especialistas consultados, no deberían usarse sin supervisión humana.

“Estos sistemas no vienen a suplantar al experto: el riesgo de suicidio no es una enfermedad ni se puede diagnosticar, van a dar la voz de alarma, por ejemplo, a un padre si las conversaciones de su hijo adolescente pueden indicar que piensa en el suicidio. El paso posterior sí es acudir a un profesional de la salud mental, por supuesto”, remarca Laura Plaza.

La gran pregunta: ¿son fiables, en ese caso, o no? ¿Y cómo se usan a día de hoy? Una revisión de 35 estudios sobre inteligencia artificial para detectar signos de suicidio en posts en redes sociales asegura que el uso de estas técnicas “ayudará en la predicción y prevención del suicidio”. Otro estudio sobre casos específicos de adolescentes afirma que son útiles para detectar cuándo puede una persona joven estar sufriendo amenazas o bullying en sus redes y que eso modifique el tono de sus publicaciones.

La conclusión de los especialistas contactados por Maldita.es es que los sistemas pueden ser más o menos fiables para detectar los primeros signos de una depresión por ejemplo, pero que siempre van a ser un complemento al diagnóstico médico, nunca una sustitución.

“La precisión y cobertura de estos sistemas es elevada (puede que mayor que los humanos, pero no creo que podamos afirmarlo con rotundidad)”, afirma Plaza. “A día de hoy no está aceptado que puedan utilizarse sin supervisión. Pero podrían ser una importante fuente de información adicional para ayudar a hacer diagnósticos”, coincide Araujo. Según Rui He, los algoritmos de machine learning están “lejos de ser suficientemente inteligentes para reemplazar a los profesionales”.

Estas especialistas también coinciden en que este tipo de inteligencia artificial se usa por el momento en un plano teórico y no conocen casos en los que se haya estandarizado su uso, por ejemplo, en un hospital o un centro médico. Aun así, hay empresas como IBM que sí venden soluciones de tecnología basada en inteligencia artificial a un nivel comercial, por ejemplo chatbots y programas para analizar datos.

Además de esta explicación tecnológica, te animamos a leer la información que dan los compañeros de Maldita Ciencia sobre el suicidio y la depresión.

Imagen de portada: Alan Warburton / © BBC / Better Images of AI / Medicine / CC-BY 4.0