Se ha viralizado en redes esta semana un experimento que han puesto a prueba varios usuarios de Twitter del algoritmo que utiliza la red social para recortar las imágenes en la previsualización que nos enseña antes de abrirla. Es decir, que si una imagen es muy alargada, Twitter la recorta automáticamente para que si pasamos por encima de un tuit sin llegar a abrirlo, vemos lo que considera "más importante" de la foto.

La conclusión que sacan es que el mecanismo arroja resultados racistas porque tiende a poner en la previsualización las caras de piel blanca antes que las de piel negra.

Tanto se ha comentado que a España han llegado memes relacionados:

Twitter tiene desde 2018 colgada en su blog oficial una explicación técnica para la manera en la que recorta las previsualizaciones de las imágenes, pero aun así cargos de Comunicación y de Datos de la empresa han salido a disculparse públicamente por lo que señalan los usuarios. Os lo explicamos.

Los usuarios acusan a Twitter de tener un algoritmo que prioriza las caras blancas a las negras

La discusión se formó después de que varios usuarios anunciaran un experimento con el que supuestamente demostraban que Twitter usaba un algoritmo racista que priorizaba a personas con la piel blanca en las previsualizaciones de los tuits, al subir fotos con una gran separación vertical. Luego, se sumaron muchos más, también en España:

Por otro lado, otros usuarios denuncian que la elección se debe a aspectos como el contraste o la nitidez de la imagen:

Twitter explicó en 2018 cómo recortan las imágenes subidas, y no es con reconocimiento facial

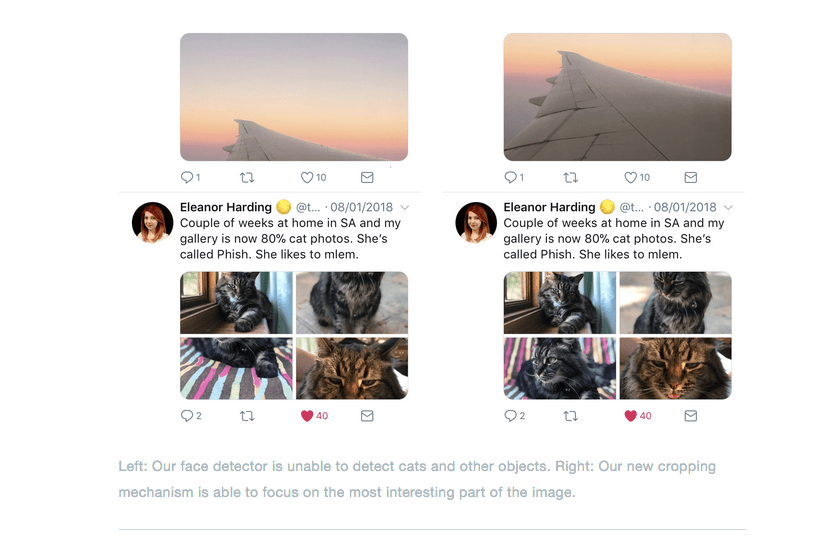

Twitter explica en un post de 2018 en su blog oficial que las fotos de nuestro tablón se recortan para mejorar la uniformidad y lograr que veamos más tuits de un vistazo, y que en un principio se basaron directamente en la detección de las caras para hacerlo. Esto no funcionó bien porque el sistema a veces no las detectaba o lo hacía cuando ni siquiera había una en la imagen.

En vez de optar por centrarse en la mitad exacta de la imagen, desarrollaron una red neuronal que focalizara las partes de la imagen con mayor "prominencia", que son aquellas en las que un usuario tendería a firjarse en un primer vistazo. El problema es que ese tipo de reconocimiento es muy lento si se usa a gran escala (hablan de millones de fotos subidas diariamente a la red social).

¿Cómo lo adaptan? Imaginad que tenéis un ordenador que ocupa toda una habitación y que consigue una precisión elevadísima de dónde están los puntos más importantes de cada foto, pero necesitáis hacer ese proceso en un portátil que podáis llevaros a la habitación de al lado. Este no es capaz de hacerlo tan rápido, así que en vez de hacer su propio análisis, hace un resumen del del ordenador grande y se basa en eso para seleccionar los puntos.

¿Se puede dejar cosas por el camino, como el hecho de que priorizar cosas como el contraste o la definición de una foto haga que la piel más clara vaya a salir electa en la mayoría de los casos? Puede ser.

El algoritmo, según la explicación técnica que dan en esa publicación, no está basado en un sistema de reconocimiento facial, que como te hemos explicado en este artículo, está demostrado que tiene problemas para identificar a personas con la piel negra.

La previsualización se da solo en Twitter, ya que en otras plataformas como Tweetdeck o Telegram el recorte de las imágenes se hace por la mitad (por lo que se ve la parte blanca):

Representantes de Twitter se han disculpado públicamente

El director del departamento de Datos de Twitter asumió la culpa en la red social en respuesta a un usuario que señalaba que fuese por la razón que fuese, la compañía tenía que asumir ciertas obligaciones éticas a la hora de diseñar sus algoritmos. "Es nuestra culpa 100%. Nadie debería decir lo contrario. El siguiente paso es arreglarlo", tuiteaba el directivo.

También una de las responsables de Comunicación de la compañía respondió directamente ante el experimento, igual que la cuenta oficial de la red social. Aseguró que se había comprobado que no hubiera sesgos raciales o de género en el modelo antes de lanzarlo, pero que "deben hacer más análisis". También mencionó que el código que se utiliza se liberaría para que otros pudieran revisarlo y replicarlo.

Los sesgos raciales están presentes en algoritmos que utilizamos en nuestro día a día

Hace unos días, os hablábamos en este artículo del racismo y su relación con la inteligencia artificial: si lo hay entre las personas lo habrá en la tecnología. ¿Por qué? Pues precisamente porque las tecnologías automatizadas se entrenan con datos que un grupo de personas ha elegido. Esas personas tienen inclinaciones ideológicas y responden a estereotipos sociales que terminan desfavoreciendo a grupos históricamente desfavorecidos.

Eso termina incidiendo en la tecnología, y no solo cuando hablamos de discriminación racial. También pasa con la discriminación de género.

Primera fecha de publicación de este artículo: 21/09/2020.