Mientras el mundo se fija en las protestas raciales que llevan días copando las noticias de Estados Unidos por el asesinato de George Floyd, el mundo de la tecnología mira a la empresa de informática IBM y su decisión de parar, por el momento, el desarrollo, la producción y la distribución de sistemas de reconocimiento facial. En realidad, la compañía dice que lo que rechaza es cualquier tipo de tecnología que sirva para acometer “vigilancia masiva”, el “perfilado racial” o la “violación de derechos humanos”.

También Amazon ha anunciado este jueves 11 una moratoria de un año al “uso policial” de su programa Amazon Recokgnition de reconocimiento facial, supuestamente a la espera de que el Congreso de Estados Unidos implemente algún tipo de regulación sobre este tema. Este programa está ya presente en Europa y en Asia.

Al día siguiente, Microsoft, otro gigante presente en el campo de venta de reconocimiento facial, aseguró que ni había vendido ni vendería esta tecnología para uso policial y de vigilancia, según el diario The Washington Post.*

La cuestión es que las tecnologías de reconocimiento facial llevan mucho tiempo enfrentándose a malos resultados y fallos discriminatorios para las personas según el color de su piel. Es especialmente relevante que IBM o Amazon decidan aparcar sus proyectos justo ahora porque ambas compañías vendían esta tecnología a cuerpos de policía y seguridad.

¿Reconocimiento facial es que me graben la cara?

No, y este es un error muy común. Separemos las cosas que puede hacer una cámara que capta imágenes de tu cara o tu cuerpo: puede simplemente grabar y guardar las imágenes, puede grabar para analizar un componente concreto de la imagen y también puede grabar para identificar automáticamente a una persona. En el metro, en organismos oficiales, en supermercados… Grabar imágenes para vigilar un espacio es algo que se hace continuamente, pero es simplemente eso, una grabación.

Para que haya reconocimiento facial, tiene que haber un programa informático instalado en esa cámara que sea capaz de buscar en una librería de imágenes la que está asociada a mi persona. Así es como me “reconoce” y me “identifica” y lo hace de manera automática. Puede que ese programa esté diseñado para buscar un elemento concreto en una imagen, aunque no sea encontrar e identificar a una persona.

“El reconocimiento facial usa la cara como un dato biométrico, pero el análisis facial no. Un ejemplo sería el darse cuenta de si una persona lleva mascarilla o no, como hicieron en el metro de Francia”, explica a Maldita Tecnología Javier Sánchez Monedero, investigador en tecnología de reconocimiento e inteligencia artificial del Data Justice Lab.

Por tanto, para hablar de reconocimiento facial necesitamos que haya un programa automatizado que sea capaz de analizar una imagen y decirnos 'esta persona que ves en la imagen es Menganito García', porque la encuentra por sí sola en una base de datos asociada a ese programa informático. Otro ejemplo: cuando Facebook sabe a quién etiquetar en las fotos que subimos en las que aparecen personas.

Este tipo de tecnología está basada en sistemas de inteligencia artificial, es decir, que no solo el proceso es automatizado sino que puede ir aprendiendo a medida que se añaden nuevas imágenes, nuevos casos, nuevas funciones… Y aquí es donde entra el problema de la discriminación. Los datos con los que aprende los introduce una persona o grupo de personas determinadas con sus sesgos personales que se ha demostrado que pueden causar que personas que no tengan la piel clara o blanca no estén bien representadas.

La tecnología aprende de los datos y los datos pueden tener sesgos humanos

“Los sesgos están en los datos, en la cantidad de personas con piel clara u oscura que están en las bases de datos que se utilizan para crear los modelos”, aclara Sánchez Monedero. Por eso, la pregunta clave es cómo de certera es esta tecnología a día de hoy, teniendo en cuenta que se le da uso en sistemas de vigilancia, en reconocimiento de personas inmigrantes que buscan cruzar una frontera o incluso para hacer entrevistas de trabajo y analizar diferentes rasgos de una persona.

Algunos estudios se basan en esta premisa y aciertan: si tienes una base de datos que contiene en torno a un 80% de fotos de personas con la piel clara, hay altas probabilidades de que no reconozca adecuadamente a personas con diferentes tonos de piel.

“Las categorías a nivel estadístico, que es lo que estamos utilizando en biometría, tienen que ser adecuadas: una mujer como categoría es demasiado amplia, por ejemplo”, señala Lorena Jaume-Palasi, directora ejecutiva de The Ethical Tech Society. Pensad en cuántas fotos de mujeres distintas habría que meter en la base de datos para que las representara a todas. Las hay con apariencia asociada a los chicos, de diferentes nacionalidades, tatuadas, transexuales… Hay estudios que muestran que si son negras aumentan los problemas.

IBM, la compañía que ahora ha paralizado este sector, hablaba hace apenas un año y medio de mejorar la diversidad de sus programas incluyendo supuestamente más tonos de piel pero además midiendo los cráneos de las personas (hasta ese punto es difícil concretar este tipo de tecnología) o su sexo o edad. Tampoco funcionó. Para Jaume-Palasi esta concreción también es ineficaz porque asegura que no hay evidencias científicas para separar por “razas” de esa manera a las personas. Aquí, las compañeras de Maldita Ciencia te cuentan un poco más sobre este tema.

Amazon Rekognition ha sido sujeto de estudio y crítica por la discriminación de sus sistemas durante años y en más de una ocasión se ha pedido que los retirara. La denuncia se basa en que si se usa para casos tan determinantes como encontrar y juzgar a quien podría ser un criminal, no puedes permitirte que un sistema falle por no distinguir rasgos faciales de personas negras o que discrimine por género.

“¿Qué estás categorizando y cómo lo estás categorizando? Si sólo ofreces hombre y mujer, ya estás encorsetando a las personas que no se sienten ni hombre ni mujer en una categoría que es contingente, y basada en lo que es una normativa cultural de una determinada zona o región”, continúa Jaume-Palasi.

La tecnología de reconocimiento facial lleva años evidenciando problemas de sesgo racial

Hay diversidad de estudios y proyectos que analizan la discriminación tecnológica y la presencia de sesgos humanos en función de su procedencia o cultura (predominantemente la occidental) en sistemas de reconocimiento de personas. En este artículo hablamos del color de la piel, pero también puede ocurrir por género o procedencia, por ejemplo. Hace diez años los retos seguían siendo discernir una cara en una imagen, pero el problema de fondo ya estaba ahí.

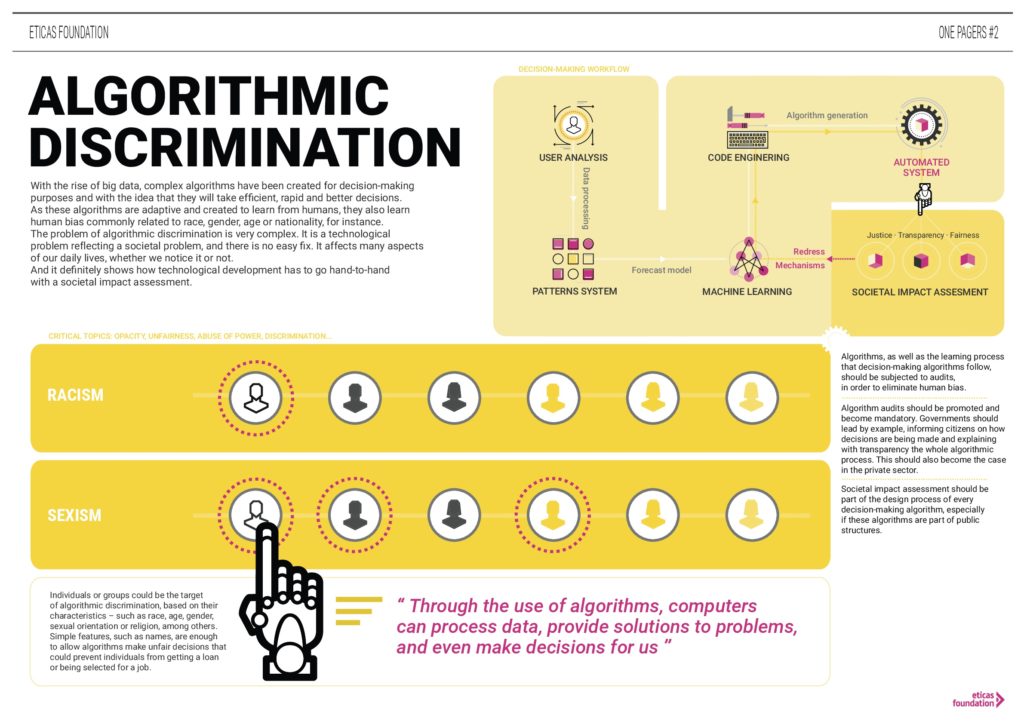

En España, organizaciones como la Fundación Éticas han sido pioneras en denunciar la discriminación algorítmica que los sistemas inteligentes pueden causar en las personas. Por eso existe ahora el Observatorio de Algoritmos con Impacto Social, que pretende seguir su pista.

Además, vienen de largo. Cuando no hablábamos de complejos sistemas informáticos capaces de decidir por sí mismos, las películas fotográficas que había que revelar ya tenían sus problemas para mostrar bien a las personas con piel oscura. También podemos hablar de sensores no adaptados: esta información de 2017 habla de un dispensador de jabón que no reconoce la piel negra.

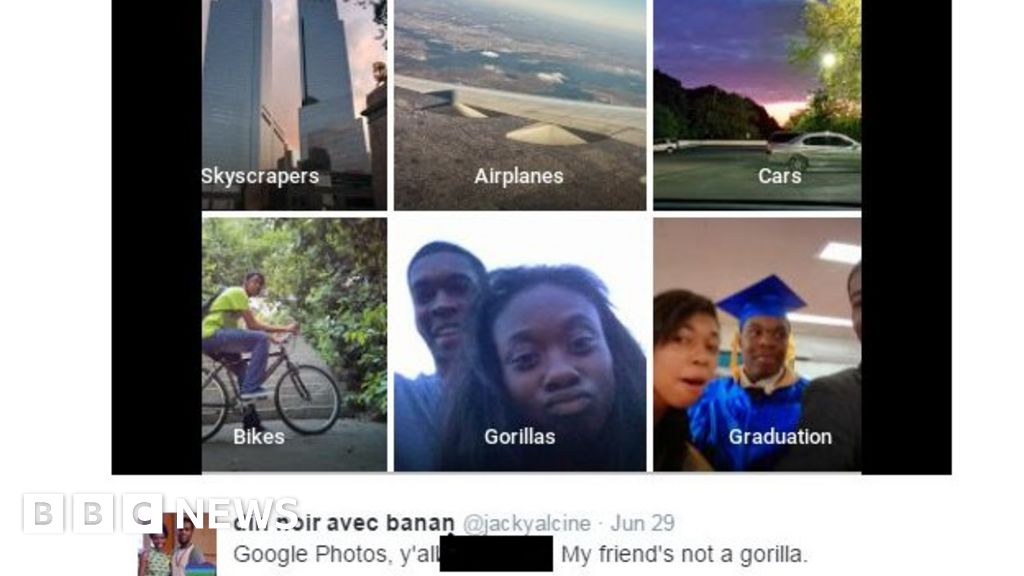

Seguro que a muchos os suena la historia del sistema de visionado de Google que confundió a un chico negro con un gorila.

Tardaron tanto en encontrar una manera de solucionar este problema (que se confundiera a una persona negra con un simio) que terminaron por retirar la categoría de “gorilas” del sistema para impedir que siguiera apareciendo esa asociación.

“El problema no es hacer algo tonto como que te echen jabón en la mano, es que la tecnología no te está reconociendo como persona. Que no es solo el enfado, es parte del problema que está generando el reconocimiento personal”, concluye Sánchez Monedero.

* Hemos actualizado este artículo el 15 de junio para incluir que Microsoft confirmó que no vendería sistemas de reconocimiento facial a la policía estadounidense poco después de los anuncios de Amazon e IBM.