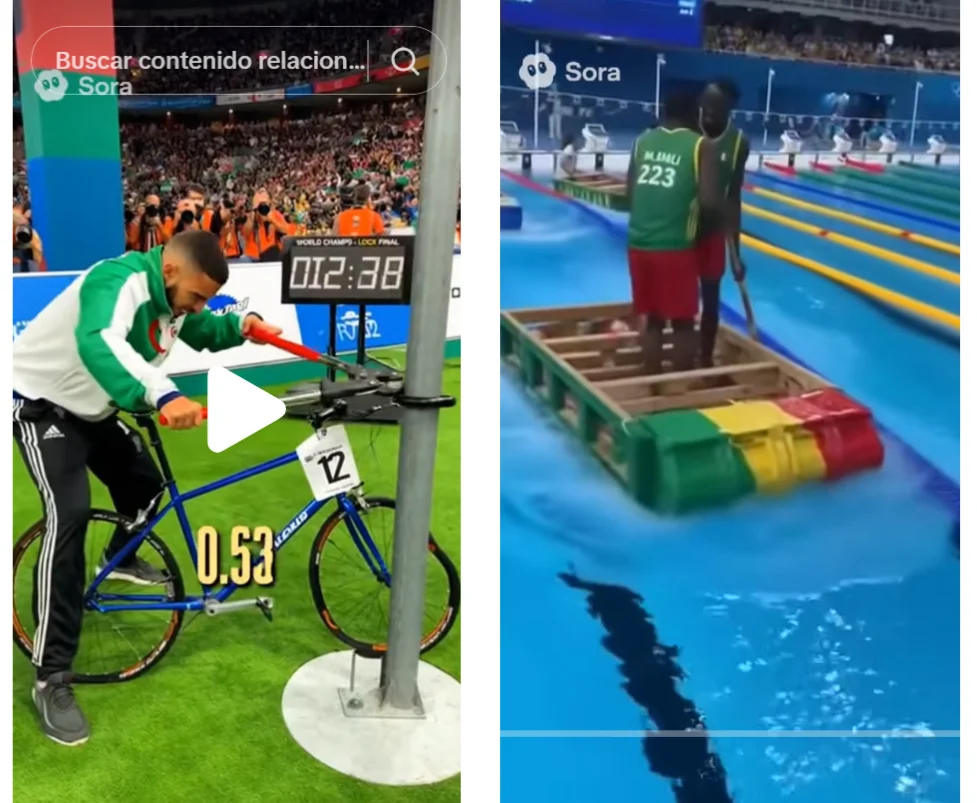

Un grupo de mujeres compiten por ver cuál de ellas consigue permanecer más tiempo callada; un hombre árabe resulta ganador en una prueba de robar bicicletas; y un judío celebra ser el primero en terminar de contar un fajo de billetes en unas olimpiadas. Son sólo tres ejemplos de los centenares de vídeos creados con Sora, un híbrido entre red social y herramienta de creación de vídeos hiperrealistas con inteligencia artificial de Open AI, que circulan esta semana en redes sociales.

Esta herramienta, impulsada por la segunda versión de modelo de generación de vídeo de OpenAI, Sora 2, se está empleando para producir contenidos desinformadores de figuras públicas de forma masiva. Aunque a fecha de publicación de este artículo no está disponible en España, esto no ha sido un impedimento para que se viralicen vídeos con los que se perpetúan narrativas y estereotipos de diferentes grupos sociales como las mujeres, las personas árabes o negras o los judíos.

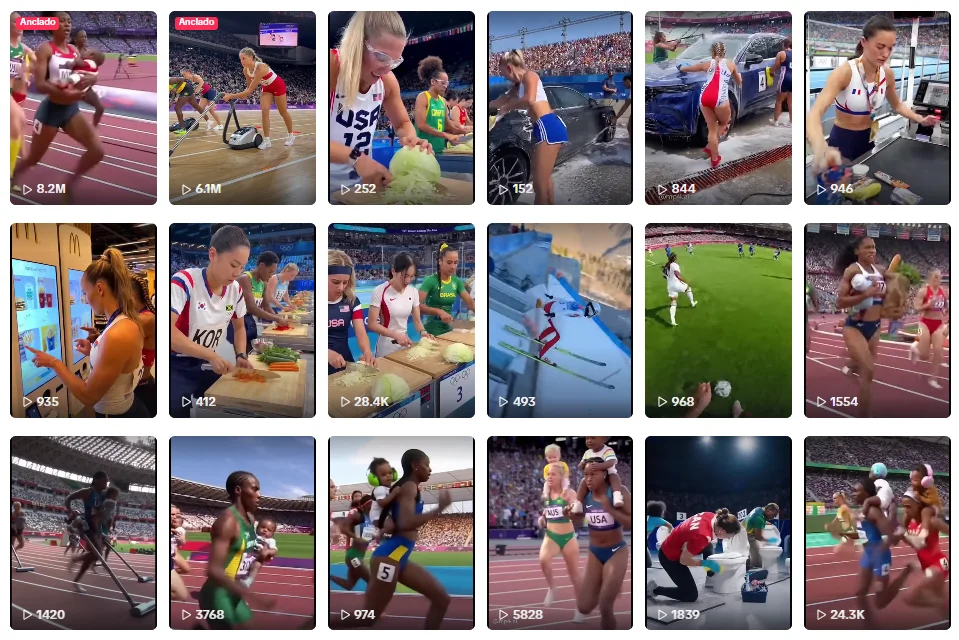

Vídeos hiperrealistas compartidos como bromas para perpetuar estereotipos sobre mujeres

En muchos de estos vídeos, que contienen hashtags advirtiendo de que son humor, se presenta a las mujeres como personas expertas en limpieza (poniendo lavadoras o pasando el aspirador), incapaces de permanecer en silencio durante mucho tiempo o negadas para conducir. A fecha de publicación de este artículo, sólo estos cuatro vídeos acumulan más de 15,8 millones de visualizaciones y decenas de comentarios machistas y violentos. Pero no son los únicos, hay muchos más ejemplos circulando en TikTok, Instagram y YouTube Shorts.

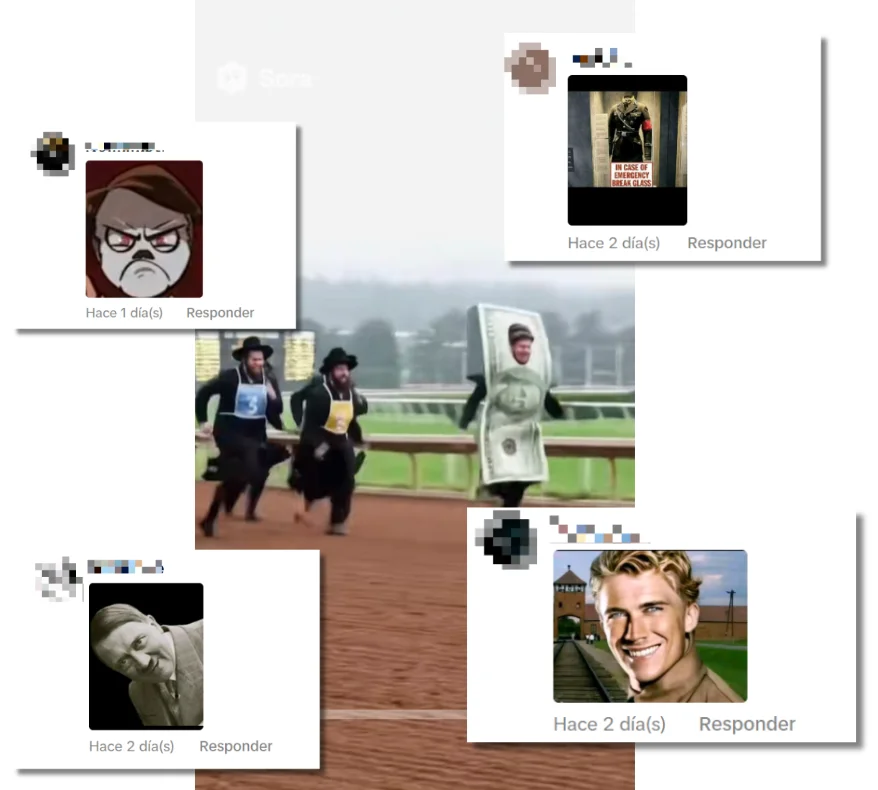

Los vídeos creados con Sora también sonun espacio para el discurso de odio contra judíos

A los judíos se les muestra como personas avaras que únicamente persiguen la riqueza o la generación de dinero. En este caso, en los comentarios de estas publicaciones se pueden observar diferentes alusiones a Adolf Hitler y su discurso antisemita. Entre ellos se repiten especialmente los memes del dictador, una estrategia que utiliza el discurso ‘pop fascista’ para colar su mensaje evitando las restricciones de las plataformas.

Las narrativas de criminalización de personas árabes, negras o inmigrantes que se difunden gracias a los vídeos de Sora

A las personas árabes o latinoamericanas se las muestra como perpetradoras de delitos, por ejemplo, robando bicicletas atadas a un poste, tratando de sustraer la cartera de un viandante sin que éste se percate o empaquetando cocaína. Esta narrativa, que asocia a personas negras o árabes con actos violentos o delictivos, es una constante.

También circulan contenidos que propagan la idea de que las personas negras entran irregularmente en otros países, con vídeos en los que se les ve saltando muros o cruzando un mar en patera. Solo estos dos ejemplos suman más de medio millón de visualizaciones.

Se utilizan falsas competiciones deportivas para propagar estos mensajes que generan desinformación y desconfianza y perpetúan estereotipos

Hay un patrón claro a la hora de difundir estos mensajes: utilizan el contexto de unas falsas olimpiadas. Por ejemplo, una prueba falsa en la que compiten varias mujeres para determinar quién regaña mejor a su pareja (todas las parejas son hombres) o una carrera entre judíos para alcanzar a un hombre disfrazado de dinero.

Presentados como si fueran humor, estos contenidos perpetúan narrativas y estereotipos de grupos sociales, y pueden reforzar actitudes machistas y fomentar mensajes racistas y xenófobos.

También pueden generar desinformación. Si se elimina la marca de agua que deja la herramienta de OpenAI en la parte superior izquierda de los vídeos (algo que se puede hacer de forma sencilla), los usuarios pueden interpretar que lo que están viendo es real y compartirlo como tal, amplificando todavía más su alcance. Además, estos vídeos hiperrealistas y sin errores visibles pueden contribuir a aumentar la sensación de desconfianza entre los usuarios.