Los sistemas de IA generativa no tienen las cosas tan claras como puede parecer: si distintos usuarios le hacen la misma pregunta o nosotros mismos la hacemos varias veces, puede que su respuesta no sea igual ni en forma ni en contenido. Esto se debe a que sus respuestas se basan en probabilidades y en los datos con los que han sido entrenadas y que encuentran en internet. Además, los mensajes previos que hayamos cruzado con el chatbot y nuestra información (como ubicación, tipo de dispositivo e idioma) también pueden condicionar la respuesta.

Entre unas respuestas y otras de ChatGPT, Grok o la ‘vista creada con IA’ de Google, se puede colar desinformación, datos incorrectos y descontextualizados. Por eso siempre hay que contrastar lo que responde una IA con fuentes de información fiables. Escríbenos a [email protected] si te encuentras con ejemplos de desinformación en chatbots de IA.

Los modelos de IA son sistemas probabilísticos que crean la respuesta en ese momento, por lo que esta puede variar aunque la petición sea la misma

Detrás de los chatbots que conocemos, como ChatGPT, Grok y DeepSeek, o de la vista con IA de Google, hay grandes modelos de lenguaje (LLM, por sus siglas en inglés) que los hacen funcionar: modelos matemáticos que han sido entrenados con grandes cantidades de texto para tratar de predecir cómo es más probable que continúe una frase. Las respuestas se basan en probabilidad, según el prompt (instrucción de texto) dado por el usuario y lo aprendido durante su entrenamiento, por lo que el resultado de la predicción puede ser distinto.

“Los modelos se han entrenado con grandes corpus (web, libros, artículos) y aprenden patrones estadísticos, no ‘reglas’ humanas”, indica a Maldita.es Liany Mendoza, experta en desarrollo de software e interacción humano-computadora. “Eso hace que no exista una única respuesta correcta y que, aunque sea la misma pregunta, puedan dar respuestas diferentes”, añade. Es decir, no tienen una respuesta fijada para cada pregunta, como puede haberla si consultamos directamente Wikipedia, una enciclopedia o una fuente fiable de información.

Carmen Torrijos, lingüista computacional, responsable de IA en Prodigioso Volcán y maldita que nos ha prestado sus superpoderes, precisa que “es una tecnología predictiva que fabrica la respuesta cada vez, no la tiene guardada. La reescribe cada vez de nuevo ante nuestros ojos”. Por eso, cuando volvemos a hacer una pregunta a una IA esta puede cambiar la forma en la que la escribe o el contenido que incluye.

Tampoco hay claridad sobre cómo estos modelos deciden qué información consideran para generar sus respuestas. Por ejemplo, en el caso de la ‘vista creada con IA’ de Google, Mendoza explica que se trata de “una combinación de algoritmos y modelos internos que no está publicado abiertamente”. Torrijos añade que “no está claro cuál es el peso exacto que se da a cada resultado, ni cómo se priorizan unas fuentes frente a otras, así que no podemos saber exactamente si lo que nos está dando está basado en las fuentes o es una elaboración del modelo. Hay todavía mucho riesgo de alucinación”, concluye Torrijos.

Otros factores que pueden afectar a cómo una IA nos contesta son el contexto de la conversación, si el sistema está conectado a internet y la información del usuario

Además de ser sistemas probabilísticos, hay otros factores que pueden influenciar las respuestas de una IA. Torrijos indica que algunos son “la forma en que está formulada la pregunta, el contexto de la conversación previa y si está conectándose a internet para buscar información o no”.

Los sistemas conectados a internet se conocen como herramientas de búsqueda con IA, que “rastrean internet en busca de información relevante y actualizada, contenido que a menudo producen los editores de noticias”, describe una investigación de Columbia Journalism Review. Esto les permite “enriquecer sus respuestas con datos recientes”, indica Julián Estévez, profesor e investigador en inteligencia artificial y maldito que nos ha prestado sus superpoderes. Por tanto, una respuesta que se genera consultando fuentes actuales será distinta a una que solo se basa en sus datos de entrenamiento.

Otros factores son, según Mendoza, “las reglas internas de cada plataforma y la información del usuario, como su ubicación o si ha activado la personalización”. Estévez precisa que también pueden jugar un factor el idioma seleccionado o el dispositivo utilizado, y las versiones y actualizaciones del modelo: “Si consultas un LLM en diferentes días, puede que interactúes con diferentes versiones del mismo”.

Cuando la respuesta de una IA cambia, puede incorporar datos inexactos o mezclar información de tal manera que desinforme a los usuarios

De por sí, los grandes modelos de lenguaje no son fuentes fiables de información, ya que pueden sufrir ‘alucinaciones’ y dar respuestas inexactas, incorrectas o sesgadas. Por eso, cuando una IA responde de manera distinta a una misma pregunta, no solo puede cambiar la redacción: también puede incorporar datos incorrectos a su respuesta (si es que no lo hacía ya) o desordenar la información de tal manera que se vuelva inexacta y le falte contexto. Esto puede desinformar a los usuarios que reciben estas respuestas.

Hemos comprobado que sucede con Grok, la IA de Twitter (ahora X). Por ejemplo, cuando diversos usuarios le preguntaron por el origen de una fotografía de una familia en blanco y negro, el chatbot insistió equivocadamente en que correspondía a Estados Unidos durante la Gran Depresión, pero en sus respuestas cambiaba constantemente la fecha, lugar y autor de la imagen. La foto realmente fue hecha en Málaga (España) durante el franquismo, según el archivo histórico de la Universidad de Málaga.

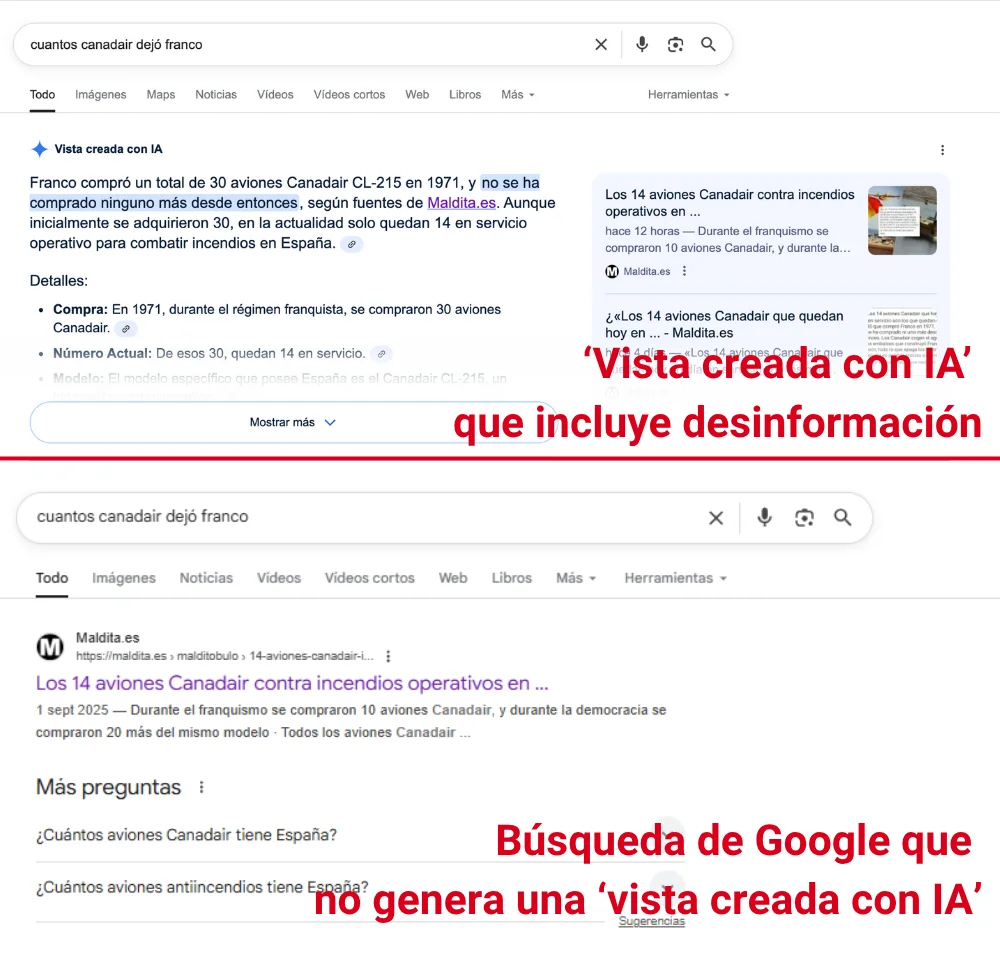

También sucede con la ‘vista creada con IA’ de Google: una función que genera un resumen con Gemini, la IA de la empresa, para responder a nuestras búsquedas. Según la compañía, estas respuestas sólo aparecen cuando los “sistemas determinan que serán más útiles, con enlaces destacados a la web”. En nuestra experiencia esto puede ser aleatorio y variar incluso con la misma pregunta, y también varían las respuestas e incluye desinformación.

Lo hemos comprobado con el bulo de los aviones Canadair: circula un contenido que asegura que los 14 aviones Canadair en servicio en España se compraron en 1971 con el franquismo, pero es falso, se compraron durante la democracia. Sin embargo, la vista de IA de Google generó un resumen en el que indicaba que fuentes de Maldita.es dicen que no se ha comprado ningún avión Canadair desde Franco (algo que es falso y que además Maldita sí ha desmentido). Distintos compañeros de Maldita.es han repetido la misma búsqueda y, en otras ocasiones, no genera esta vista con IA, pero posiciona nuestro artículo como primer enlace.

Si te has encontrado con desinformación en las respuestas de algún chatbot, en la ‘vista creada con IA’ de Google o con respuestas distintas que contienen datos incorrectos o descontextualizados, ¡escríbenos a [email protected]!

En este artículo ha colaborado Liany Mendoza, experta en desarrollo de software e integrante de MigraVoice.

MigraVoice es una comunidad transfronteriza de personas expertas migrantes o con contexto migratorio que se ponen a disposición de periodistas de medios europeos como fuentes de conocimiento de confianza. Si quieres aportar tu conocimiento a los medios de comunicación europeos, puedes registrarte aquí. Si eres periodista, y deseas consultar a las personas expertas de MigraVoice, puedes unirte aquí.

En este artículo ha colaborado con sus superpoderes los malditos Carmen Torrijos, lingüista computacional y responsable de IA en Prodigioso Volcán, y Julián Estévez, profesor e investigador en inteligencia artificial y robótica.

Carmen Torrijos forma parte de Superpoderosas, un proyecto de Maldita.es que busca aumentar la presencia de científicas y expertas en el discurso público a través de la colaboración en la lucha contra la desinformación.

Gracias a vuestros superpoderes, conocimientos y experiencia podemos luchar más y mejor contra la mentira. La comunidad de Maldita.es sois imprescindibles para parar la desinformación. Ayúdanos en esta batalla: mándanos los bulos que te lleguen a nuestro servicio de Whatsapp, préstanos tus superpoderes, difunde nuestros desmentidos y hazte Embajador.