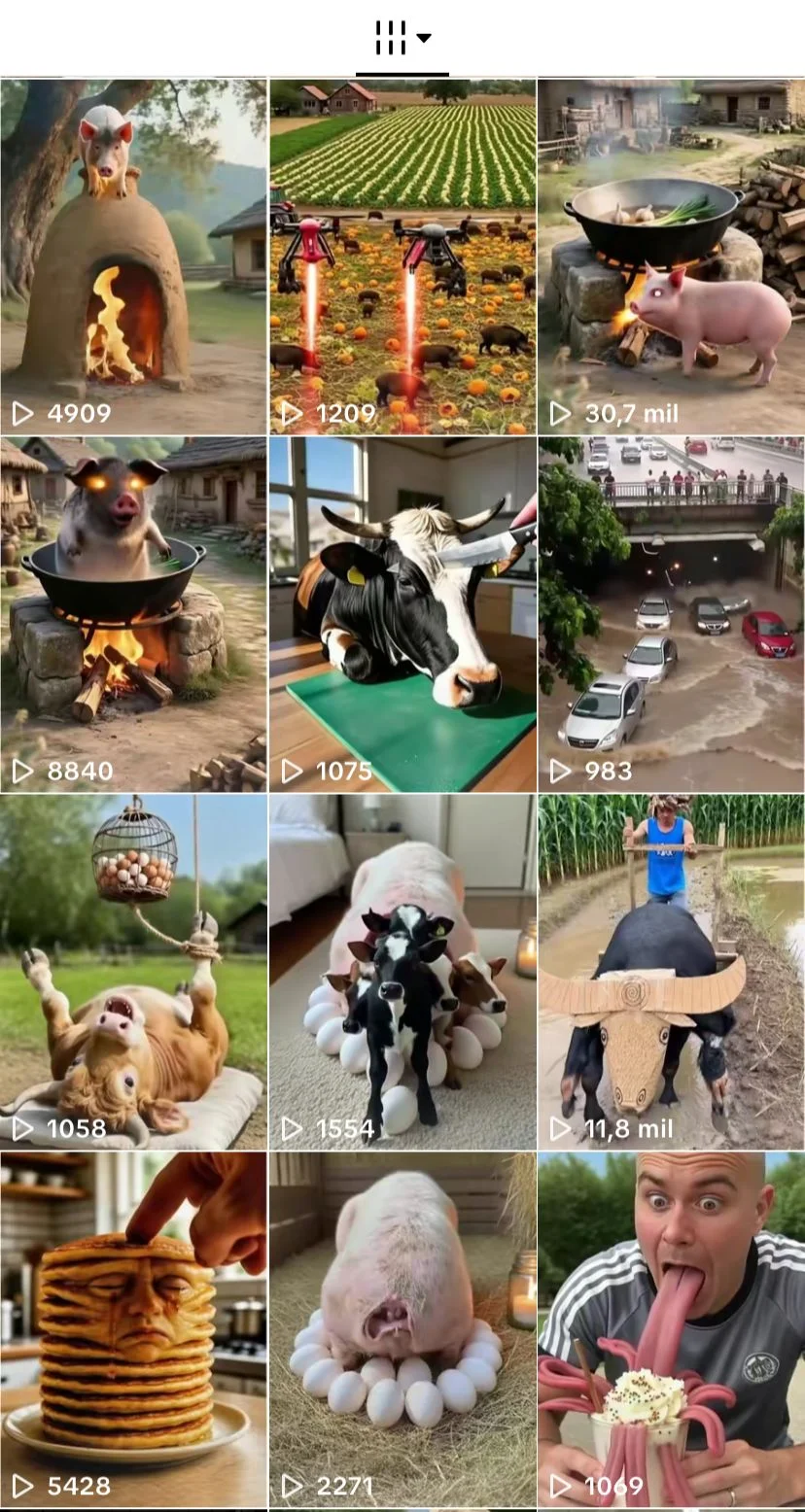

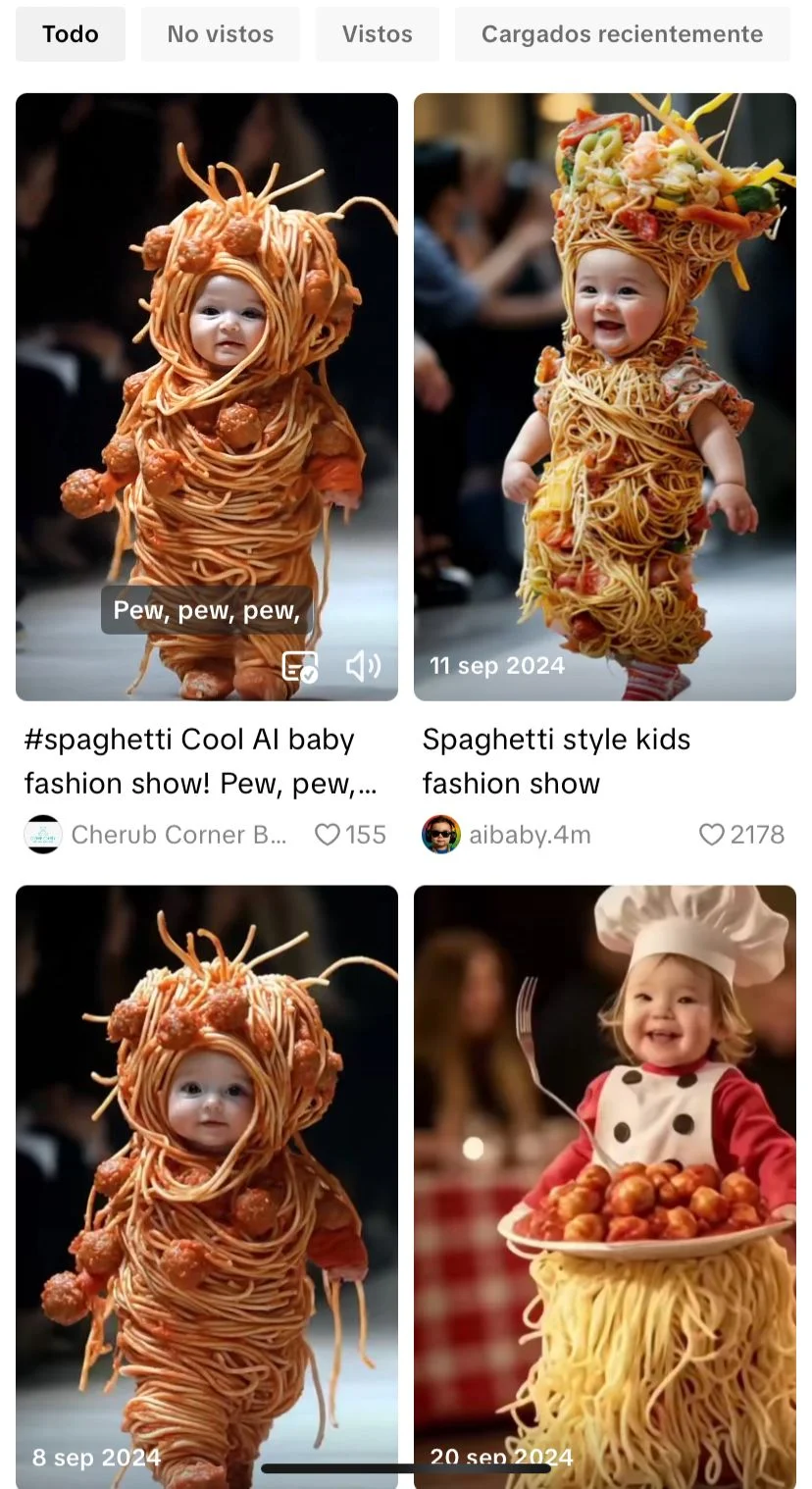

AI slop, bazofia de la IA o “bazofIA”. Así se llama a los contenidos de baja calidad creados con inteligencia artificial que llenan redes sociales, buscadores y webs: Jesús hecho de gambas, un artículo sobre el supuesto suicidio del psiquiatra de Netanyahu (no hay registro de que el profesional haya existido, según NewsGuard) o un vídeo de un bebé envuelto en espaguetis desfilando por una pasarela. La bazofia de la IA puede tomar distintas formas, pero suele ser contenido llamativo que se produce masivamente y tiene como objetivo viralizarse y generar ingresos.

Pero no es lo único que provoca: estos contenidos generan a su paso desinformación y desconfianza en los usuarios, y “contaminan los ecosistemas mediáticos”, haciendo más difícil encontrar contenido de calidad en internet, según los expertos consultados por Maldita.es. Que cada vez sea más accesible y fácil crear este tipo de contenidos con aplicaciones de IA generativa, como Vibes de Meta AI, lanzada este 25 de septiembre de 2025, agrava el problema y su impacto.

Los ‘AI slop’ son contenidos creados con IA que suelen ser llamativos, pero de baja calidad y sin valor

No es difícil encontrarnos en redes sociales e internet con bazofia de la IA, o como define a Maldita.es Javi Cantón, investigador del Departamento de Ciencias de la Computación e Inteligencia Artificial de la Universidad de Granada, “contenido generado masivamente con herramientas de IA que se publica en internet, sin ningún tipo de revisión ni intención real de informar o aportar algo de valor”.

Tampoco es complejo identificarlo, según Almudena Barreiro, experta en inteligencia artificial y maldita que nos ha prestado sus superpoderes. La especialista indica que podemos reconocer estos contenidos ya que suelen ser repetitivos, genéricos, incoherentes, con una “estética rara que no cuadra del todo”, y pueden resultar inentendibles para los usuarios. Cantón agrega que se presentan en distintos formatos, como “imágenes llamativas pero absurdas, vídeos surrealistas o incluso artículos llenos de texto que pueden parecer ‘normales’, pero que con una lectura un poco más atenta se detecta que están vacíos de contenido realmente útil”. Los vídeos de animales en situaciones heróicas o conmovedoras o los de bebés en situaciones grotescas pueden ser ejemplos de este contenido.

Son contenidos producidos de forma masiva con el objetivo de colarse en los algoritmos y generar ingresos

Otra de las características principales de los AI slop es que se producen de forma masiva, algo que les permite colarse en los algoritmos de las redes sociales y resultados de buscadores, y llegar a los usuarios. Barreiro explica que esto se debe a que es muy barato producir estos contenidos “y da resultados rápidos, aunque sean mediocres”. 404 Media define esta estrategia de producción masiva como un “ataque de fuerza bruta” a los algoritmos.

Es lo que hacen muchos perfiles dedicados a generar AI slop: publican decenas, centenares o miles de contenidos al día, con la esperanza de que logren viralizarse en redes sociales. “Los algoritmos priorizan volumen y novedad, no calidad. Así que si generas mucho, tienes más probabilidades de ‘colar’ contenido”, señala Barreiro. “Como detrás de estos algoritmos no hay nadie pilotando, la ‘bazofIA’ se cuela por todos lados, inundando los feeds, búsquedas y recomendaciones”, añade Cantón.

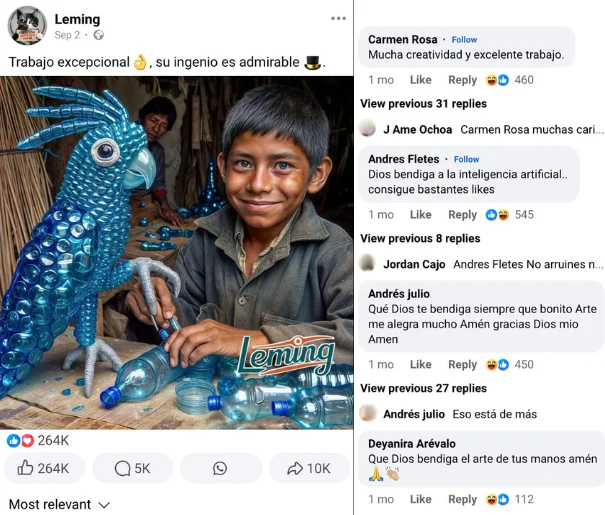

Aumentar su visibilidad es lo que permite a los creadores de estos contenidos generar ingresos. Cantón afirma que producen “de forma masiva, rápida y barata, muchas veces con el único objetivo de atraer clics o generar ingresos por publicidad”. Un ejemplo de ello son las páginas de Facebook que publican imágenes de niños, obras de arte, casas o de Jesús con mensajes grandilocuentes o cursis. Según una investigación publicada en Misinformation Review, su objetivo es ganar popularidad para monetizar su contenido, o redirigir a los usuarios a granjas de contenido (webs llenas de publicidad programática) y webs para timarlos.

Estos contenidos pueden desinformar representando situaciones que no han ocurrido y generar desconfianza

La bazofia de la IA no solo no aporta valor, también puede generar desinformación. Ya sea por la intención del usuario que los crea o por los propios errores que cometen los sistemas de IA: estos contenidos muestran o relatan situaciones que no son reales, y muchas veces las personas las toman como ciertas. “Una de las consecuencias más graves es la desinformación, y las consecuencias de esta en la sociedad”, señala Barreiro.

Un ejemplo de ello son las granjas de contenidos: webs que publican artículos de baja calidad de forma masiva para generar ingresos publicitarios. En ocasiones se disfrazan de medios de comunicación para compartir contenido falso o impreciso creado con IA, lo que puede confundir a los usuarios, desinformarlos y aumentar la desconfianza en el periodismo. “La ‘bazofIA’ aumenta la incertidumbre ante lo que vemos y leemos, y por tanto nuestra desconfianza hacia contenidos que no reafirman lo que ya creemos”, explica Cantón.

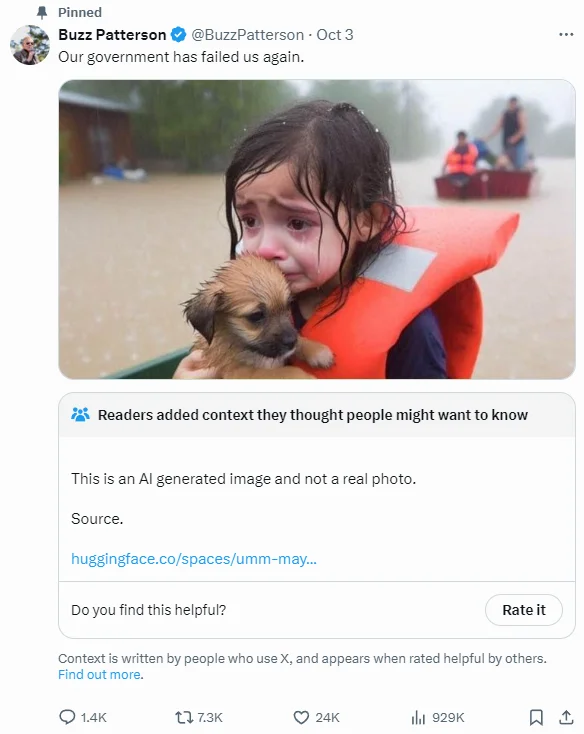

“Más allá del objetivo de ganar dinero, creo que también puede haber detrás una estrategia de sembrar caos e incredulidad para que ya no creas ninguna imagen, tampoco las reales”, afirma el investigador. De esta manera, según Cantón, “se podría aumentar el poder de ‘narrativas alternativas’”. El experto ejemplifica con la imagen viral de una niña abrazando a un cachorro en un bote durante el huracán Helene en Estados Unidos: “Aunque los usuarios sabían que era falsa, decidieron compartirla porque la interpretan como representativa de la realidad, por su poder simbólico, y se hizo viral para criticar la respuesta política”.

La bazofia de la IA contribuye a la ‘mierdificación’ de internet, que dificulta que los usuarios encuentren contenido de calidad

Estos contenidos de baja calidad creados con IA han inundado buscadores, redes sociales y sitios web, contribuyendo a la ‘mierdificación’ de las plataformas, el proceso por el cual las plataformas empeoran sus servicios hasta que dejan de servir a sus usuarios. La IA puede acelerar este proceso, ya que vuelve más fácil y rápido crear contenidos.

“Contamina los ecosistemas mediáticos por sobrecarga informativa, es basura y polución digital, ocultando el contenido legítimo y de calidad (o al menos dificultando su localización)”, advierte Cantón. Sucede con buscadores como Google, cuyos resultados se han llenado de contenidos creados con IA: si queremos buscar una imagen de un animal, de nuestro próximo destino turístico, o incluso de famosos, debemos navegar entre resultados creados con IA de poco valor hasta encontrar contenidos reales y fiables. “Todo esto no solo agota nuestra atención, sino que también degrada la experiencia digital: todo se vuelve repetitivo, falso o vacío”, agrega el investigador.

Contrasta, busca etiquetas, rastrea el origen y busca indicios de que ha sido creado con IA: consejos para identificar los ‘AI slop’

A medida que avanza la tecnología, cada vez es más difícil diferenciar los contenidos creados con IA de los reales. Algunas claves para identificar los AI slop:

Contrasta el contenido con fuentes fiables: fíjate si lo que dice ese texto o lo que muestra esa imagen o vídeo se corresponde con la realidad contrastando con fuentes oficiales, o si es un contenido de baja calidad.

Busca etiquetas en la publicación: etiquetas como “#ai” (de artificial intelligence) o las propias de la plataforma sobre contenido generado revelan que un contenido no es real. En el caso de los textos, puedes revisar si se ha señalado en el texto que este ha sido creado con IA. Ojo, esto no siempre se indica, así que si no lo encuentras no asuma que es real.

Rastrea el origen: busca la imagen o un fotograma del vídeo en la búsqueda inversa de Google para rastrear su origen. Si la persona que la compartió originalmente se identifica como creador de contenidos con IA o menciona a la inteligencia artificial en su nombre de usuario o descripción, desconfía. En el caso de los textos, puedes buscar al supuesto autor del artículo y revisar si usa IA (si no existe, también es razón para sospechar).

Observa si hay indicios de que ha sido creado con IA: hay algunos consejos que podemos seguir tanto para identificar imágenes, vídeos y textos generados con IA. Pero ten en cuenta que tienen limitaciones y pueden cambiar a medida que avanza la tecnología.

En este artículo ha colaborado con sus superpoderes la maldita Almudena Barreiro, experta en inteligencia artificial.

Almudena Barreiro forma parte de Superpoderosas, un proyecto de Maldita.es que busca aumentar la presencia de científicas y expertas en el discurso público a través de la colaboración en la lucha contra la desinformación.

Gracias a vuestros superpoderes, conocimientos y experiencia podemos luchar más y mejor contra la mentira. La comunidad de Maldita.es sois imprescindibles para parar la desinformación. Ayúdanos en esta batalla: mándanos los bulos que te lleguen a nuestro servicio de Whatsapp, préstanos tus superpoderes, difunde nuestros desmentidos y hazte Embajador.