ChatGPT, Grok, Gemini y otros chatbots de IA funcionan gracias a los grandes modelos de lenguaje (o LLM, por sus siglas en inglés de Large Language Model), modelos de inteligencia artificial que generan texto y son capaces de aprender patrones y relaciones entre palabras para generar lenguaje natural imitando a un humano. Este tipo de inteligencia artificial se ha hecho muy popular desde el lanzamiento de ChatGPT y genera texto gracias a un sistema probabilístico, que predice la siguiente palabra plausible según el prompt (las instrucciones que le damos a los programas de IA a partir de las cuales elaboran su respuesta) y lo aprendido durante su entrenamiento.

Los LLM se entrenan con cantidades masivas de datos a partir de los que aprenden los patrones y relaciones propias del lenguaje y aprenden a contestar a los usuarios con una ‘personalidad’ determinada. La capacidad de estos modelos para ‘hablar’ imitando a una persona puede hacernos pensar que todo lo que nos cuentan es verdad y llevarnos a utilizar herramientas basadas en LLM como buscadores, para verificar contenidos, como si fueran un terapeuta o incluso para entablar una relación sentimental. Sin embargo, su funcionamiento está condicionado por factores como el diseño del modelo, su entrenamiento y el prompt introducido por el usuario. A pesar de que se trata de una tecnología con múltiples posibilidades, los expertos consultados por Maldita.es recomiendan siempre contrastar las respuestas que devuelve.

Los grandes modelos de lenguaje funcionan prediciendo cómo es más probable que continúe una frase

Los grandes modelos de lenguaje o LLM son modelos matemáticos que han sido entrenados con grandes cantidades de texto para tratar de predecir cómo es más probable que continúe una frase. “Los LLM son fundamentalmente sistemas de autocompletado de texto, como el teclado del móvil cuando sugiere la siguiente palabra”, explica Iris Domínguez, que investiga sobre inteligencia artificial y nos ha prestado sus superpoderes. “La diferencia principal es que, donde antes el autocompletado del móvil simplemente miraba las últimas dos o tres palabras escritas y en base eso decidía cuál era la siguiente palabra más probable, los LLM leen todo el texto, de manera que las respuestas pueden ser mucho más profundas”, añade.

A fecha de publicación de este artículo, algunos ejemplos de los LLM que hacen posible el funcionamiento de los chatbots más conocidos son GPT-4.5, el modelo que hay tras ChatGPT; Grok 3 para la IA de X (antes Twitter); Llama 3.1 tras la IA de Meta y DeepSeek LLM en el caso del chatbot chino DeepSeek.

Domínguez explica que, en la actualidad, las aplicaciones más populares de los LLM son la traducción de textos y la programación, pero que se trata de una tecnología con múltiples posibilidades. “Tenemos desde los resúmenes automáticos de textos largos, la moderación automática de redes sociales, los chatbots de compañía, los asistentes virtuales…”, pero recalca que no en todas está “a la altura de reemplazar a seres humanos”.

Además, recuerda que “aunque suenen y se expresen mejor que tú o que yo, y aunque en muchos campos ‘sepan’ más, aún no tienen la capacidad de pensar y sentir con la complejidad que lo hacemos los humanos”. Realmente, una IA no entiende ni comprende lo que dice. Sobre si la IA será capaz alguna vez de realizar cualquier tarea intelectual, lo que se conoce como inteligencia artificial general (AIG), existen discrepancias entre los expertos. Los consultados por Maldita.es coinciden en que su desarrollo está en una fase temprana, y que a día de hoy, sigue siendo un problema sin resolver.

Los LLM se entrenan a partir de cantidades masivas de datos para aprender a generar texto que suene a algo escrito por una persona

El entrenamiento de los LLM cuenta, en general (porque puede depender del modelo), con dos etapas. En una primera fase se entrenará el modelo a partir de cantidades masivas de datos que incluyen desde la Wikipedia al completo hasta artículos de revistas y periódicos, libros, código informático, transcripciones de vídeos y guiones de películas, y mensajes de redes sociales, explica Domínguez. “Básicamente todo lo que las empresas que los entrenan sean capaces de reunir”. Es en esta primera fase en la que los grandes modelos de lenguaje aprenderán los patrones y relaciones propias del lenguaje.

En la segunda fase, “lo convertimos en algo que contesta a un usuario de forma útil”, continúa Domínguez. “Por lo general, aquí se entrena sobre un conjunto de datos mucho más pequeño, conversaciones escritas y seleccionadas por los trabajadores de la compañía que está entrenando el modelo”. Esta etapa le dará “personalidad” y determinará la forma en la que el modelo contesta a los usuarios (o no contesta, como el caso del chatbot DeepSeek cuando le preguntas qué pasó en la plaza de Tiananmen).

¿Cómo es el proceso de aprendizaje de estos modelos a partir de todos estos datos? “A nivel interno, cada palabra (en realidad, fragmento de palabra, que se denomina token) se convierte en números según un diccionario”, explica Domínguez. Después, indica que se aplica un modelo, que es una “gran función matemática” sobre un trozo de un texto para comprobar qué palabra devuelve. En caso de que el resultado no sea el deseado se ajustará la función para que nos ofrezca la palabra que queremos. “Repitiendo este proceso sobre cientos de millones de palabras y textos, eventualmente, el modelo acaba aprendiendo a generar texto que suena humano”, detalla.

Hay que tener cuidado, porque las respuestas generadas por chatbots de IA basados en LLM pueden presentar ‘alucinaciones’ o sesgos debido a su diseño o a los datos de entrenamiento utilizados

A partir de este entrenamiento, así como del prompt introducido, genera sus respuestas. Por tanto, las herramientas basadas en LLM como los chatbots no son fuentes fiables de información, ya que pueden mezclar los datos, desordenarlos y cometer errores. Los modelos pueden producir respuestas incorrectas o inexactas, también conocidas como ‘alucinaciones’. “Cuando el modelo no sabe un dato, pero igualmente te contesta con confianza, como si lo supiese”, aclara Domínguez.

Además, los desinformadores pueden intentar aprovechar esta forma de aprender de los modelos para tratar de manipular las respuestas de los chatbots de IA a través de técnicas como el ‘LLM grooming’. Esta práctica consiste en saturar la web con desinformación para tratar de introducirla en los datos de entrenamiento de las herramientas basadas en LLM, como los chatbots, y conseguir que sus respuestas difundan este contenido falso.

Esta forma de aprender y el diseño del modelo puede dar lugar también a sesgos en los textos generados, que pueden ser raciales o de género, entre otros. “La presencia de sesgos de género en estos modelos puede tener consecuencias significativas y preocupantes porque están creando verdades algorítmicas irrefutables que refuerzan un modelo único”, explica Lorena Fernández, experta en perspectiva de género en tecnología y maldita que nos ha prestado sus superpoderes. Los modelos también pueden presentar el conocido como sesgo de equidistancia artificial, que evita que el modelo se posicione con respecto a temas que pueden considerarse polémicos, como el feminismo o el cambio climático, o el sesgo de adulación, arrojando la respuesta que queremos escuchar.

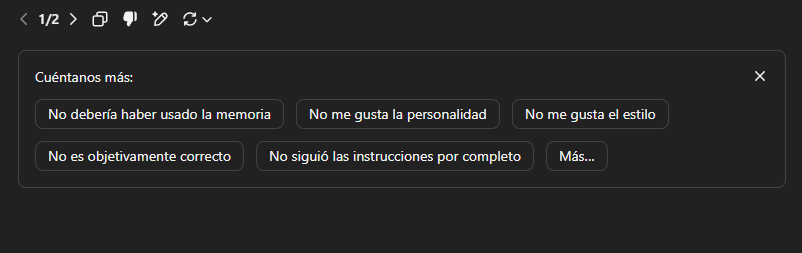

Fernández considera importante “prestar atención al lenguaje utilizado” por la herramienta para detectar sesgos y contrastar la respuesta arrojada con otras fuentes. En caso de que se detecten sesgos, explica que “conviene reportarlos a la plataforma correspondiente para contribuir a la mejora de la misma”. En el caso de ChatGPT, por ejemplo, se puede pulsar el pulgar hacia abajo que aparece bajo el texto generado para reportar una respuesta incorrecta y aportar comentarios adicionales.

En este artículo han colaborado con sus superpoderes la maldita Lorena Fernández, experta en perspectiva de género en tecnología, e Iris Domínguez, que investiga sobre inteligencia artificial, justicia algorítmica y sesgos de IA.

Lorena Fernández forma parte de Superpoderosas, un proyecto de Maldita.es que busca aumentar la presencia de científicas y expertas en el discurso público a través de la colaboración en la lucha contra la desinformación.

Gracias a vuestros superpoderes, conocimientos y experiencia podemos luchar más y mejor contra la mentira. La comunidad de Maldita.es sois imprescindibles para parar la desinformación. Ayúdanos en esta batalla: mándanos los bulos que te lleguen a nuestro servicio de Whatsapp, préstanos tus superpoderes, difunde nuestros desmentidos y hazte Embajador.