El conversor de texto a voz que utilizaba el astrofísico Stephen Hawking ha evolucionado: los avances en inteligencia artificial han permitido la creación de voces sintéticas (voces generadas a través de un software y que imitan nuestra forma de hablar), cada vez más naturales y menos robotizadas. Gracias a técnicas como la clonación de voz, con las que la máquina recrea cómo suena una persona en concreto, se puede conservar este rasgo y se puede emplear para devolver la capacidad de hablar a quiénes la han perdido, ya sea por una enfermedad, una discapacidad o un accidente. Un proceso que ayuda a combatir la sensación de “deshumanización” que se puede sentir con una voz genérica (que es la misma para diferentes personas) y mejorar su calidad de vida. Fue el caso del padre de Álvaro Medina, periodista en Prodigioso Volcán, que nos contó cómo la ciencia y la tecnología lo hicieron posible en la Maldita Twitchería Tecnológica.

Las voces sintéticas se emplean en herramientas de accesibilidad, como conversores de texto a voz, como el que usaba Stephen Hawking

El proceso por el que una voz sintética es capaz de imitar la forma de hablar que tenemos los humanos se puede hacer de diferentes maneras, como reproduciendo una biblioteca de audios ya grabados, o a partir de un sintetizador de voz que enuncie los diferentes sonidos que componen una oración tal y como lo haría una persona.

Para esto se pueden desarrollar sistemas text-to-speech (conversión de texto a voz), que permiten a la máquina interpretar un texto en escrito, dividir las diferentes palabras en fonemas y reproducirlo en forma de audio. En este artículo hay más detalles.

La conversión de texto a voz tiene diferentes aplicaciones, entre ellas la creación de herramientas de accesibilidad para personas que han perdido el habla, ya sea por una enfermedad o un accidente. Gracias a estos sistemas text-to-speech, estas personas se pueden comunicar escribiendo frases en un dispositivo, que posteriormente reproduce ese texto en forma de sonido.

El ejemplo más conocido es el sistema que utilizaba el astrofísico Stephen Hawking para comunicarse. El divulgador fue diagnosticado a los 21 años de Esclerosis Lateral Amiotrófica (ELA), una enfermedad neurodegenerativa que afecta a las células nerviosas motoras e impide que éstas envíen señales a los músculos. Poco a poco fue perdiendo la capacidad de hablar, pero era capaz de comunicarse escribiendo frases en su ordenador, que la máquina recitaba en voz alta.

Hasta hace unos años estas voces sintéticas sonaban poco naturales y eran bastante impersonales y artificiales (no recreaban la voz de la persona). Pero gracias al uso de la inteligencia artificial, ahora es posible que estas voces suenen mucho más realistas y que imiten la forma de hablar de una persona en concreto, gracias a la clonación de voz.

Con la clonación de voz, la IA permite recrear voces de personas concretas y que quienes la han perdido la puedan recuperar, como enfermos de ELA

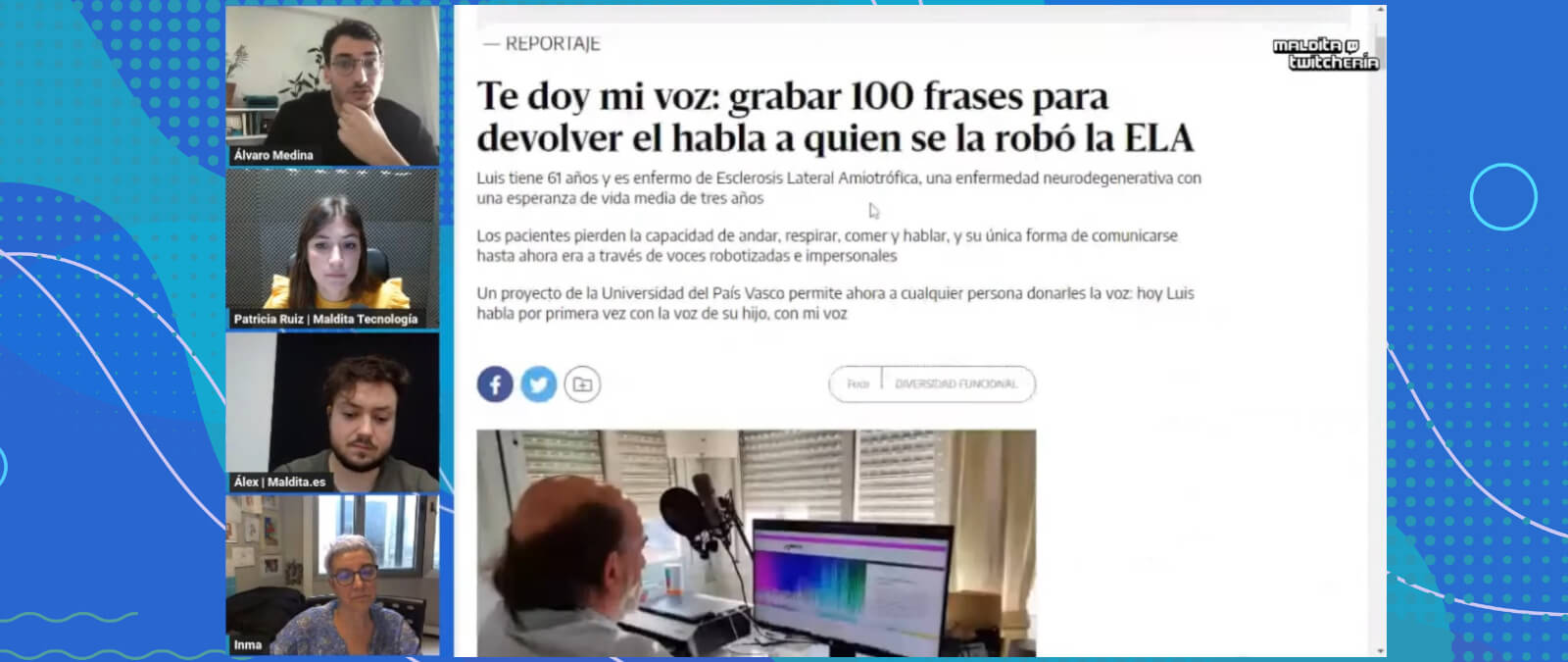

La clonación de voz se puede utilizar para personalizar estos sistemas text-to-speech. Una posibilidad que puede mejorar la calidad de vida de las personas que han perdido el habla, que muchas veces se ven obligados a utilizar la misma voz genérica que otras personas, con la deshumanización que ello conlleva. Es la historia de Álvaro Medina, periodista en Prodigioso Volcán, que nos contó en la Twitchería de Maldita Tecnología cómo gracias a Inma Hernáez, catedrática de la UPV/EHU y directora del laboratorio de investigación Aholab (especializado en el procesado digital de la voz), pudo donar su voz a su padre enfermo de ELA y mejorar su calidad de vida.

El padre de Medina, Luis, fue diagnosticado con ELA en 2019, y a los pocos meses perdió la capacidad de hablar, según ha contado el periodista en elDiario.es. “Eso no sólo implica un problema comunicacional, sino también un componente emocional muy grande”, detalló Medina, que también incidió en que en los sistemas text-to-speech habituales “la voz es común a todos, hay pocas opciones para elegir, con la deshumanización que eso implica”.

Fue en ese momento cuando Medina descubrió a Hernáez y el proyecto AhoMyTTS: una iniciativa que permite “donar” nuestra voz para crear un “banco de voces sintéticas” y proporcionar sistemas de conversión de texto a voz personalizados. A través de esta iniciativa, Luis era capaz de escribir cualquier oración en la máquina y que fuera la voz sintética de su hijo (parecida a la suya) quién la leyera en alto. Medina aseguró que gracias a este proyecto su padre pudo mejorar su calidad de vida y afirmó que muchos pacientes de ELA, al perder la voz y ser incapaces de comunicarse oralmente, “se aíslan por completo”.

Hay más historias positivas del uso de la IA y las voces sintéticas para enfermos de ELA. The Washington Post ha recogido el testimonio de diferentes pacientes que han podido recuperar su forma de hablar . Es el caso de Ron Brady, diagnosticado con ELA en 2020 con 52 años, que gracias a la clonación de voz a través de esta tecnología, ha podido conservar su voz.

“Cuando oí mi voz mejorada, sentí que era la primera vez desde que me diagnosticaron que alguna parte de mí realmente mejoraba”, ha detallado Brady, que actualmente emplea un teclado para poder comunicarse con los demás a través de un sistema text-to-speech. “Perder mi voz es duro, porque pierdo la habilidad de interactuar con otras personas. Tener mi voz sintética me permite poder recuperar un poco de eso”.

Ruth Brunton, paciente de ELA desde marzo de 2021, también tuvo una experiencia similar. A los pocos meses de su diagnóstico perdió la capacidad de hablar, lo que la llevó a recurrir a una compañía especializada en voces sintéticas para intentar preservar su voz. Sin embargo, Brunton no conseguía sentirse identificada a través de aquella voz sintética, ya que la empresa utilizó un sintetizador de voz tradicional que no conseguía imitar del todo su forma de hablar.

No fue hasta que acudió a otra compañía que hacía uso de la inteligencia artificial para clonar voces, que la paciente sintió que había recuperado su voz. “Me sorprendió lo mucho que significaba para mí tener una voz que sonara realmente como yo. Puede parecer una tontería, pero tener mi propia voz aumentó mi confianza en mí misma".

Las voces clonadas también sirven para personas que han perdido la voz en un accidente, y se puede rescatar de audios antiguos

Las voces sintéticas también pueden servir para quién haya perdido la voz en un accidente. El político argentino Jorge Rivas fue víctima de un asalto en 2007 que le provocó una tetraplejía, perdiendo la capacidad de hablar. Desde entonces utiliza un sistema text-to-speech para comunicarse, a través de una voz sintética genérica.

Pero el pasado 12 de junio de 2023 Jorge Rivas presentó junto al Ministerio de Ciencia, Tecnología e Innovación de Argentina el proyecto Mi identidad vocal: una iniciativa pública que busca recuperar la voz original de una persona a través de la inteligencia artificial, y que permitirá clonar la voz de Rivas a partir del material audiovisual disponible antes del incidente, según recoge Forbes.

"Es el primer software de esta naturaleza que se realiza en nuestro país y que será de acceso universal, es decir, que podrá acceder a él quien lo necesite y no quien pueda”, aseguró Rivas durante la presentación del proyecto, donde también incidió en que “la voz también es un derecho, que se valora sobre todo cuando se lo pierde”.

El proyecto, desarrollado por la Universidad Tecnológica Nacional - Facultad Regional La Plata (UTN-FRLP) empleará la clonación de voz a través de inteligencia artificial para que “quien esté perdiendo o haya perdido su capacidad del habla, poder hacerlo nuevamente con el mismo timbre y características de su particular forma de hablar”, según detalló el Gobierno de Argentina en una nota de prensa.