No paramos de hablar del reconocimiento facial. Es muy probable que te suene por leerlo en medios de comunicación, en redes sociales como Facebook o Instagram e incluso en situaciones de nuestro mundo analógico, como al ir a embarcar un avión en un aeropuerto. Sin embargo, hay muchos tipos de reconocimiento de imágenes, no solo el que identifica a una persona a partir de una foto de su cara. La tecnología que ‘reconoce’ imágenes se programa para que sepa que en una imagen aparece un árbol, un gato o una moto y etiquetarlo como tal.

En el caso de las personas, también se puede aplicar el reconocimiento de imágenes, sin que tenga que usarse necesariamente reconocimiento facial. En este caso, el programa informático reconoce que en la imagen hay una persona, aunque no sepa quién es. Te hablamos a fondo de cómo funcionan estos sistemas en este artículo sobre cómo funcionan los filtros de redes como Instagram o TikTok.

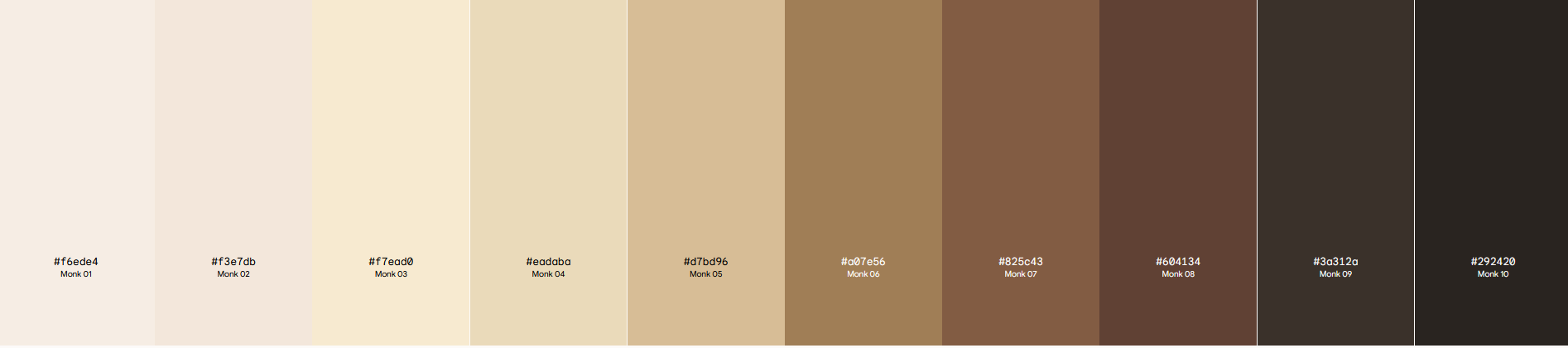

Una escala inclusiva de tonos de piel

El problema es que, a lo largo de los años, nos hemos encontrado con que los algoritmos de empresas destacadas por su trabajo con la inteligencia artificial, como Google o Meta (Facebook), han presentado graves problemas a la hora de clasificar a personas con la piel oscura. Incluso, han llegado a etiquetar imágenes de personas con la piel negra como si fuesen simios. El caso de Google fue muy sonado en 2015 y a Facebook le pasó recientemente, en 2021. También ha tenido problemas Twitter: los parámetros de su algoritmo de reconocimiento de imágenes tendían a destacar las imágenes en las que salían personas con la piel blanca al recortarlas. La primera reacción de las empresas era común: salir a disculparse por el error, pero sin dejar de usar la tecnología. Twitter, concretamente, sí que hizo un análisis interno para comprobar si su algoritmo podría presentar sesgos (la conclusión fue que sí).

En esta línea, en mayo de 2022, Google anunció que estaba colaborando con el sociólogo y profesor de Harvard Ellis Monk para implementar una escala diseñada para ser “más inclusiva con el espectro de tonos de piel que vemos en la sociedad”. De aquí sale la escala de tonos de piel Monk (Monk Skin Tone o MST en inglés), que incluye diez tonos diferentes que, según dicen, son más “representativos”, especialmente de las personas con la piel negra.

“La escala MST nos ayudará tanto a nosotros como a la industria tecnológica en general a crear conjuntos de datos más representativos para poder entrenar y evaluar los modelos de inteligencia artificial en equidad, que resultará en funcionalidades y productos que funcionen mejor para todos y para todos los tonos de piel. Por ejemplo, utilizamos la escala para evaluar y mejorar los modelos que detectan rostros en las imágenes”, escribe en el blog de Google Tulsee Doshi, jefa de Producto e Inteligencia Responsable de la empresa.

Según informa Google, aplicarán esta escala en sus productos de clasificación de imágenes basados en inteligencia artificial, como la búsqueda de imágenes en Google o “Photos”, su programa de almacenamiento y etiquetado de imágenes disponible para Android.

Los fallos del reconocimiento facial hacia personas racializadas y ciertas minorías

Timnit Gebru, una exinvestigadora en ética de la Inteligencia Artificial en Google, trabajó en esta acción antes de que fuese despedida por la empresa por señalar que en el desarrollo de la tecnología se estaban obviando importantes consideraciones de los fallos que tienen hacia las personas racializadas y ciertas minorías. Asegura que ella introdujo el trabajo de Ellis Monk en Google, a pesar de que la echasen de su puesto por poner en evidencia la posición de la multinacional ante los temas relacionados con la IA y el racismo. Su caso desembocó en una polémica global.

Thank you Google for talking about the "pioneering" gender shades study & talking about the Monk scale that I introduced you to :)

— Timnit Gebru (@timnitGebru) May 11, 2022

I met Dr. Ellis Monk when I was interviewing at Harvard

https://t.co/IGCZh5YrzQ

Sabemos que el reconocimiento de imágenes clasifica en ocasiones de forma errónea a las personas -en el peor de los casos, confundiéndolas con primates-, y también que el reconocimiento facial presenta más fallos y falsos positivos cuando analizan a personas negras, especialmente si hablamos de las mujeres, tal y como te hemos contado en otras ocasiones en Maldita.es.

“El problema de base de cuando se dice que la IA es racista viene de reconocer la existencia de la raza a nivel fenotípico”, señala Javier Sánchez Monedero, investigador en inteligencia artificial del Data Justice Lab y la Universidad de Córdoba y miembro de AlgoRace. Para evaluar el rendimiento de un algoritmo, se piensa en hacer “subescalas por distintos tonos de piel u oscuridad” para que los sistemas no fallen, ya que los errores provienen de la falta de representación de la piel oscura.

Implementar este tipo de ‘subescalas’ contempla que el problema que presentan estas tecnologías es el “binarismo” que se asocia a que solo haya personas “blancas” o “negras”. Para explicarlo, el especialista pone un ejemplo usado en la medicina: “Es como si en vez de asumir que solo hay jóvenes y ancianos, se van estableciendo rangos de edad en diez en diez. En medicina esto se llama estratificación de la muestra: hasta tal rango de edad se recomienda una dosis y hasta el siguiente otra”, expone.

Desde Maldita.es nos hemos puesto en contacto con Google para preguntar por la aplicación de esta escala y para conocer cuál utilizaban previamente, pero al momento de publicación de este artículo no hemos recibido respuesta.