Hablar de la inteligencia artificial (IA) como un sujeto en sí es complicado porque tiene muchas finalidades distintas y métodos de aplicación. Varias de ellas consisten en analizar a las personas para obtener un resultado específico: identificarlas a partir de sus datos biométricos, como te hemos contado en alguna ocasión, pero también predecir rasgos de su personalidad, su estado de ánimo o incluso su eficiencia para desempeñar mejor o peor un trabajo. A esta última aplicación se le llama ‘reconocimiento de emociones’ y es de lo que vamos a hablar hoy.

El reconocimiento de emociones no es un área de estudio nueva pero en los últimos años se ha extendido mucho dentro del campo de la inteligencia artificial. Como os podréis imaginar, lo que se trata de hacer es diseñar y entrenar programas informáticos para que de forma automática digan cómo se siente una persona. A partir de ahí, las personas que manejan esos sistemas pueden tomar ciertas decisiones en base a lo que ven o que directamente la tome el propio programa informático. ¿Decisiones como cuáles? Pues por ejemplo, si una persona es apta para un puesto de trabajo en función de cómo haga una entrevista grabada en vídeo.

Buscando la personalidad de alguien en sus expresiones faciales

Algunas de las empresas que desarrollan programas informáticos que analizan este tipo de vídeos dicen hacerlo porque así el proceso es más “objetivo”. Sin embargo, en la mayoría de los casos los algoritmos no tienen capacidad para ser más objetivos que una persona, sino que terminan causando una discriminación estructural. Es decir, que discriminen a un segmento concreto de una población, como un grupo étnico.

Por ejemplo, una start-up alemana que utiliza este tipo de programa asegura que el sistema basado en inteligencia artificial que ha creado analiza el tono de la voz, el lenguaje, los gestos y las expresiones faciales para crear un “perfil de personalidad de comportamiento”. Este perfil se guía por las variables del modelo psicológico OCEAN, que analiza cinco rasgos de personalidad: lo ‘abierta de miras’ que es una persona, si es es escrupulosa, si es extrovertida, amable y, por último, si es emocionalmente inestable. Investigadores que han hecho pruebas con el programa informático han comprobado que es posible confundir al sistema con cosas tan simples como ponerse unas gafas, un pañuelo en la cabeza o incluso colocando una estantería con libros de fondo. ¿De qué manera está este sistema siendo “objetivo”?

El análisis de entrevistas de trabajo, ya sea en vídeo o en directo, es sólo una de las aplicaciones que tienen los sistemas basados en inteligencia artificial emocional y una forma de medir parámetros emocionales de las personas. “Tradicionalmente, la investigación de reconocimiento de emociones se basaba en su mayoría en la interpretación de la expresión facial”, señala a Maldita.es, Agata Lapedriza, investigadora en el eHealth Center de la UOC. Actualmente, dice, se analizan también señales fisiológicas capturadas con sensores, como el ritmo cardíaco, el ritmo de la respiración o la sudoración de la piel.

“Por ejemplo, cuando estamos nerviosos suele subir el ritmo cardíaco y sudamos más. Por lo tanto, si se aprende más sobre estas relaciones entre los cambios de estado emocional y los cambios fisiológicos se pueden crear tecnologías que, a partir de procesar las señales fisiológicas se pueda obtener información sobre los cambios de estado emocional”, añade esta investigadora.

Sin embargo, también advierte que todo esto ocurre en un plano investigativo: “Estamos intentando descubrir cómo hacer algo que no sabemos hacer y estamos creando conocimiento nuevo. Durante este proceso puede haber confusiones, errores o equivocaciones, es normal. El problema es cuando se aplica una investigación que no está suficientemente madura para casos reales”.

La base de esta tecnología ha pasado a considerarse "pseudociencia"

Grupos de investigación más recientes han calificado el reconocimiento de emociones como “pseudociencia” porque aseguran que no es posible asumir que de manera universal las personas expresan sus emociones de la misma forma, contando además con que en muchas ocasiones estas se reprimen. Lapedriza expone que esta asunción se hace porque para algunos programas informáticos se siguen usando teorías que eran válidas hace unos años pero que desde hace poco están en discusión.

Estas teorías son las que se han usado para diseñar modelos tecnológicos interpretando las expresiones faciales, como señalaba esta profesora. Concretamente, durante años se han basado en unos estudios que lideró el psicólogo Paul Ekman del año 1972. Su conclusión es que existen seis emociones básicas que las personas expresan de manera universal: enfado, asco, miedo, felicidad, tristeza y sorpresa. En base a esa valoración, un sistema de visión por computador podría analizar nuestra cara y si sonreímos o fruncimos el ceño y reconocer si experimentamos una de esas emociones.

“El problema es que no hay realmente una correspondencia entre tus movimientos faciales y tus emociones”, continúa Lapedriza. “Cuando estamos felices a veces sonreímos, pero otras no. Y cuando sonreímos, el motivo por el que sonreímos puede ser por felicidad o por otro motivo, por ejemplo para quedar bien. Así pues, es cierto que la expresión y los movimientos de la cara llevan mucha información emocional, pero establecer la correspondencia entre la cara y las emociones de la persona es un poco más complejo”.

Gran parte de la investigación en reconocimiento de emociones se ha hecho usando las premisas de Ekman, pero a día de hoy otras investigaciones la han refutado. Concretamente, este estudio establece que “no hay suficientes evidencias” para sostener ese paradigma de emociones universales, ya que esas expresiones faciales no son “huellas dactilares” o “diagnósticos” que sean fiables sin analizar el contexto de la situación, a la persona y su cultura.

Es además uno de los estudios en los que se está apoyando ahora la comunidad investigadora de IA para evaluar el uso de esta tecnología, como apunta este informe del AI Now Institute de la Universidad de Nueva York. Otra investigación al respecto cuestiona también el papel de la cultura: por ejemplo, señala que aunque las personas asiáticas del este y el oeste del continente tienen conceptos similares de cómo se expresa el dolor, tienen diferentes ideas de cómo muestran placer.

Los programas informáticos ignoran el contexto o la situación de una persona a la hora de analizarla

“Los sistemas de reconocimiento de emociones comparten una serie de cianotipos y asunciones fundamentales: que hay un pequeño número de categorías emocionales distintivas y universales, que las personas involuntariamente mostramos esas emociones en nuestras caras y que estas pueden ser detectadas por máquinas”, explica en este artículo en The Atlantic Kate Crawford, una de las más reconocidas investigadoras de inteligencia artificial a nivel global, que actualmente trabaja en Microsoft, y autora del informe del AI Now Institute.

Con ella coincide Javier Sánchez, investigador de IA en Data Justice Lab y la Universidad de Córdoba: “La base fundamental está rota. Hay una serie de categorías compactas a través del lenguaje de la cara pero se ignora el contexto y la situación”.

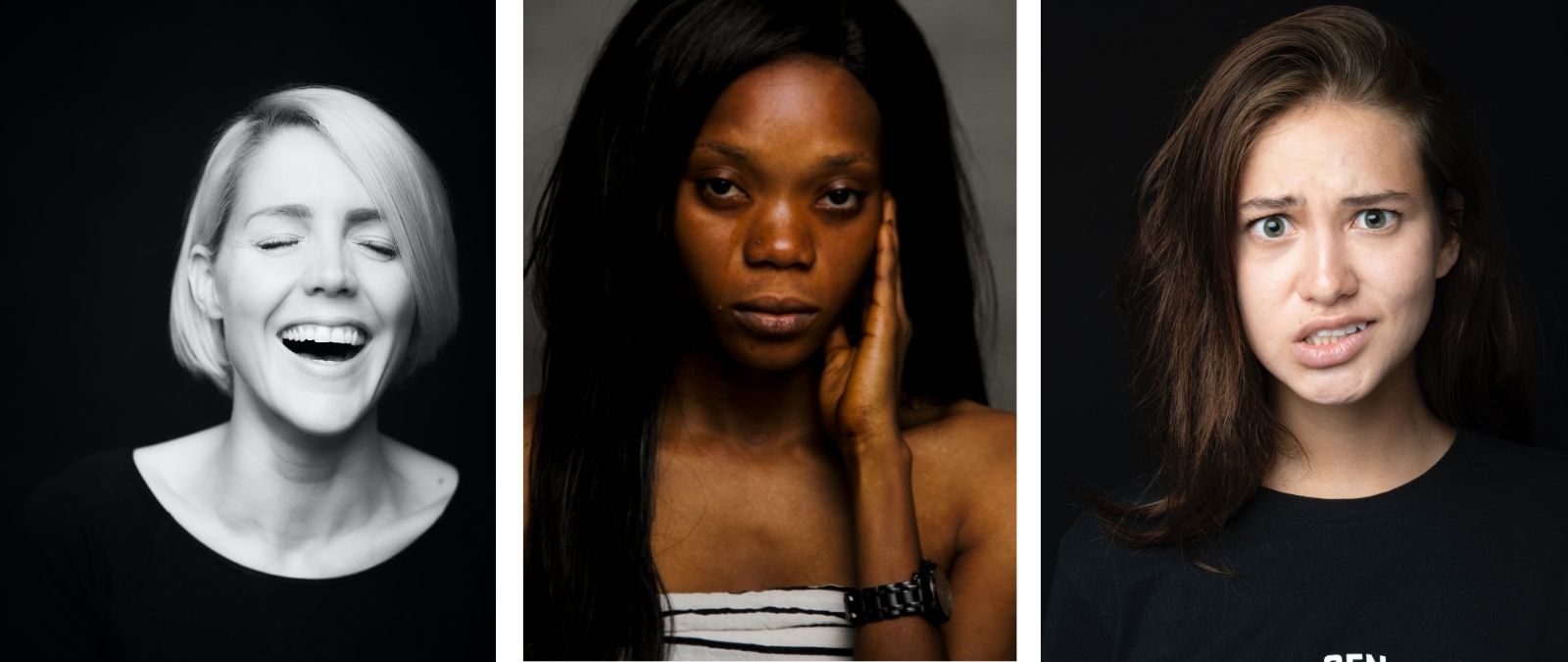

Sánchez explica a Maldita.es que parte del problema de este tipo de sistemas reside en que las bases de datos de imágenes que se usan para entrenar a los programas que tienen que detectar estas emociones pueden no ser representativas: al usarse fotos de actores y actrices con un fondo neutro haciendo muecas que luego se etiquetan como ‘cara triste exagerada’, ‘cara enfadada exagerada, ‘cara sonriente feliz’, no se obtiene una muestra real de lo que puede ser la cara enfadada o contenta de una persona.

“Es fácil hacer un experimento virtual, en el mundo cerrado que es tu ordenador y en el que delimitas una serie de cosas, pero eso no se corresponde con el mundo real porque puedes grabar un montón de alumnos haciendo aspavientos y un montón de cosas o a actores a los que se les han instruido para que hagan todo de una misma forma”, expone, pero “las emociones necesitan contexto tanto de la persona como del ambiente”.

“Actualmente estamos lejos de tener máquinas que puedan reconocer emociones como lo hacemos los humanos, pero poco a poco vamos creando conocimiento y creando sistemas que pueden reconocer algún tipo de estado emocional en alguna circunstancia concreta”, señala Lapedriza.

Prueba a medir tus supuestas emociones con la máquina

Investigadores en antropología e ingeniería de la Universidad de Cambridge diseñaron un pequeño juego para probar las limitaciones de esta tecnología con el que puedes comprobar cómo uno de estos sistemas califica tus emociones según la cara que pongas (basándose en las emociones del estudio de Ekman). Además, incluye un minijuego para ilustrar el problema de la falta de contexto. Por ejemplo, con que no puedan distinguir si una persona está parpadeando o haciendo un guiño: “Los sistemas de IA pueden detectar que un ojo se abre y se cierra, pero no pueden entender la acción en contexto o saber lo que significa”.

Vistas con la lupa de un minijuego, la aplicación de esta tecnología nos puede hacer un poco más de gracia o resultarnos más familiar. El problema viene cuando sistemas que no están del todo afinados o que no han sido probados en determinados entornos se usan para fines que pueden directamente discriminar a grupos de personas o para tomar decisiones de peso, como el ejemplo de las entrevistas de trabajo que hemos visto un poco más arriba o para que lo usen para considerar si un estudiante es más aplicado o menos en función de su postura o sus gestos. Eso o confiar en un programa informático para decidir si la persona que conduce un coche está adormilada o no y si eso puede causar un accidente.

Si vamos un poco más allá, incluso se ha desvelado que este tipo de tecnologías se han testado con los uigures, un grupo étnico musulmán que desde hace siglos vive en China y que en el país han tratado como internos en campos de concentración, tal y como mostró una investigación en 2019 de The New York Times.