“Sabía que estas herramientas existían, pero nunca imaginé que fueran tan accesibles, ni que pudieran usarse con esta impunidad entre menores. Y menos aún, que un día algo así tocaría directamente a mi hija”. Así es como Miriam Al Abid describe a Maldita.es su experiencia: su hija es una de las víctimas del caso de difusión de desnudos creados con IA en Almendralejo (Extremadura, España), que afectó a 22 menores en 2023. Los identificados como responsables tenían entre 12 y 14 años.

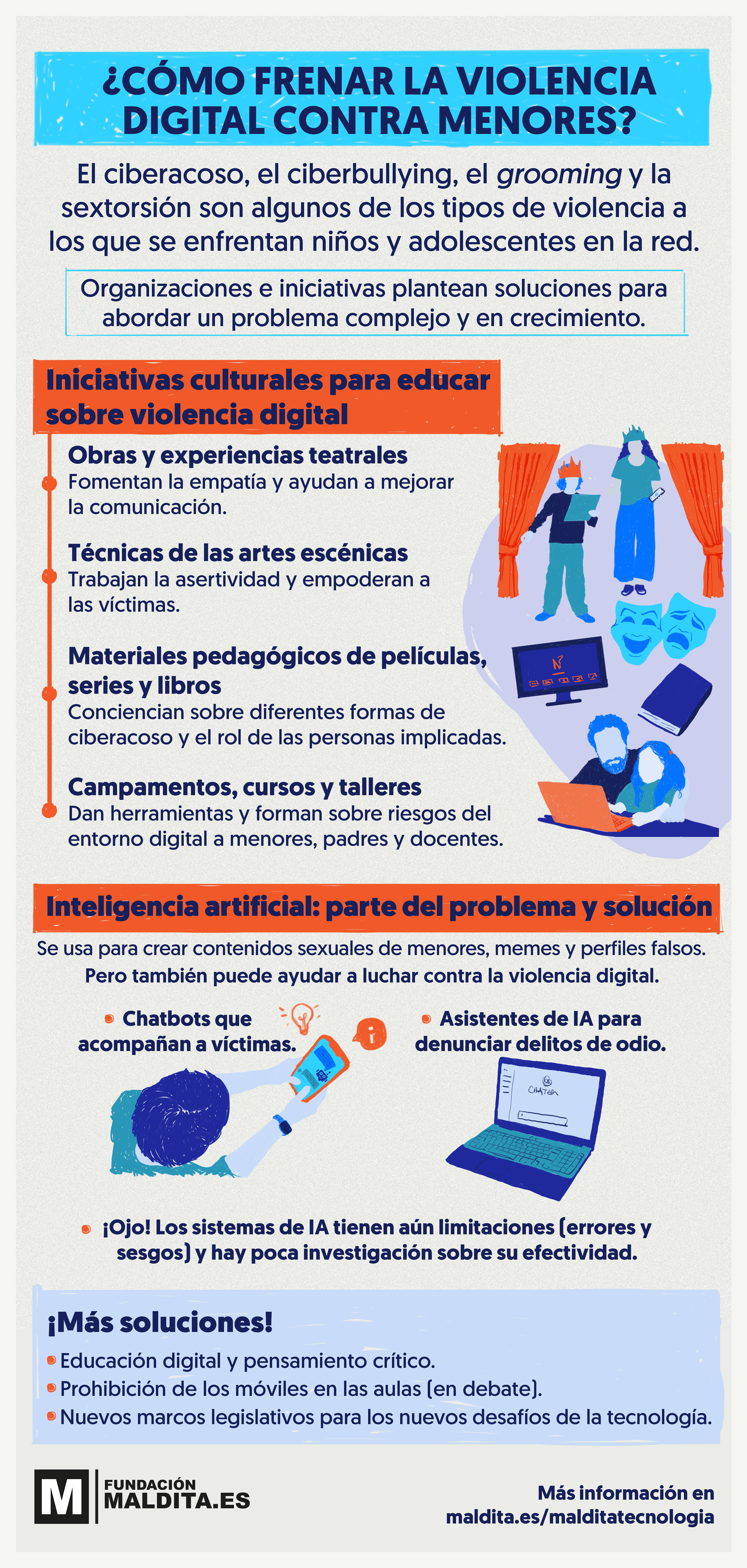

Esos contenidos sexuales creados con IA pueden constituir un delito de pornografía infantil que tiene impacto sobre la salud mental de los menores y que, además, les convierte en víctimas de la desinformación: esas imágenes no reflejan en realidad sus cuerpos ni de sus acciones. Cuando se comparten en redes sociales y aplicaciones, el alcance de estos contenidos queda totalmente fuera de control. La IA está por tanto en el centro actual del problema (también se está usando IA para perpetrar ciberacoso a través de memes y stickers humillantes o perfiles falsos que suplantan la identidad de las víctimas), pero a la vez puede ser parte de la solución. Aunque aún con ciertas limitaciones, se están desarrollando chatbots y asistentes que asesoran a víctimas y ayudan a denunciar delitos de odio en línea.

Cómo mantener a los menores a salvo de la violencia digital y los desafíos de la IA

Este reportaje es el cuarto de una investigación internacional llevada a cabo por Maldita.es (España), Scena9 (Rumanía) y Rubryka (Ucrania). El proyecto explora la problemática de la violencia digital y su impacto en menores, así como las diferentes iniciativas que buscan identificar soluciones, prevenir estas situaciones y proteger a las víctimas. Esta investigación se ha desarrollado gracias al apoyo de Journalismfund Europe y a la mentoría y el apoyo de Transitions.

Los contenidos sexuales con IA de menores son un problema global y en auge

A medida que las herramientas de inteligencia artificial se han vuelto más accesibles y populares también han aumentado las situaciones en las que se utilizan para ejercer violencia digital. Una de las principales preocupaciones es su utilización para crear contenidos que ponen a personas en situaciones sexuales o las desnudan sin su consentimiento. Según un informe de 2019 de la compañía DeepTrace, el 96% de los deepfakes (vídeos manipulados con IA para suplantar la identidad de una persona) que circulan en internet son contenidos pornográficos no consentidos por sus víctimas, que suelen ser mujeres, en su mayoría famosas.

Niños, niñas y adolescentes también son víctimas de esto: la IA se está utilizando para crear imágenes y vídeos sexuales de menores sin su consentimiento, lo que puede constituir un delito de pornografía infantil.

Es un problema global: un estudio del Internet Watch Foundation de 2023 analizó un foro de la dark web (parte oculta de internet que se puede acceder con ciertos programas informáticos) y en solo un mes encontró 11.108 imágenes creadas con IA sospechosas de infringir algún delito relacionado con el abuso sexual infantil. En España, según un informe de 2025 de Save The Children, el 20% de los jóvenes encuestados afirma que alguien compartió con otras personas imágenes creadas con IA para mostrarle desnudo, siendo menor de edad y sin su consentimiento. De nuevo, este fenómeno afecta más a las mujeres: cerca del 21% sufrieron esta práctica, frente al 18% de los chicos.

En Corea del Sur, se han denunciado cientos de casos de deepfakes de menores de edad distribuidos por Telegram. En Maldita.es hemos analizado cómo esta plataforma de mensajería alberga bots que permiten, con unos clics, desnudar imágenes o poner a personas en situaciones sexuales sin su consentimiento. Los bots analizados pedían aceptar unos términos que prohibían procesar fotos de menores, pero no indicaban si controlaban esto de alguna manera.

En muchos casos, también en los que hemos conocido en España, los que crean este tipo de contenidos son los propios menores: un estudio de 2023 de la ONG Thorn reveló que en Estados Unidos uno de cada diez niños afirma que sus amigos han usado IA para generar imágenes manipuladas de carácter sexual de otros niños.

Este problema se ve agravado por el fácil acceso a las herramientas y el desconocimiento que existe sobre esta tecnología

Los expertos consultados por Maldita.es destacan que tanto el fácil acceso a estas herramientas, como la desinformación que existe sobre cómo funcionan y los riesgos asociados a su mal uso, son factores claves para entender la gravedad del problema actual. También destacan que aún no es una práctica tan extendida, pero que sí debemos prestarle atención por los riesgos que supone.

“No considero que la IA como tal haya provocado un boom, sí que creo que hay problemáticas que se agravan con esta tecnología”, Judith Membrives, investigadora en igualdad y derechos humanos y presidenta de Algorights.

“Durante los dos últimos años hemos ido atendiendo algún caso que tiene que ver con inteligencia artificial”, Diana Díaz, directora de las Líneas de Ayuda de ANAR.

“Es un factor de riesgo evidente. Cualquiera que tenga un mínimo conocimiento de IA sabe que es muy fácil simular cosas que no son verdad, y es muy fácil para alguien que quiera ridiculizar, menospreciar o insultar a otra persona, sin ni siquiera entrar en contacto con ella”, Ferran Calvo, presidente de la Asociación Baobab.

“[Los menores] tienen demasiado acceso a herramientas de IA sin estar preparados para ello, además ni siquiera sus padres saben cómo funciona”, Laura Cuesta, profesora de cibercomunicación y nuevos medios en la Universidad Camilo José Cela de Madrid.

“La ignorancia es absoluta, tanto de los efectos que puede tener y que tiene en el profesorado como en los niños”, Gil María Campos, presidente de la asociación Desempantallados.

Estas imágenes y vídeos sexuales creados con IA pueden desinformar sobre la intimidad de las víctimas, y repercutir en su huella digital

El desconocimiento sobre este tipo de contenidos generados con IA se suma al rol que juegan las herramientas de IA en la creación de contenidos desinformadores. En internet y redes sociales circulan vídeos, imágenes y audios creados con IA que buscan desinformar sobre catástrofes naturales (como la DANA en España), elecciones (como las presidenciales de EEUU el 2024) y conflictos bélicos (como los ataques entre Israel e Irán en junio de este año), entre otros temas.

Pero en el caso de los contenidos sexuales creados con IA, estos repercuten en la vida privada de las personas y desinforman al representar a las víctimas en cuerpos que no son los suyos y en situaciones sexuales que no son reales, lo que revictimiza a las personas afectadas, convirtiéndolas también en víctimas de la desinformación. Como explicó a Maldita.es Alicia Hermoso, pedagoga, doctoranda en Educación y maldita que nos ha prestado sus superpoderes, es importante el impacto que puede suponer para la víctima ver un cuerpo que se difunde como el suyo (pero que no lo es) y la disonancia que esto puede generar.

"Se desinforma, se manipula y se destruye la reputación de la víctima de la misma manera que lo hace el revenge porn (porno de venganza) o la sextorsión", Rocío Pina, profesora de Estudios de Psicología y Ciencias de la Educación y del grado de Criminología de la Universitat Oberta de Catalunya.

Estos contenidos también pueden tener consecuencias en la huella digital de las víctimas (el rastro de información sobre nosotros que hay en internet) si se comparten en internet, plataformas y redes sociales. “[Los menores] no se dan cuenta de que lo que se viraliza hoy se ha viralizado para toda la vida”, explica a Maldita.es Gonzalo Santamaría, miembro del Consejo directivo de la European Antibullying Network (EAN).

Chatbots y asistentes para asistir a las víctimas: hay soluciones que utilizan IA para construir un espacio digital más seguro (pero tienen limitaciones)

En la otra cara de la moneda, existen distintas soluciones que usan IA para hacer frente a la violencia digital. “Lo malo de la IA en este sentido es que perjudica porque posibilita el delito, pero también nos ayuda en cierto modo a ir por delante de los ciberdelincuentes al detectar antes los patrones”, defiende Cuesta.

Una de estas soluciones es Sof-IA, el chatbot de IA de Fad Juventud, fundación que trabaja para “mejorar el bienestar y la calidad de vida de la juventud”. Este chatbot “atiende consultas relacionadas con el consumo de sustancias, así como sobre malestar emocional, en las que también se incluyen situaciones de violencia digital”, según explican desde la fundación a Maldita.es.

Sof-IA está diseñado para jóvenes que “no quieren o no se atreven a escribir a un servicio atendido por una persona o prefieren el anonimato del chat” y, aunque no se enfoca en violencia digital, “sí permite trabajar, a través de diferentes herramientas, la gestión emocional, y los síntomas ansiosos y depresivos”, indican desde Fad Juventud.

Este programa funciona con un “sistema basado en árboles de decisión y un motor de recomendaciones apoyado en machine learning [aprendizaje automático, un tipo de IA]”. Después del desarrollo de la arquitectura del programa y su integración en Telegram, “se implementaron las funciones de anonimización y se probó la herramienta con usuarios reales”, explican desde Fad Juventud.

La iniciativa tiene sus limitaciones, entre las que Fad Juventud apunta la falta de interactividad, contenidos “algo breves o simples”, y que el chatbot solo está implementado en Telegram. Sin embargo, defienden que el bot “es efectivo, siempre y cuando se complemente con el Servicio de Información y Orientación para poder ampliar la información y derivar, en caso de necesidad, a un asistente”. Desde su lanzamiento en 2024, Sof-IA ha atendido más de 800 consultas, según la fundación.

Otro programa que quiere aportar soluciones es DEL.IA, un asistente contra delitos de odio desarrollado por estudiantes del Máster en Lenguaje e Inteligencia Artificial de la Universidad Autónoma de Madrid. Su objetivo es asesorar a los usuarios para denunciar delitos de odio en entornos físicos y digitales, donde nos podemos encontrar con haters, trols y discursos de odio. El asistente utiliza reconocimiento de voz para “guiar a la víctima de forma empática tanto en el reconocimiento del suceso como delito de odio como en los siguientes pasos a dar”, según la web del máster. Debido a que la iniciativa es incipiente y fue lanzada en 2025, aún no hay cifras disponibles públicamente del impacto ni la proyección que se tiene del proyecto.

A las limitaciones que puede tener cada proyecto se suman los riesgos extendidos de usar sistemas de IA. Por ejemplo, que no son una fuente fiable de información, ya que puede cometer errores y ‘alucinar’, generando respuestas incorrectas, inexactas o sesgadas. También pueden ‘heredar’ los sesgos de sus desarrolladores o datos de entrenamiento. De hecho, las propias herramientas de generación de imágenes con IA, que pueden llegar a usarse para generar contenidos sexuales, los tienen: las investigadoras Jane Castleman y Aleksandra Korolova de la Universidad de Princeton (EEUU) descubrieron en un estudio de 2025 que los modelos de generación de imagen con IA, como los de OpenAI, Meta y Stability AI, presentan un sesgo de adultificación contra las niñas negras, “representándolas como mayores y con ropa más reveladora que sus contrapartes blancas”.

Otro problema es que existe poca investigación sobre el uso de IA para combatir la violencia digital. Así lo indica un estudio publicado en 2024 realizado por los investigadores Suyesha Singh y Vaishnavi Nambiar, en el que analizaron su uso para detectar contenido sexual de menores: “Existe poca evidencia que demuestre la eficacia de las intervenciones de IA para resolver los problemas de abuso sexual infantil en línea, lo que debería fomentar la realización de más investigaciones en este campo”.

El pensamiento crítico y la educación digital: otras herramientas para la prevención y detección de situaciones de violencia digital contra menores

Además de las posibles soluciones basadas en IA, existen otras iniciativas que buscan fomentar el pensamiento crítico y la educación digital para frenar la violencia digital contra menores, incluido el uso de IA para crear contenidos sexuales o humillantes. “Creo que hay que estimular el pensamiento crítico; aunque lo veas en unas imágenes, esto no quiere decir que sea cierto”, destaca a Maldita.es Sergio Salgado, presidente de Xnet, red de especialistas y activistas sobre derechos digitales.

E-tic es un ejemplo de ello: es un programa educativo impulsado por la Fundación Diario de Navarra que combina sesiones en los colegios con niños de entre 6 y 12 años, con juegos para las familias que se realizan en su plataforma educativa. “Actualmente trabajamos con 3.600 niños y sus correspondientes familias”, señala a Maldita.es Nerea Tollar, coordinadora educativa del programa que se desarrolla en Pamplona en colegios y centros de menores, aunque señala que tienen la intención de ampliar el programa a más edades y lugares de España.

Tollar explica que enseñan a los niños cómo identificar lo que les molesta y cómo pedir ayuda para comunicar a tiempo situaciones de violencia digital. También les enseñan a diferenciar el contenido creado con IA del real. “Mis hijas ya identifican situaciones reales como el ciberacoso, los haters, retos virales peligrosos o publicaciones engañosas. No solo saben ponerles nombre, sino que también reflexionan sobre ellas y saben cómo actuar”, afirma a Maldita.es Idoia Arzoz, madre de dos niñas de 8 y 10 años que participaron en el programa.

Fad Juventud también apuesta por formar a menores, familias y docentes “para que contribuyan a reducir” la violencia digital. Ofrecen materiales formativos y cursos para educar sobre inteligencia artificial a profesores y padres. También sobre la prevención de la violencia y discursos de odio en redes sociales (según Fad Juventud, cuentan con 200 descargas) y sobre cómo promover comportamientos éticos en entornos digitales (más de 400 visitas); seminarios online para familias sobre educación afectivo-sexual o el fomento de la igualdad de género, con más de 100 participantes cada uno. Para los docentes está Construye tu Mundo, programa para prevenir el maltrato y fomentar la convivencia entre adolescentes, al que acceden más de 2.000 docentes de Educación Secundaria en centros españoles cada año escolar.

La prohibición de los móviles en las aulas y la tipificación de los contenidos creados con IA son otras alternativas que se barajan

Hay otras alternativas que se comparten como posibles soluciones para el problema de la violencia digital contra menores y los contenidos creados con IA que se usan para violentarlos. Una de ellas es la prohibición de los móviles en las aulas, una de las vías a través de las cuales los menores pueden acceder a las herramientas de IA, pero los expertos aún difieren sobre la efectividad de este tipo de políticas.

La regulación también es necesaria para prevenir y reaccionar a situaciones de violencia digital: tanto en España como en la Unión Europea existen proyectos de ley que buscan actualizar la regulación a nuevas problemáticas, por ejemplo, tipificando como delito los contenidos sexuales creados con IA.

[Puedes descargar la infografía aquí].

En este artículo ha colaborado con sus superpoderes la maldita Alicia Hermoso, pedagoga, doctoranda en Educación.

Alicia Hermoso forma parte de Superpoderosas, un proyecto de Maldita.es que busca aumentar la presencia de científicas y expertas en el discurso público a través de la colaboración en la lucha contra la desinformación.

Gracias a vuestros superpoderes, conocimientos y experiencia podemos luchar más y mejor contra la mentira. La comunidad de Maldita.es sois imprescindibles para parar la desinformación. Ayúdanos en esta batalla: mándanos los bulos que te lleguen a nuestro servicio de Whatsapp, préstanos tus superpoderes, difunde nuestros desmentidos y hazte Embajador.