En las últimas semanas, muchos medios se han hecho eco de un proyecto político que usa inteligencia artificial (IA) en Dinamarca: seguramente hayas visto titulares que hablan de “una inteligencia artificial que lidera un partido político danés”. Han llamado al sistema en cuestión “Leader Lars” (o “Líder Lars”, en español”), y pese a que en muchos casos se está retratando como un programa capaz de representar a un partido político y de entender las necesidades de la gente, este tipo de proyectos están muy lejos de lo que entendemos que haría un líder de un partido político a día de hoy. Veámoslo en detalle.

Un chatbot para atender y responder las inquietudes y peticiones políticas de la gente

Líder Lars es un chatbot basado en inteligencia artificial desarrollado por una asociación sin ánimo de lucro llamada MindFuture y un colectivo técnico-artístico llamado Computer Lars, y se asocia a lo que han bautizado como el Partido Sintético. ¿De qué hablan, en este caso, cuando mencionan ‘una inteligencia artificial’ al frente de un partido? Un chatbot es un sistema programado para interactuar con las personas por medio de textos o audios, como puede ser Alexa u otro asistente de voz que usamos en casa, si hablamos de audio, o un programa asistencial si hablamos de texto. Por ejemplo, como cuando hablamos con el chat de algunas operadoras para resolver un problema técnico. En el caso de Líder Lars, dos grupos han diseñado este programa y lo han entrenado para que, cuando se le hable, pueda responder con temas referentes a la política danesa.

Siempre recordamos que para entrenar un programa de inteligencia artificial que arroja respuestas por sí mismo, es necesario presentarle muchos, muchos datos sobre el tema que queremos que hable o escriba. En el caso de Líder Lars, se ha alimentado con los programas electorales de los partidos que no han llegado a tener representación parlamentaria desde 1970. ¿Con qué intención? Sus creadores dicen que aspiran a que las personas que no acuden normalmente a votar puedan comunicarse con el sistema y luego recoger sus peticiones para incluirlas en su propio programa de cara a 2023.

Ahora bien, ¿significa esto que con Líder Lars se pueda hablar como con una persona o con un representante político? O más bien, ¿tiene capacidad para legislar o dirigir un partido? No, y es importante que entendamos por qué un programa de inteligencia artificial no es capaz a día de hoy de “liderar” un partido político.

“No sé si lo veremos en más países, pero no tiene ninguna incidencia sobre cómo funciona el proceso democrático”, afirmaba en una entrevista en RTVE la especialista en auditoría de algoritmos y CEO de Eticas Tech, Gemma Galdón. “Lo que hace es visibilizar un uso intensivo de los datos que en muchos casos los partidos ya están realizando. La interacción con el ciudadano ya no la tiene un político, sino que la tiene un chatbot”, decía.

“Lo que plantean es que es muy difícil llegar a un político, pero un chatbot se puede reproducir de muchas maneras y muchas veces, con lo cual tú puedes tener una interacción con un chatbot, pero siempre programado por políticos. No es que las personas, o los políticos, se pongan al servicio de una inteligencia artificial”, resaltaba.

Un programa de IA no puede 'entender' lo que dice o lo que le comunicamos, sólo arroja datos

Aquí es importante que hablemos de que un sistema de inteligencia artificial no es capaz de ‘entender’ lo que nos está diciendo o escribiendo. Por tanto, no es posible que Líder Lars comprenda lo que implica que una persona reciba un salario u otro, que tengan acceso a un servicio de salud pública o no o que pueda debatir para instaurar medidas como se hace en un proceso político y democrático a día de hoy.

“Ningún sistema de IA (como GPT-3 o un chatbot) tiene conciencia real de lo que está diciendo en el sentido que tenemos conciencia nosotros, de entender lo que significa lo que estamos diciendo y mirar sus implicaciones en el futuro o situarlas en un contexto histórico”, afirma a Maldita.es Ariel Guersenzvaig, filósofo de la tecnología especializado en ética de la IA y profesor en Elisava Facultad de Diseño e Ingeniería en la Universidad de Vic.

Sin embargo, así es como se está retratando en entrevistas en algunos medios. “En los temas políticos y sociales no hay lo que podemos llamar una verdad de base: si coges la composición química de una piedra o defines lo que es un melanoma para programar un sistema de inteligencia artificial, estaremos de acuerdo en que el sistema podrá detectarlo porque tenemos una idea más clara de lo que es. En cambio, en temas socio-políticos no tienes estos conceptos de verdad como punto de partida”, señala.

“En una sociedad moderna y plural hay diferencias importantes en lo que es la seguridad, el bienestar, la buena educación, la integración… son objetos de constante debate. No hay una verdad que puedas obtener mediante un sistema matemático”, recalca el especialista.

La directora de MindFuture, Caroline Axelsson, decía en una entrevista con El Periódico de España que “hay gente que cree que una máquina gestionaría mejor un país porque no se corrompe, pero porque tampoco tiene empatía”. Esa idealización de que una máquina “objetiva” tuviese representación parlamentaria es más común de lo que pensamos. De hecho, hay informes que reflejan que más de la mitad de los españoles estarían de acuerdo en sustituir el número de parlamentarios y que se les diese poder de decisión a los algoritmos (te contamos por qué eso no es tan fácil como parece).

Tampoco puede ser 'objetivo': usa la información con la que se le entrena, incluido cualquier matiz ideológico

Pero esta percepción, en realidad, tiene trampa, ya que no es posible inculcar lo que es ser “objetivo” a una máquina. “La idea de objetividad como una cosa pura, aislada de todo tipo de valores y emociones está descartada en la epistemología moderna. Objetiva es la composición de una piedra, pero no hablamos de ello en otro tipo de debates”, dice Guersenzvaig. Y recalca: “Un sistema informático no es más objetivo”.

Esto es algo que vemos incluso contradictorio en las conversaciones escritas que han tenido algunos periodistas con el sistema. Mientras que los creadores aseguran que el partido es “sintético” y por tanto trata de homogeneizar las disparidades, el programa por sí mismo se define como “progresista” o dice claramente que es de un partido “de izquierdas”. ¿Por qué? Seguramente porque esa sea la ideología de los partidos cuyos programas electorales han sido utilizados.

También se utiliza el pretexto de que un programa de inteligencia artificial no puede ser “corrupto”. Sin embargo, una vez más depende de cómo se le entrene. “El término IA confunde a la mayoría de las personas en cuanto a las capacidades reales de los sistemas. Una planta en un sentido puede ser inteligente porque sabe cuándo abrirse, cómo florecer o buscar la luz, pero cuando hablamos de IA hablamos de un tipo de inteligencia humana y que incluso tiene unos atributos más racionales o menos emocionales, por todo el halo matemático estadístico”, añade Guersenzvaig.

De ahí que este especialista considere que no es posible a día de hoy que uno de estos sistemas tome decisiones automatizadas sobre cuestiones políticas: “Porque son frágiles técnicamente, están tremendamente sesgados, tienen problemas estructurales que no son fáciles de resolver meramente con ciencia de datos”.

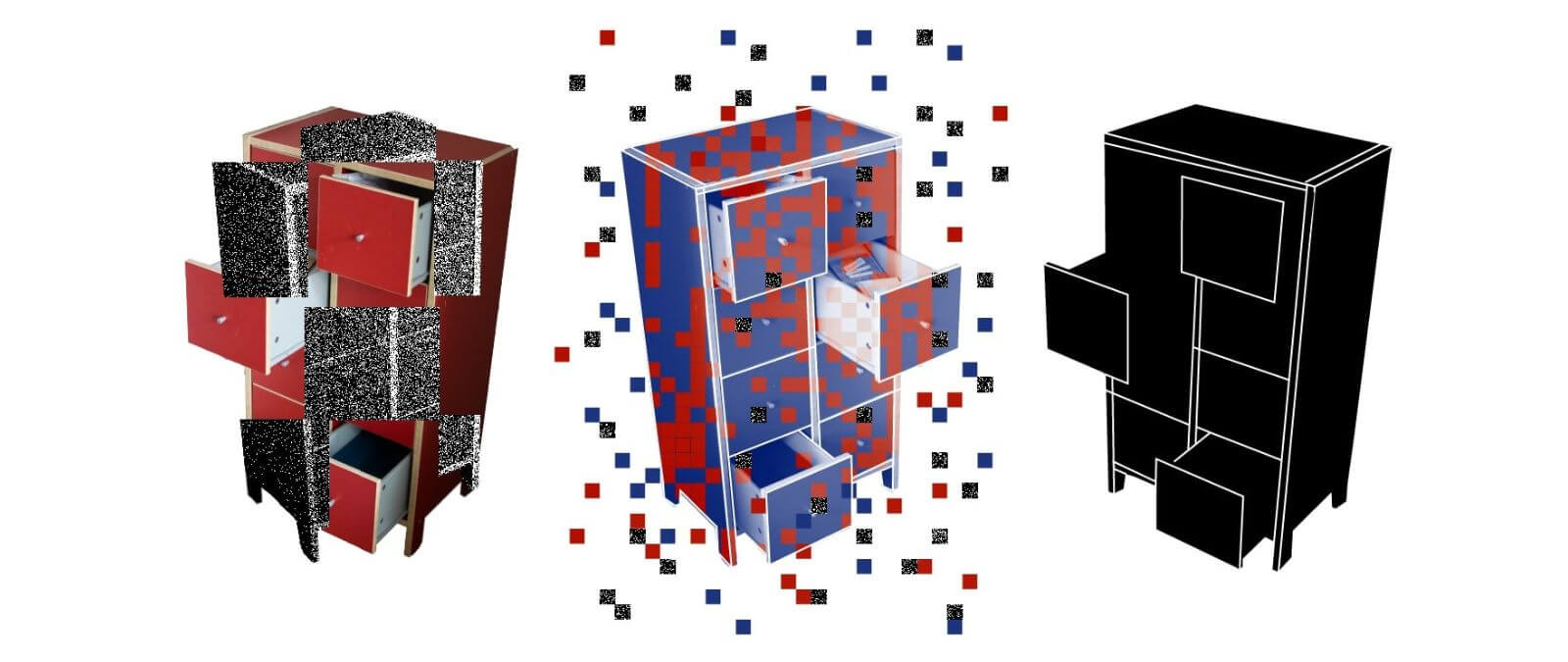

Imagen: Anton Grabolle / Better Images of AI / Classification Cupboard / CC-BY 4.0

Primera fecha de publicación de este artículo: 21/11/2022