En las últimas semanas hemos visto como el concepto de "policía predictiva" ha ido apareciendo en contenidos desinformadores para distorsionar el alcance de este tipo de tecnologías. Para aclarar a qué nos referimos cuándo hablamos de un programa informático de policía predictiva, hemos hablado con especialistas de este tema en la Maldita Twitchería. Alguna de las conclusiones que nos dejan: sí, a nivel global se usa tecnología para prevenir delitos y analizar patrones como dónde es más probable que ocurran, pero también es cierto que todavía no hay tantas cien por cien funcionales. También comentamos la discriminación que causan en ciertos sectores de la población.

¿De qué hablamos cuando hablamos de policía predictiva?

Para sentar las bases de la Twitchería contamos con Fernando Miró Llinares, director del centro de investigación CRÍMINA de la Universidad Miguel Hernández. Nos explicó que aunque tiene sentido utilizar un término como "policía predictiva", este puede ser “engañoso y aparatoso teniendo en cuenta lo que en realidad hace”. En general, los sistemas de inteligencia artificial que ya utilizan los equipos de policías del mundo son “sistemas de información automatizada” que analizan una gran cantidad de datos en busca de patrones o conductas de riesgo. Y esto afecta al análisis barrios y personas concretas y herramientas de análisis en tiempo real como el reconocimiento facial. Técnicas todavía muy jóvenes y que en muchas ocasiones “tienen una eficacia enormemente discutible”.

Se aplican sobre un segmento de la población ya de por sí discriminado

Es una de las ideas que nos transmitió Carlos Castillo, investigador de IA en el grupo de computación social de la Universidad Pompeu Fabra. Las tecnologías de policía predictiva al final se aplican para analizar a personas que están sometidas a varias "capas de discriminación" al encontrarse en un ámbito penitenciario, por ejemplo: "Los datos con los que se entrenan estos algoritmos provienen de una sociedad que ya tiene discriminación estructural y seguramente los datos que se utilizan en policía predictiva y justicia son de los datos más contaminados", asegura.

"El hecho de que un algoritmo sea más objetivo que una persona porque no sea capaz de establecer una discriminación interpersonal es un error, porque un sistema informático puede estar exento de este tipo de discriminación pero no de la discriminación estructural o institucional", asegura Castillo.

Desde Estados Unidos a Europa: se aplican de forma global

Las limitaciones tecnológicas para este tipo de programas informáticos son bastante grandes y eso hace que se usen para casos muy concretos. Es lo que nos explicaba Gemma Galdón, directora de Eticas Consulting y Eticas Foundation, que asegura que la "buena noticia" es que tampoco hay muchísimos: "La inteligencia artificial predictiva utilizada en entornos policiales no es la norma". La cuestión es que donde más expuesto está tanto el desarrollo de estas tecnologías como las consecuencias de su uso es en Estados Unidos, y es de allí de donde se puede obtener más información sobre su impacto. Aquí Galdón nos relata algunos ejemplos:

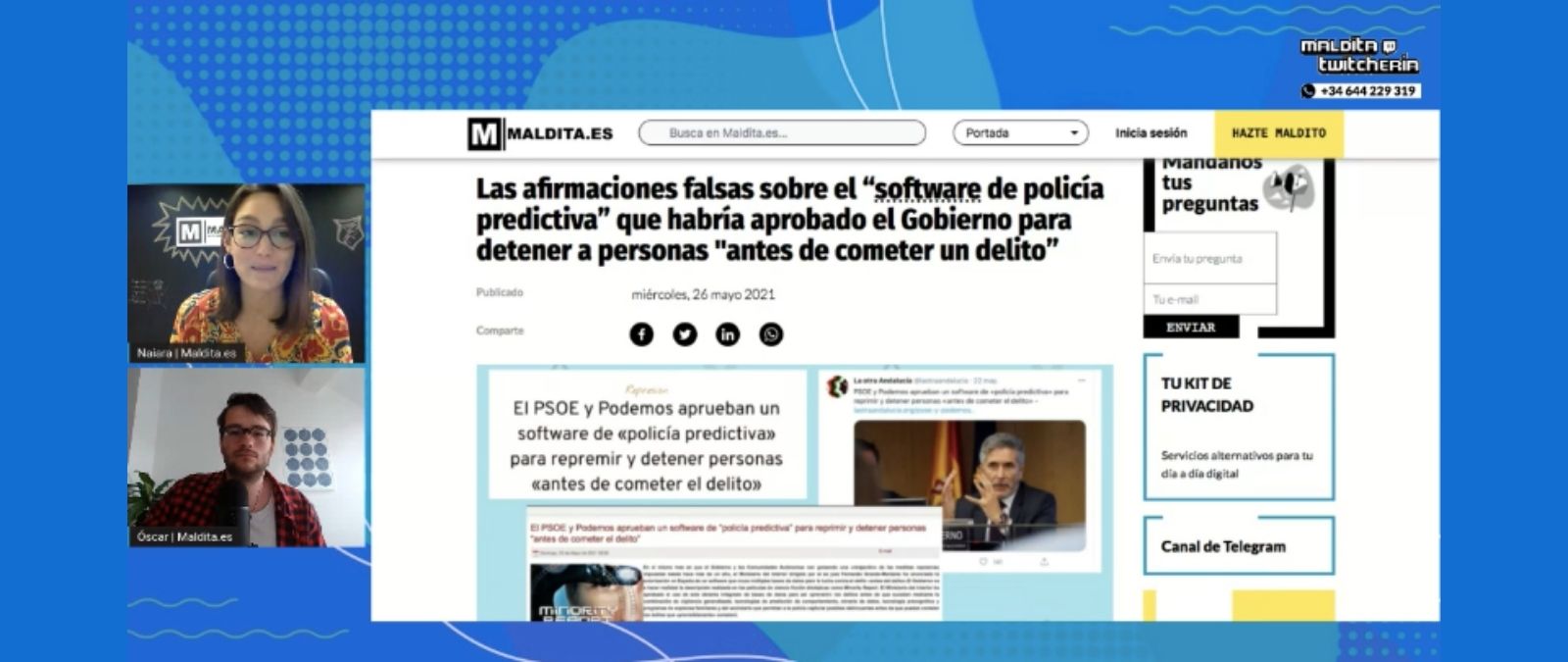

Las confusiones con la nueva ley de protección de datos para investigaciones policiales

Terminamos el programa de esta semana haciendo un repaso de la Ley Orgánica 7/2021, la recién aprobada legislación sobre el tratamiento de nuestros datos personales en investigaciones policiales e infracciones penales. Dado que en los últimos días se creó mucha confusión con lo que permitía la ley y lo que no, estuvo resolviendo dudas en la Maldita Twitchería Darío Rincón, abogado especializado en protección de datos de Secuoya Group. Nos contó que es "una ley muy necesaria" porque todos los datos aplicados en investigación policial o judicial no tenían cabida en el Reglamento General de Protección de Datos europeo, así que fue necesario aprobar en Europa una directiva paralela que recogiera estos supuestos.

Primera fecha de publicación de este artículo: 04/06/2021