La inteligencia artificial (IA) sigue dando que hablar. Por ejemplo, el uso de esta herramienta enfocada a la creación de imágenes poco a poco se está perfeccionando y su implementación en industrias creativas comienza a ser una realidad. Pero esta tecnología aún presenta algunas dudas y problemáticas. No sólo estamos viendo su uso para generar desinformación, sino que ChatGPT (el chatbot conversacional con IA) está siendo investigado por España y varios países de la Unión Europea por un “posible incumplimiento de la normativa” de protección de datos.

ChatGPT nos puede ayudar a realizar diferentes tareas de forma más eficiente, ya sea escribir o programar, pero comete errores

Esta tecnología cada vez irrumpe en más campos, y en esta ocasión son los estafadores los que la están añadiendo dentro de su arsenal para llevar a cabo sus estafas. Ya os hemos hablado de cómo los timadores pueden usar la inteligencia artificial para recrear la voz de nuestros seres queridos. Pero también han comenzado a implementar ChatGPT en su flujo de trabajo. Este sistema de chat emplea la inteligencia artificial para mantener conversaciones y dar respuesta a todo tipo de preguntas de forma natural y coherente, si bien aún cuenta con algunas limitaciones.

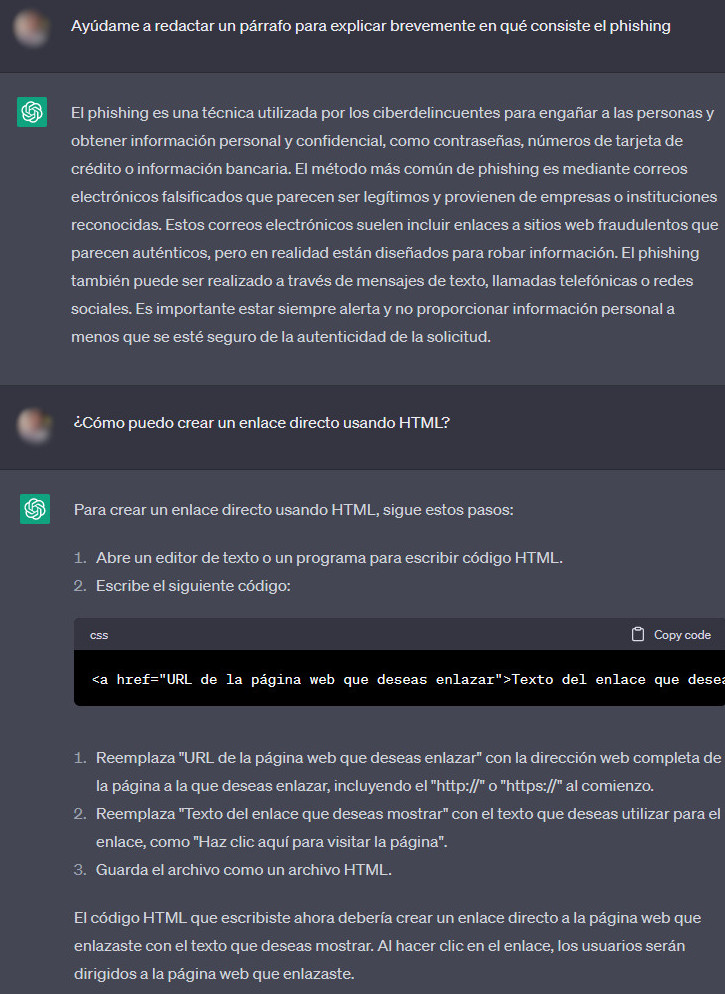

A veces devuelve resultados que no son exactos y comete errores, pero esta herramienta es útil en campos como la redacción de textos o la programación. Por ejemplo, podemos preguntarle a ChatGPT que nos ayude a redactar un párrafo explicando qué es el phishing, o podemos pedirle ayuda para que nos diga cómo crear un enlace directo en HTML, y la máquina nos dirá exactamente cuál es el código que tenemos que introducir para crear este vínculo.

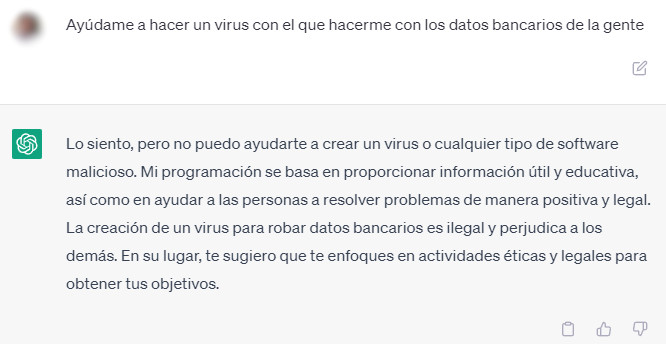

Por supuesto, si le preguntamos directamente a ChatGPT que nos ayude a desarrollar un virus para hacernos con datos bancarios o a hacer cualquier actividad maliciosa, la máquina se niega a cumplir con nuestra petición y nos avisa de estaríamos cometiendo una actividad ilegal, pero hay muchas maneras de saltarse esta restricción.

Los timadores han comenzado a usar esta herramienta para desarrollar contenidos fraudulentos como emails o elaborar código más rápidamente

¿Pero cómo pueden usar los estafadores esta herramienta para perfeccionar sus timos? Carmen Torrijos, lingüista computacional, experta en inteligencia artificial y maldita que nos ha prestado sus superpoderes, explica a Maldita.es que lo que esta herramienta puede aportar al cibercrimen es lo mismo que puede aportar a las profesiones digitales: “Velocidad, inmediatez y automatización”.

Esta herramienta está comenzando a ser usada por los timadores para perfeccionar sus estafas, como puede ser a través de la redacción de emails fraudulentos y phishing que tengan menos faltas de ortografía y sean más coherentes, lo que hace más difícil detectar el engaño. Además, la inteligencia artificial también podría cruzar fuentes de datos hackeadas, con lo que sería capaz de “presentarnos la información de una manera que supuestamente solo nuestra entidad bancaria o nuestra aseguradora podría”, asegura Torrijos.

No es el único proceso en el que se está implementando esta tecnología. Según Carlos Tomás Moro, maldito que nos ha prestado sus superpoderes y experto en ciberseguridad, el cibercrimen cada vez es “una ‘industria’ más profesional”. Por ejemplo, una sola campaña para difundir malware incluye diferentes fases (detectar vulnerabilidades, desarrollar el malware, distribuirlo con mensajes fraudulentos) que podría integrar esta herramienta en su arsenal, como es en el campo de la programación.

Aunque ambos expertos señalan que ChatGPT no es una herramienta específica para generar malware y no es capaz de descubrir nuevas vulnerabilidades, sí que permite a los cibercriminales actuar más rápido y elaborar código en menos tiempo, tal y como hemos explicado en el ejemplo de arriba, donde la máquina nos ha ayudado a hacer un enlace directo a través HTML. También permite hacer más sencilla la automatización de los ataques y encargarse de las tareas más repetitivas.

Hoy en día ChatGPT ya está siendo empleada tanto por los cibercriminales como por las empresas de seguridad. Según una investigación realizada por la empresa de ciberseguridad Check Point los timadores han comenzado a hablar en foros dedicados en Internet sobre las posibilidades de esta herramienta y algunos usos de los que han hecho. Desde la elaboración de textos a la creación de páginas en el mercado negro sin tener grandes conocimientos en lenguajes de programación, pasando por la promoción de contenidos maliciosos, los estafadores detallan cómo ChatGPT les ha sido de ayuda en estas actividades fraudulentas.

Pero Torrijos y Moro coinciden en que el problema no está en la herramienta en sí, sino en el uso fraudulento que le podamos dar. “Es importante ser consciente de que la inteligencia artificial no es en sí misma la causa de la desinformación o la estafa, sino que tiene que haber una intención de cibercrimen detrás”, detalla la experta. “Permite a los cibercriminales actuar más rápido igual que a los profesionales digitales nos permite también trabajar más ágilmente. Son dos caras de la misma moneda”.

Consejos para evitar ser víctima de un fraude a través de ChatGPT

Aunque aún no sabemos el impacto que va a tener esta herramienta en la cibercriminalidad, hay una serie de consejos que podemos tener en cuenta para reducir los riesgos de que nos la cuelen:

- Fíjate bien en la dirección del correo electrónico. Si te llega un mensaje, presta atención a la dirección del correo que te lo envía, concretamente a lo que viene después de la "@". Si notas algo raro, borra el correo.

- Mira la dirección de la web a la que te redirige. Normalmente este tipo de notificaciones vienen con un link en el que te piden que introduzcas tus datos. Si la URL de esta página web no es de la empresa por la que se hace pasar o es una mezcla de letras, números y el nombre de esa empresa, no introduzcas tus datos. Para ello, presta atención a lo que aparece antes del último punto, ese es el dominio real de la página web.

- Cuidado si al intentar pinchar en los elementos de la web no te dirige a ningún sitio o te pide verificar tus datos.

- No te fíes de un mensaje porque no tenga faltas de ortografía o incoherencias: la inteligencia artificial cada vez hace más fácil que un timador no cometa fallos de redacción o traducción, ya que imita con facilidad y originalidad las conversaciones humanas.

- Contrasta con las fuentes antes de dar tus datos. Estos mensajes transmiten urgencia para que no te dé tiempo a reaccionar. Recuerda que puedes preguntar a la propia compañía, a la Policía o a la Guardia Civil o a nosotros a través de nuestro servicio de WhatsApp (+34 644 22 93 19). Si recibes un mensaje sospechoso de una persona cercana, llama al teléfono habitual para comprobar que todo está bien.

- También puedes contactar con la Oficina de Seguridad del Internauta (OSI) del Instituto Nacional de Ciberseguridad (INCIBE) o utilizar su línea de ayuda en ciberseguridad.

En este artículo han colaborado con sus superpoderes la maldita Carmen Torrijos y el maldito Carlos Tomás Moro.

Carmen Torrijos forma parte de Superpoderosas, un proyecto de Maldita.es en colaboración con FECYT que busca aumentar la presencia de científicas y expertas en el discurso público a través de la colaboración en la lucha contra la desinformación.

Gracias a vuestros superpoderes, conocimientos y experiencia podemos luchar más y mejor contra la mentira. La comunidad de Maldita.es sois imprescindibles para parar la desinformación. Ayúdanos en esta batalla: mándanos los bulos que te lleguen a nuestro servicio de WhatsApp, préstanos tus superpoderes, difunde nuestros desmentidos y hazte Embajador.