Desde mostrar un arma en la mano de Alex Pretti, asesinado por la Patrulla Fronteriza, que nunca estuvo ahí, hasta intentar destapar los supuestos rostros (no son reales) de las mujeres que posan junto a Trump en una imagen del patrimonio de Epstein: los contenidos editados o “mejorados” con inteligencia artificial pueden desinformar o usarse para manipular a las personas, distorsionando o añadiendo elementos que no existen a una imagen o vídeo real. Una práctica cada vez más común que en varias ocasiones surge como una forma de obtener más información sobre un suceso en desarrollo, pero de la que no debemos fiarnos. Recuerda siempre contrastar con imágenes compartidas por fuentes fiables de información para que no te la cuelen.

Desde las manifestaciones contra ICE hasta el caso Epstein: cómo se han viralizado imágenes editadas con IA que desinforman sobre personas y hechos de actualidad

Las herramientas para editar o “mejorar” contenidos con IA son cada vez más accesibles y su uso durante sucesos de actualidad crece en popularidad. “Cada vez más, vemos que los usuarios recurren a herramientas de inteligencia artificial después de noticias de último momento, cuando los medios visuales auténticos pueden ser borrosos, incompletos y totalmente insatisfactorios para los usuarios que intentan descubrir los hechos antes de que se informen oficialmente”, destaca un análisis de NewsGuard.

Es lo que sucedió después del asesinato de Alex Pretti por parte de agentes de la Patrulla Fronteriza durante las protestas contra ICE en Minnesota, Estados Unidos. Se viralizó una imagen donde el enfermero aparecía con un arma en su mano, pero no era real, sino que la foto auténtica con peor calidad, donde tenía un móvil en la mano, había sido “mejorada” con IA. También sucedió con un vídeo viral que supuestamente mostraba cómo el arma de Pretti se disparaba después de que un agente se la quitara: el usuario que lo publicó dijo que “mejoró con IA” el vídeo original, pero en los registros compartidos en redes sociales de la escena desde distintos ángulos no se aprecia que se dispare el arma (algo que, según el New York Post, investigó el Departamento de Seguridad Nacional).

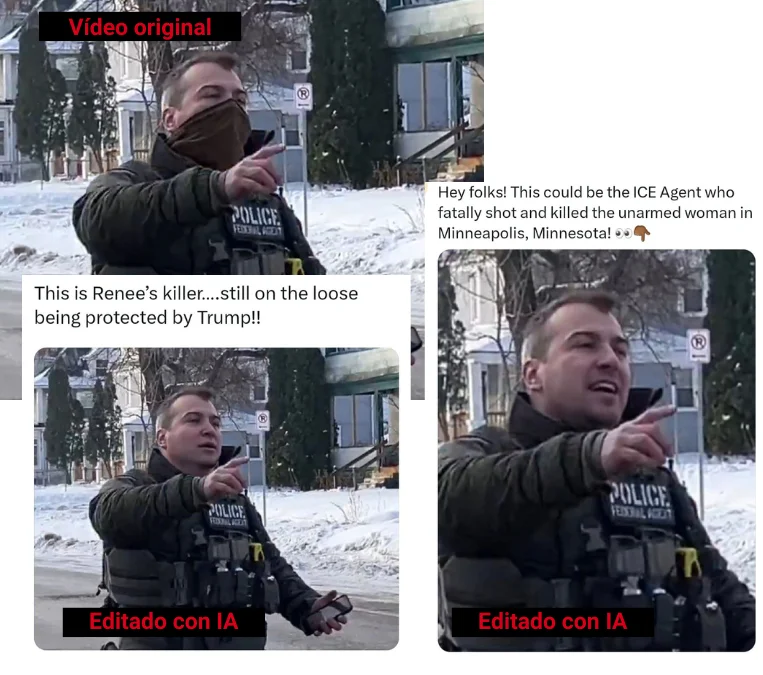

Esta técnica de editar contenidos con IA también se había utilizado semanas antes, cuando el ICE asesinó a Renee Nicole Good. Como explica BBC Verify, se viralizaron imágenes donde se usaba inteligencia artificial para intentar “desenmascarar” a un agente involucrado en el tiroteo, que aparecía en los vídeos de la escena con el rostro cubierto. “Los intentos de usar IA para generar la cara del agente de ICE sin máscara han dado resultados muy diferentes en cada ocasión”, indica el análisis de la cadena pública británica.

Esto sucede porque “la plataforma no tiene forma de saber el aspecto real de esa persona”, explicó a CTV News Channel Giancarlo Fiorella, director de investigación de Bellingcat. “Completa los datos faltantes con el aspecto que cree que podría tener su rostro basándose en otras imágenes de personas con las que se han entrenado estas plataformas”, añadió.

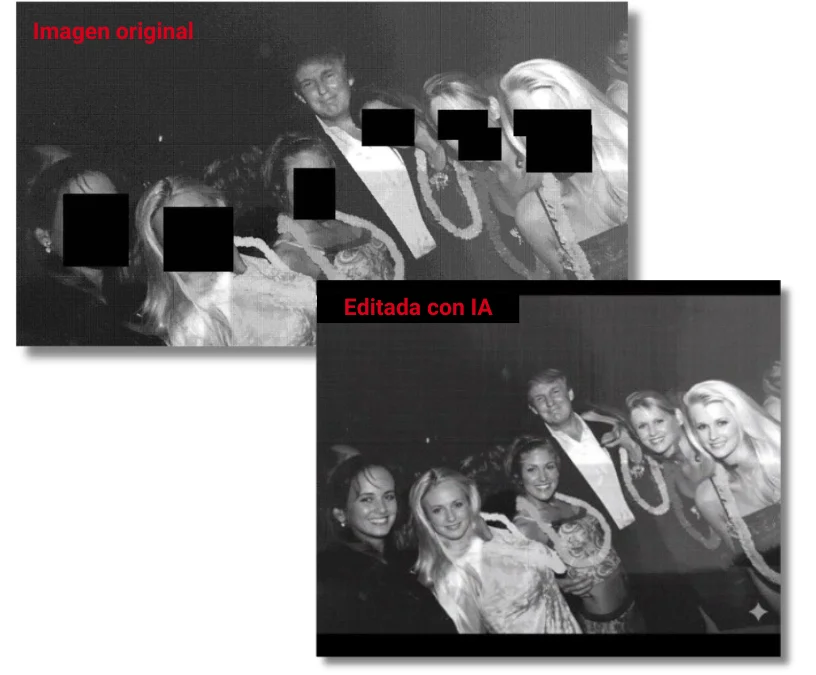

Algo similar ya había ocurrido meses antes con una imagen en la que aparece Donald Trump junto a un grupo de mujeres con sus caras cubiertas, incluida en las imágenes filtradas por los demócratas del patrimonio de Jeffrey Epstein. Como señala BBC Verify, en diciembre de 2025, comenzaron a circular imágenes editadas con IA para supuestamente “revelar” los rostros de las mujeres, pero no coincidían entre sí, ya que, nuevamente, son predicciones que hacen los sistemas basándose en las imágenes con las que fueron entrenados.

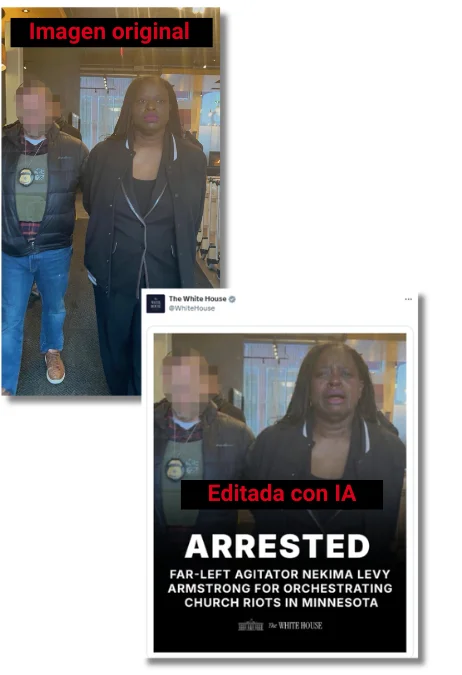

No siempre son usuarios anónimos los que publican este tipo de contenidos. La Casa Blanca compartió una imagen editada con IA, según The New York Times, de una mujer que fue arrestada durante las protestas en Minnesota: en la original aparece con una expresión seria, pero fue modificada para mostrarla llorando.

“A diferencia de una ‘mejora’ que hace que una imagen sea más clara, una mejora que crea una imagen falsa es una manipulación, no una mejora”, concluye NewsGuard.

Las herramientas para “mejorar” o editar contenidos con IA pueden cometer errores, distorsionando o añadiendo elementos que no estaban en los originales

Los contenidos “mejorados” o editados con IA son aquellos que han sido modificados con herramientas que usan inteligencia artificial que prometen aumentar la resolución, modificar elementos, añadir color o reducir el ruido de la imagen, entre otras cosas. A diferencia del contenido generado con IA, estos no se crean desde cero, sino que modifican una imagen o vídeo que ya existe.

¿Cómo lo hacen? Siguiendo la lógica predictiva de los modelos de inteligencia artificial: “Las herramientas que ‘mejoran’ con IA no poseen un conocimiento privilegiado de la realidad subyacente a una imagen de baja calidad. En cambio, se aproximan a cómo podría verse una versión mejorada de una imagen”, señaló Henry Ajder, experto en IA generativa, a BBC Verify.

Esto se debe a que los modelos de IA predicen el resultado más probable según su entrenamiento y el prompt [instrucción de texto] del usuario, pero no ‘saben’ ni ‘entienden’ lo que producen. En este proceso, una IA puede ‘alucinar’ y dar respuestas incorrectas, inexactas o sesgadas. Errores que en el caso de las imágenes y vídeos editados con IA pueden ser elementos visuales que no estaban en las versiones originales. “El riesgo es que la gente confunda la “mejora con IA”, que en realidad es una predicción, con nuevos conocimientos”, advirtió Ajder.