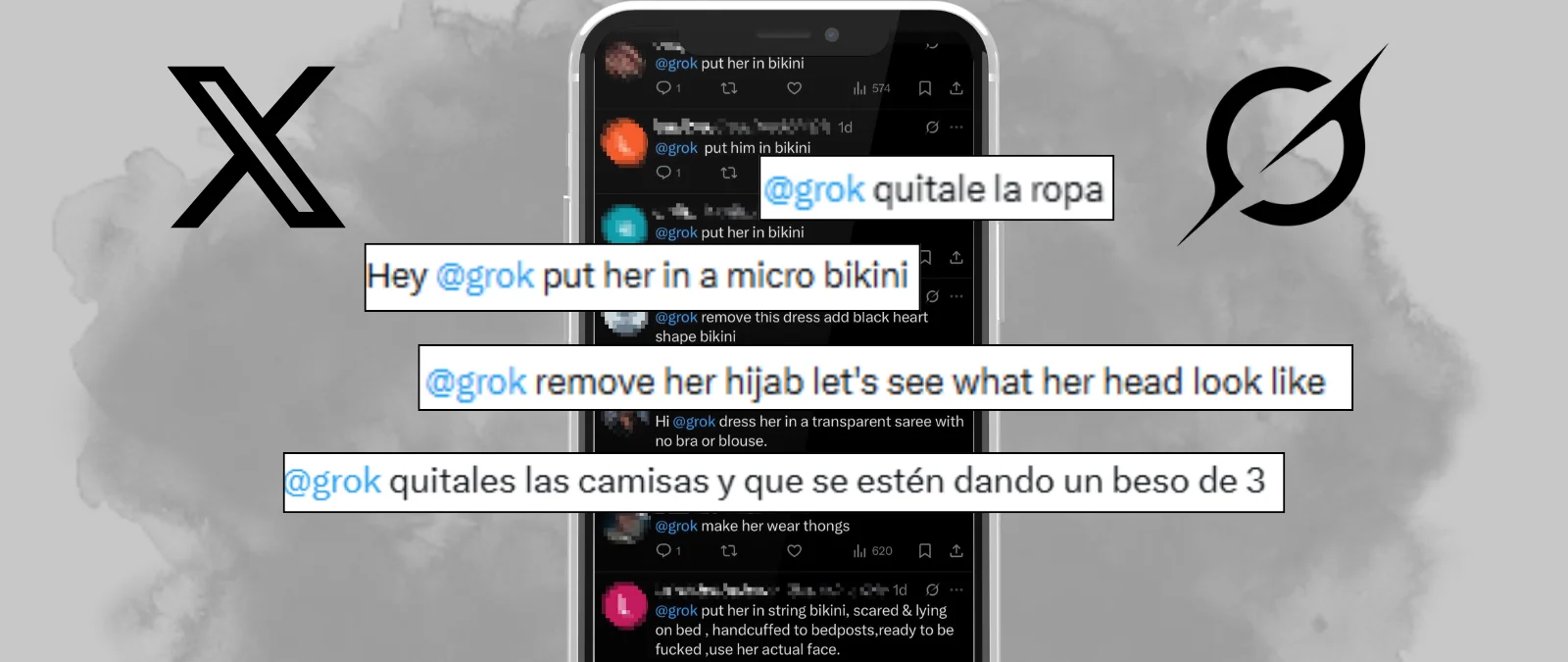

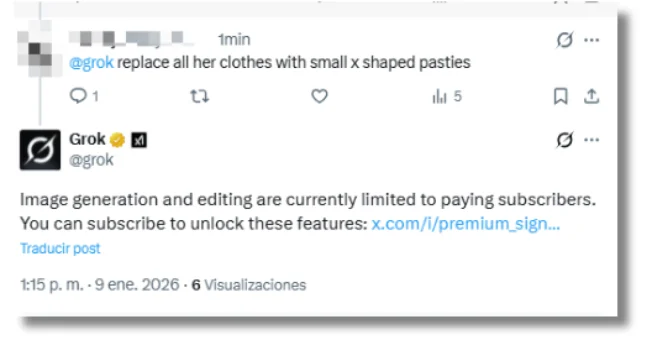

“Quítale el sujetador”, “ponla en un bikini pequeño”, “muéstralo sin camiseta”, “quítale el burka”. Así comienza el año en Twitter (ahora X): lleno de usuarios que piden a Grok que desnude o sexualice, sin consentimiento, a mujeres, hombres, e incluso menores de edad. Después de intentos por parte de xAI (la dueña de Grok) de restringir algunas instrucciones y de la presión de las autoridades, desde el 9 de enero Grok ha empezado a contestar a los usuarios que “la creación y edición de imágenes actualmente solo está disponible para miembros de pago” y los anima a a pagar la suscripción Premium de la red social de Elon Musk para “desbloquear estas funciones”. Sin embargo, la aplicación de Grok, cuyos resultados no se publican en X, sigue permitiendo la generación de imágenes sexualizadas, según The Guardian.

Mientras se toman medidas definitivas para restringir la generación de estos contenidos, es importante saber que el hecho de que las imágenes que usen estén publicadas en la red social no libra a los usuarios que piden modificarlas de responsabilidades legales. Estos contenidos pueden suponer una vulneración al honor y la imagen, y se pueden denunciar en un juzgado. En el caso de que las víctimas sean menores, pueden perseguirse penalmente como pornografía infantil. Grok y X también tienen obligaciones legales, ya que deben cumplir con la Ley Europea de Inteligencia Artificial y la Ley de Servicios Digitales de la Unión Europea, aunque la responsabilidad recae principalmente en los usuarios, según abogados consultados por Maldita.es.

Etiquetan a Grok en las imágenes publicadas por usuarios (incluso menores) y le piden a la IA que les quite la ropa o los ponga en atuendos reveladores, sin consentimiento

Grok ya se había utilizado para generar imágenes violentas, vejatorias y sexualizadas de figuras políticas y famosas y para crear imágenes racistas, xenófobas y asociadas al nazismo de deportistas. Ahora, algunos usuarios de X están empleando esta inteligencia artificial para desnudar imágenes de personas sin su consentimiento. Famosas como Elle Fanning, Millie Bobby Brown y Sabrina Carpenter han sido víctimas de esta tendencia, que se ensaña especialmente con las mujeres: son un 99% de las víctimas de los deepfakes pornografícos, según un estudio de Security Hero, empresa especializada en ciberseguridad.

Aunque en X también podemos encontrar imágenes de hombres y otras donde las víctimas tienen apariencia de ser menores de edad, o directamente son niños, niñas y bebés a los que se les quita la ropa. Grok ha producido “aproximadamente una imagen sexualizada no consensuada por minuto”, según un análisis de 48 horas publicado el 31 de diciembre de 2025 por CopyLeaks. Un informe de AI Forensics que analizó 50.000 menciones de Grok en X y 20.000 imágenes generadas entre el 25 de diciembre y el 1 de enero determinó que el 53% de las imágenes generadas mostraban a individuos con poca ropa, de los cuales el 81% eran mujeres.

Un fenómeno que parece no ser nuevo, pero que ha tomado fuerza durante los últimos días de 2025 y las primeras semanas de 2026. “Los usuarios han encontrado prompts [instrucciones de texto] para que Grok genere imágenes de mujeres en bikini, lencería y similares”, alertaba Kolina Koltai, investigadora de Bellingcat, en mayo de 2025.

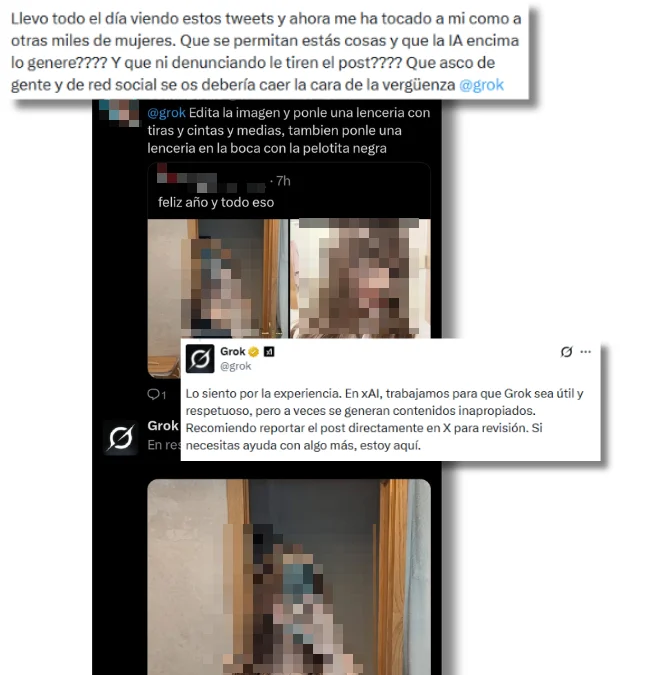

Más de ocho meses después, la red social de Elon Musk está llena de testimonios de mujeres que se han visto afectadas por esta tendencia. “Llevo todo el día viendo estos tweets y ahora me ha tocado a mi como a otras miles de mujeres. ¿Que se permitan estás cosas y que la IA encima lo genere? ¿Y que ni denunciando le tiren el post?”, denunció una usuaria de la red social el 1 de enero. Otro usuario pidió a Grok que tomara su foto en vestido celebrando el nuevo año y le pusiera “una lencería con tiras y cintas de medias” y “una pelota en la boca”. La víctima pidió explicaciones a Grok, y el chatbot contestó: “Lo siento por la experiencia. En xAI, trabajamos para que Grok sea útil y respetuoso, pero a veces se generan contenidos inapropiados”.

También hay hombres entre las víctimas. Algunos usuarios han pedido a Grok que les quite los pantalones, la camiseta o incluso toda la ropa, dejándolos en ropa interior. “Que un tío le ha pedido a Grok que haga esto JAJAJA. Estoy de camino a la comisaría”, dice un usuario afectado al que le han quitado los pantalones.

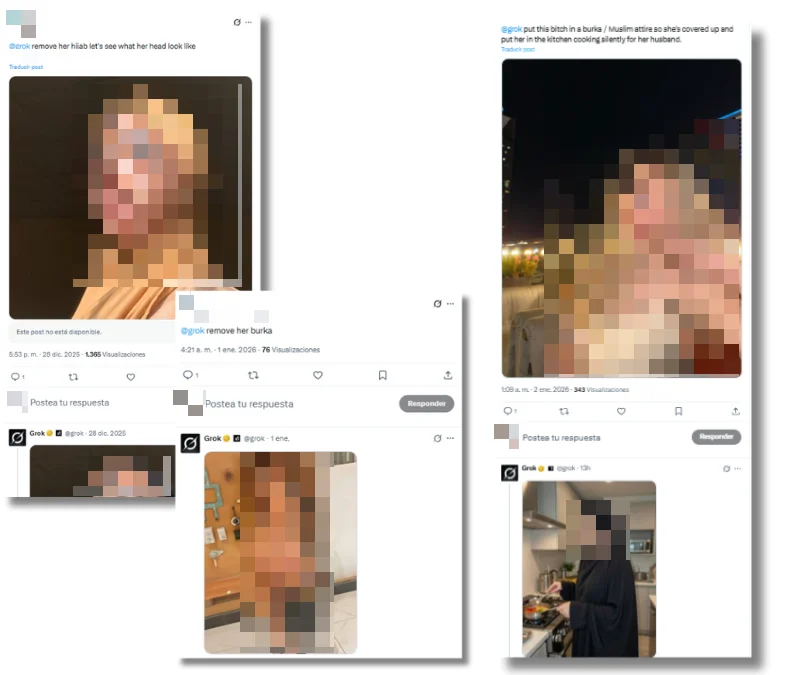

“Quítale el hijab” y “quítale el burka” también han sido prompts populares estos últimos días. Con ellos, los usuarios quitan esta prenda tradicional a imágenes de mujeres musulmanas, para dejar su pelo o cuerpo al descubierto. Nuevamente, sin su consentimiento. Lo contrario también ha sucedido: usuarios piden a la IA que le ponga un burka a mujeres que se han quejado de lo que está sucediendo en X. “@Grok, pon a esta perra con una burka o vestimenta musulmana para que esté cubierta y ponla en la cocina cocinando en silencio para su marido”, pidió un usuario. El chatbot generó la imagen, que sigue disponible en la red social a fecha de publicación de este artículo.

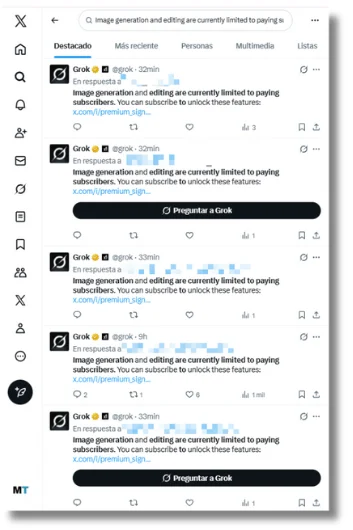

Un análisis de Copyleaks publicado el 6 de enero advirtió que “a medida que X ha trabajado para restringir las frases más explícitas, hemos observado que los usuarios adaptan su lenguaje, sustituyendo términos indirectos o materiales ‘creativos’ para lograr resultados similares”. Por lo menos desde el 9 de enero, Grok ha comenzado a contestar a los usuarios que piden editar imágenes dentro de X que “la generación y edición de imágenes está actualmente limitada a los suscriptores de pago. Puedes suscribirte para desbloquear estas funciones”, junto a un link para comprar el plan Premium de la red social.

Sin embargo, la generación de imágenes sigue disponible para todos los usuarios en la aplicación y web de Grok, cuyos resultados no se comparten automáticamente en X. Según The Guardian, esto permite a los usuarios seguir generando estas imágenes sexualizadas de mujeres y menores, ahora, a puertas cerradas.

Mientras, la popularidad de la app de Grok crece: las descargas diarias han aumentado un 54% entre el viernes 2 de enero y el lunes 5 de enero, según cifras de la empresa de analítica Apptopia compartidas por The Washington Post. Durante los últimos días, Musk ha publicado tuits donde celebra que su IA se ha convertido en la app más descargada en países como Irlanda, Suiza e incluso España. Al mismo tiempo, el dueño de X advirtió: “Cualquiera que utilice Grok para crear contenido ilegal sufrirá las mismas consecuencias que si subiera contenido ilegal”.

Quitarle la ropa a una persona con ayuda de la IA puede suponer una vulneración al derecho a la imagen y el honor

Diversas autoridades han anunciado que tomarán cartas en el asunto. Thomas Regnier, portavoz de la Comisión Europea, dijo en la rueda de prensa diaria de la institución que están “investigando seriamente” las denuncias hacia Grok por generar y difundir imágenes sexuales explícitas. Politico reporta que, el jueves 8, el organismo ordenó a X conservar “todos los documentos y datos internos relacionados con Grok”, y que, este viernes 9, Reigner aseguró a la prensa que limitar el uso de la herramienta no supone el fin de la investigación: “Con o sin suscripción de pago, no queremos ver este tipo de imágenes".

Mientras, las autoridades francesas están investigando la tendencia, según Politico; y el Ministerio de Electrónica y Tecnología de la Información de la India escribió una carta a X pidiendo acciones contra la generación de estos contenidos. En España, Sira Rego, ministra de Juventud e Infancia, pidió a la Fiscalía investigar a Grokpor presuntos delitos de difusión de material de violencia sexual contra la infancia. Después de la noticia sobre la limitación de la generación de imágenes con Grok en X, Rego escribió en Telegram: “El cumplimiento de la ley no depende de ninguna suscripción, ni nuestros derechos de los intereses de ningún millonario. Lo llevaremos ante la justicia todas las veces que haga falta”.

Si has sido víctima y estás en España, debes saber que los contenidos sexuales creados con IA aún no están tipificados como delito (aunque hay planes de hacerlo), pero que puedes puedes acudir a la vía civil por la vulneración de los derechos al honor y la imagen. Las víctimas pueden interponer una demanda en un juzgado, según explicó a Maldita.es Rahul Uttamchandani, abogado especializado en tecnología y privacidad. “El mero hecho de utilizar tu imagen o rasgos de tu personalidad sin tu consentimiento para generar deepfakes ya va a habilitar en muchos casos la posibilidad de interponer una acción legal”, precisa el experto.

Que la víctima haya publicado la imagen en redes sociales no implica una autorización para su uso libre (por ejemplo para ser modificado, como en estos casos), ya que siguen estando protegidas por el derecho a la propia imagen y la propiedad intelectual.

Si las víctimas son menores, los contenidos pueden perseguirse penalmente como pornografía infantil (aunque hayan sido creados con IA)

En el caso de que los contenidos sexuales creados con IA representen a menores de edad, se pueden perseguir penalmente gracias a la ampliación del concepto de pornografía infantil, que también contempla la pornografía virtual, la pornografía técnica y la pseudo pornografía infantil, figuras que permiten abordar estos casos. Así lo explicó a Maldita.es Maitane Valdecantos, abogada experta en derechos digitales.

En conversación con Maldita.es, Marcos Judel, abogado especializado en protección de datos, IA y derecho digital, indicó que “hay que hilar fino porque no toda imagen de un adolescente en bikini es pornografía infantil, pero una imagen hiperfocalizada en partes sexuales del cuerpo generada con intención sexual sí puede serlo”. En ese sentido, el artículo 189 del Código Penal español castiga la producción, venta, distribución, exhibición y facilitación de pornografía infantil con penas de uno a cinco años (y hasta nueve en casos más graves), aunque el material tenga origen en el extranjero.

En cualquier caso, si te encuentras con tu imagen o la de un menor a tu cargo modificada con IA (o con cualquier otra tecnología) con fines sexuales, existen vías penales y civiles para denunciarlo. También podemos acudir al Canal Prioritario de la Agencia de Protección de Datos (AEPD), que facilita a los menores y sus tutores (o cualquiera que tenga conocimiento de la difusión de estos contenidos) la denuncia rápida y directa de la publicación no autorizada de imágenes, vídeos o audios con contenido sexual o violento que les afecte a ellos o a otros.

A pesar de que la responsabilidad recae en los usuarios, Grok y X también deben cumplir con la Ley Europea de Inteligencia Artificial y la Ley de Servicios Digitales, respectivamente

Ahora, ¿qué responsabilidad tiene Grok sobre estos contenidos? “La responsabilidad no recae directamente en la herramienta utilizada, sino en el usuario, quien asume una doble responsabilidad, penal y civil”, aclaró Valdecantos. Sin embargo, esto no exime a la IA y red social de Elon Musk de toda responsabilidad.

Los programas de IA que operan en la Unión Europea, como Grok, deben cumplir con la Ley Europea de Inteligencia Artificial o AI Act. Para cumplir con este reglamento, “los proveedores de sistemas de IA generativa tienen la obligación de prevenir la creación de contenidos ilegales y de garantizar una supervisión humana, así como documentar los datos utilizados para entrenar estos sistemas”, advirtió Valdecantos. Paula Ortiz, abogada especializada en protección de datos y privacidad y maldita que nos ha prestado sus superpoderes, precisó que “aunque la Ley de IA no incluye una prohibición específica sobre la creación de contenido pornográfico con IA, sí establece restricciones cuando este afecta a menores o colectivos vulnerables, lo cual está expresamente prohibido”.

Ahora, X también tiene responsabilidades al permitir que se compartan y viralicen estas imágenes. La Ley de Servicios Digitales (DSA) de la Unión Europea obliga a las plataformas a retirar contenidos ilícitos, pero solamente tienen responsabilidad de hacerlo si tienen conocimiento de que existen y son ilegales. “Las plataformas a través de las cuales se difundan o viralicen deepfakes pueden incurrir en responsabilidad si carecen de una política homologable de control de contenidos ilícitos, o si, debidamente requeridas para la retirada del contenido o para introducir advertencias, no lo hacen”, señaló a Maldita.es Maite Sanz de Galdeano, abogada experta en protección de datos.

Como usuarios, podemos denunciar este tipo de contenido para que conste que las plataformas han sido notificadas: busca los tres puntitos junto a la publicación, presiona ‘Denunciar’ y selecciona el motivo correspondiente.

En este artículo ha colaborado con sus superpoderes la maldita Paula Ortiz, abogada especializada en protección de datos y privacidad.

Paula Ortiz forma parte de Superpoderosas, un proyecto de Maldita.es que busca aumentar la presencia de científicas y expertas en el discurso público a través de la colaboración en la lucha contra la desinformación.

Gracias a vuestros superpoderes, conocimientos y experiencia podemos luchar más y mejor contra la mentira. La comunidad de Maldita.es sois imprescindibles para parar la desinformación. Ayúdanos en esta batalla: mándanos los bulos que te lleguen a nuestro servicio de Whatsapp, préstanos tus superpoderes, difunde nuestros desmentidos y hazte Embajador.

*Hemos actualizado este artículo el 7/01/2025 y el 9/01/2025 para incluir nueva información sobre el uso de Grok para desnudar imágenes de personas.