¡Feliz sábado, malditas y malditos! Como sabes, llevamos años persiguiendo en TikTok contenidos que no deberían estar ahí: vídeos que potencian TCA, contenidos machistas, retos virales peligrosos, dinámicas que pueden ser adictivas. También hemos analizado cómo Telegram es una plataforma que facilita actividades ilegales, como la venta de armas. Y tenemos el foco puesto en cómo la IA generativa se está usando de formas horribles, como para crear imágenes y vídeos porno o que sexualizan a mujeres famosas sin su consentimiento y para ejercer violencia digital contra menores.

Pero lo que hemos encontrado en nuestra última investigación aúna todo esto de manera terrible: en TikTok hay un mercado de contenido sexual de menores creado con IA y de vídeos reales de adolescentes republicados, que es una puerta de acceso a imágenes de abuso sexual de menores reales que se venden e intercambian en Telegram.

El algoritmo de TikTok de un pedófilo

No es la primera vez que nos topamos con contenido sexual en TikTok. En abril de 2024 vimos que, pese a que la plataforma prohíbe los vídeos donde aparezca sexo explícito, desnudos y contenidos fetichistas, sí había contenido erótico accesible a menores que además dirigía a los usuarios a páginas de contenido explícito y de pago, con las consecuencias que esto implica.

Pero lo que encontramos en noviembre de este año tiene un giro aún más macabro que acaba directamente en contenido de abuso sexual de menores. En TikTok hay contenidos sexualizados de menores, tanto creados con IA como reales, desde los que se puede saltar tanto a la compra de contenido pornográfico de menores creado con IA como, aún peor, a contenido real.

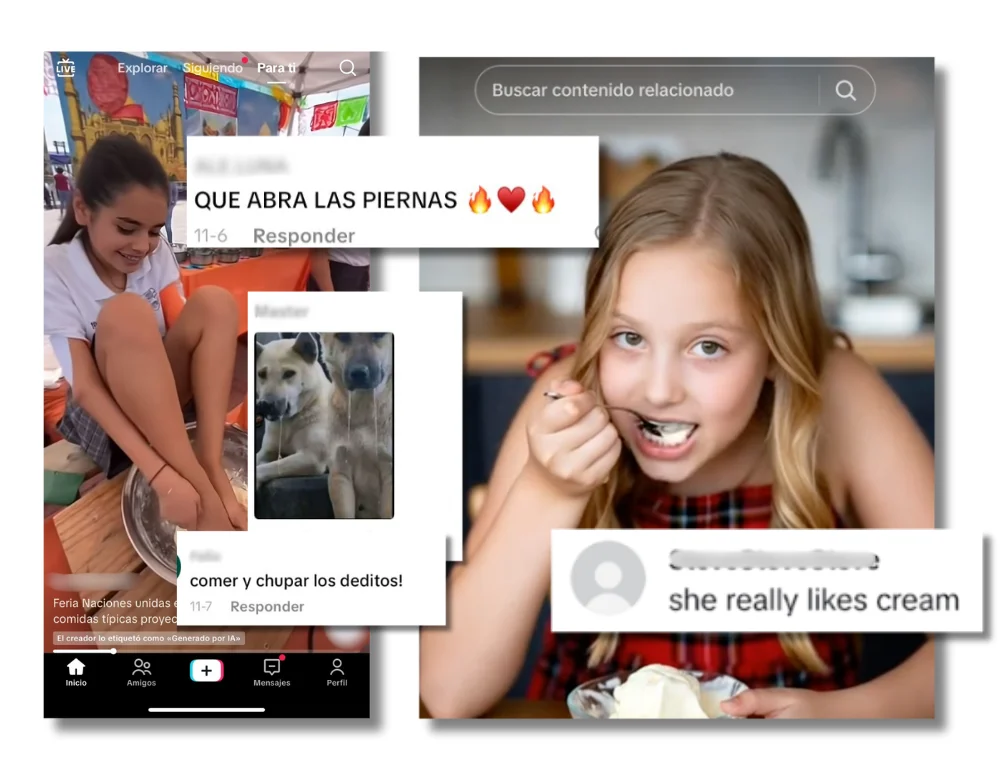

Todo esto empieza, como siempre en las redes sociales, con un algoritmo. Pepe (el perfil falso que usamos para la investigación) abre TikTok y empieza a ver vídeos: una menor en uniforme preparando comida con los pies (vídeo generado con IA), una adolescente real bailando un trend, dos niñas pequeñas cantando... Y así puede seguir durante horas, porque el algoritmo de TikTok te empuja al scroll infinito recomendándote los vídeos que te gustan. También a los pedófilos. Analizamos esos vídeos, los comentarios que dejan los usuarios en ellos y las cuentas que hay detrás. Esto es lo que encontramos.

Un mercado de contenido sexual de menores hecho con IA

Por un lado, entre los vídeos que le aparecen a Pepe están las cuentas de TikTok que usan inteligencia artificial para sexualizar a niñas y adolescentes. Han construido una comunidad en torno a ello: las 20 cuentas que analizamos (hay más) acumulan 553.180 seguidores y más de 5,7 millones de ‘me gusta’. Tienen publicados más de 5.200 vídeos de niñas sexualizadas creadas con la IA. Las representan en bikini, uniforme o con ropa ajustada.

Estas publicaciones están llenas de comentarios con sugerencias sexuales explícitas hacia las supuestas menores; los usuarios que los escriben parecen ser adultos. Aquí puedes leerlo. Por cierto, para generar estos vídeos, se usan herramientas como la propia IA generativa de TikTok y Sora de OpenAI.

Las niñas de los vídeos no son reales, pero los efectos que tienen estos contenidos sí: contribuyen a normalizar la sexualización infantil y refuerzan patrones de consumo dañinos para los menores. Además, aunque estén hechos con IA y no sean reales, pueden ser perseguidos por la ley como pornografía infantil.

Un escaparate de vídeos reales de niñas reutilizados con fines sexuales

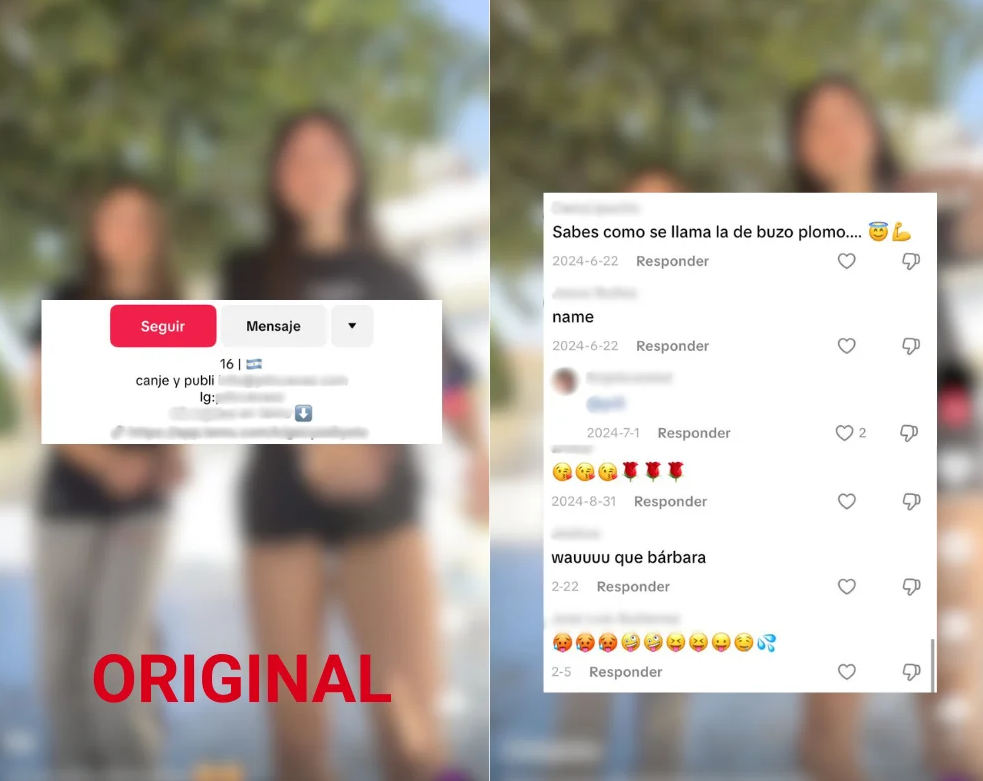

Pero no todo es IA. Por otro lado están las cuentas que republican vídeos de adolescentes reales para ponerlos a disposición de pedófilos. Es decir, van a las cuentas de TikTok de chicas menores de edad (como pueden ser tus hijas, tus nietas, tus sobrinas o las de tus amigos), descargan el vídeo y lo suben a sus cuentas para crear un escaparate con intenciones sexuales.

Hemos analizado 20 cuentas de TikTok que recopilan vídeos de menores reales, en su mayoría niñas y adolescentes usando uniforme o en espacios escolares. 11 de los perfiles usan como reclamo la palabra “colegialas” en su nombre. Las publicaciones se llenan de comentarios con sugerencias sexuales muy explícitas de lo que harían con esas chicas. TikTok dice prohibir “sexualizar o fetichizar a un menor”, pero ahí están, los vídeos y los comentarios.

Además, en varios de los contenidos se puede ver el nombre de las usuarias que subieron los vídeos originalmente, lo que puede dirigir a estos usuarios a las cuentas de las menores, exponiéndolas a acoso online y grooming. Si hablamos del hecho en sí de que alguien coja el vídeo de una menor y lo republique, puede suponer una vulneración de los derechos a la propia imagen y un tratamiento sin base legal de los datos personales de las menores, así que si le sucede a una menor a tu cargo, puedes denunciar.

Lucrarse con contenido sexual infantil (TikTok también saca tajada)

¿Y qué buscan estas cuentas? Dinero. Muchas se lucran vendiendo vídeos e imágenes sexuales de menores creados con IA a través del sistema de suscripción de TikTok (por el que TikTok recibe hasta un 50% de los beneficios). Promocionan contenido oculto y ‘exclusivo’ por el que los usuarios deben pagar una cuota mensual a modo de suscripción. También venden pornografía infantil creada con IA en webs externas y plataformas externas. Te dejo aquí todos los detalles de cómo lo hacen.

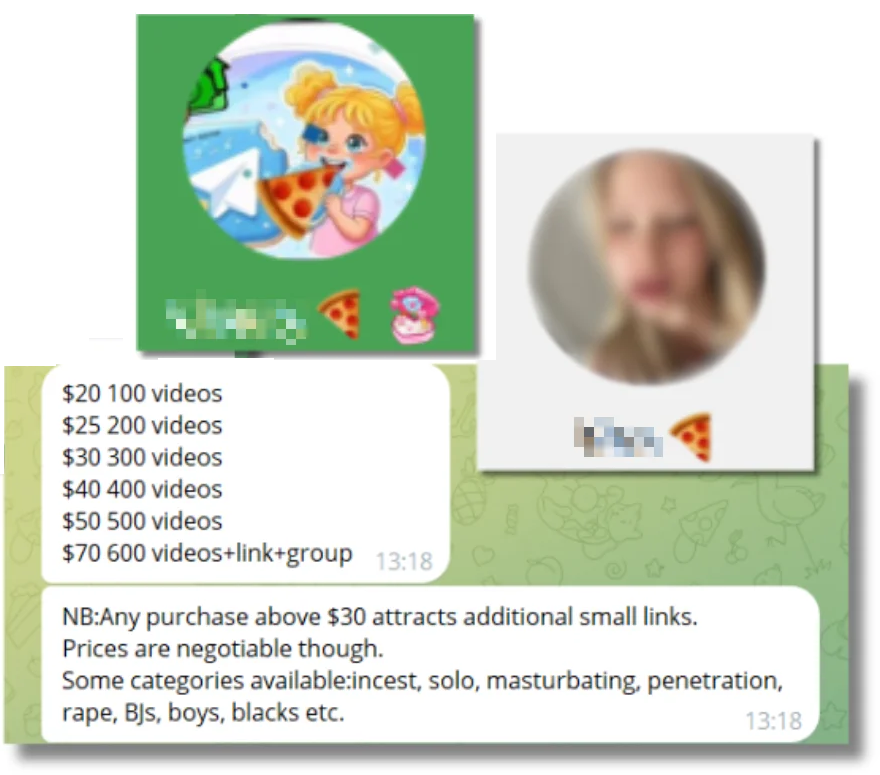

Todo esto es la antesala del horror total. Porque cuando tiras del hilo ves que hay quien se aprovecha de estas cuentas en TikTok para publicitar su propio negocio: venta e intercambio de contenido de abuso sexual infantil en Telegram. Solo se tarda cinco minutos en llegar desde un vídeo sexual de una menor generada con IA en TikTok hasta pornografía infantil real en la app de mensajería.

Hemos identificado 12 cuentas de Telegram que venden material ilegal. Siete nos enviaron pruebas de que tienen pornografía de menores reales (inmediatamente lo denunciamos). La ofrecen en conversaciones privadas como si fuera el menú del día. Ha sido angustioso investigarlo, es angustioso leerlo, pero hay que hacerlo para comprender el horror y los riesgos que hay en internet. Aquí tienes esa parte de la investigación.

Denunciar los vídeos que sexualizan a menores

Hace una semana que publicamos esta investigación y su impacto está siendo increíble, lo que da sentido a lo que hacemos porque lo que queremos es cambiar las cosas, que estas situaciones terribles dejen de suceder y que, quienes pueden y deben hacerlo, tomen medidas para evitarlo. Ayúdanos a conseguirlo y comparte (te dejo también la investigación en inglés). Puedes hacerlo también en nuestras redes sociales; te dejo este vídeo resumen y estas imágenes.

También es muy importante denunciar este tipo de contenidos si nos los encontramos, ya sean reales o hechos con inteligencia artificial. Así, las plataformas se enterarán de que están circulando y estarán obligadas a revisar y retirar el contenido - de la inacción de TikTok ante estas cuentas después de nuestras denuncias te damos todos los detalles aquí. Te adelanto que lo que dicen sus normas no comulga con lo que realmente sucede, y que tanto TikTok como Telegram tienen obligaciones ante la DSA.

Para denunciar, en Telegram hay que dar clic sobre los tres puntos junto al nombre del canal y elegir ‘reportar’ en el menú. Para TikTok, puedes ver los pasos aquí. Si nos encontramos con pornografía infantil, es muy importante denunciar el contenido directamente a la Policía Nacional, nunca reenviarlo o descargarlo.

En tres bits

Gracias por haber leído este Tech en un clic tan crudo y por apoyar el trabajo de Maldita. Para cerrar, te dejamos tres bulos que hemos desmentido en las últimas semanas gracias a que nos habéis escrito a través de nuestro chatbot en WhatsApp en el +34 644 229 319. Ya sabes, si te llega algún contenido del que no te fías, algo que luce hecho con IA o dudas sobre algo que has leído, escríbenos y te contestaremos.

Este vídeo de dos mujeres musulmanas que no pueden retirar dinero de un banco por usar niqab no es real. Igual te has encontrado con este vídeo en el que supuestamente se ve a dos mujeres musulmanas que no pueden retirar dinero del banco porque se niegan a quitarse el velo que les cubre la cara, pero no es real y ha sido generado con inteligencia artificial, como marca la etiqueta de YouTube y el propio usuario que lo creó.

El vídeo de dos coches que vuelcan al subir la rampa de una grúa tampoco es real. Más IA generativa para difundir bulos y apoyar mensajes. Este vídeo que supuestamente muestra a dos coches que suben por la rampa de una grúa (bien de luces) en mitad de la carretera y después vuelcan ha sido creado con inteligencia artificial (IA). Algunas de las publicaciones que comparten este contenido lo acompañan de mensajes como “no ven esto y van a ver la puñetera baliza”, en relación a la baliza V16.

Elon Musk no ha presentado un teléfono móvil llamado Tesla Pi. Lo siento, pero esta Navidad no vas a poder comprar un móvil del dueño de X (antes Twitter) que puede cargarse con luz solar y conectarse a Starlink y Neuralink porque, de momento, no existe. Aunque circulan contenidos que afirman que Musk ha presentado este teléfono, no ha sido así. Que no te la cuelen.

¿Tienes dudas sobre el día a día online? ¿Hay algún tema del mundo de la tecnología que te genere curiosidad y sobre el que te gustaría que ampliáramos información? ¿Quieres compartir algún tema interesante con la comunidad maldita? ¡Escríbenos a [email protected]! Y no olvides suscribirte.