Vídeos creados con Sora de OpenAI, el híbrido entre red social y herramienta de creación de vídeos con IA, ya inundan internet, a pesar de que la app sigue estando disponible solo con invitación en Estados Unidos y Canadá. Con ella, los usuarios pueden crear de forma fácil y rápida vídeos que representan a personas reales. Según la compañía, la app cuenta con medidas de mitigación para evitar malos usos de la imagen de otras personas y bloquear representaciones de figuras públicas (excepto de lo que consideran “figuras históricas”).

Sin embargo, no es difícil encontrarnos con vídeos creados con Sora que representan a celebridades y figuras políticas. Los resultados hiperrealistas, sumado a que se eliminan las marcas de agua y terminan circulando fuera de su contexto original, hacen que estos vídeos puedan provocar desinformación y agravar la desconfianza de los usuarios ante lo que ven. También se pueden usar para difamar a famosos y ponerlos en situaciones irreales que afecten su reputación. Pero no solo a ellos: si compartimos nuestro rostro con la función ‘Cameo’ de la app, que permite crear deepfakes (vídeos que suplantan la identidad con IA), nuestra imagen también puede escapar de nuestro control y terminar siendo usada para difamarnos, acosarnos o extorsionarnos.

Sora permite crear vídeos hiperrealistas de personas reales: OpenAI dice bloquear los de figuras públicas, pero permitir los de personajes históricos

El 30 de septiembre, OpenAI presentó Sora, una app que permite crear vídeos con su modelo Sora 2 y compartirlos en un feed ‘Para ti’, donde podemos interactuar con otros usuarios. Con esta app, que aún no está disponible en España, los usuarios pueden crear vídeos y audios hiperrealistas con solo un prompt (instrucción de texto).

Adelantándose a posibles malos usos, Sam Altman, el dueño de OpenAI, aseguró en su blog que la aplicación cuenta con “medidas de mitigación para evitar el uso indebido de la imagen de otra persona en deepfakes, medidas de seguridad para contenido perturbador o ilegal, controles periódicos sobre el impacto de Sora en el estado de ánimo y el bienestar de los usuarios, etc.”.

En el comunicado del lanzamiento, OpenAI aseguró tomar “medidas para bloquear representaciones de figuras públicas”. Días después, Altman comunicó que darán a los “titulares de derechos” mayor control sobre la generación de personajes, con un modelo similar al opt-in (solicitar consentimiento previo). Sin embargo, han circulado vídeos creados con Sora, por ejemplo, del actor Bryan Cranston junto a Michael Jackson, del influencer Jake Paul, y de Donald Trump junto a Vladimir Putin y Volodímir Zelensky. También de figuras públicas que ya han fallecido, como Amy Winehouse, Tupac Shakur y Albert Einstein. Consultados por esto, OpenAI afirmó a PCMag que sí permiten “la generación de figuras históricas”, pero no está claro qué definen como tal.

Estos vídeos hiperrealistas de personajes públicos pueden desinformar y aumentar la desconfianza de los usuarios ante lo que ven, además de usarse para difamarlos

Esta confusión sobre los límites de lo que está permitido y lo que no ha dado cabida a que se creen y compartan todo tipo de vídeos que muestran a figuras públicas. Algunos de ellos pueden producir desinformación y aumentar la sensación de desconfianza de los usuarios ante lo que ven. Gracias a sus resultados hiperrealistas, los vídeos creados con esta app no presentan muchos de los errores que solíamos buscar para identificar si un vídeo era real o un deepfake. A esto se suma que en internet ya hay herramientas para eliminar las marcas de agua de Sora, y que los vídeos están circulando fuera de su contexto original (se comparten en otras redes sociales, en ocasiones, sin etiquetas que los identifiquen como creados con IA).

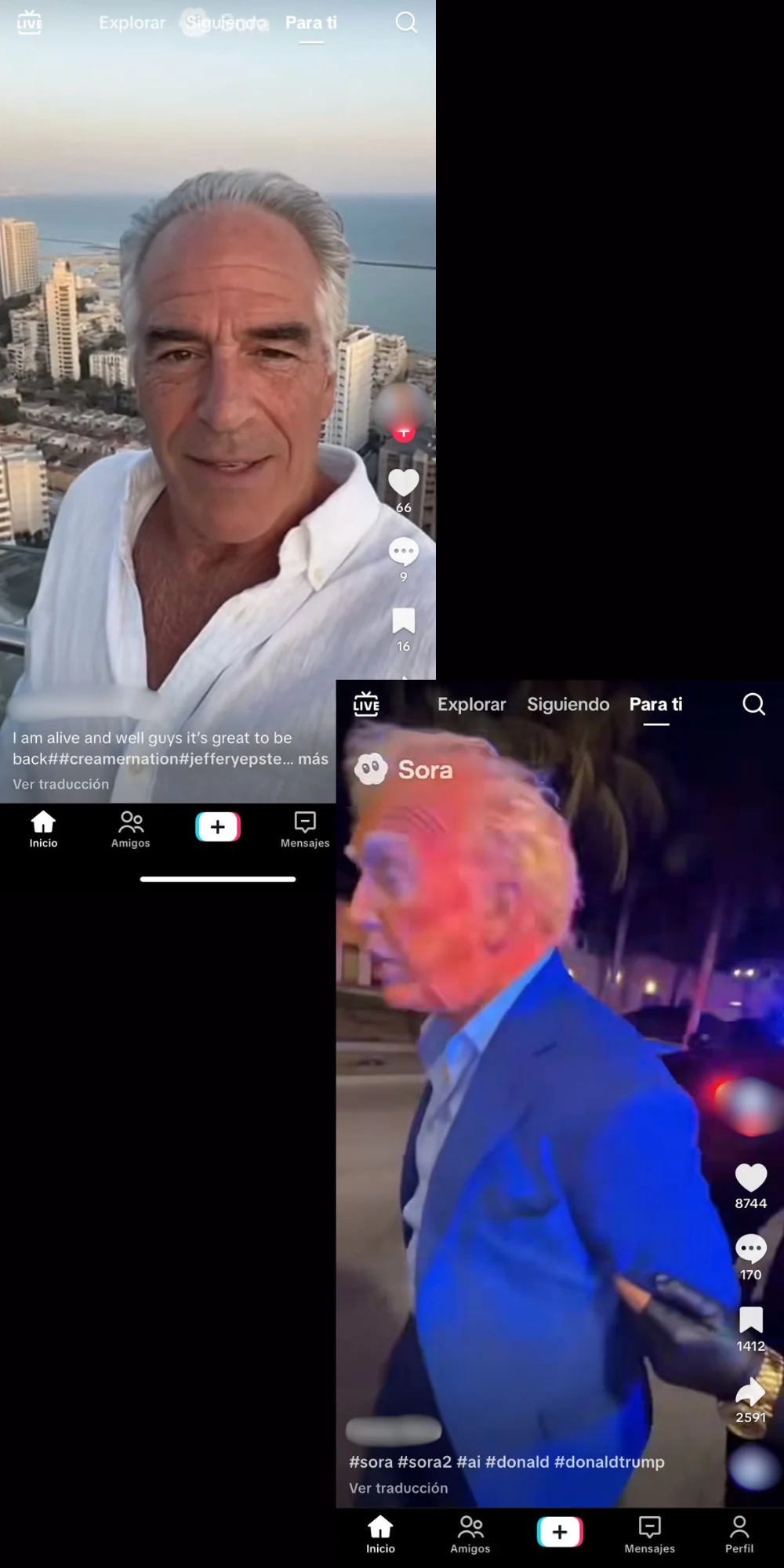

Además, que estos vídeos representen a figuras públicas puede generar falsos relatos y alterar la percepción sobre personajes y hechos reales o históricos. Por ejemplo, en TikTok circulan vídeos creados con Sora que muestran a Jeffrey Epstein diciendo que está vivo y que reside en Tel Aviv (Israel), una narrativa que forma parte de una teoría de la conspiración, o de Trump siendo detenido por reclutar mujeres para Epstein. Estos contenidos pueden servir para reforzar narrativas sobre el caso Epstein y el supuesto papel del presidente de Estados Unidos.

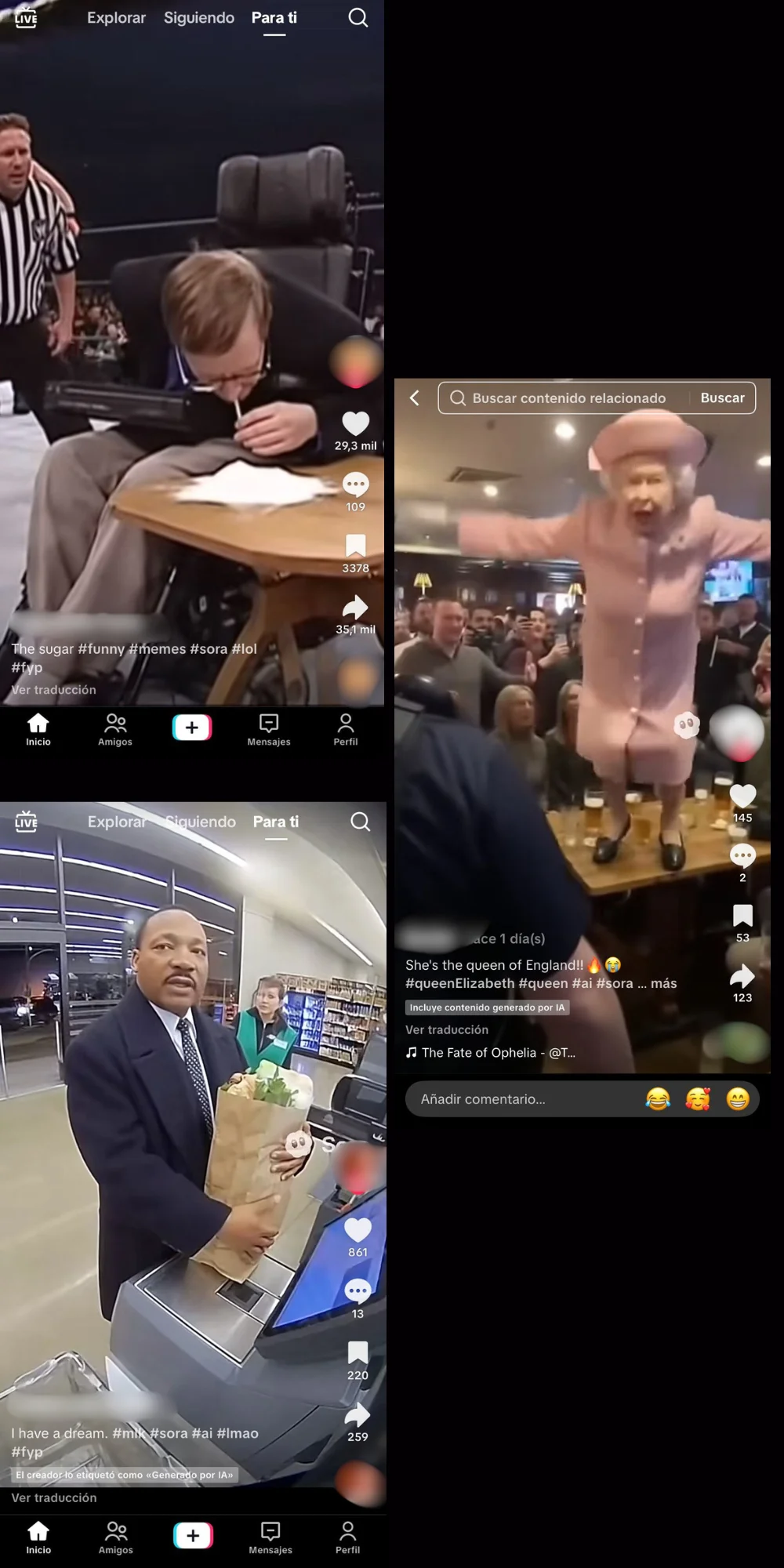

También pueden usarse para difamar a estos personajes públicos, poniéndolos en situaciones falsas que pueden afectar su reputación. Por ejemplo, en redes sociales circulan vídeos hechos con Sora que muestran al científico Stephen Hawking consumiendo cocaína, al activista Martin Luther King llevándose la compra de un supermercado sin pagar, o a la reina de Inglaterra Isabel II tirándose encima de una persona para pegarle.

El uso no autorizado de la imagen de estas personas ha generado preocupación y rechazo por parte de agencias de talento y empresas de Hollywood. Entre sus familiares también. La hija del difunto actor, Robin Williams, hizo un llamado a los usuarios para que dejen de hacer vídeos con IA de su padre, que han proliferado desde el lanzamiento de Sora: “Por favor, dejad de enviarme vídeos de mi papá con IA”, pidió Zelda Williams a través de su Instagram. “Por favor, si tienes un poco de decencia, deja de hacerle esto a él y a mí, incluso a todos, y punto. Es una tontería, es una pérdida de tiempo y energía, y créeme, no es lo que él querría”, añadió.

En respuesta, un portavoz de OpenAI afirmó a Axios que hay “fuertes intereses de libertad de expresión” en el uso de Sora para representar a figuras históricas. "En el caso de las figuras públicas recientemente fallecidas, sus representantes autorizados o los propietarios de sus bienes pueden solicitar que su imagen no se utilice en los cameos de Sora”, añadió. Sin embargo, igual que con “personaje histórico”, Axios detalla que OpenAI no aclaró qué considera “recientemente fallecido”.

También podemos ser víctimas: compartir nuestro rostro con la función ‘Cameo’ puede exponernos a difamación, acoso y extorsión, y conllevar riesgos para nuestra privacidad

Pero el riesgo de ser difamados no se limita sólo a las figuras públicas: la función de “Cameos” de Sora conlleva sus propios riesgos para nuestra privacidad. Esta permite a los usuarios generar deepfakes de ellos mismos y de otros (si así lo permiten). “Puedes aparecer directamente en cualquier escena generada con Sora con una fidelidad sorprendente, tras una breve grabación única de vídeo y audio en la aplicación para verificar tu identidad y capturar tu imagen”, explica la compañía.

A pesar de que podemos configurar quiénes pueden usar nuestros rostros para crear deepfakes, no es difícil que perdamos el control sobre cómo se usa y dónde se comparten estas creaciones. Por ejemplo, un amigo al que hemos autorizado usar nuestra imagen puede crear un contenido que a él le parezca gracioso, pero a nosotros humillante. Un usuario que lo vea en Sora puede compartirlo a través de otros canales, y hacer que este contenido termine escapando de nuestro control.

Además, es importante tener en cuenta que cuando subimos nuestro rostro a Sora, estamos compartiendo nuestros datos biométricos: estas son características físicas, como rasgos faciales y ojos, que constituyen información altamente sensible, que no se puede modificar y que su mal uso puede implicar riesgos para nuestra privacidad y derechos fundamentales.

Jorge Louzao, experto en ciberseguridad y maldito que nos ha prestado sus superpoderes, dice que uno de los principales riesgos es la suplantación de identidad, ya que los deepfakes de los usuarios “se pueden difundir sin control, usarse para acosarlos, extorsionarlos o simplemente avergonzarlos, o incluso para amplificar discursos de odio, falsedades y discursos extremos”. Por ejemplo, la periodista Taylor Lorenz denunció que su acosador usó la herramienta de OpenAI para crear vídeos con IA de ella.

A esto se suma que compartir nuestro rostro con OpenAI “también incrementa los riesgos si hubiera fallos de seguridad o cambios de políticas”, explica Louzao. Por ejemplo, estos datos biométricos podrían ser expuestos a actores maliciosos si la empresa sufriera un ciberataque. También se podrían retener para “futuros usos internos, como la mejora del modelo o almacenamiento, o incluso compartirse con terceros”.

En este artículo ha colaborado con sus superpoderes el maldito Jorge Louzao, experto en ciberseguridad.

Gracias a vuestros superpoderes, conocimientos y experiencia podemos luchar más y mejor contra la mentira. La comunidad de Maldita.es sois imprescindibles para parar la desinformación. Ayúdanos en esta batalla: mándanos los bulos que te lleguen a nuestro servicio de Whatsapp, préstanos tus superpoderes, difunde nuestros desmentidos y hazte Embajador.