Vibes de Meta y Sora de OpenAI difuminan la línea entre las herramientas de inteligencia artificial generativa y las redes sociales: son apps que mezclan la creación de vídeos y audios con IA con feeds por los que podemos scrollear e interactuar (y así estar más tiempo frente a la pantalla).

Con estas apps, es más fácil crear contenidos con IA que pueden “contaminar los ecosistemas informativos”, según los expertos consultados por Maldita.es, y contribuir a desinformar y aumentar la desconfianza en los usuarios. A esto se suma que Sora tiene una función que nos permite crear deepfakes (vídeos manipulados con IA para suplantar la identidad) de nosotros mismos, algo que los expertos advierten puede exponer nuestros datos biométricos a suplantaciones y filtraciones de datos. El propio Sam Altman, dueño de OpenAI, reconoce que en la compañía son “conscientes de lo adictiva” que puede llegar a ser esta app, y los riesgos que supone su uso indebido.

Estas redes sociales permiten crear y compartir fácilmente ‘AI slop’, y usan el scroll infinito y el uso de contenidos aleatorios para mantenernos conectados a ellas

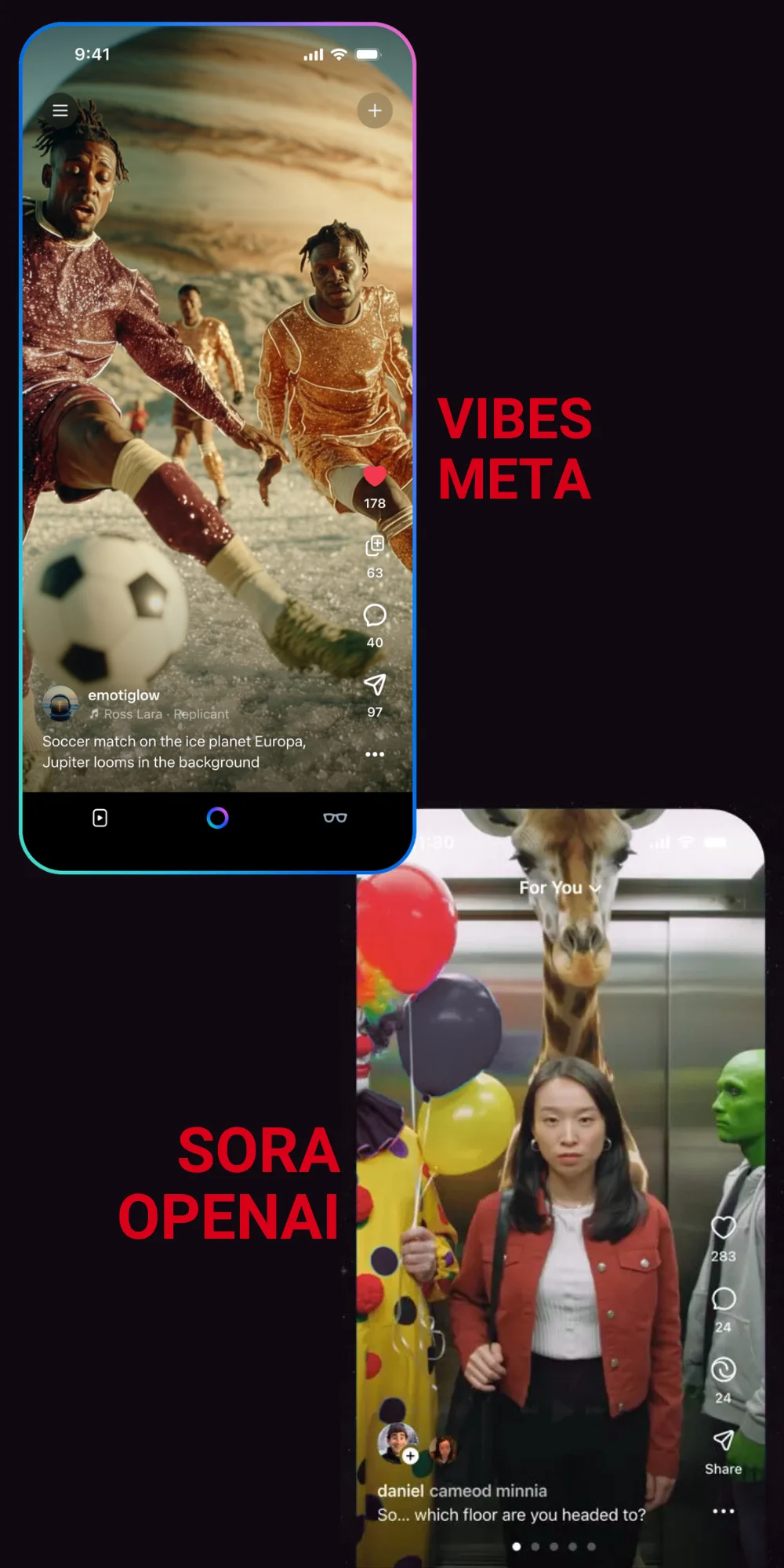

El 25 de septiembre de 2025, Meta anunció el lanzamiento de Vibes, un feed (flujo de contenido por el que nos podemos desplazar) dentro de la aplicación de Meta AI, que permite ver y compartir vídeos creados con la inteligencia artificial de la compañía. “Puedes darle vida a tus ideas con nuevas herramientas de creación visual con IA o remezclar un vídeo existente agregándole música o cambiando el estilo para hacerlo tuyo”, señala la empresa en su web. También permite dar ‘Me gusta’, comentar y compartir estos contenidos por mensaje directo o publicarlos en Instagram y Facebook.

Días después, el 30 de septiembre, OpenAI presentó su propia apuesta: Sora, una app que permite crear vídeos con su modelo Sora 2 y compartirlos en un feed ‘Para ti’, donde podemos interactuar con otros usuarios. Una de sus funciones más destacadas es “Cameo”, con la que los usuarios pueden generar deepfakes de ellos mismos y de otros usuarios (si así lo permiten). Al momento de publicación de este artículo, la app solo está disponible en Estados Unidos y Canadá para dispositivos iOS, y requiere de un código de invitación para entrar.

Con ambas aplicaciones, los usuarios pueden generar de forma fácil y rápida vídeos con IA. Esto puede hacer que se produzca masivamente contenido de baja calidad, también conocido como AI slop: vídeos, imágenes o textos creados con inteligencia artificial que no aportan valor, pero son llamativos, repetitivos e incoherentes.

Estas apps adoptan elementos de diseño que usan las redes sociales para mantenernos conectadas a ellas. Ambos feeds son similares a los de TikTok, con un scroll infinito que permite a los usuarios deslizar hacia abajo para ver contenido nuevo siempre. “El scroll infinito puede hacer que no seamos conscientes de lo que consumimos, porque ya no lo decidimos. No tenemos ni que darle a reproducir a un vídeo de forma activa. Eso nos evita elegir si queremos verlo o no”, explicó durante la Twichería de Maldita Tecnología Guillermo Paris, experto en Economía del comportamiento e investigador de experiencia de usuario.

Al scroll infinito se suma la aleatorización del contenido, que hace que no sepamos cuál va a ser el siguiente vídeo. Esta aleatorización no es totalmente al azar: las aplicaciones aprenden sobre nuestros gustos y qué tipo de vídeos consumimos más. Por ejemplo, Meta asegura que “el feed [de Vibes] se personalizará con el tiempo”. Por otro lado, Sam Altam, el dueño de OpenAI, reconoció en su blog que son “conscientes de lo adictivo que puede llegar a ser un servicio como este”.

Los contenidos que se crean con estas apps pueden saturar internet, además de generar desinformación y desconfianza en los usuarios

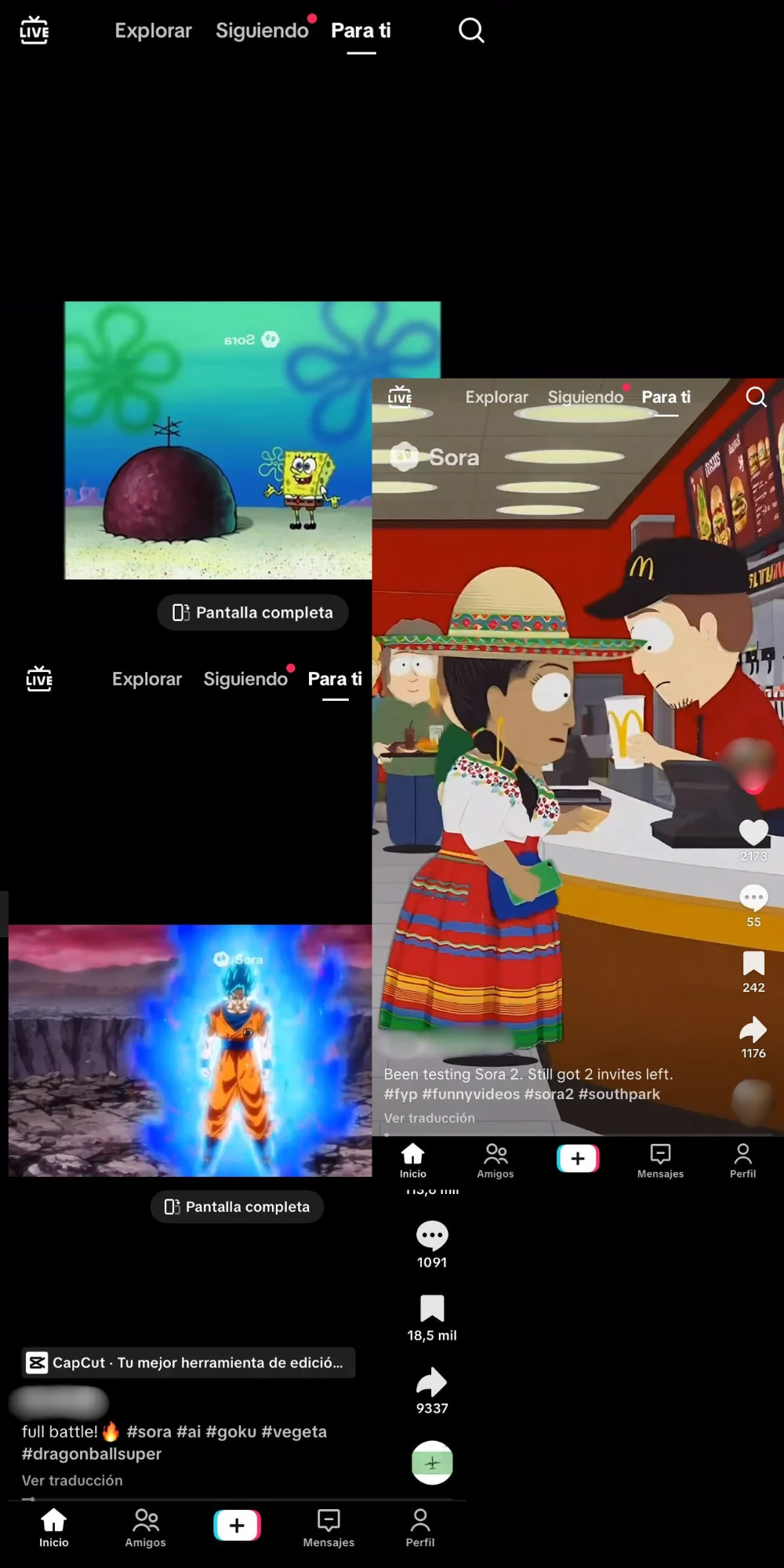

La facilidad con la que los usuarios pueden crear contenidos de baja calidad con estas apps trae consigo el riesgo de que contribuyan a ‘mierdificar’ las plataformas digitales (empeoran hasta que dejan de servir). “[El AI slop] contamina los ecosistemas mediáticos por sobrecarga informativa, es basura y polución digital, ocultando el contenido legítimo y de calidad”, advirtió Javi Cantón, investigador del Departamento de Ciencias de la Computación e Inteligencia Artificial de la Universidad de Granada. Ya lo podemos ver con los vídeos creados con Sora que imitan programas de televisión como Bob Esponja, Dragon Ball Z y South Park (algo que 404 Media dice que demuestra que la compañía ha entrenado su modelo con datos protegidos por derechos de autor), y llenan redes sociales como TikTok.

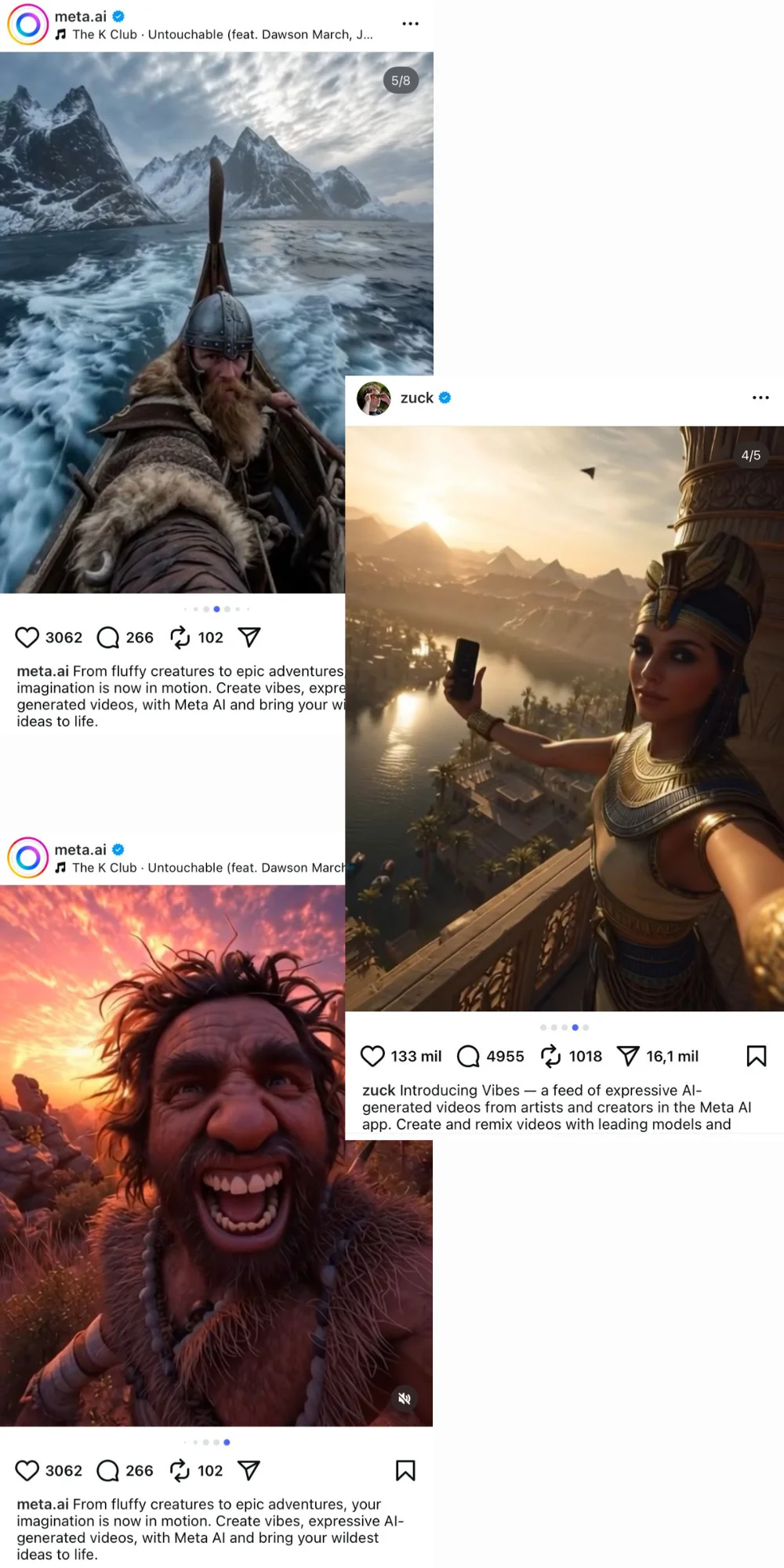

Esta contaminación también promueve la desinformación: estos contenidos muestran o relatan situaciones que no son reales, pero que muchas veces las personas las toman como ciertas. Por ejemplo, tanto Meta como su dueño, Mark Zuckerberg, han compartido en Instagram vídeos para promocionar Vibes que representan el pasado, como el Antiguo Egipto, los vikingos y los cavernícolas. En Maldita.es hemos explicado el peligro de que imágenes creadas con IA de representaciones históricas salgan de su contexto original, no se especifique su origen y se muevan como reales: pueden desinformar y alterar la percepción sobre personajes y hechos históricos.

Además, puede aumentar la sensación de desconfianza en los usuarios. Vídeos hiperrealistas como los que genera Sora pueden contribuir a esta incertidumbre, ya que no presentan muchos de los errores que solíamos buscar para saber si un vídeo era real o un deepfake. A esto se suma que en internet ya hay disponibles herramientas para eliminar las marcas de agua que incorporan los vídeos creados con Sora 2. “Si cada imagen o vídeo puede ser fabricado, el valor de lo que vemos como prueba desciende”, reflexiona Jorge Louzao, experto en ciberseguridad y maldito que nos ha prestado sus superpoderes.

Ceder nuestro rostro (y los datos biométricos que contiene) a OpenAI puede conllevar riesgos de suplantación y privacidad

La función de “Cameos” de Sora conlleva sus propios riesgos para la privacidad de los usuarios. Altman los reconoce en su blog y dice que han puesto “medidas de mitigación para evitar el uso indebido de la imagen de otra persona en deepfakes, medidas de seguridad para contenido perturbador o ilegal, controles periódicos sobre el impacto de Sora en el estado de ánimo y el bienestar de los usuarios, etc.”. El empresario también ha dicho que darán a los “titulares de derechos” mayor control sobre la generación de personajes, con un modelo similar al opt-in (solicitar consentimiento previo).

A pesar de que los usuarios tienen la potestad de configurar quiénes pueden usar sus rostros para crear deepfakes, esto no nos libra de los peligros que supone compartir nuestro rostro con una app de este tipo. Nuestras características físicas, como rasgos faciales y ojos, son datos biométricos: información altamente sensible, que no se puede modificar y que su mal uso puede implicar riesgos para nuestra privacidad y derechos fundamentales.

Para Louzao, uno de los principales riesgos es la suplantación de identidad, ya que los deepfakes de los usuarios “se pueden difundir sin control, usarse para acosarlos, extorsionarlos o simplemente avergonzarlos, o incluso para amplificar discursos de odio, falsedades y discursos extremos”.

“Que OpenAI guarde una representación de tu cara y voz para que otros generen vídeos de ti puede ser útil, pero también incrementa los riesgos si hubiera fallos de seguridad o cambios de políticas”. Por ejemplo, estos datos biométricos podrían ser expuestos a actores maliciosos si la empresa sufriera un ciberataque. También se podrían retener para “futuros usos internos, como la mejora del modelo o almacenamiento, o incluso compartirse con terceros”.

En este artículo ha colaborado con sus superpoderes el maldito Jorge Louzao, experto en ciberseguridad.

Gracias a vuestros superpoderes, conocimientos y experiencia podemos luchar más y mejor contra la mentira. La comunidad de Maldita.es sois imprescindibles para parar la desinformación. Ayúdanos en esta batalla: mándanos los bulos que te lleguen a nuestro servicio de Whatsapp, préstanos tus superpoderes, difunde nuestros desmentidos y hazte Embajador.