A partir del 3 de noviembre de 2025, LinkedIn, la red social orientada al uso profesional de Microsoft, usará los datos de sus usuarios europeos para entrenar sus modelos de IA generativa, pero podemos oponernos. Así lo explica una notificación por correo electrónico que han recibido los usuarios de la plataforma, donde se asegura que se recogerán datos como información de nuestro perfil y contenido público (“no tus mensajes privados”).

De esta manera, LinkedIn se suma a otras redes sociales y empresas tecnológicas que han cambiado sus políticas de privacidad para poder usar los datos de sus usuarios para entrenar sistemas de inteligencia artificial, como Meta (la dueña de Instagram y Facebook) y Twitter (ahora X).

La opción para que se usen nuestros datos viene activada por defecto, pero podemos desactivarla en la ‘Configuración’ del perfil

Al igual que Meta y otras compañías que han hecho este cambio, LinkedIn se justifica en el interés legítimo para usar los datos de los usuarios para entrenar sus modelos de IA. Esta es una de las bases jurídicas por las que las empresas pueden tratar los datos de las personas en la Unión Europea sin pedir su consentimiento.

Debido a esto, desde el 3 de noviembre estará activada por defecto la opción de que usen tus datos y se compartan con Microsoft, como señala su Aviso regional europeo de privacidad. Sin embargo, LinkedIn asegura que “puedes autoexcluirte en cualquier momento desde los ajustes si prefieres que tus datos no se usen de esta manera”.

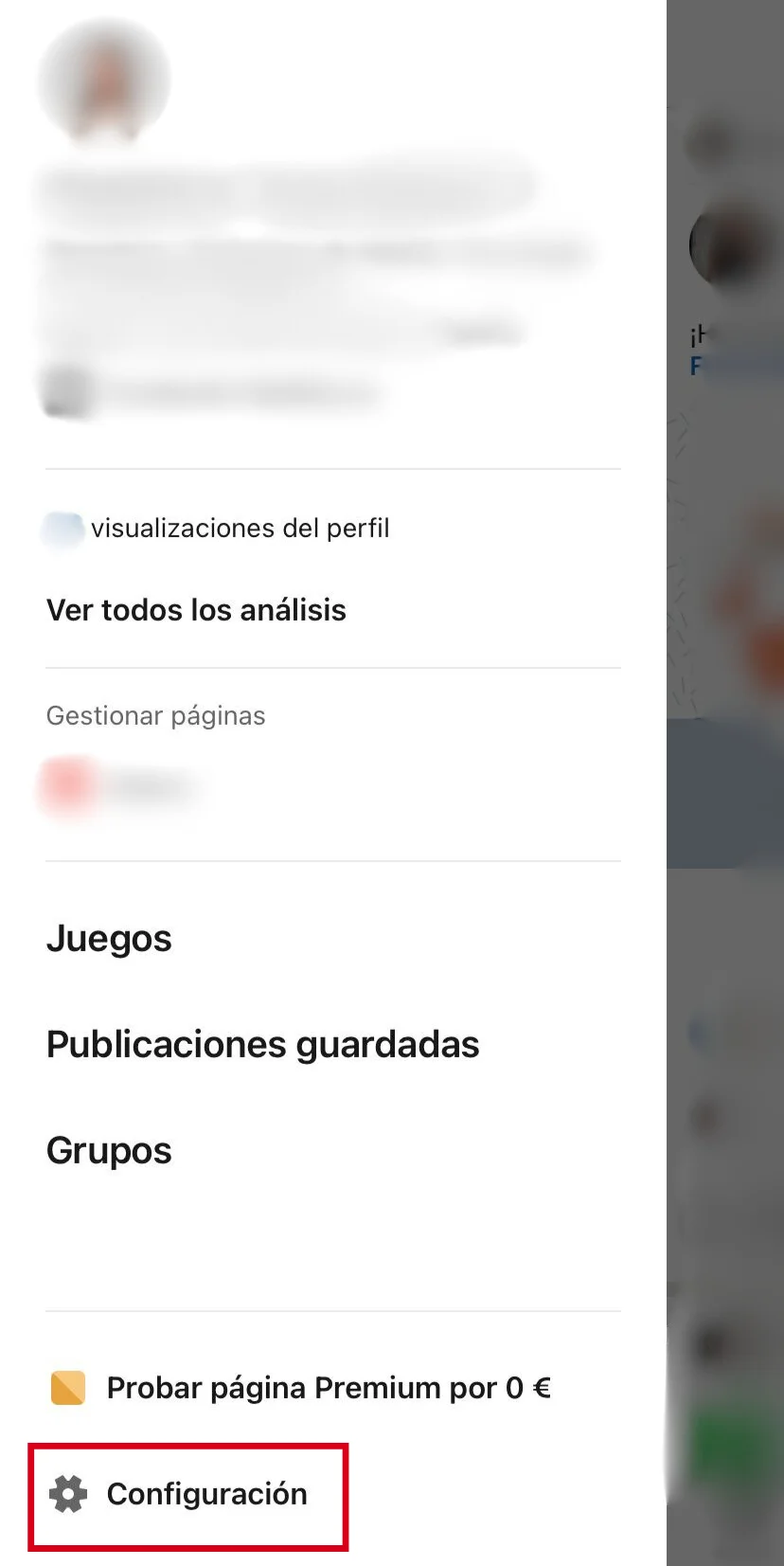

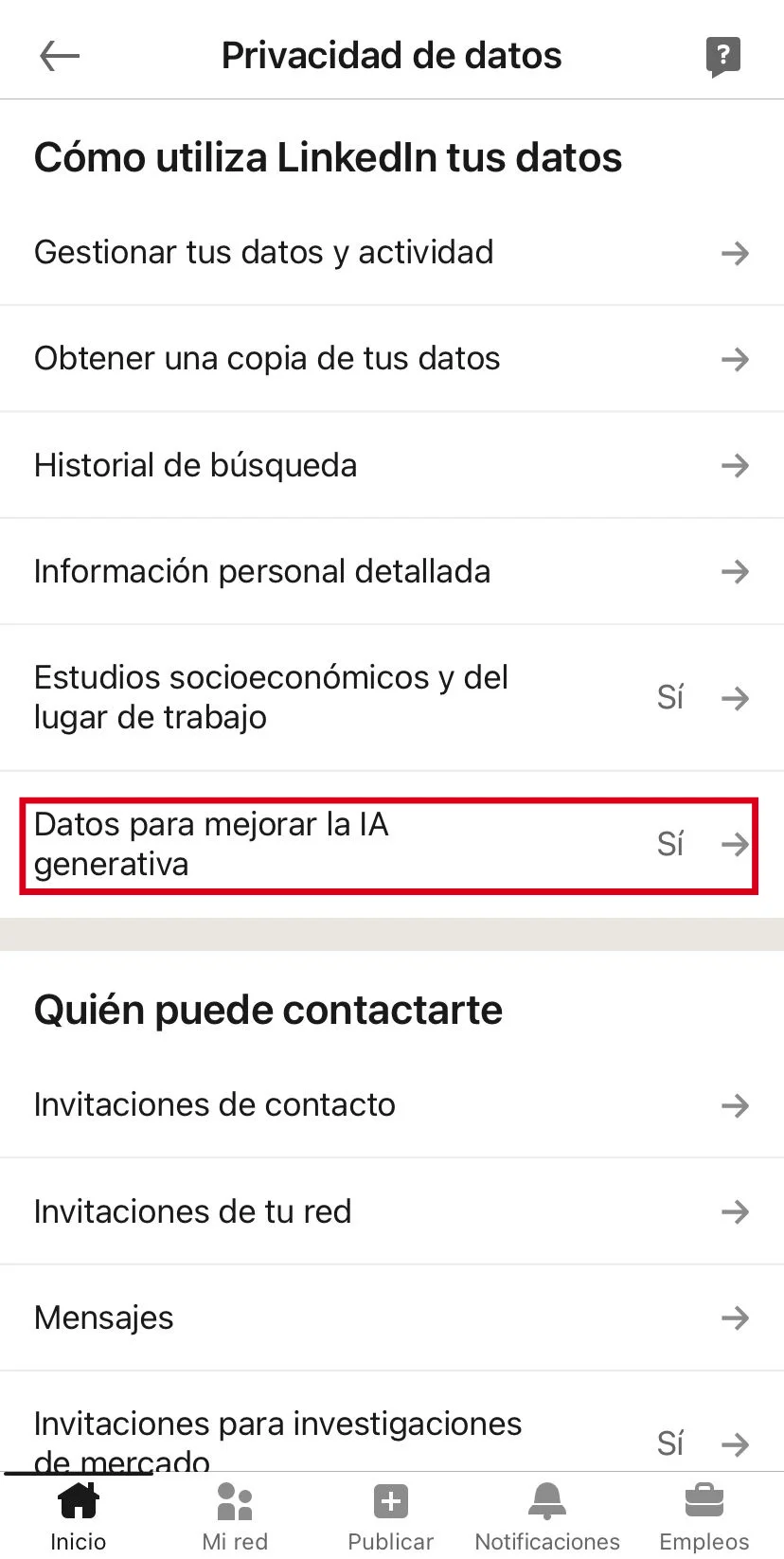

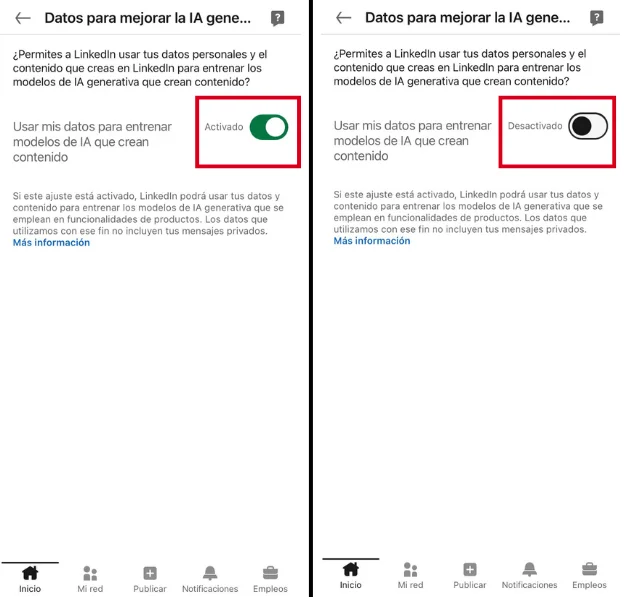

Para hacerlo, debemos:

Hacer clic sobre nuestra imagen de perfil y seleccionar ‘Configuración’.

En el apartado de ‘Privacidad de datos’, presionar ‘Datos para mejorar la IA generativa’.

Desactivar la opción ‘Usar mis datos para entrenar modelos de IA que crean contenido’.

El uso de nuestros datos para entrenar modelos de IA puede suponer riesgos de privacidad y seguridad

El anuncio de LinkedIn se suma a los que ya han hecho distintas empresas tecnológicas durante el último año. Sin embargo, que nuestros datos se usen con estos fines conlleva riesgos para nuestra privacidad y seguridad, ya que se puede extraer información sobre nosotros.

“En el momento en que nuestros datos forman parte de un modelo algorítmico, dejan de estar controlados por nosotros y quedan a merced de lo que genere este modelo”, indica Judith Membrives, presidenta de Algorights a Maldita.es. La experta en política digital añade que, además del conflicto sobre la protección de datos, estas decisiones generan un problema de consentimiento y confianza con las empresas.