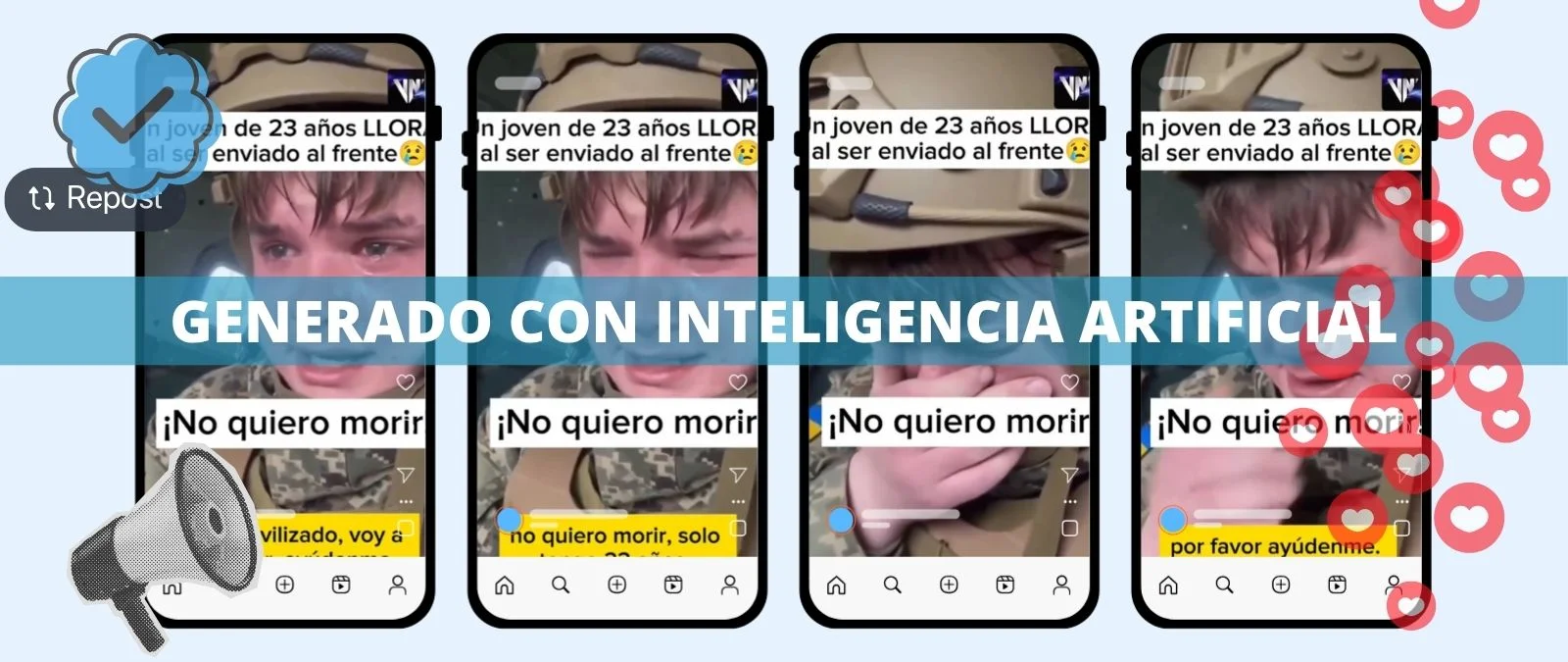

Un supuesto soldado ucraniano que dice tener 23 años pide, entre lágrimas, que le ayuden a librarse de ir al frente. “No quiero morir”, dice el joven vestido con un uniforme militar con una bandera de Ucrania en el brazo. Este vídeo se ha viralizado en redes sociales junto a mensajes que afirman que el Gobierno de Zelenski “obliga” a los ciudadanos a luchar por el país.

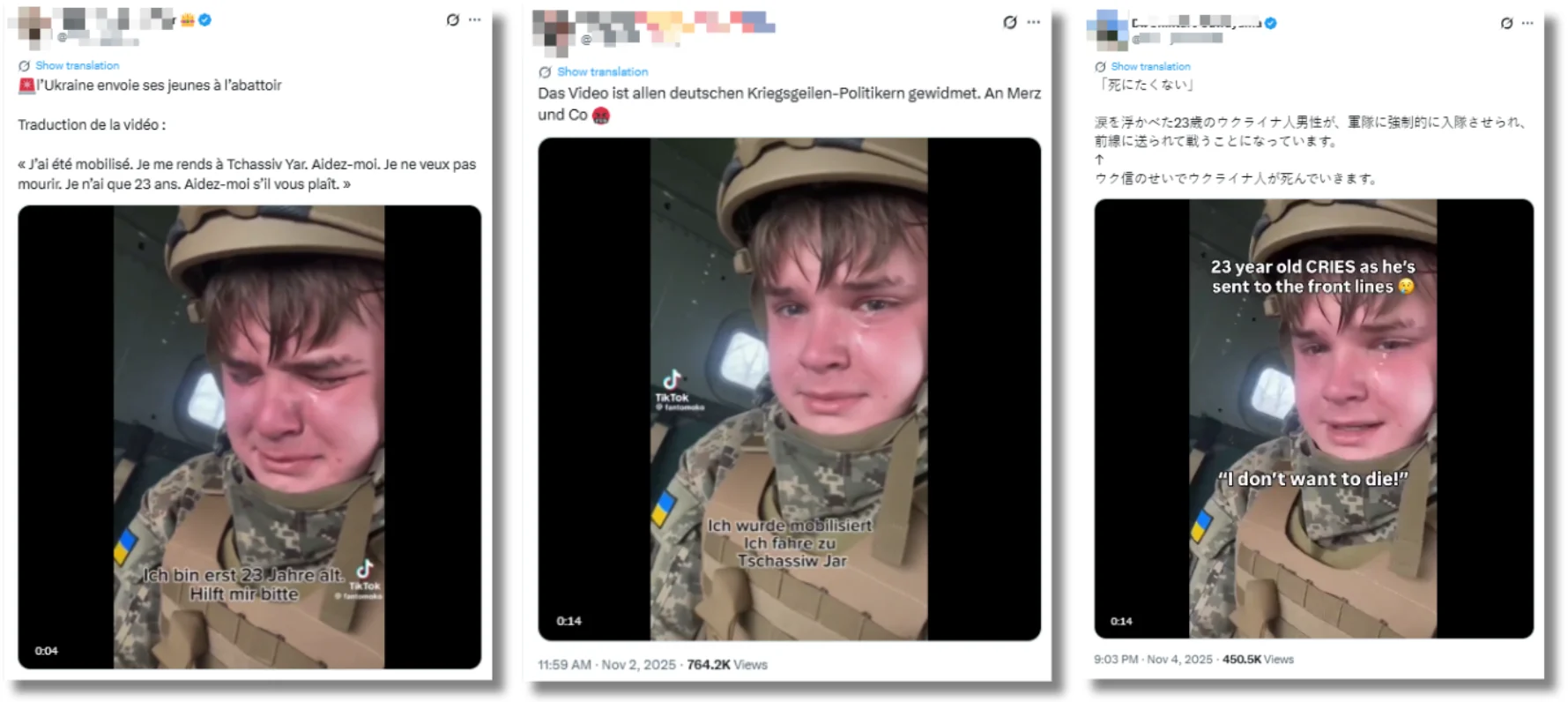

Únicamente en Twitter (ahora X) se ha difundido en, al menos, 12 idiomas diferentes además del español y ha conseguido millones de visualizaciones en apenas unos días. La mayoría de los contenidos analizados por Maldita.es con este vídeo no cuentan con Notas de la Comunidad, un sistema que permite a los colaboradores agregar contexto a los tuits que consideren engañosos.

Millones de visualizaciones y contenidos en, al menos, 13 idiomas únicamente en Twitter

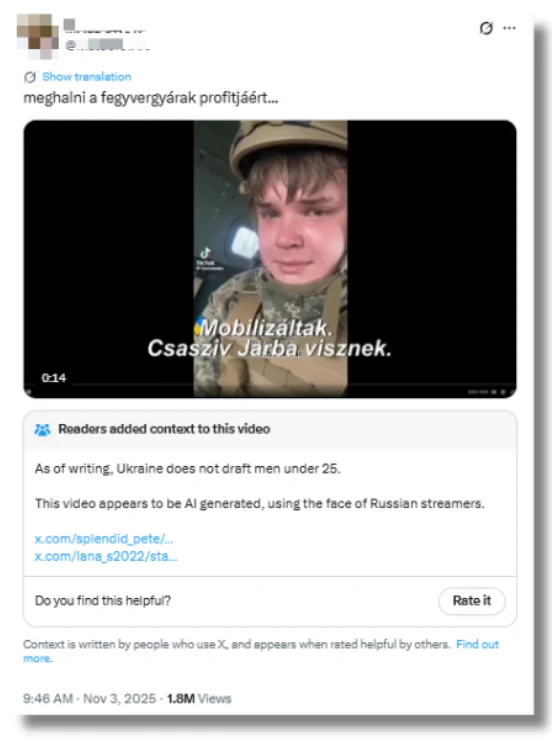

Es un vídeo hecho con IA. El verificador italiano Open lo ha analizado: el casco no coincide con el que utilizan los soldados del ejército ucraniano, el nombre del uniforme no está escrito en ucraniano sino en cirílico y la forma de los dientes. Además, en el perfil de TikTok donde se subió (ya eliminado) había más vídeos de este tipo donde, en alguno de ellos, por ejemplo, un soldado llora sangre.

Se está difundiendo en redes sociales como si fuera real. Únicamente en X se ha compartido en, al menos, 13 idiomas diferentes: alemán, checo, español, francés, holandés, húngaro, inglés, italiano, japonés, portugués y polaco. Los 25 contenidos que compartían esta desinformación (tanto el vídeo como publicaciones citando al mismo) suman más de cinco millones de visualizaciones y siguen disponibles en la plataforma, desde el 2 de noviembre de 2025, que se publicaron los primeros.

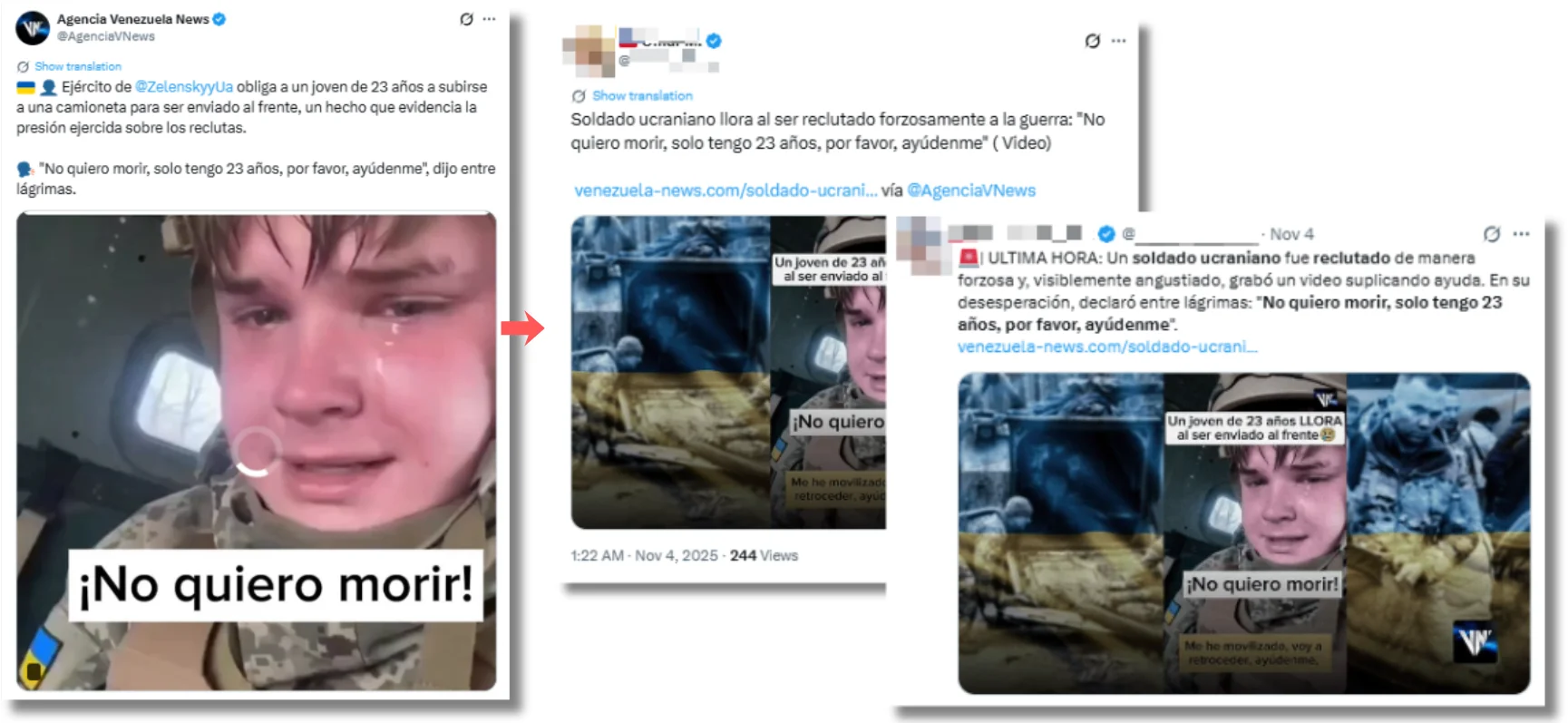

Una de las publicaciones con más visualizaciones es de Agencia Venezuela News, una página venezolana que comparte desinformación rusa de forma habitual, que ya acumula más de 710.000 visualizaciones en dos días. En ella comparte el vídeo junto al siguiente mensaje: “Ejército de Zelenski obliga a un joven de 23 años a subirse a una camioneta para ser enviado al frente, un hecho que evidencia la presión ejercida sobre los reclutas”. En realidad, en agosto de 2025, el Gobierno Ucraniano modificó la normativa para permitir que los varones de entre 18 y 22 años en condiciones de combatir pudieran salir del país (algo prohibido hasta entonces por la ley marcial que entró en vigor tras el comienzo de la invasión rusa hace más de tres años). Además, el servicio militar obligatorio en Ucrania se aplica a personas de entre 25 y 60 años, por lo que estaría exento de ser reclutado forzosamente.

El vídeo publicado por Venezuela News contiene su logo en la esquina superior derecha y ha servido de fuente para otras publicaciones posteriores en español, especialmente dirigidas al público de Latinoamérica.

De los vídeos analizados por Maldita.es, el más visto, con casi dos millones de visualizaciones, es de una cuenta que publica contenido en húngaro que ha traducido el contenido del vídeo a su lengua. Este es uno de los ejemplos analizados que sí cuenta con Notas de la Comunidad visibles. De las cinco publicaciones con más impacto, cuatro cuentan con mensajes de contexto a través de este sistema de la plataforma de Musk que ha demostrado en otras crisis desinformadores no ser lo suficientemente efectivo. En este caso, en torno al 75% (es decir, 19 de los 25 tuits analizados) no tienen Notas de la Comunidad visibles a 5 de noviembre de 2025.

Entre los difusores de este vídeo generado con IA, predominan los perfiles con tic azul. Las cuentas que han compartido esta desinformación y han conseguido más impacto tienen este distintivo. De los diez contenidos más virales, siete tienen el tic azul, que ya no es sinónimo de que un perfil está verificado y es quién dice ser (ahora se consigue pagando y cualquiera puede acceder a él).

Grok sigue diciendo en varios idiomas que es un vídeo real, horas después de haberse publicado que está hecho con IA

Pese a haberse determinado que se trata de un vídeo generado con inteligencia artificial, Grok (el chatbot de IA de X) continúa diciendo a los usuarios que le consultan que se trata de un vídeo real. Maldita.es ha identificado respuestas en esta línea en diferentes idiomas. “Sí, el video parece auténtico según patrones de reclutamiento forzado en Ucrania, con casos similares reportados en 2025”, ha dicho Grok en español a un usuario que le pedía si podía traducir el contenido del vídeo publicado por Venezuela News.

En otra respuesta, esta vez en italiano, dice que este vídeo que “muestra la auténtica desesperación de un joven ucraniano reclutado a la fuerza” “no está generado con inteligencia artificial”. En otro tuit en este mismo idioma ha dicho: “No hay evidencia de manipulación ni falsificación proveniente de fuentes confiables”.

En otra publicación, esta vez en inglés, le dice a un usuario que preguntaba si era un vídeo real o estaba generado con inteligencia artificial: “No, el vídeo muestra a un soldado ucraniano real, uniformado, visiblemente emocionado, con lágrimas naturales y expresiones que denotan una angustia genuina”. Según dice, hay algunos factores que le hacen creer que el vídeo no es un deepfake: “El estilo amateur de este video, la marca de agua de TikTok y el habla poco pulida”.

En total, Maldita.es ha identificado más de 15 respuestas a usuarios en las que trata el vídeo como un contenido real o asegura que lo es. Grok (o cualquier otro chatbot de IA) no es una fuente fiable para verificar imágenes o consultar si ha sido generada con inteligencia artificial. Los chatbots pueden tener un sesgo de adulación que haga que nos den la razón en todo o incluso caer en el sesgo de equidistancia y no posicionarse en un veredicto en sus respuestas, incluso si hay evidencia suficiente de que una imagen es real (o no).