No todos los contenidos que vemos sobre el huracán Melissa, el más potente registrado en 2025 a su paso por Jamaica y Cuba, son reales. Es el caso de los vídeos e imágenes en los que se ven tiburones por las calles, víctimas lamentándose por la catástrofe o el fenómeno visto desde un avión, generados con inteligencia artificial. Algunos han sido publicados antes de que el huracán tocara tierra y circulan sin etiquetas o con las marcas de agua de identificación de IA borradas, por lo que pueden despistar sobre su origen sintético. Sora, la nueva app de creación de vídeo de OpenAI, se ha utilizado para crear decenas de vídeos de este tipo.

En otras catástrofes, como la DANA en Valencia y el huracán Milton y Helene en Estados Unidos, también se ha usado IA generativa para crear contenidos falsos: las situaciones de emergencia suelen ser terreno fértil para la desinformación y la IA hace más fácil crear contenidos visuales de forma masiva. Los expertos consultados por Maldita.es advierten de que en este tipo de situaciones, estos contenidos pueden entorpecer la gestión de las autoridades y poner en riesgo la vida de las personas.

En redes sociales circulan contenidos creados con IA que supuestamente muestran la devastación del huracán Melissa

El huracán Melissa tocó tierra en Jamaica este martes 28 de octubre de 2025. Pero incluso antes de que su devastación fuera real, ya circulaban en redes sociales vídeos e imágenes creados con inteligencia artificial que supuestamente mostraban el paso del fenómeno natural, desinformando con antelación, aumentando el caos y poniendo en riesgo vidas de personas que podían actuar pensando que esa era la realidad.

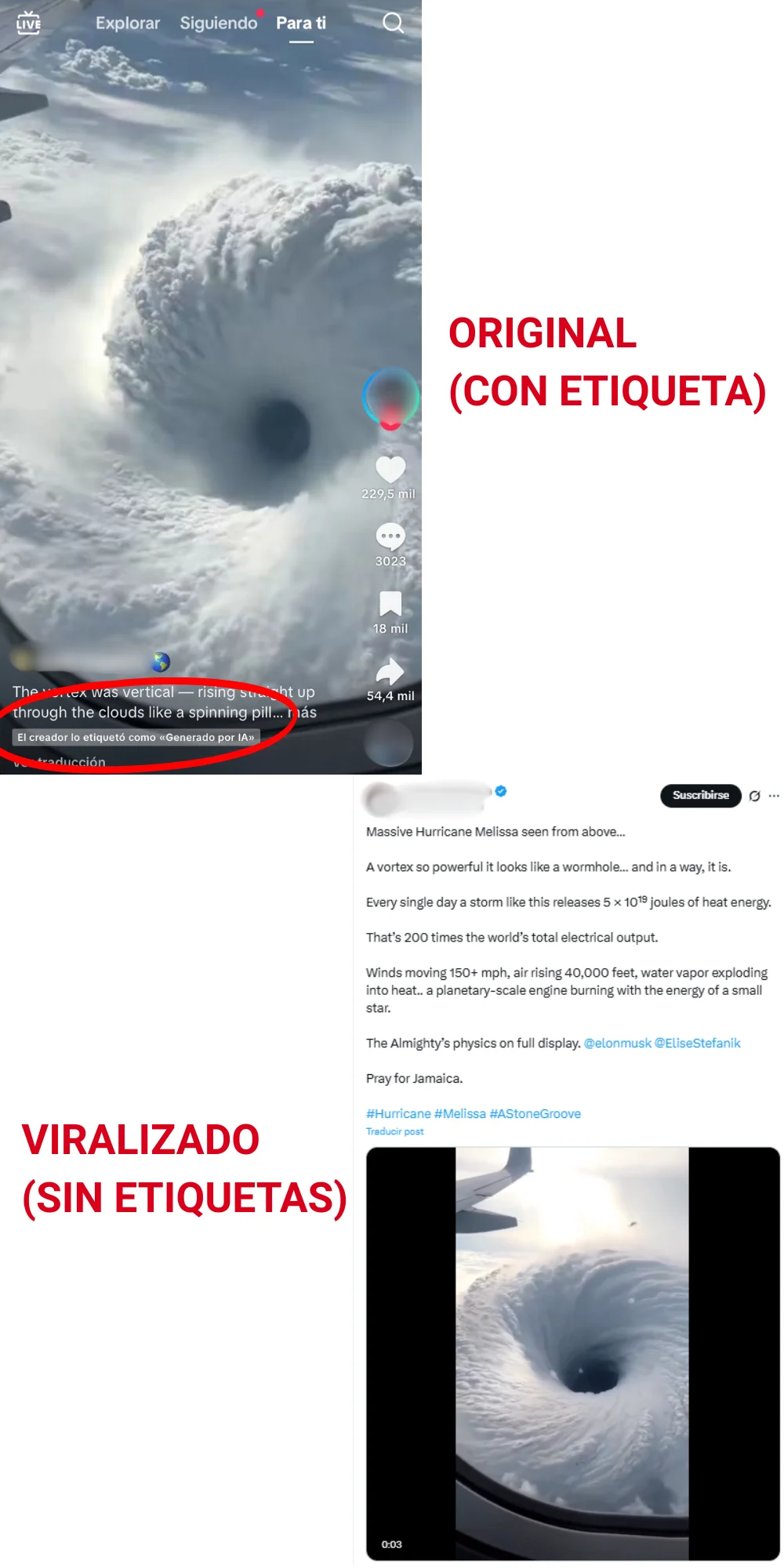

Algunos de estos contenidos se han viralizado sin etiquetas que revelen su origen sintético, lo que hace más difícil que los usuarios distingan si lo que están viendo es real o no. Es el caso de un vídeo que supuestamente muestra el huracán Melissa desde la ventana de un avión. Aunque originalmente se publicó en TikTok con la etiqueta de “Generado con IA” el 26 de octubre, días antes de que el huracán tocara tierra, se ha viralizado en X, TikTok, Instagram y Facebook sin etiquetas. Solo cuatro publicaciones que contienen este vídeo acumulan más de 5,6 millones de visualizaciones.

Otro caso es el de una imagen creada con IA que supuestamente muestra Jamaica destruida por la catástrofe. Se publicó por primera vez al menos cuatro horas antes de que el huracán tocara tierra en este país, según explican los verificadores de Lead Stories, miembros del European Fact-Checking Standards Network (EFCSN) al igual que Maldita.es, que han determinado que la imagen fue generada con inteligencia artificial. Rápidamente se viralizó en redes sociales sin etiquetas (aunque en X aparece con una nota de la comunidad que advierte que fue creada con IA).

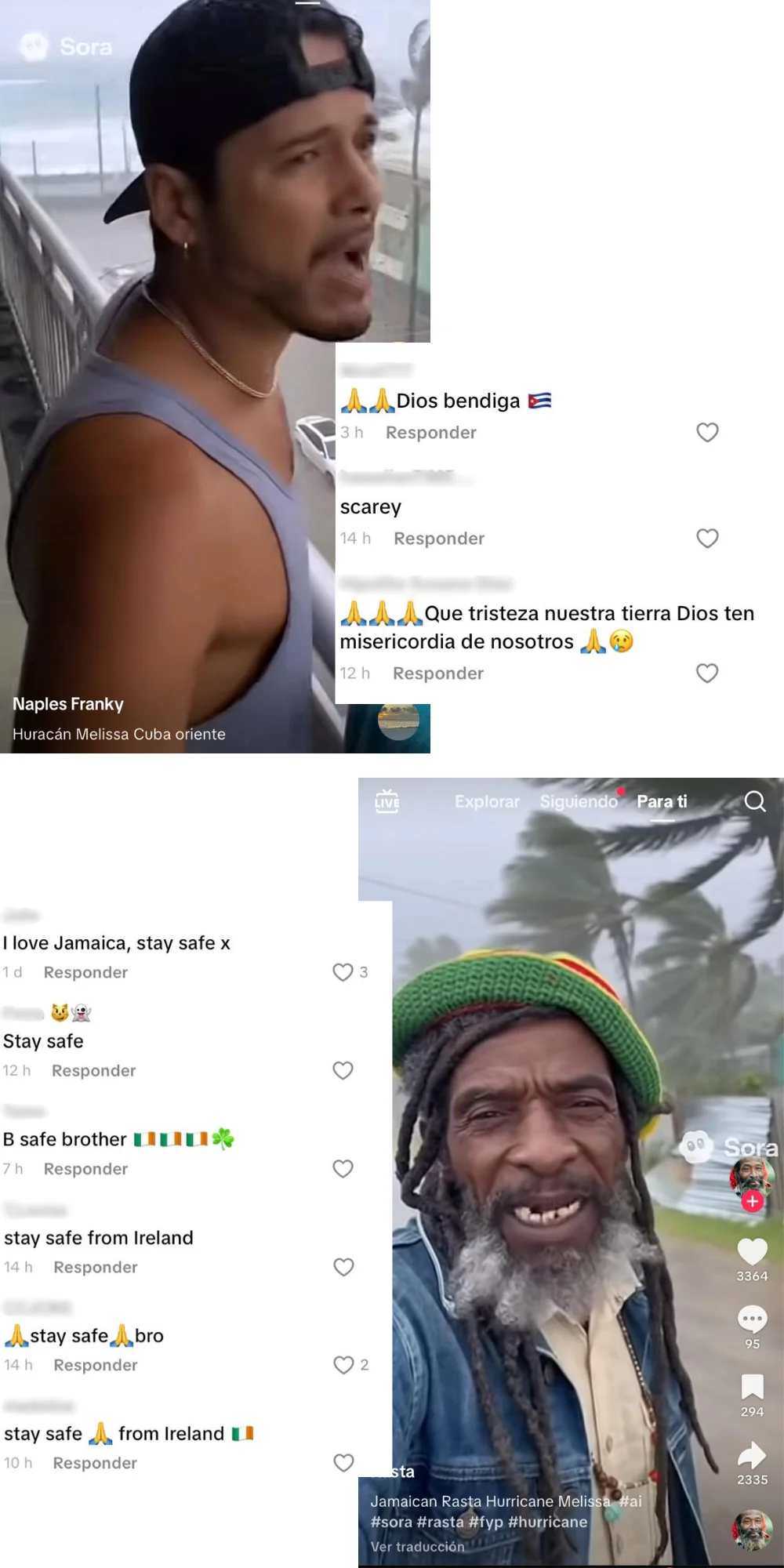

Sora, la nueva red social de OpenAI que permite crear vídeos con IA de forma rápida y fácil, está ayudando a que se generen estos contenidos de forma masiva. En redes sociales podemos encontrar decenas de vídeos con la marca de agua de Sora sobre la catástrofe, y en los comentarios hay usuarios que parecen creer que son reales. Es lo que sucede en vídeos creados con IA que muestran los testimonios de supuestos afectados por el huracán en Jamaica y Cuba.

En otros contenidos, las marcas de agua que dejan herramientas de creación de vídeo como Sora parecen haber sido eliminadas o difuminadas. Los verificadores de BBC Verify aseguran que este sería el caso de un vídeo creado con IA que supuestamente muestra cómo una persona graba desde un balcón a dos tiburones que nadan en las calles de Jamaica durante el huracán: “En la parte inferior izquierda del vídeo se aprecia una señal borrosa, probablemente una marca de agua que ha sido ocultada”.

Durante una emergencia, somos más vulnerables a la desinformación, y esto puede entorpecer la gestión de las autoridades y poner en riesgo a las personas

Las situaciones de emergencia, como un huracán, son momentos en los que los ciudadanos son más vulnerables a la desinformación: la incertidumbre hace que se vuelva más difícil reconocer qué es real y qué no. En este contexto, estos contenidos creados con IA se vuelven especialmente peligrosos, por ejemplo, cuando muestran sucesos que no han ocurrido. Este es el caso de los vídeos con IA de la devastación del huracán que fueron publicados antes de que este siquiera tocara la tierra.

“Cuidado con las imágenes generadas con IA que serán utilizadas por las cuentas de redes sociales para manipular tus emociones y monetizar tu atención”, advirtió el científico atmosférico Matthew Cappucci en su cuenta de X sobre el huracán Melissa. “Esta tormenta [Melissa] es de gran magnitud y probablemente causará daños catastróficos, y la información falsa socava la seriedad del mensaje del gobierno sobre la importancia de estar preparados”, afirmó a AFP Amy McGovern, profesora de meteorología de la Universidad de Oklahoma. ”En última instancia, este tipo de información falsa provocará pérdidas de vidas y bienes”.

Abel López, geógrafo experto en reducción del riesgo de desastres, señaló a Maldita.es que la información es esencial durante catástrofes como esta, ya que permite gestionar la incertidumbre de las personas para que sepan cómo protegerse. En ese sentido, la desinformación aumenta la incertidumbre, lo que puede hacer que las personas tomen malas decisiones que interfieran en los sistemas de respuesta y protección civil. Esto sucede porque los esfuerzos se destinan a enfrentar las situaciones que genera la desinformación, en lugar de “estar enfocados en garantizar que todas las personas estén lo más protegidas posibles”, explica.

Por su parte, Álvaro Morote, geógrafo y experto en gestión de riesgos naturales, afirmó a Maldita.es que fenómenos como estos tienen consecuencias graves, pero que estos vídeos pueden exagerarlas aún más: “Esto puede ser un arma de doble filo, ya que puede concienciar y alarmar a la población, pero con el riesgo de que no sea del todo cierto”. El geógrafo añade que la incertidumbre puede hacer que las personas duden en hacer caso a los mensajes oficiales, algo que puede poner en riesgo la vida de las personas, en especial cuando la información es fundamental para poder evacuar o protegerse.