¡Feliz sábado, malditas y malditos! La semana pasada te hablamos de nuestra investigación sobre violencia online contra menores (por si acabas de llegar o te lo perdiste, te la dejamos aquí). Esta, te contamos cómo la IA generativa sigue impactando en el ecosistema informativo, y provocando que este empeore y que haya nuevos formatos de desinformación. También, varios ejemplos de cadenas que circulan en WhatsApp y en otras redes sociales que hablan sobre nuestros datos personales, pero aciertan poco (más bien, nada).

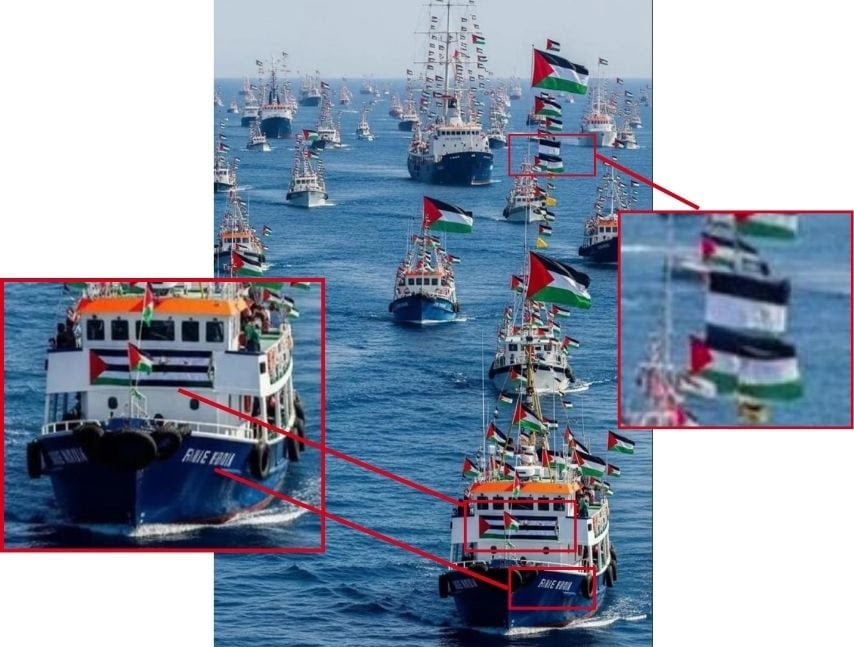

Flotilla hecha con IA

Las noticias sobre la Global Sumud Flotilla se suceden estos días y, como siempre, internet se llena de ruido y de contenidos que no son ciertos. La IA generativa contribuye a ello. Han circulado imágenes y vídeos supuestamente de la travesía de la flotilla hacia Gaza que no son tales. Algunas son de otros sucesos y están descontextualizadas, y otras están generadas con inteligencia artificial o editadas.

Para identificar cuáles están a todas luces creadas o manipuladas con IA, puedes fijarte en las banderas (con posiciones y formas muy parecidas, colores y franjas equivocadas, y algunas que directamente no están sobre ningún barco), en las letras (que no forman palabras legibles) y en los propios barcos (que parecen en algunos casos haber sido copiados y pegados). Aquí puedes ver todos los contenidos que hemos verificado.

Pero qué bazofIA es esta

Este y otros tipos de contenidos generados con IA están empezando a poblar internet de forma masiva. Hace un año identificamos que los resultados en buscadores de imágenes habían empezado a devolver contenidos generados con inteligencia artificial (lo que empeora los resultados y desinforma). Cuando se trata de contenidos de baja calidad, que son llamativos, repetitivos e incoherentes, reciben el nombre de AI slop, bazofia de la IA o “bazofIA”.

Pueden ser imágenes de Jesús esculpido en arena o hielo, o con el cuerpo formado de gambas, papel de burbujas o abejas. Vídeos terribles de niños en situaciones grotescas y sexualizadas o de animales en situaciones heróicas o conmovedoras. O incluso artículos, como uno sobre el supuesto suicidio del psiquiatra de Netanyahu, y otros en granjas de contenidos. Todos estos contenidos que se generan rápido, fácil y en masa, llenan redes sociales, buscadores y webs, provocando (lo estabas viendo venir) desinformación.

El objetivo de los AI slop es colarse en los algoritmos, feeds, búsquedas y recomendaciones; viralizarse; obtener clics y generar ingresos. Pero lo que también acaban provocando es una contaminación del ecosistema digital e informativo, la mierdificación de internet y, a la postre, desconfianza en los ciudadanos, porque cada vez es más difícil encontrar contenido de calidad en internet.

Al final, este tipo de imágenes y vídeos generados con IA muestran o relatan situaciones que no son reales, y se pueden aprovechar también para sembrar caos y desinformar. De hecho, la mitad de los españoles ya se muestra muy o bastante preocupado por el impacto de la IA en la desinformación, y al 75% les preocupa mucho o bastante que llegue un momento en el que no podamos distinguir si las imágenes o vídeos que vemos en internet son reales o no. Aquí tienes consejos para identificar los AI slop y que no nos la cuelen.

Miss agente especial IA

Para seguir aprendiendo sobre inteligencia artificial y que no nos la cuelen, hemos explicado un concepto del que por ahí a veces se leen maravillas mágicas, que de momento no lo son tanto: los agentes de IA.

Son sistemas que pueden (en teoría) tomar decisiones y ejecutar acciones de forma autónoma. Por ejemplo, podrían navegar por internet y reservar el tour mejor evaluado que encuentren para nuestro próximo viaje, o atender las llamadas de una empresa y gestionar citas o reuniones.

Se diferencian de los chatbots en bastantes cosas (no trabajan solo en modo preguntas y respuestas, hacen tareas más complejas), pero también se asemejan en otras: pueden ‘alucinar’ y equivocarse. Por eso, hay que supervisar las acciones y resultados de un agente de IA (como de cualquier otro modelo de IA). En cualquier caso, están en desarrollo y aún no hay implementaciones masivas, como te contamos aquí.

En cuatro bits

Ahora, LinkedIn. Ya son varias las empresas que anuncian en el último año que quieren usar nuestros datos personales para entrenar sus sistemas de inteligencia artificial. Meta (Instagram, Facebook, WhatsApp), Twitter (X) y, ahora, LinkedIn. La red social profesional de Microsoft ha avisado de que a partir del 3 de noviembre usará datos de los usuarios europeos, como la información de nuestro perfil y nuestro contenido público, para entrenar sus modelos de IA generativa. Si quieres oponerte (ojo, si no, usarán nuestros datos por defecto), aquí te contamos qué pasos seguir. Recuerda que que se usen nuestros datos para entrenar la IA puede poner en riesgo nuestra privacidad.

Meta AI y nuestros datos. Al hilo de esto, que no te la cuelen diciéndote que se puede evitar que estas compañías usen nuestros datos para su IA reenviando cadenas de texto en WhatsApp. No funciona así, pero es un bulo que vuelve y vuelve. En Instagram, Facebook y Threads circula la cadena “Adiós Meta AI” que asegura que la dueña de estas redes sociales, Meta, “es ahora una entidad pública” (falso), y que si no publicamos este texto se usará nuestra “información y fotos” (falso también). Compartir este texto no tiene ninguna validez legal sobre las condiciones que ya aceptamos al crear nuestras cuentas. Así es como puedes evitar que Meta use tus publicaciones, fotos e interacciones con su IA en Instagram y Facebook para entrenarla.

Erre que erre con las cadenas falsas sobre Meta. No es la única cadena que contiene información falsa: tampoco es verdad que por el aniversario de WhatsApp y reenviando esta cadena se pueda obtener un teclado arcoiris, nuevas fuentes y leer mensajes eliminados; ni que haya que pagar por usar Facebook o que publicar esta cadena evite que la red social pueda usar nuestras fotos.

Y erre que erre con la privacidad de WhatsApp. Pero si hay una cadena reenviada que se lleva la palma (nos la habéis enviado 700 veces), es la que asegura que la IA de Meta integrada en WhatsApp pueda acceder a ‘todos’ nuestros mensajes si no activamos la ‘Privacidad avanzada del chat’. Esto es falso: esta IA solo puede leer los mensajes en los que se la menciona (usando @Meta AI) o los que se comparten con ella. Si no queremos que otros usuarios puedan compartir nuestros chats con las funciones de IA de Meta, podemos evitarlo. Si te llega una cadena, comprueba lo que dice y, si tienes dudas, mándanosla directamente en WhatsApp al +34 644 229 319.

¿Tienes dudas sobre el día a día online? ¿Hay algún tema del mundo de la tecnología que te genere curiosidad y sobre el que te gustaría que ampliáramos información? ¿Quieres compartir algún tema interesante con la comunidad maldita? ¡Escríbenos a [email protected]! Y no olvides suscribirte.