Feliz sábado, malditas y malditos. ¿Cómo va el verano? Esperamos que muy bien. Mientras sobrevivimos al calor, no queremos que te pierdas una investigación que hemos publicado sobre cuentas de Twitter (ahora X) en las que se desinforma y engaña sobre inteligencia artificial. Las típicas promesas de que podemos hacernos ricos fácilmente desde casa, pero que siempre esconden riesgos, ahora suman IA como ingrediente para colárnosla.

Es una nueva estrategia que también usan webs fraudulentas que promocionan supuestas plataformas de inversión que dicen utilizar IA para conseguir grandes beneficios en poco tiempo. Timo. Para que no nos engañen este verano, te contamos esto y más cosas sobre contenidos generados con IA sobre animales y destinos turísticos que no son lo que parecen.

Tuits virales que prometen mucho y dan poco

Es agosto, hace calor, entras en X para pasar el rato y empiezan a salirte publicaciones con muchísimos likes que te aseguran que, cómodamente bajo tu ventilador, vas a ganar un montón de dinero. ¿Y cómo? Pues claro, utilizando inteligencia artificial, ese ente mágico del que no paras de oír hablar desde hace un par de años. ¿A quién no le va a gustar ganar dinero fácil? ¿Quién es el guapo o la guapa que puede dudar de eso? Pues tú, lector/a de Maldita Tecnología, porque detrás de esas promesas hay un montón de riesgos.

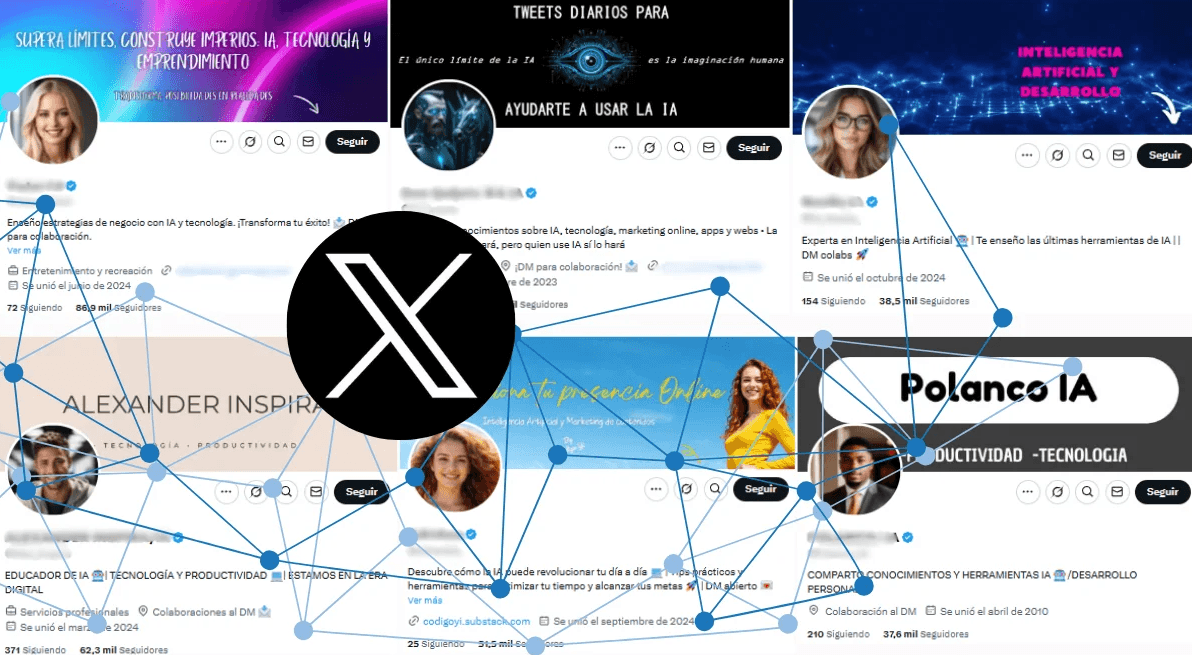

Todo empieza en la red social de Elon Musk, donde hace meses empezamos a detectar cuentas un poco turbias, con fotos de perfil que a todas luces están generadas con IA, y que tienen comportamientos similares. Sus descripciones incluyen por algún lado ‘IA’ (algunas directamente en el nombre), interactúan principalmente entre ellas y hacen clickbait sobre cómo generar ingresos con herramientas de IA. Mmmm, sospechoso: quien te promete hacer dinero de forma sencilla y rápida, siento decirte que seguramente está tratando de engañarte de alguna manera o de sacar algo a cambio.

Lo hemos investigado: hemos analizado 32 cuentas de X que publican en español contenidos virales sobre IA, 25 tienen el tic azul de los perfiles verificados en la plataforma, y todas en total suman más de 2,5 millones de seguidores.

Son muchas las ideas que sugieren estas cuentas para ganar dinero usando herramientas de IA, pero algunas se repiten. Uno de los consejos más comunes es crear un influencer con IA y monetizar su contenido en redes sociales para obtener, supuestamente, miles de dólares. En algunos casos sugieren hacer contenido pornográfico o muestran cómo usar vídeos de personas reales y reemplazar su rostro con el de nuestro influencer.

Otro consejo que se repite es usar chatbots de IA para crear contenidos (como eBooks, artículos, ofrecer servicios de traducción y redacción, y dejar reseñas en Amazon) y venderlos o monetizarlos. También crear “perfiles sin rostro” en YouTube y TikTok, un método que consiste, según estas cuentas, en descargar vídeos de otros usuarios, editarlos para convertirlos en vídeos cortos y subirlos desde nuestras cuentas para monetizarlos como si fueran nuestros. Muy ético todo, pero qué importa la ética si vas a ser millonario.

También aseguran que crear una cuenta de X sobre un tema específico (como inteligencia artificial, qué original), desarrollar el contenido con herramientas de IA y monetizarlo puede generarnos grandes ingresos. Curiosamente, lo mismo que están haciendo estas cuentas, porque muchas de ellas copian contenidos de otros usuarios. Aquí tienes los métodos con los que prometen dinero fácil y aquí una guía detalladísima para identificar a este tipo de cuentas (que a veces esconden ese tipo de tuits en hilos con otros contenidos). Nos interesa identificarlas para darle una doble pensada a lo que prometen, porque seguir sus consejos puede tener consecuencias muy negativas.

Desinformación, privacidad y riesgos legales

En general, siempre hay que desconfiar de los métodos que aseguran que podemos ganar miles de dólares trabajando desde casa y sin la necesidad de tener experiencia. Los expertos nos explican que ganar dinero monetizando contenido requiere de estrategia y conocimientos, y que no es tan fácil ni inmediato como usar una IA. Tanto ellos como los propios usuarios en redes sociales advierten de que estos métodos no dan los resultados prometidos. No es oro ni IA todo lo que reluce.

Pero ya no es solo que no vayamos a ganar dinero y vayamos a perder el tiempo, el problema es que mientras que estas cuentas ganan visibilidad e ingresos gracias a colaboraciones con las herramientas de IA que recomiendan y a nuestras interacciones, los usuarios que siguen estos métodos exponen sus datos personales y pueden ser víctimas de fraudes y robos.

Nuestro maldito Jorge Louzao, experto en ciberseguridad, lo analizó y nos dijo que “estos perfiles falsos enlazan a sitios que parecen estafas”, y nos recordó que compartir nuestra información con un sitio ilegítimo tiene varios riesgos: “Desde los más básicos de dar nuestros datos personales a un desconocido, hasta facilitar información financiera como una tarjeta bancaria que acabe en una estafa o robo”. Fuiste buscando oro… y no encontraste ni cobre.

De hecho, lo que puedes encontrar es una suspensión de tu cuenta, una multa o algo más grave: si seguimos los métodos que recomiendan usar el contenido de otros usuarios sin su autorización o suplantarlos, también podemos vulnerar leyes y las normas de las plataformas.

Por ejemplo, nuestro maldito Miguel Vieito, jurista e investigador en derecho, advierte que “crear una cuenta con IA podría ser contrario a los términos de uso, pero también ilícito por vulnerar las normas de propiedad intelectual”. Como te contaba arriba, una de las sugerencias de estas cuentas es crear contenido sexual con IA de personas sin su consentimiento. Si esto a alguien puede remotamente parecerle buena idea, quizá se le quite al saber que conlleva una vulneración de derechos y puede ser un delito.

Y suma y sigue: no solo podemos poner en riesgo nuestra privacidad o vulnerar leyes, también exponer a otras personas. Porque algunas de las herramientas promocionadas por estas cuentas de X pueden implicar riesgos para la salud de los usuarios que las utilizan, como un programa que ofrece chatbots que prometen cumplir las funciones de un psicólogo o nutricionista, o actuar como un amigo, familiar o pareja, peligros de los que ya te hemos advertido en Tech en un clic, y a los que estaría genial no contribuir.

Y aún hay otro riesgo más latente, el nexo común de todo lo que hacemos en Maldita: la desinformación. Entre las publicaciones de estas cuentas también podemos encontrar hilos con datos curiosos, hechos históricos y de actualidad (la mayoría copiados de otros usuarios), que en varios casos contienen desinformación, como imágenes creadas con IA o descontextualizadas que se presentan como reales. Gracias al gran número de seguidores que cosechan, hacen que estos contenidos desinformadores lleguen a más personas.

Resumiendo: que si en X (o donde sea) te encuentras con este tipo de cuentas que publican en español contenidos sobre cómo usar herramientas de IA para generar ingresos de forma rápida y fácil, ojo cuidao. Sospecha de los perfiles con imágenes de perfil con indicios de haber sido creadas con IA y publicaciones copiadas de otros usuarios, especialmente si te prometen miles de dólares con poco esfuerzo (de esto sospecha siempre, te lo prometan en X o en la calle).

Siempre, antes de probar cualquier herramienta que alguien te recomiende, comprueba que se trata de páginas fiables y seguras. Lo mismo si quieres comprar alguno de los productos que venden, unirte a uno de sus grupos de Telegram o newsletters, porque puedes estar exponiendo tus datos. También ten cuidado si te planteas seguir sus consejos para crear contenidos y monetizarlos: puedes acabar infringiendo una ley o las normas de las redes sociales. Y ayúdanos a llegar a más gente compartiendo nuestra investigación, esta newsletter o este vídeo donde lo resumimos, porque juntos es más difícil que nos la cuelen.

En tres bits

¿Un paraíso hecho con IA? No solo nos la intentan colar con promesas sobre hacernos ricos con inteligencia artificial, también puede que nos llevemos un chasco si este verano hacemos un viaje… y el destino no es como pensábamos. En redes sociales y sitios web circulan contenidos creados con IA de destinos turísticos y sitios históricos que se comparten como si fueran reales. Lo fuerte es que algunas de estas imágenes son publicadas por perfiles y webs que se dedican al turismo o al contenido sobre viajes. Ok, no es tan grave que un turista se lleve a casa una decepción, pero sí lo es que este tipo de contenidos puedan desinformar, generar falsos relatos y acabar alterando la percepción sobre un lugar. Especialmente porque esto hace que los buscadores e internet en general se llenen de contenido de poca calidad, y cada vez sea más difícil distinguir qué es real y qué no. La mierdificación, a la orden del día con la IA.

¿Un delfín salvando a un leopardo en alta mar? Lo de arriba no solo sucede con imágenes de lugares y paisajes, también con contenidos en los que se representa a animales en situaciones heróicas o conmovedoras. Hemos pasado de las imágenes en tropel de gatitos a vídeos en los que un oso polar bebé se reúne con su madre o a un canguro le impiden subirse a un avión. Aunque pueda parecernos divertido y entrañable volvemos al problema de antes: internet se llena de situaciones que en realidad no han pasado y que se nos presentan con aspecto hiperrealista. Porque ese es el problema, no es lo mismo ver en unos dibujos animados o un cómic cómo un leopardo se sube a un delfín para no ahogarse, que visualizarlo en un vídeo que parece y nos presentan como algo real. Aquí, los expertos dicen que esto puede desinformar, generar falsas narrativas y alterar nuestra percepción sobre estos animales y su ecosistema. Al final, esto interfiere en el conocimiento ecológico y, lo que parece inocente, a la larga puede tener un impacto.

¿Esta imagen es real, Grok? Puede que cuando nos topemos con alguna de estas imágenes y no sepamos si son verdad o están generadas con IA tengamos la tentación de acudir a la propia IA a preguntarle. Estamos viendo cómo se usan Grok, ChatGPT y Gemini para esto, pero utilizar un chatbot de IA para verificar si una imagen es real no es una buena idea: pueden cometer errores y ‘alucinar’ si quieren respondernos pero no tienen información suficiente. Además, están influenciados por sus sesgos, como el de adulación (por el que puede que, según cómo les hagamos la pregunta, nos dé directamente la razón) o el de equidistancia (para evitar posicionarse). Ha habido varios ejemplos, tristemente de actualidad, de niños y niñas desnutridos y buscando comida en Gaza. Grok contestó que eran imágenes de hace años en otros contextos, pero no; lamentablemente son actuales. Aquí te contamos los detalles con más ejemplos, y también consejos para diferenciar los contenidos creados con IA de los reales.

¿Tienes dudas sobre el día a día online? ¿Hay algún tema del mundo de la tecnología que te genere curiosidad y sobre el que te gustaría que ampliáramos información? ¿Quieres compartir algún tema interesante con la comunidad maldita? ¡Escríbenos a [email protected]! Y no olvides suscribirte.