Nada de borrar vídeos porque sí o reducir la visibilidad de una publicación sin que el usuario lo sepa: existe una obligación en la Unión Europea por la que las plataformas digitales deben enviar al usuario afectado una justificación detallando los motivos por los que decidan restringir su publicación. Una norma que aplica desde agosto de 2023 para las grandes plataformas, como Facebook o Instagram, y desde el 17 de febrero de 2024 para el resto de plataformas digitales de la UE.

Este deber proviene de la Ley de Servicios Digitales, un conjunto de normas de la Unión Europea para regular el espacio digital que las principales plataformas online, redes sociales y motores de búsqueda deben cumplir. A parte de esta medida de transparencia, el reglamento contempla también obligaciones relacionadas con mecanismos de notificación o transparencia algorítmica, y aborda la moderación de contenidos en redes sociales, es decir, el monitoreo de las plataformas sobre las publicaciones que sus usuarios comparten y la aplicación de unas normas concretas.

Las plataformas deben hacer una ‘declaración de motivos’ si eliminan algún contenido o inhabilitan acciones

Las plataformas pueden decidir actuar sobre una publicación en base a la ley vigente, por ejemplo si comparte pornografía infantil, contenido con protección intelectual o contenido terrorista, y en base a sus condiciones generales. Estas son normas propias creadas por estas empresas privadas en las que determinan qué se puede compartir y qué no en sus servicios, y también determinan qué mecanismos existen para restringir las publicaciones que no siguen sus guías.

Con el fin de aumentar la transparencia y evitar decisiones injustificadas o discriminatorias por parte de estas empresas, la Ley de Servicios Digitales obliga a las plataformas digitales a proporcionar “una declaración de motivos clara y específica” (Artículo 17). Es decir, en el caso de que una plataforma como TikTok, YouTube o Instagram elimine o reduzca la visibilidad de una de tus publicaciones, deberá obligatoriamente explicarte el por qué de su decisión y de una forma entendible.

La misma obligación aplica si se suspende la monetización de un contenido, si se inhabilita alguna acción (o todas) dentro del servicio (ej. no permitir publicar) o si se elimina la cuenta entera.

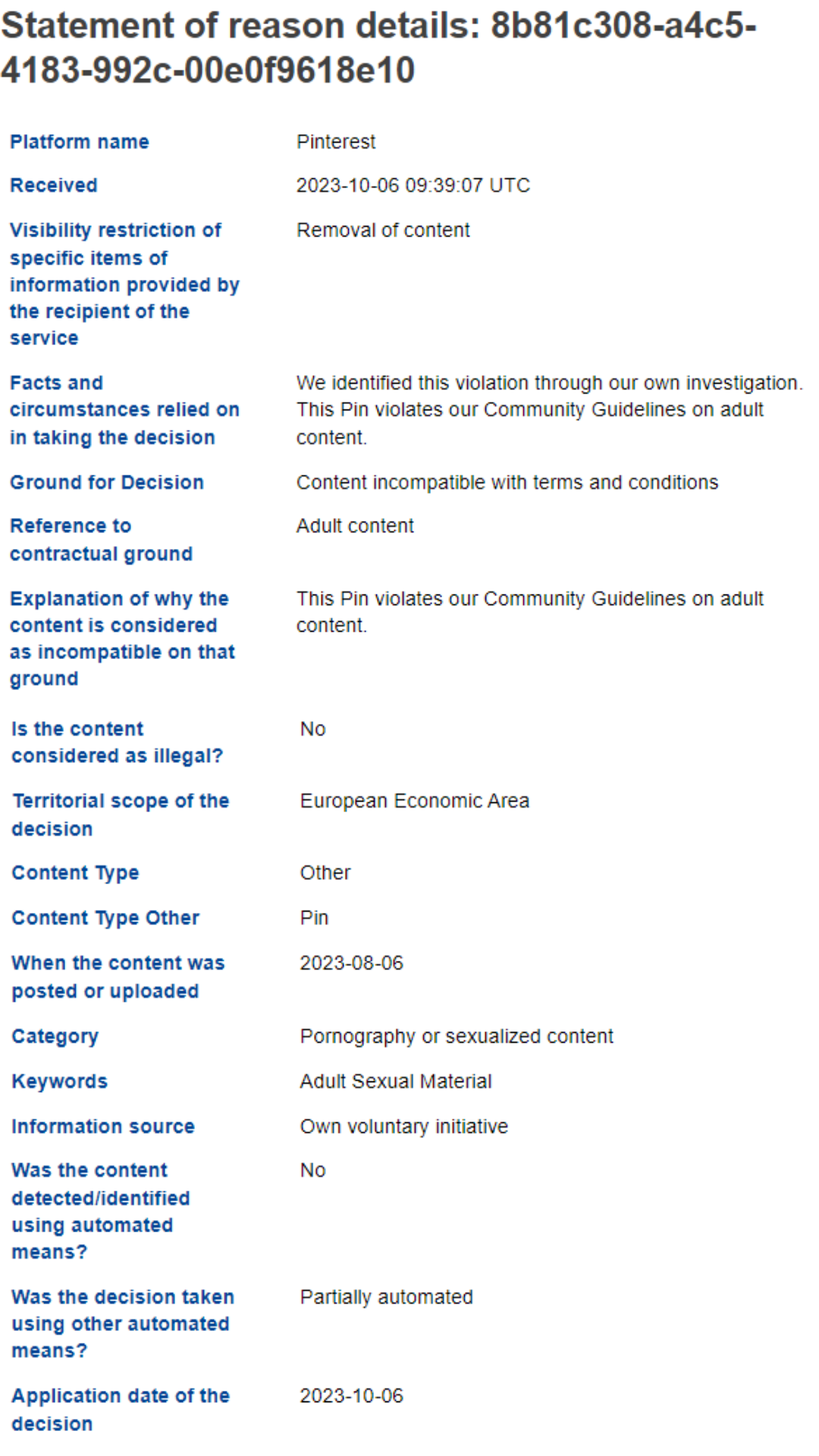

Esta declaración debe incluir en qué se basa la decisión y qué conlleva

Para no dejar lugar a dudas, el mismo artículo de la DSA detalla la información que, como mínimo, debe constar en esta “declaración de motivos”:

Qué conlleva la decisión (la eliminación de la publicación, la suspensión temporal de la cuenta…) y, si aplica, durante cuánto tiempo y en qué territorio.

Hechos y circunstancias en que se basa la decisión, incluida si es una respuesta a la notificación de otro usuario o por iniciativa propia de la plataforma.

Si la decisión ha sido adoptada de forma automatizada.

En el caso de tratarse de un contenido ilegal, en base a qué fundamento jurídico y cuál es la relación con la publicación.

En el caso de ir en contra de las condiciones generales, en base a qué fundamento de estas condiciones y cuál es la relación con la publicación.

Qué hacer si no estás de acuerdo y quieres recurrir la decisión.

Sobre este último punto, la DSA especifica tres opciones disponibles para los usuarios para impugnar estas decisiones sobre sus contenidos: presentar una queja directa a la plataforma, pelar ante un órgano de disputa extrajudicial certificado por cada país o acudir a los tribunales.

Estas declaraciones de motivos se recogen en una base de datos de transparencia pública que podemos consultar

Este ejercicio de transparencia no es solamente entre el usuario y la plataforma digital, sino con la Comisión Europea también. Las plataformas digitales deberán comunicar a la Unión Europea las decisiones, junto a su “declaración de motivos”, que tomen con respecto a las publicaciones compartidas dentro del territorio de la UE.

Cada una de estas decisiones de moderación de contenidos se vuelcan en una base de datos pública (Art. 24 (5)) que lleva disponible desde el 26 de septiembre. Según la Comisión Europea, su objetivo es “garantizar la transparencia y el escrutinio de las decisiones” y “controlar la difusión de contenidos ilegales y dañinos en línea” por lo que permite filtrar por categorías específicas, ver estadísticas o descargar datos en formatos ‘legibles por máquina’ para llevar a cabo mejores análisis.

Estos son datos del número de decisiones registradas en su primera semana de uso (26 de septiembre al 2 de octubre 2023):

La cifra de entradas disponibles en la base de datos alcanzó prácticamente los 23 millones en 7 días tras las contribuciones de 16 plataformas digitales.

El 99,6% de las decisiones en moderación de contenido son en base a los términos y condiciones de la propia plataforma (por ejemplo, promover el acoso o bullying o retos o actividades peligrosas); el otro 0,04% por tratarse de contenido ilegal.

TikTok es la plataforma que más decisiones ha registrado seguida de Pinterest y Amazon. Estos datos pueden ser reflejo de la cantidad de usuarios de la UE en estas plataformas (125 millones, 181 millones o más de 45 millones de usuarios activos mensuales respectivamente), de sus procesos o mecanismos de moderación o de su adaptación a esta obligación de compartir con la Comisión sus decisiones.

La eliminación de publicaciones es la acción de moderación más repetida entre las registradas.

Algo más de 35 mil registros corresponden a contenidos en español.

Alrededor del 38% de las decisiones no entran en ninguna de las categorías temáticas creadas por la Comisión sino que se refieren a otros aspectos de sus términos y condiciones.

Lo cierto es que el valor de esta herramienta dependerá del interés de las plataformas en proporcionar información de forma regular y sobre todo detallada, que permita comparar decisiones y plataformas.

Hemos actualizado este artículo a 16/02/2024 para incluir que desde el 17 de febrero la DSA aplica para todas las plataformas digitales de la Unión Europea.