Las historias para no dormir ahora nos roban el sueño en TikTok. “Morí al caer en un pozo que se había construido sin permiso”. “Desaparecí adentro de mi propia habitación y mi cuerpo fue encontrado sin vida 9 días más tarde”. “Tenía un destino brillante en el mundo del boxeo pero mi vida y carrera fueron destruidas”. Estos son algunos de los vídeos que circulan en esta red social que cuentan historias de crímenes, fallecimientos, desapariciones, sucesos extraños o personajes históricos.

Todos los contenidos comparten características. Se trata de vídeos creados con inteligencia artificial a partir de una imagen generada con IA que se anima para dar movimiento al rostro. La voz está automatizada y no es real (en algunos vídeos recuerda a Loquendo). Y quizá lo más desconcertante: en todos ellos se narran en primera persona historias reales (más o menos exageradas) de sucesos trágicos o misteriosos, como si las víctimas nos los contaran directamente. Dentro de esta tendencia hay vídeos sobre supuestas violaciones de animales a mujeres, aunque en este caso todo indica que los sucesos que se cuentan no son reales.

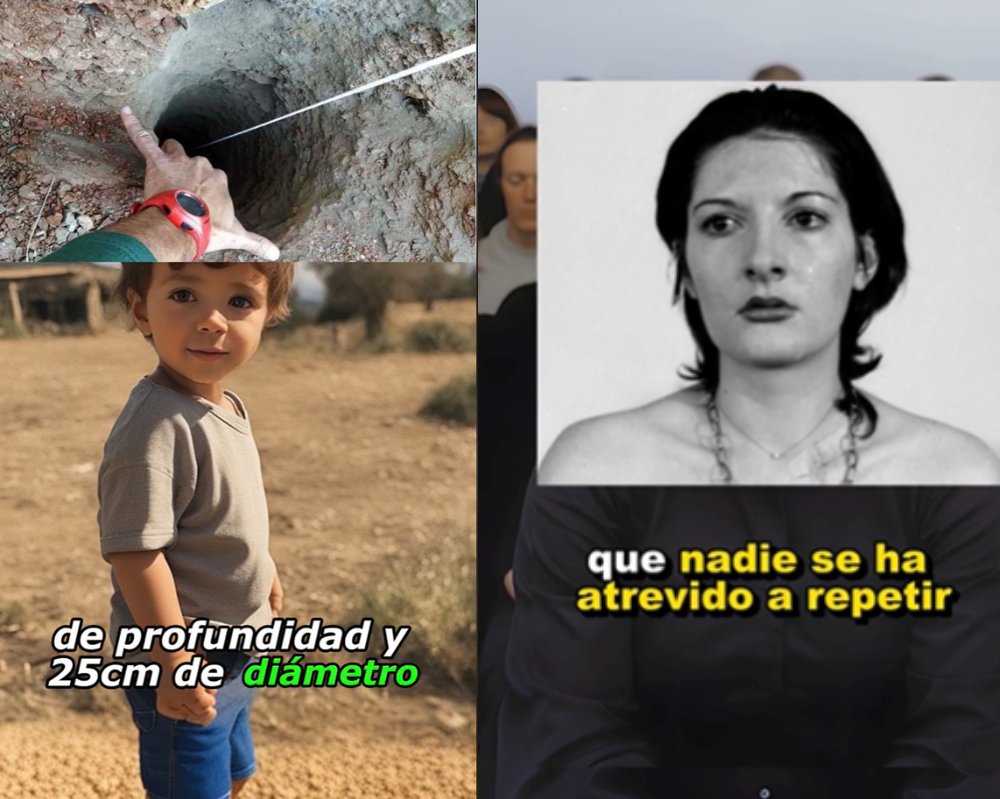

Estos vídeos cuentan con millones de reproducciones y hay cuentas en TikTok especializadas en difundirlos. En las descripciones de estos perfiles se definen como “Historias relatadas por sus protagonistas” o “Historias contadas por los que la vivieron”. En muchos de los casos, las historias que se cuentan sucedieron a menores de edad. Por ejemplo, un vídeo sobre el fallecimiento de Julen Roselló, el niño que cayó por un pozo, tiene más de 800.000 reproducciones.

Si se realizan sin consentimiento, este tipo de contenidos pueden constituir una intromisión ilegítima en la protección del honor, la intimidad y la propia imagen. En el caso de los menores de edad, los expertos consultados por Maldita.es coinciden en que se debe prestar especial atención a sus derechos, cuya protección está reforzada por la ley.

Los vídeos que narran sucesos en primera persona y se difunden en TikTok están creados con inteligencia artificial

En TikTok hay una nueva tendencia cuando menos desconcertante. Se trata de cuentas que comparten vídeos en los que, mirando a cámara, una persona te cuenta un suceso de su vida. Todos estos contenidos comparten características. Son historias truculentas sobre crímenes, fallecimientos, desapariciones y sucesos extraños, que se cuentan con palabras llamativas y trágicas. Buscan, claro, que no apartes la vista. En otras ocasiones, los personajes narran episodios de la vida de personajes históricos o famosos.

Aunque las historias se cuentan en primera persona, no hay personas reales en esos vídeos. Lo que aparecen son imágenes generadas con inteligencia artificial (todas con el mismo tipo de acabado, rostros simétricos, pieles de porcelana, pupilas muy circulares) en las que el cuerpo permanece estático y la cabeza, los labios y los ojos se mueven. Hay detalles concretos de las imágenes que indican que están generadas con IA, como manos deformes. Estas imágenes en movimiento generadas con IA se intercalan y superponen con fotografías reales de los sucesos que se están contando.

El otro detalle es la voz. En los vídeos los protagonistas cuentan la historia con voces automatizadas generadas también con inteligencia artificial (es lo que se conoce como voces sintéticas). Por tanto, estos contenidos están creados con IA y no son reales, algo que en algunos casos se avisa y en otros no. Los vídeos se agrupan bajo hashtags como #aistorytelling en inglés (16,2 billones de visualizaciones), y en castellano suelen usar otros como #casosdelavida (897,1 millones visualizaciones), #historiareal, #historiasreales o #casosdelavidareal.

Las historias que se cuentan son de personas reales, en muchos casos de menores de edad

Aunque los vídeos están creados con imágenes falsas, las historias que hay detrás sí son reales, aunque a veces están más o menos adornadas o exageradas, y en algunos casos indican datos incorrectos. Uno de los vídeos más virales (ahora eliminado, pero que llegó a acumular 67 millones de reproducciones) fue sobre Suleman Dawood, el hijo de 19 años del millonario paquistaní Shahzada Dawood, que falleció junto a su padre en la expedición submarina al Titanic.

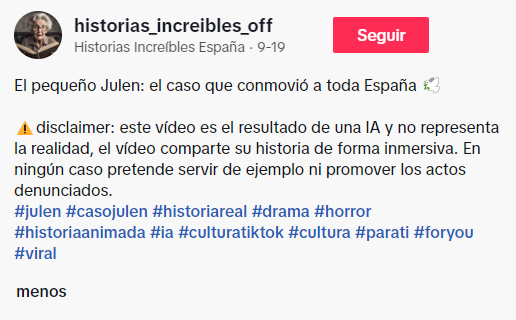

Hay vídeos de todo tipo, como la historia del experimento de la artista serbia Marina Abramović o del derrame cerebral del boxeador Prichard Colón. Otro habla del fallecimiento de Enrique López Sáez, un joven que participó en el programa de televisión First Dates. En los comentarios, los usuarios señalan errores en lo que se cuenta y se cuestionan el sentido del vídeo. Recordemos que se presenta como si el propio Enrique, que ha fallecido, contara a cámara su historia.

Muchos de estos vídeos cuentan historias de menores de edad y de niños y niñas que fallecieron. El vídeo sobre Julen Roselló; la desaparición y fallecimiento de Paulette Gebara, una niña mexicana de cuatro años; la historia de Terry Jo Duperrrault y los asesinatos en el velero Bluebelle; y de Michael Dumas, un adolescente que contrajo anquilostomas en la playa. No son historias precisamente amables, pero con el tono y el dramatismo consiguen enganchar a la gente y sumar millones de reproducciones.

Dentro de esta tendencia también hay vídeos de mujeres que cuentan cómo, supuestamente, han sido agredidas sexualmente por animales, aunque en este caso todo indica que los sucesos que se cuentan no son reales.

¿Es legal que se haga un contenido contando la historia real de alguien en primera persona sin su permiso?

Aquí viene el quid de la cuestión. Como hemos dicho, estos vídeos representan al protagonista con una imagen generada con inteligencia artificial y ponen en una voz falsa su historia, como si la contara a cámara. ¿Esto es legal hacerlo sin pedir consentimiento al protagonista, que no ha buscado serlo? No existen leyes concretas sobre estos usos de la tecnología, pero la legislación actual se puede aplicar.

Santiago Mediano, experto en propiedad intelectual, robótica e inteligencia artificial y presidente de Santiago Mediano Abogados, explica a Maldita.es que “el bien jurídico protegido por el derecho a la propia imagen no es solo la exteriorización de la figura humana, sino algo mucho más amplio, alcanzando a rasgos y aspectos de su personalidad y su historia biográfica”. Es decir, que aunque no se esté usando directamente en algunos casos la imagen de la persona (en otros sí porque se ponen imágenes reales) y aunque las imágenes falsas no se parezcan tanto a las personas que representan, este tipo de vídeos supondrían una intromisión ilegítima en el ámbito de protección del honor, la intimidad y la propia imagen (como recoge la Ley Orgánica 1/1982, de 5 de mayo).

Concretamente, el abogado explica que la ley considera intromisiones ilegítimas “la utilización del nombre, de la voz o de la imagen de una persona para fines publicitarios, comerciales o de naturaleza análoga”. Por tanto, “la persona o sus sucesores [si se trata de la historia de un fallecido] podrían autorizar o prohibir el uso y publicación de la creación en medios de comunicación social, por ejemplo, TikTok”.

Hay excepciones. Están las llamadas “caricaturas, concepto que, bajo ciertas circunstancias, podría dar cobertura a estas creaciones”, y que “son toleradas por el ordenamiento jurídico dentro de unos límites”, señala Mediano. También podría haber excepciones como que sean vídeos sobre una persona pública, en los que en el uso de imágenes podría prevalecer el derecho a la información. En cualquier caso, Jorge Campanillas, abogado especializado en protección de datos de Iurismática Abogados, recalca a Maldita.es que este caso es diferente porque no lo está contando alguien como periodista o como un medio de comunicación, sino que “se están haciendo pasar por una persona y contando su vida en primera persona”.

Al final, “como son historias reales está vigente el derecho al honor, a la intimidad y a la propia imagen, y siempre debe haber cierto consentimiento”, resume Jorge Campanillas. Si comparamos estos vídeos con el cine, “en las películas basadas en hechos reales en las que no se ha obtenido consentimiento o son historias no autorizadas, en muchos casos se cambian los nombres para que no haya conflicto con estos derechos”, ejemplifica Campanillas. También pasa en publicidad: los anuncios de Lola Flores o Luis Aragonés creados con tecnología deepfake sí tenían el consentimiento de sus familiares. Usar la imagen de una persona con fines comerciales requiere consentimiento, aunque esté creada con inteligencia artificial.

¿Qué pasa si los protagonistas de esos vídeos creados con IA son niños?

“Con menores el bien jurídico protegido está aún más protegido. Por ejemplo, la fiscalía podría directamente actuar de oficio si se está tratando la imagen del menor de manera peyorativa o si ha fallecido”, explica Campanillas.

En este sentido, el Ministerio Fiscal vela por la protección de la imagen y la integridad física y moral de los menores, indica Mediano: “Aunque la Instrucción 2/2006, de 15 de marzo, sobre la protección de derecho al honor, intimidad y propia imagen de los menores no aborda específicamente el tema de los deepfakes, los principios que refleja pueden ser de aplicación a estas situaciones”.

Por ejemplo, Mediano señala que la excepción de las caricaturas “podría no ser aplicable a los menores, especialmente si están en riesgo su integridad moral u otros bienes dignos de protección”. Si hay que denunciar, serían los padres o tutores los que podrían hacerlo. “Todos los poderes públicos y entidades privadas implicados en este asunto deben prestar especial atención a la defensa de los derechos de los menores. Es una cuestión social de la máxima importancia”, considera Mediano.

Otro tema que sobrevuela este tipo de vídeos es el económico. Esas cuentas con millones de reproducciones están sacando dinero de ello, ¿podrían los protagonistas o sus familiares (en el caso de historias de personas fallecidas o de menores) pedir beneficios? Mediano remarca que una de las cosas que se podría solicitar es “una indemnización por los daños y perjuicios causados”.

@relatoshumans Paulette Gebara. Historia real. #casosdelavidareal #historiasreales #historiareal #crimenesreales ♬ Sad and lonely - MoppySound

Hemos actualizado este artículo para incluir información sobre los vídeos sobre supuestas violaciones de animales a mujeres.