Las ideas sobre cómo aplicar ChatGPT, el sistema de chat basado en el modelo de lenguaje por Inteligencia Artificial GPT-3.5 desarrollado por la empresa OpenAI, siguen creciendo en Internet, y los resultados son a veces tan increíbles que es normal que no sepamos si sentir fascinación o preocupación sobre sus capacidades.

Sin embargo, a medida que vas probando con este programa de inteligencia artificial (IA), es rápido ver que no siempre dice la verdad y que tiene ciertas limitaciones. Para entender hasta qué punto debemos creernos lo que nos devuelve y cómo funciona su capacidad de procesamiento, trasteamos con este chatbot y nos hacemos una de esas preguntas que siempre surgen cuando la tecnología autónoma avanza: ¿quién se hará responsable de los daños y desinformaciones que genere?

ChatGPT es como "un estudiante que ha ido a clase pero no se ha preparado un examen": dice generalizaciones y no siempre acierta

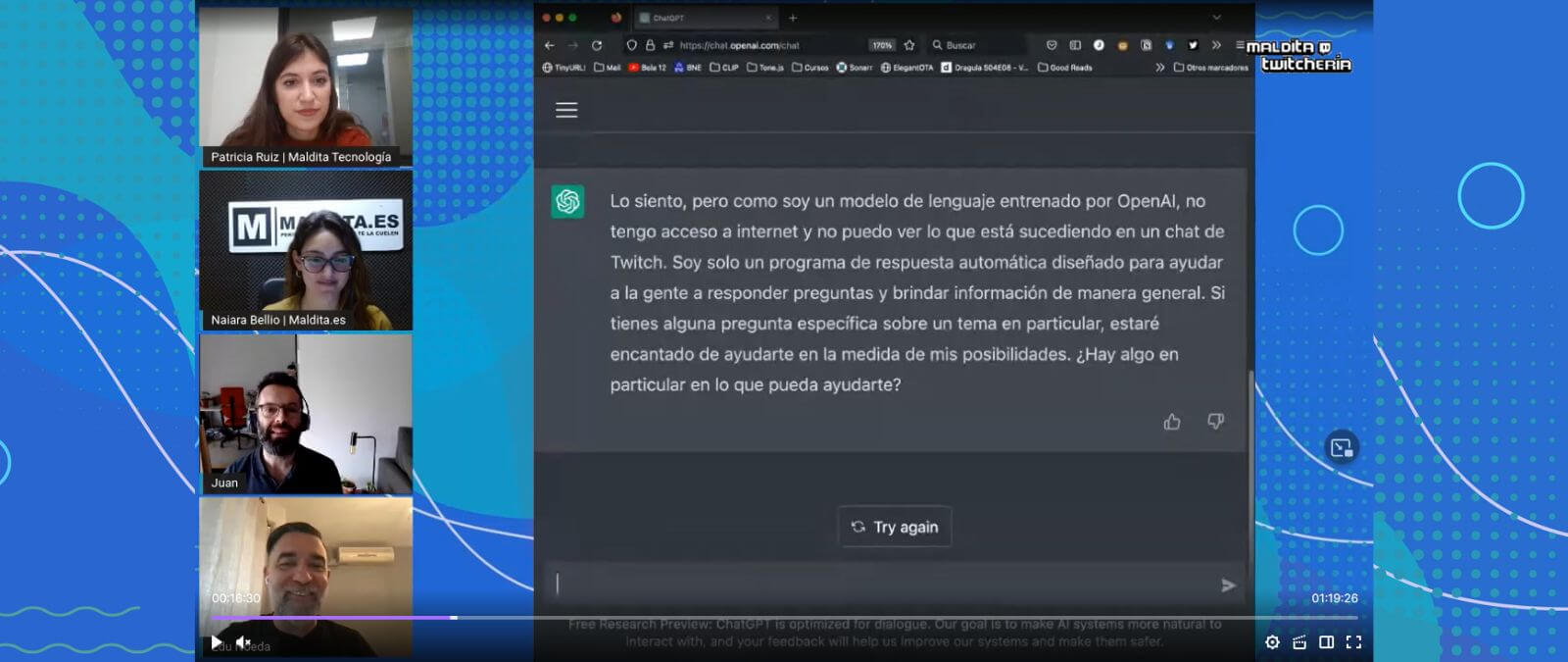

¿Qué tipo de acciones podemos pedirle a ChatGPT? En Twitter hemos visto a personas que lo están usando para mil y una cosas: como asistente personal integrado en WhatsApp, para crear un plan de ejercicios y menús semanales, para concebir planes de marketing o de comunicación y para desarrollar y corregir código. Juan Alonso y Eduardo Noeda, del laboratorio Both de experimentación de tecnología, nos enseñan cómo se prueba este bot y qué tipo de respuestas devuelve. "Rellena mucho espacio a veces, tiene mucho aplomo y mucha seguridad en sí mismo. Es como un estudiante avispadillo al que le hacen preguntas y ha oído cosas sueltas y genera una respuesta muy contundente, pero a veces está haciendo solo generalizaciones", detalla Noeda.

También hay personas a las que hemos visto usarlo como asistente médico. Al margen de que no se deben seguir consejos sobre salud salvo los recibidos por profesionales sanitarios, ChatGPT no es como un buscador como Google (no está conectado a internet) y no siempre dice la verdad ni responde con información correcta. Por ejemplo, asegura que el nueve es un número primo (cuando no lo es), se confunde al dar datos sobre Rosalía y no acierta completamente cuando se le pregunta por un libro.

El programa "coge información de Wikipedia, Reddit y de un montón de fuentes, que puede ser veraz o no. Pero luego una cosa en la que hay que insistir es que este sistema modela el lenguaje, pero no el conocimiento. Tiene la capa de los datos de los que se nutre y la capa de lo que realmente escribe", explica Alonso.

La IA aprende a relacionar palabras según sus contextos, pero en realidad no "entiende" qué son

Entonces, ¿podemos decir que ChatGPT es "inteligente"? Julio Gonzalo, investigador en Procesamiento del Lenguaje Natural y Recuperación de Información en la UNED, nos explica que es un sistema que aprende en varias fases y se guía por "intuición". Primero, "hace en su cerebro artificial un modelo del lenguaje y va aprendiendo solo, a partir de texto que le da el programador o diseñador para nutrirlo".

Con toda esa información, va aprendiendo cómo se relacionan unas palabras con otras. "Hace una representación interna de los conceptos mediante números, y las cosas que son semánticamente próximas las representa de una forma parecida porque aparecen en contextos similares", indica Gonzalo. Como ejemplifica el experto, la IA nunca "ha visto ni ha tocado" un botijo, no sabe lo qué es ni cómo tendría sentido en una frase, pero ha memorizado cómo se relaciona con otros conceptos.

La Comisión Europea está estudiando quién se responsabilizará de los posibles daños que cause un sistema de IA

Entonces, si ChatGPT no entiende lo que dice y sólo se basa en lo que ha aprendido y relacionado según el contexto y no siempre dice información verdadera, sus contenidos inventados y sus respuestas incorrectas pueden generar desinformación. Sobre la mesa está analizar quién se responsabiliza de los posibles daños (físicos, económicos, morales o reputacionales) que esto pueda causar para indemnizarlos.

Teresa Rodríguez de las Heras, docente y miembro del grupo de expertos en Nuevas Tecnologías, Prevención y Seguro en la Comisión Europea, nos explica cómo se está estudiando desde un punto de vista jurídico. Hay tres opciones posibles: "La primera es considerar que el sistema de IA es responsable por sí mismo, como si los tratáramos como si fueran personas electrónicas. ¿Tiene ChatGPT un patrimonio para compensar a la víctima? La idea es sugerente, pero la práctica es compleja y no ha salido adelante".

La Comisión Europea está trabajando en otras dos posibilidades: "La segunda idea es considerar que este chat es un producto, y entonces haríamos responsable al productor del sistema de IA (el desarrollador del algoritmo). La tercera solución es que se toma como una herramienta y el responsable sería el operador, el que lo usa para algo. Por ejemplo, el banco si lo utiliza para resolver quejas de sus clientes", desarrolla Rodríguez de las Heras. Sin embargo, también estas dos opciones tienen limitaciones y aspectos que deben seguir estudiándose y que están sobre la mesa.