A la inteligencia artificial (IA) se le han atribuido capacidades que no siempre son reales o que al menos requieren de la intervención humana para funcionar. Por ejemplo, una IA no puede escribir una noticia por sí sola porque no sabe qué es hasta que se le enseña ni qué debe de contener este tipo de textos, y tampoco es capaz de detectar automáticamente cuándo un evento es susceptible de ser noticia y cuándo no. Eso sin hablar de la imposibilidad de estos sistemas para entender el contexto, algo de lo que ya os hemos hablado en Maldita.es y en lo que nos centramos en este programa.

Así que como ya os adelantamos en el titular, usar la IA para detectar y frenar la desinformación todavía está muy lejos de saber la realidad, y nuestros invitados nos explican en la Maldita Twitchería por qué esto es así y qué es lo que le falta a la IA para ser usada en este campo.

Saber distinguir el tono y el contexto es el gran escalón que queda por resolver

Ángel Delgado, ingeniero de machine learning en paradigma digital, rebaja mucho las expectativas que nos suelen vender, "como que la IA va a dominar el mundo o que sustituirá a los humanos". "Una inteligencia artificial entrenada puede ver qué es lo importante en un texto y, a partir de lo que ha aprendido, generar uno nuevo, pero nunca va a saber o entender el contexto de lo que ha leído o de lo que está escribiendo", explica Delgado.

El ingeniero aclara que "una de las cuestiones que más falta por desarrollar dentro del campo es captar el tono: todavía la máquina no es capaz de distinguir el contexto para poder entender si hay que hablar formal o informalmente, qué vocabulario utilizar según la audiencia o si se cuentan ironías, que es clave para analizar un texto o una conversación".

Una IA puede corregir la ortografía, pero no la semántica

Precisamente de lenguaje hablamos con Iria da Cunha, doctora en lingüística aplicada e investigadora de lingüística computacional en la UNED. Lo primero es que destaca la gran diferencia entre idiomas, porque "un gran número de IAs están diseñadas en inglés, básicamente porque hay más texto que en otras lenguas, pero también porque hay más investigadores dedicados en este campo en inglés".

En línea con lo que había comentado anteriormente Ángel Delgado, Da Cunha explica que "la parte fundamental que separa a los humanos de las máquinas es la semántica, el contexto de una oración". "Por ejemplo, un procesador de textos como Word es capaz de analizar la ortografía y la sintaxis para ofrecerte correcciones, pero no va a saber distinguir si escribir 'vaca' o 'baca' está bien porque no entiende el contexto comunicativo de la frase".

"Que una IA distinga si un insulto se ha proferido con intención de hacer daño o como muestra de colegueo es muy difícil ahora mismo"

"La inteligencia artificial, ahora mismo, no puede luchar por sí sola contra el fenómeno de la desinformación", comienza Pablo Hernández, el coordinador de Academia de Maldita.es. "En tal caso, en los estudios sobre la materia, se ve que tiene que haber personas que estén ayudados por una IA que pueda monitorizar los grandes flujos de información, porque por ahora siempre se requiere el factor humano", añade.

Nuestro compañero muestra las conclusiones de algunas investigaciones, como una que "concluye que la IA no sabe analizar bien el discurso de odio porque, por ejemplo, no distingue si un insulto se ha dicho con intención de hacer daño o como muestra de colegueo". "También existe otro estudio en el que se refleja que la IA no detecta bien el discurso machista, seguramente porque cuando fue entrenado estos sesgos se introdujeron como 'normales' en la conversación y no como elemento para distinguir ese tono machista".

Los efectos de las recomendaciones de la IA sobre los usuarios

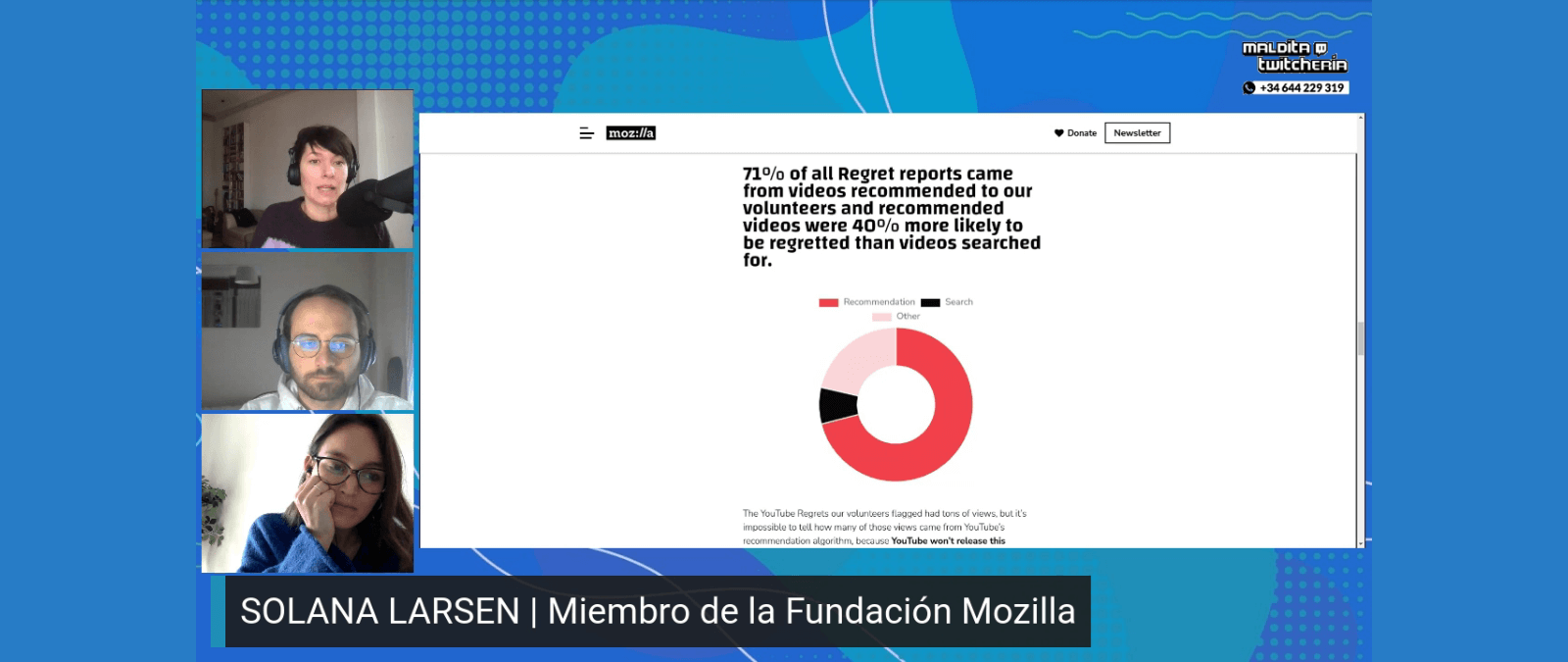

Solana Larsen, investigadora de la Fundación Mozilla, resume algunos de los estudios y herramientas que han puesto en marcha desde la organización para analizar las IAs de las plataformas. Por ejemplo, como también os contamos en Maldita.es, la extensión Regret Reporter permite decirle al algoritmo de YouTube que no nos recomiende más vídeos sobre una temática concreta. "Esta herramienta también nos permite saber de forma anónima cómo ese usuario ha llegado a ese vídeo", aclara Larsen.

"Las conclusiones de nuestro estudio muestran como el 71% de los vídeos reportados al algoritmo para que no se mostraran más al usuario fueron recomendados por la propia plataforma, y cómo los vídeos sugeridos tenían un 40% más de probabilidades de ser reportados que los vídeos buscados", comenta la investigadora de Mozilla. Otra de las cuestiones que descubrieron es que "los países de habla no inglesa fueron los más que utilizaron el sistema de aviso de la extensión".