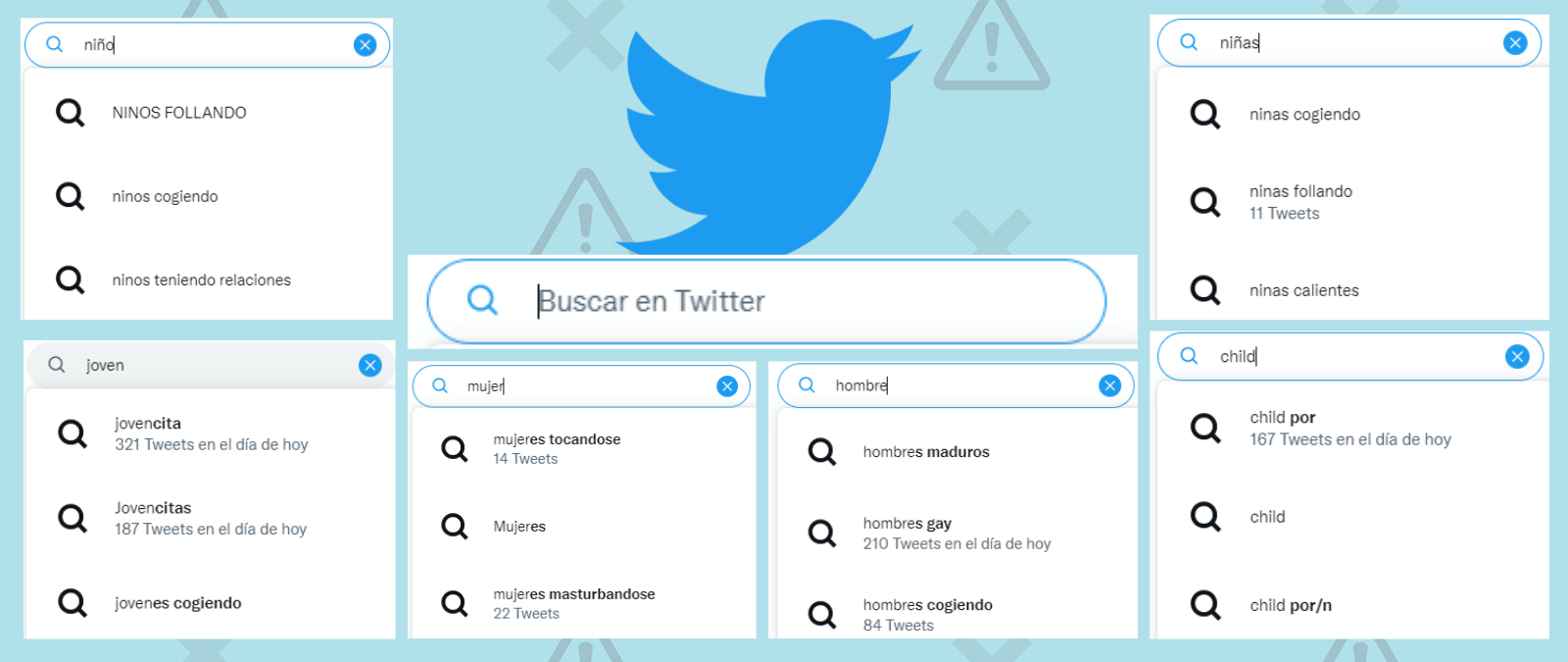

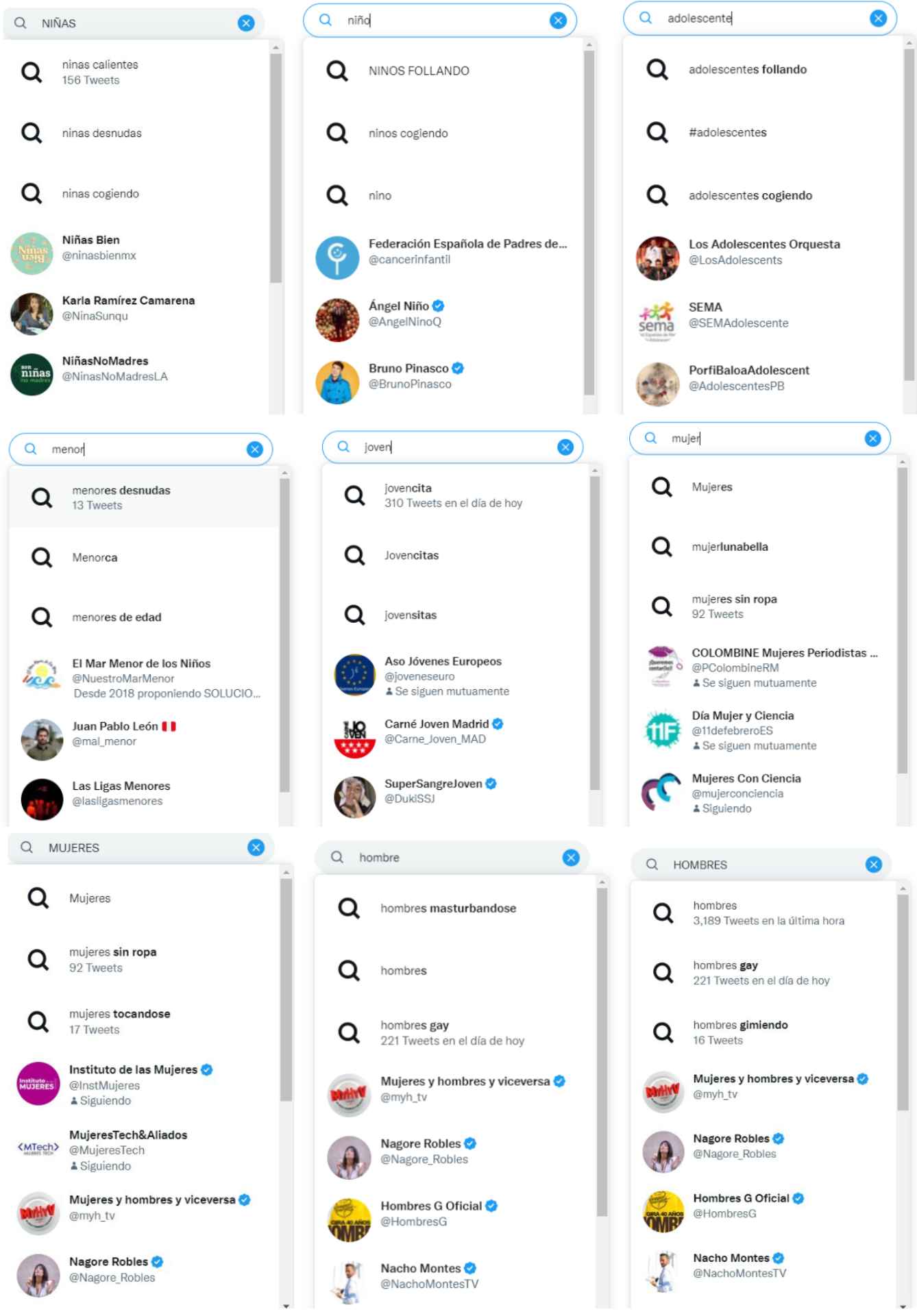

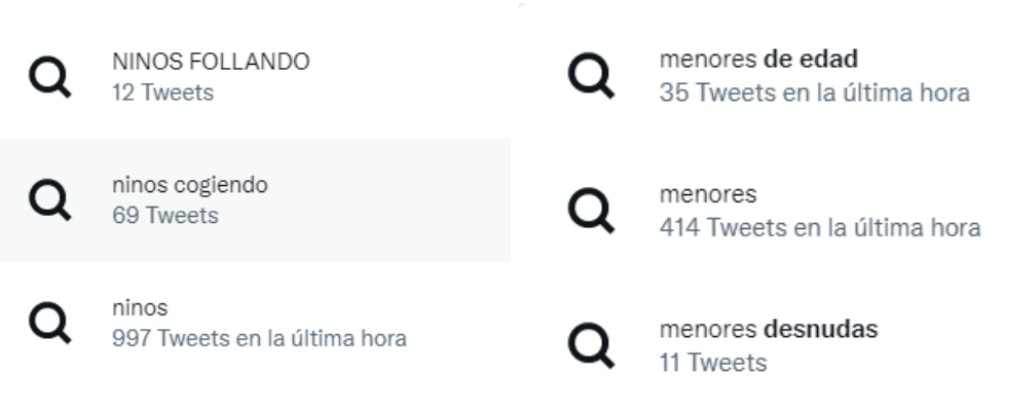

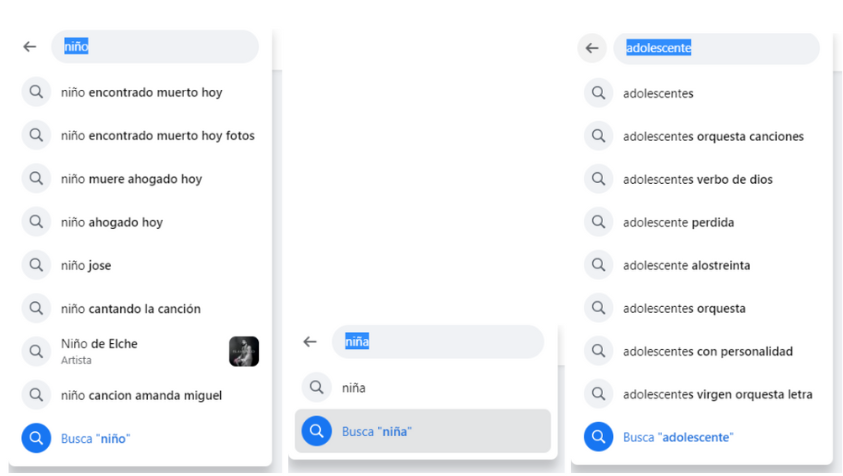

Hay cosas que uno no espera encontrarse en una red social global utilizada a diario por millones de personas, como es Twitter, al usar su barra de búsquedas: “Estaba buscando la noticia del niño de seis años, he puesto ‘niño’ y me han salido estas búsquedas sugeridas en Twitter”, contó la usuaria @lady_sackville. La plataforma le devolvía las expresiones ‘ninos cogiendo’, ‘NINOS FOLLANDO’ y ‘ninos sicarios’ [sic]. Alertados, otros usuarios hicieron la misma prueba y afirmaron que les pasaba lo mismo. No sólo en España, también en Latinoamérica, y no sólo con la palabra ‘niño’, también al buscar ‘niñas’.

En Maldita.es hemos probado a hacer la misma búsqueda durante varios días, a distintas horas y desde distintas cuentas de Twitter. Prácticamente en la totalidad de los casos, Twitter autocompleta la búsqueda con el tipo de términos sexuales que se ven en las capturas. Esto ocurre también con más palabras que hacen referencia a personas menores de edad, como ‘joven’, ‘menor’ o ‘adolescente’, y también si se busca ‘hombre’ o ‘mujer’. En inglés, sucede con la palabra ‘child’.

Hemos consultado con expertos qué hay detrás de la función de autocompletado del buscador de Twitter, si los cambios de Elon Musk tienen algo que ver con que estas sugerencias no estén capadas y si es ilegal que aparezcan cuando se trata de contenido relacionado con menores de edad.

Twitter no ha publicado detalles sobre su función de autocompletado ni sobre cómo gestiona las predicciones delicadas

En cualquier barra de buscador de una plataforma o motor de búsqueda (Instagram, Facebook, LinkedIn o correo electrónico), cuando empezamos a teclear es habitual que se despliegue un menú que sugiera distintas palabras. Como hemos visto, también ocurre en Twitter si tecleas en ‘Buscar en Twitter’. Esta función de autocompletado se implementó en julio de 2012, como anunció la red social en su blog.

En el comunicado, se explica que el autocompletado de búsqueda de Twitter muestra al usuario los términos más probables para su consulta a medida que la escribe. También se mencionan las sugerencias relacionadas: si se busca un tema para el que las personas usan varios términos, Twitter proporcionará “sugerencias relevantes para los términos en los que la mayor parte de esa conversación está teniendo lugar en Twitter”. Pero no hay más información en detalle.

Desde Maldita.es hemos contactado repetidamente con Twitter para preguntarles sobre el funcionamiento del algoritmo de autocompletado y cómo gestiona la red social las sugerencias que muestra. También hemos preguntado por qué no están capadas las búsquedas que predice en relación a las palabras ‘niño’ o ‘niña’. A 16 de enero, no hemos obtenido ninguna respuesta.

“La tecnología de Twitter del autocompletado en las búsquedas no la comparten fácilmente”, corrobora Tomás Balaguer, ingeniero de automatizaciones y maldito que nos ha prestado sus superpoderes. El experto cuenta a Maldita.es que lo más cercano a una explicación a esta pregunta es un artículo en el blog de desarrollo de Twitter sobre cómo tratan los datos y forman los llamados topics (temas) y nos explica una hipótesis probable sobre cómo funciona. “Es un modelo predictivo basado en machine learning bastante parecido al de Google. Lo que vas introduciendo se compara con los trends [tendencias] de búsquedas por parte del resto de usuarios y se le asigna un ‘peso’. Obviamente tus propias búsquedas similares tendrán siempre mayor ‘peso’ que cualquiera de las de otros usuarios (salvo que borres el historial)”, detalla Balaguer.

Mariluz Congosto, investigadora en caracterización de usuarios y propagación de mensajes en Twitter de la Universidad Carlos III de Madrid, también cree que probablemente funcione de forma similar al de Google: “Da la impresión de que guarda las búsquedas y los pares de palabras que aparecen juntas con más frecuencia y los sugiere. Concretamente, a veces muestra la cantidad de tuits publicados en la última hora”.

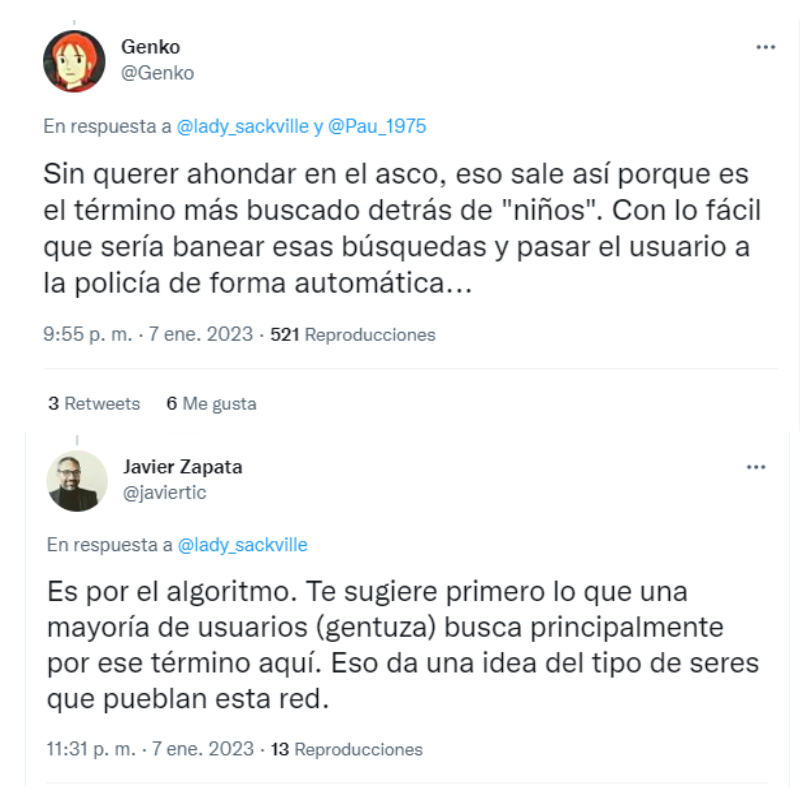

Es decir, el algoritmo de autocompletado devolvería los grupos de palabras que se han buscado juntas en más ocasiones. Esto también lo sugerían algunos usuarios de la red.

Congosto añade que “esos pares de palabras no tienen por qué estar juntos”, sino simplemente “aparecer en el mismo tuit”. Es decir, puede que las palabras ‘menores’ y ‘desnudas’ estén escritas a la vez en la misma publicación, pero no unidas, y que no impliquen connotación sexual. Tanto la investigadora como desde Maldita.es hemos comprobado qué resultados ofrecen algunas de estas búsquedas: hay casos en los que efectivamente las palabras no van juntas en el tuit y el contenido no tiene nada que ver. Sin embargo, en otros casos sí incluyen contenido sexual.

No es ilegal que Twitter sugiera automáticamente estos términos, pero debería actuar si se les notifica

La política relativa a la explotación sexual infantil de Twitter de octubre de 2020 recoge que “Twitter tiene tolerancia cero hacia cualquier material que muestre o promocione actos de explotación sexual infantil”. Entre los contenidos que incumplen esta política se especifica, por ejemplo, “comentarios sexualizados acerca de un menor conocido o desconocido, o dirigidos hacia él” o “compartir fantasías sobre actos de explotación sexual infantil o promocionar la participación en dichos actos”. Pero, en el caso de las palabras que predice la función de autocompletado, se trata de una sugerencia que aparece en la barra de búsqueda; no en un tuit ni una publicación ejecutada.

¿Es ilegal que Twitter sugiera el tipo de búsquedas que hemos analizado en relación a menores y connotaciones sexuales? “No hay una legislación específica que prohíba este tipo de cosas. Twitter no tiene responsabilidad inicial directa por las sugerencias que haga siempre y cuando las genere basadas en criterios asépticos y neutrales. Seguramente la plataforma dirá que el autocompletado es una función neutra donde si la gente busca mucho ‘niños cogiendo’, Twitter lo va a sugerir por la frecuencia con que la gente lo busca”, explica a Maldita.es Samuel Parra, abogado especializado en protección de datos en ePrivacidad y Égida.

Otra cosa es que se pueda demostrar que Twitter sabe que esas sugerencias están teniendo lugar y no está haciendo nada al respecto. “Si una institución o un particular informa a Twitter (por ejemplo mediante un burofax) de que el autocompletado está surgiendo búsquedas relacionadas con acciones sexuales y menores, y la plataforma no actúa, se le podría llevar a juicio y exigir responsabilidades por sugerir cadenas de búsqueda que te llevan a contenido que es ilícito o ilegal”, desarrolla Parra.

Es decir: si hay un algoritmo neutro detrás de las sugerencias que da la función de autocompletar, Twitter no tendría responsabilidad y no sería ilegal per se; pero sí si tiene un conocimiento efectivo de que esto se está produciendo y no lo corrige.

Aunque las plataformas no tengan obligación directamente de detectar y reportar el material de abuso sexual infantil (CSAM, por sus siglas en inglés) o cosas relacionadas como el autocompletado, Jorge Morell, abogado experto en derecho tecnológico y experto en términos y condiciones de las plataformas en Legaltechies, señala que todas lo hacen voluntariamente. Además, el abogado indica que “en este caso podría entenderse que Twitter vulnera su propia política sobre explotación sexual”. Para atajar la voluntariedad, Morell nos explica que Europa propuso a inicios de 2022 regular esto de forma más concreta, pero de momento la normativa sigue bajo discusión y no ha sido aprobada.

En cambio, sí que hay penalizaciones “cuando la función de autocompletar vulnera los derechos o atenta contra el honor de alguien, porque se aplica la Ley Orgánica 1/1982 de 1982 de protección civil sobre el honor y la propia imagen”, indica Samuel Parra. Por ejemplo, si al buscar el nombre de una persona se sugiere la palabra ‘estafador’, especifica Jorge Morell. Pero en estos casos “normalmente los buscadores no han sido responsables, ellos sólo reflejan lo que indexan”, añade.

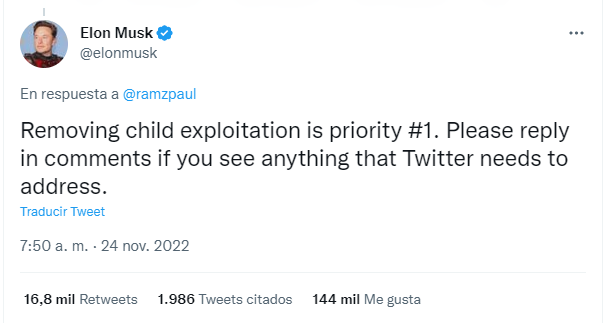

Aunque Musk ha dicho que luchar contra contenidos de abuso sexual infantil es la prioridad, el equipo dedicado a ello se ha reducido a menos de 10 personas

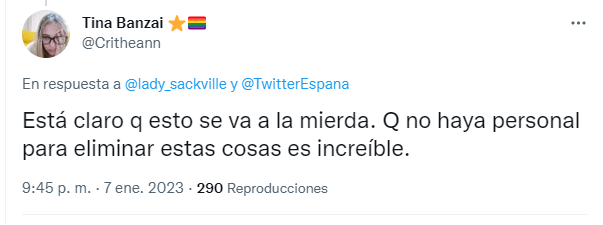

Una pregunta que se han hecho los expertos con los que hemos hablado y también muchos usuarios en Twitter a raíz del hilo de @lady_sackville ha sido sobre los equipos que deberían estar moderando y revisando la función de autocompletar. ¿Tiene algo que ver con todo esto Elon Musk, el nuevo dueño de Twitter?

Por un lado, Musk ha insistido en varias ocasiones en que bloquear los contenidos relacionados con abuso sexual infantil en la plataforma es su prioridad. Tras su llegada han aparecido nuevas formas directas de reportar este tipo de contenidos y también se habrían eliminado hashtags relacionados con la venta de material de abuso sexual infantil, como señaló la defensora de supervivientes de trata de personas Eliza.

Por otro lado, sabemos que con Musk llegaron despidos y dimisiones en masa, como os hemos contado en Maldita.es. Entre el personal que se ha visto reducido estaría el equipo dedicado a prevenir la explotación sexual infantil en la plataforma: según recogió Bloomberg a finales de noviembre de 2022, Twitter tenía 20 miembros del equipo responsables de revisar y escalar los informes de contenidos reloacionados con abuso sexual infantil; ahora quedaría menos de 10. Según Wired, sólo queda un miembro en el caso del equipo de seguridad infantil de la región de Asia-Pacífico, que agrupa al 60% de la población mundial. Sólo en Japón se concentran 59 millones de usuarios de Twitter.

Con la mitad del personal, vigilar este tipo de búsquedas y de contenido es mucho más difícil, por eso Jorge Morell cree que los despedidos pueden haber afectado a que ahora aparezcan esas sugerencias de autocompletado: “Lo normal hasta ahora sería que ellos activamente rastrearan este tipo de contenido y lo denunciaran. En casos donde alguien lo denuncia particularmente, lo normal es que también actúen. Pero con la cantidad de despedidos actuales, parece que hay mucho menos rastreo y acción proactiva, y seguramente también sean más lentos en casos donde deben reaccionar a denuncias”.

El 1 de febrero de 2023, Twitter actualizó en su cuenta de Twitter Safety los últimos resultados de su trabajo sobre material de explotación sexual infantil. Por ejemplo, detallan que en enero se suspendieron aproximadamente 404.000 cuentas que crearon, distribuyeron o interactuaron con este tipo de contenido, lo que supone un aumento del 112 % en el cierre de este tipo de cuentas desde noviembre. Sin embargo, el 6 de febrero, el New York Times publicó una investigación en la que constatan que este material persiste en la plataforma, es fácil de encontrar e incluso es sugerido por el motor de recomendación. *

Google sí detalla en su web cómo funciona su autocompletado y cómo gestionan los problemas. Facebook también ha tenido polémicas

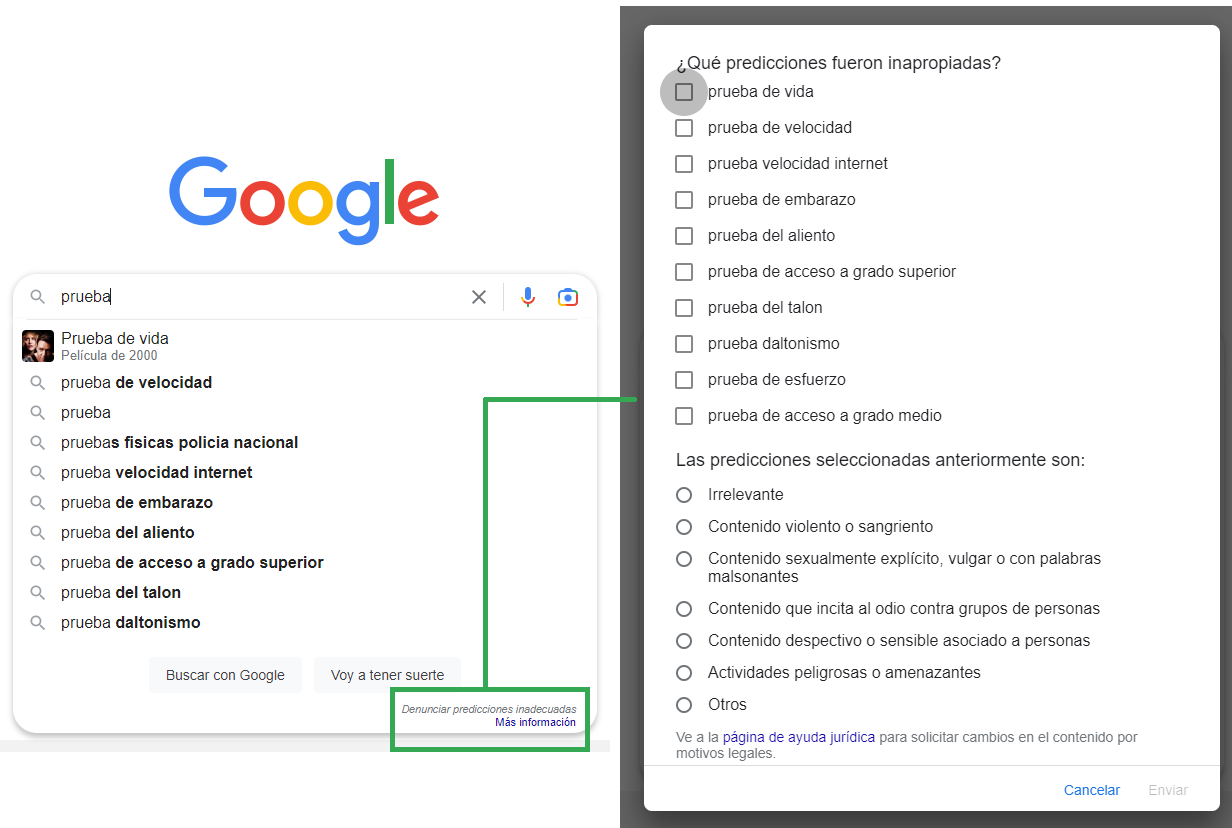

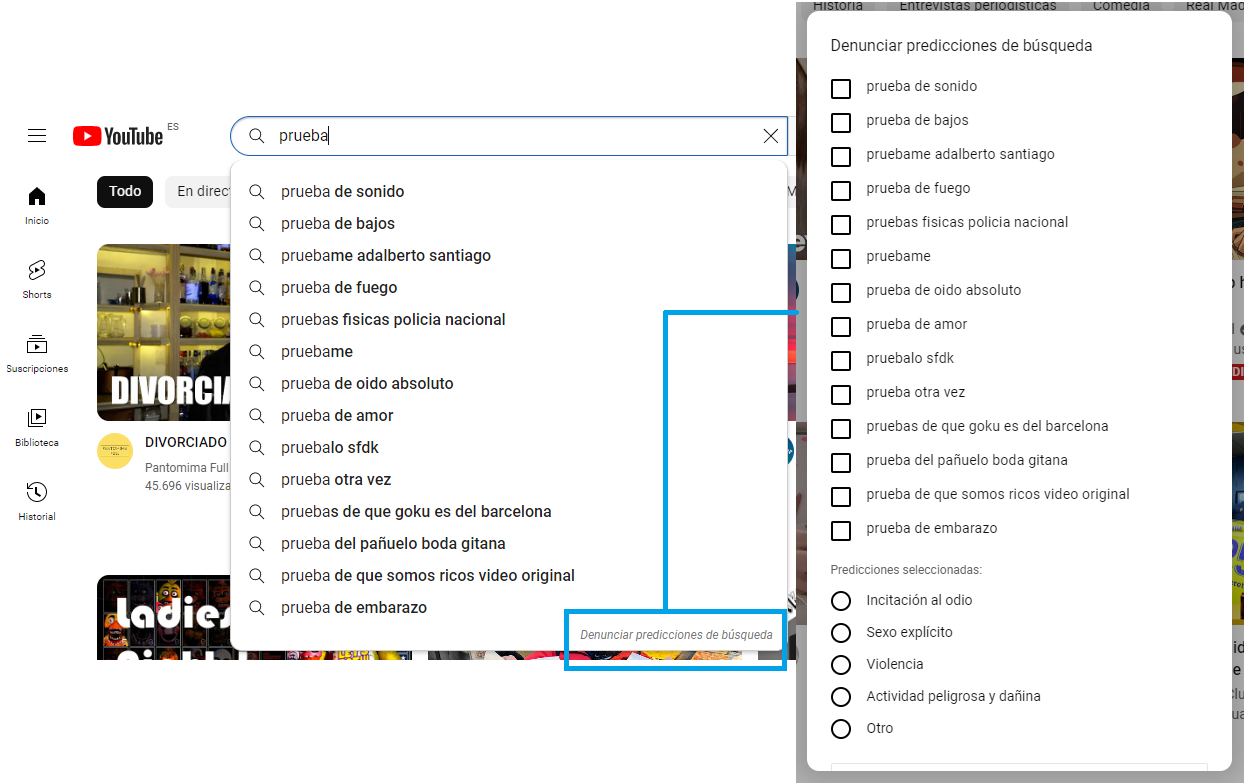

En el caso de Google sí hay publicada mucha información sobre cómo funciona su algoritmo de autocompletado. En esta sección de la web de Ayuda de Búsqueda de Google, explican que los sistemas automatizados “buscan consultas comunes que coincidan con lo que un usuario empieza a introducir en el cuadro de búsqueda”, pero también tienen en cuenta el idioma, la ubicación, las tendencias y las búsquedas anteriores. Danny Sullivan, enlace público de Google sobre búsquedas, publicaba esta entrada en 2018 con más detalles y recordaba que sus sistemas “no son perfectos y las predicciones inapropiadas pueden ocurrir”. En la web especifican cómo gestionan esos problemas: por ejemplo, señalan que sus sistemas tratan de evitar predicciones sexualmente explícitas. También dan la posibilidad de denunciar una predicción, tal y como explican aquí.

La denuncia se puede hacer directamente en el propio buscador de Google y de YouTube: en ambos casos, aparece en la parte inferior derecha del cuadro de predicción. Una vez que se pulsa Denunciar predicciones de búsqueda se abre un menú donde se puede seleccionar directamente qué predicción denunciar y qué estamos denunciando (incitación al odio, contenido violento, sexo explícito, actividad peligrosa y dañina u otros).*

Sin embargo, Google ha tenido problemas con su algoritmo de autocompletado en varias ocasiones. Por ejemplo, The Guardian recogía las predicciones que devolvía si empezabas a escribir la pregunta ‘are jews…’ (‘¿son los judíos…?’) u otras relacionadas con religiones o mujeres. En idiomas como el árabe sigue habiendo problemas.

También es algo que ha pasado con Facebook: en 2018, al escribir ‘video of’ se devolvían sugerencias de autocompletado de vídeos sexuales y contenido de abuso infantil. En Latinoamérica, en febrero de 2019, advirtieron justo sobre el mismo caso que hemos investigado en Twitter: autocompletados de carácter sexual al buscar en la barra de Facebook las palabras ‘niña’ o ‘niño’. Facebook lo desactivó.

En este artículo ha colaborado con sus superpoderes el maldito Tomás Balaguer, ingeniero de automatizaciones.

Gracias a vuestros superpoderes, conocimientos y experiencia podemos luchar más y mejor contra la mentira. La comunidad de Maldita.es sois imprescindibles para parar la desinformación. Ayúdanos en esta batalla: mándanos los bulos que te lleguen a nuestro servicio de Whatsapp, préstanos tus superpoderes, difunde nuestros desmentidos y hazte Embajador.

* Hemos añadido información sobre cómo se pueden denunciar las predicciones de búsqueda en Google y YouTube.