John J. Mearsheimer, politólogo y profesor de la Universidad de Chicago, afirma que apenas habla español. Sin embargo, en YouTube hay una red que ha publicado más de 200 vídeos (la mayoría todavía disponibles) del experto haciendo un análisis político, en español, de diferentes temas que ocupan la actualidad: el ‘caso Epstein’, Israel y Palestina, o la captura de Maduro por parte de Estados Unidos, entre otros. Aprovechan el creciente interés por el análisis político para inundar la plataforma con estos vídeos, creados con inteligencia artificial (IA) y con millones de visualizaciones en apenas unos días. Una de las herramientas que utilizan es el generador de vídeos con IA que permite clonar la imagen de cualquier persona, HeyGen.

Durante el análisis, algunos de los 15 canales han cambiado el tipo de contenido que publican. Los deepfakes (vídeo manipulado con IA para alterar o sustituir la cara, cuerpo o voz de una persona) del experto han dado paso, sin explicación aparente, a vídeos sobre Pakistán, país desde donde estaría operando la red. “La Vida en un Pueblo de Pakistán Me Dejó Sin Palabras” o “Descubriendo un Pueblo Escondido en Pakistán 🇵🇰” son dos ejemplos de cortos que han aparecido recientemente en dichos canales. Algunos de estos vídeos han sido publicados en URL antiguas, aprovechando sus visualizaciones e interacciones.

Maldita.es detectó 15 canales creados en tres meses que utilizan la imagen de John Mearsheimer en más de 200 vídeos

“Tengo un problema importante con la gente que publica vídeos falsos de IA míos en internet”, escribía Mearsheimer el 5 de febrero de 2026 en un post de Substack. Algunos son tan realistas, cuenta, que incluso personas de su entorno “no se dan cuenta de que están viendo una falsificación”. Explica a Maldita.es que era consciente de la circulación de deepfakes con su imagen en inglés y en chino, —detectó un total de 43 canales—, pero no sabía de la existencia de estos contenidos en español. “En algunos de estos vídeos digo cosas que nunca dije ni diría”, añade Mearsheimer.

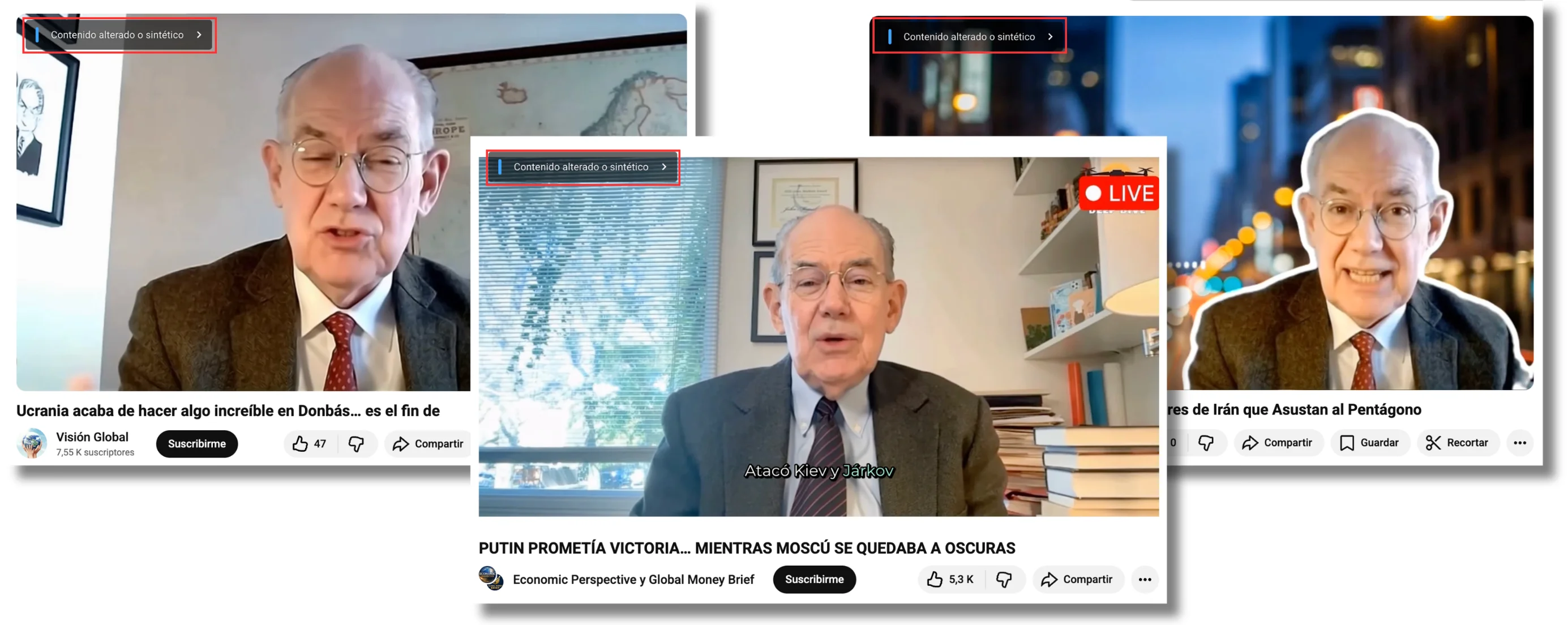

Maldita.es ha localizado más de 200 vídeos con la imagen del analista político (algunos de ellos con miles de visualizaciones) publicados por 15 canales diferentes de YouTube creados entre octubre de 2025 y enero de 2026. Estos perfiles (que en varias ocasiones han interactuado entre ellos compartiendo autoría en algunos vídeos) suman, en total, a fecha de publicación de este artículo, más de 170.000 suscriptores.

Los contenidos presentan indicios de haber sido creados con inteligencia artificial. En la mayoría de vídeos, Mearsheimer aparece vestido con la misma ropa. Las imágenes tienen la misma perspectiva y el mismo fondo, idéntico al que usa el propio analista en algunos de sus vídeos. Además, la voz de los vídeos es robótica (que no siempre es la misma) y los movimientos del protagonista son poco naturales.

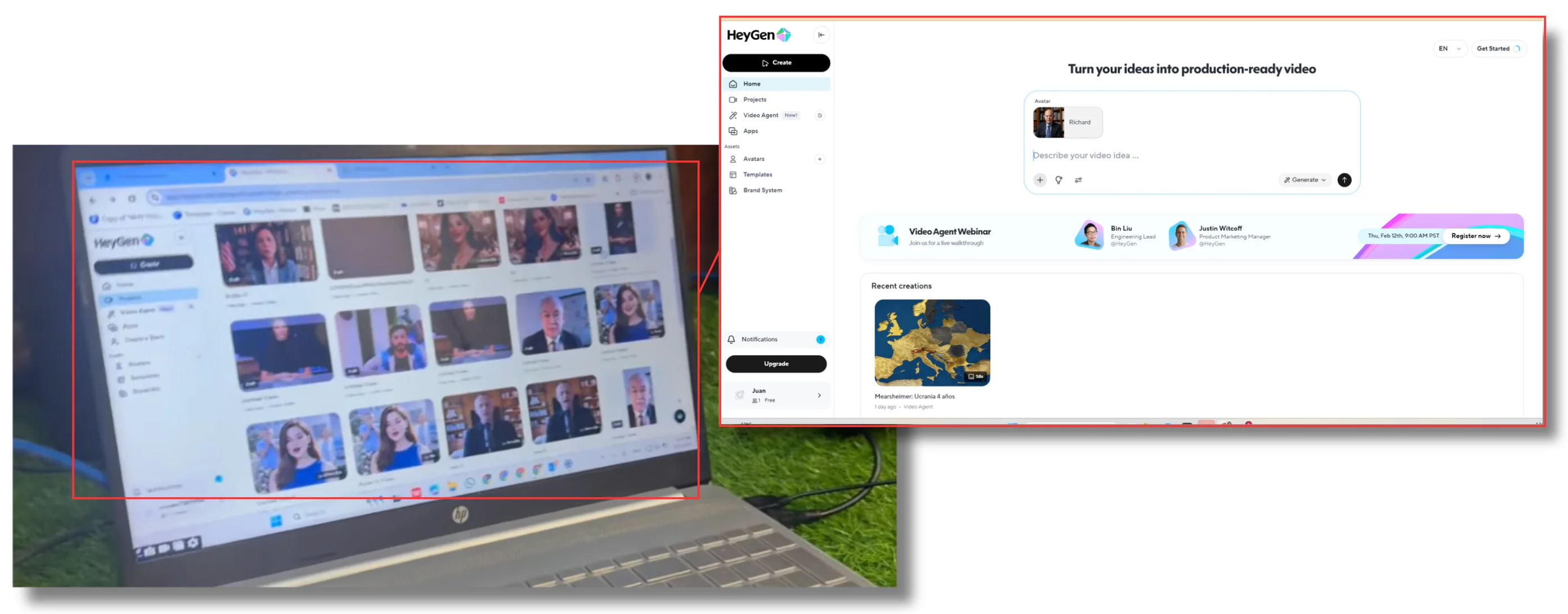

En uno de los vídeos publicado por esta red aparece un ordenador, en cuya pantalla se puede ver claramente que una de las herramientas usadas para crear estos contenidos es HeyGen, un generador de vídeos creados con IA. En estas imágenes podemos ver que han utilizado esta plataforma para generar deepfakes de Mearsheimer, pero también de otras personas.

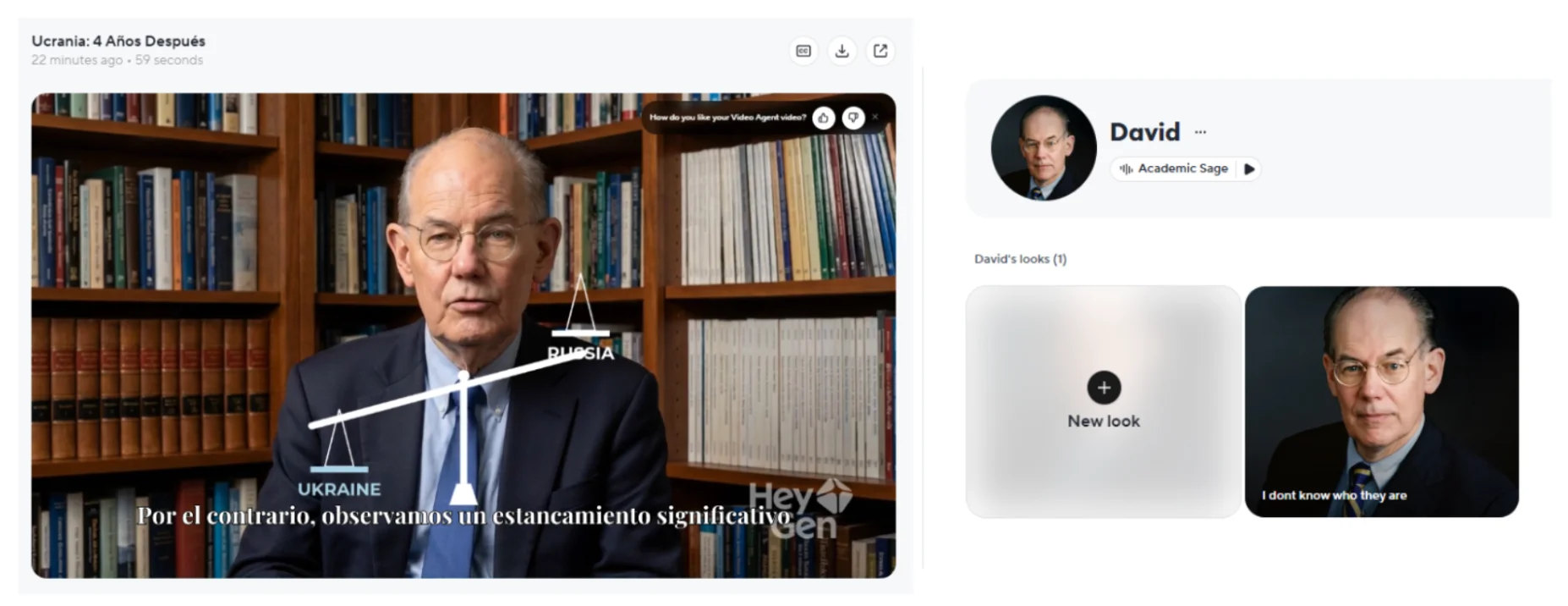

En Maldita.es hemos hecho la prueba: pedimos a esta misma herramienta que creara un vídeo de John Mearsheimer en español analizando la situación en Ucrania cuatro años después de la invasión rusa. En cuestión de minutos, HeyGen generó un vídeo similar a los publicados por esta red de canales de YouTube. De hecho, en su galería de avatares aparece el propio Mearsheimer, aunque con otro nombre, como uno de los avatares a escoger para la creación de contenidos. El resultado puede perfeccionarse aún más con una suscripción de pago a la plataforma. De hecho, la herramienta da la opción de “clonar” a una persona real, aunque en el caso de Mearsheimer sólo ha bastado con escribir su nombre porque ya está en el archivo de la plataforma.

Menos de la mitad de los canales analizados (seis) catalogan sus publicaciones (y no todas) como “contenido alterado o sintético”. Esta etiqueta de YouTube, que aparece en la descripción detallada de la publicación y de forma temporal al iniciar la reproducción, sirve para “mantener a los espectadores informados sobre el contenido que están viendo”, según explica la plataforma en su página web. “Hacer que parezca que alguien dio un consejo que en realidad no dio” o “clonar la voz de otra persona para crear voces en off o doblajes” son dos de los ejemplos que deben contener este distintivo.

“El análisis internacional, especialmente cuando se vincula a conflictos, crisis o amenazas, genera atención inmediata y un alto volumen de interacción”, explica Rafael González, miembro del Observatorio del Impacto Social y Ético de la IA (OdiseIA) y maldito que nos ha prestado sus superpoderes. Así, el objetivo principal de los deepfakes de Mearsheimer, dice el experto, es funcionar como “palanca de crecimiento rápido dentro del sistema de recomendación de la plataforma”, aprovechando los últimos movimientos geopolíticos en el mundo.

De la política internacional a vídeos sobre Pakistán: cómo algunos de estos canales han cambiado radicalmente el contenido de sus publicaciones

Cuando comenzamos este análisis, la mayoría de publicaciones de estos canales (en cuyos nombres se repiten palabras como “mundial”, “global”, “mundo”, “politics” o “economics”) eran falsos análisis políticos de Mearsheimer. Entonces, utilizaban un lenguaje alarmista, haciendo creer al espectador que estaban revelando algo exclusivo. Pero en varios ejemplos la descripción del vídeo no coincide con su contenido.

Por ejemplo, un vídeo titulado “¡BOMBA DE ÚLTIMO MINUTO! JD Vance EXPONE a Donald Trump y ADMITE el CAOS en ICE”, en realidad, trata sobre ‘el caso Epstein’ y no se menciona ni al Servicio de Control de Inmigración y Aduanas de los Estados Unidos (ICE por sus siglas en inglés) ni a JD Vance, vicepresidente en el Gobierno de Donald Trump.

Este tipo de contenidos (hasta ahora mayoritarios) han dado paso a otros vídeos con temáticas completamente diferentes, sin relación aparente y con otros formatos. En palabras de Rafael González, una vez el canal ha conseguido visibilidad con este tipo de contenidos, dejan de ser necesarios y pasan a representar un riesgo. “Su eliminación y sustitución por vídeos sin relación aparente permite conservar el canal como activo digital mientras se reducen las probabilidades de denuncias o sanciones”, afirma. En Maldita.es hemos podido comprobar que durante este análisis se han eliminado o sustituido decenas de deepfakes de Mearsheimer, que según el experto se utilizó para “activar el canal” y en ningún momento fue “el final de la operación”.

Recientemente, cuatro de los canales analizados comenzaron a publicar vídeos sobre Pakistán. “La vida rural en Pakistán es más dura de lo que pensaba” o “Así vive la gente lejos de las ciudades en Pakistán” son dos ejemplos de los contenidos que ahora publican. Se trata de vídeos más cortos (una media de seis minutos, frente a los más de 15 que duran los de Mearsheimer) y grabados, aparentemente, de forma espontánea y con pocos recursos.

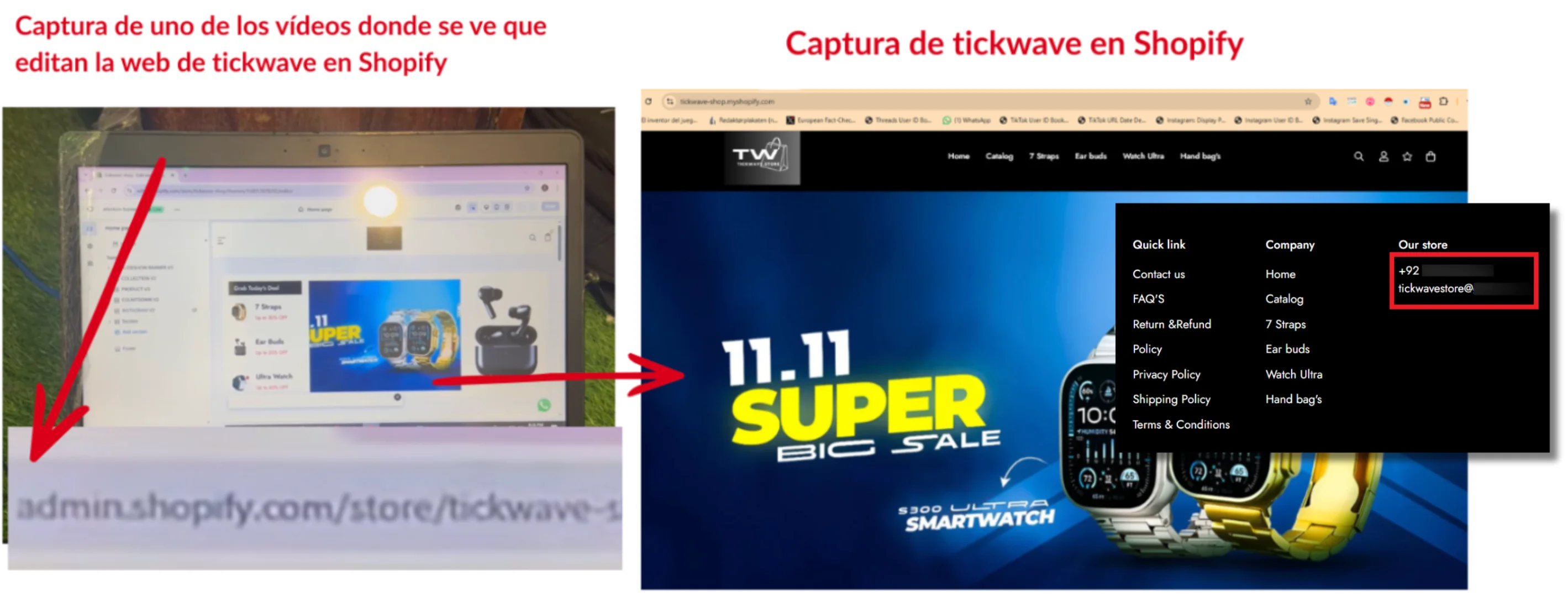

Estos vídeos, así como otros datos, indicarían que estarían operando desde ese país. En uno de los ordenadores se ve cómo editan una web en Shopify llamada tickwave cuyo teléfono tiene un prefijo de Pakistán (+92).

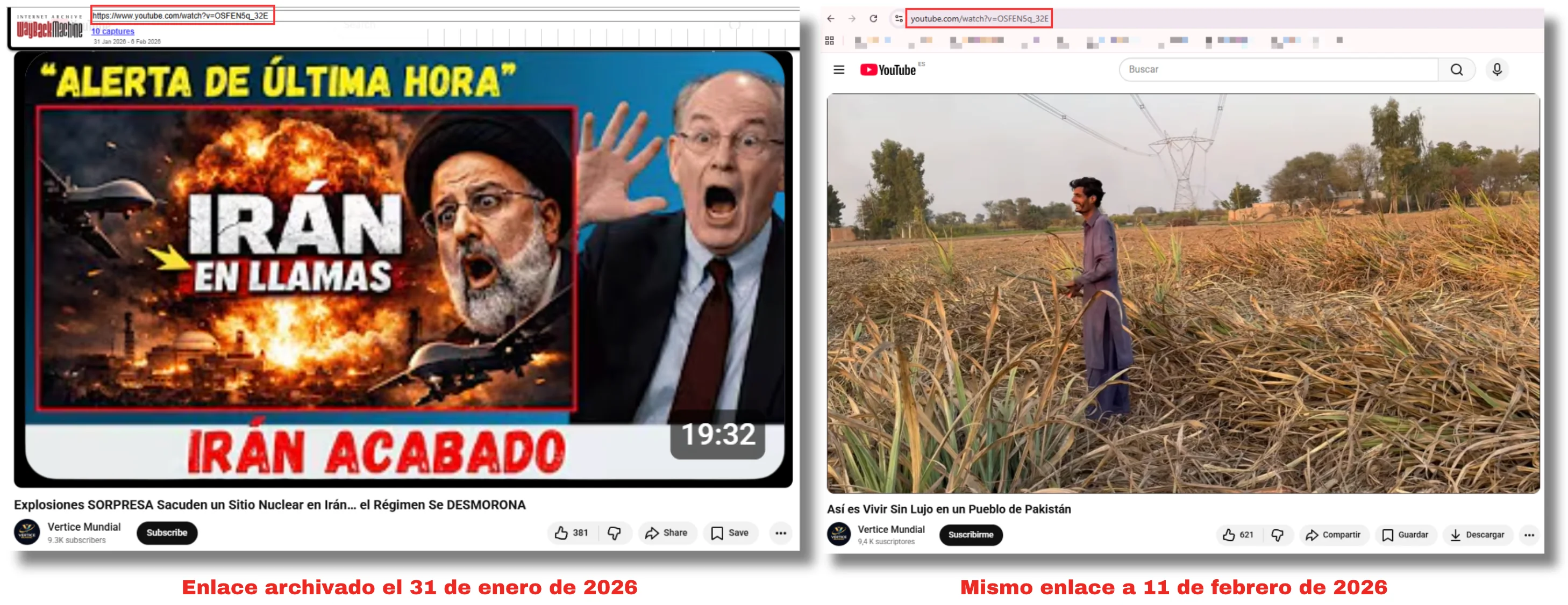

No solo han publicado más vídeos sobre Pakistán. También han cambiado el contenido de publicaciones antiguas. En varios ejemplos se ha mantenido el enlace original (además de otros parámetros como las visualizaciones o fecha de publicación), pero el contenido del vídeo ha cambiado por completo. Un ejemplo es el ahora titulado "Así es Vivir Sin Lujo en un Pueblo de Pakistán", que anteriormente se llamaba "Explosiones SORPRESA Sacuden un Sitio Nuclear en Irán… el Régimen Se DESMORONA". Se publicó el 31 de enero de 2026 y pasó de mostrar un deepfake en español de Mearsheimer a un vídeo de varios hombres en un campo.

Otro de los perfiles (eliminado recientemente de la plataforma) dejó de publicar deepfakes en español del analista político para iniciar una nueva serie de vídeos en ruso. Publicó, al menos, ocho de estos contenidos con una duración por debajo de los cuatro minutos. Según los títulos de los vídeos, narraban historias como una fiesta de cumpleaños en la que en lugar de música se reproduce una conversación telefónica entre una madre con su hijo o una mujer que coloca a escondidas una cámara de vigilancia en el apartamento de su hijo para descubrir engaños.

Los expertos consultados coinciden en que el objetivo final de estos canales podría ser la monetización de los mismos. Tomás Arriaga, experto en marketing digital especializado en monetización y rendimiento de redes sociales y maldito, explica que, basado en los vídeos de esta red (que identifica como un “mix raro”), pueden tener como meta “aprender cómo ganar dinero en internet”. No sólo a través de YouTube. Como se ve en alguno de los vídeos sobre Pakistán, también usan herramientas como Shopify (una plataforma de comercio electrónico), nos indica Arriaga.

La red de canales aquí analizada no está, a 11 de febrero de 2026, monetizada. Sin embargo, como explica Rafael González, “la ausencia de monetización visible no implica ausencia de incentivo económico o estratégico”. El experto dice que estos canales parecen encontrarse en “una fase de acumulación de valor, en la que lo relevante no es el ingreso inmediato sino la construcción de un activo reutilizable”. Además, asegura, mantener el canal sin monetizar “reduce la visibilidad ante los sistemas de control de la plataforma y permite operar más tiempo sin interferencias”.

Varios analistas políticos llevan meses denunciando la suplantación en vídeos de YouTube

Mearsheimer no es el único experto del que se han creado deepfakes en YouTube. En esta misma red de canales hemos encontrado decenas vídeos en español del gestor e inversor de fondos estadounidense Ray Dalio. En menor medida, han publicado vídeos de otras personalidades como Jack Smith, ex Fiscal Especial para el Departamento de Justicia de los Estados Unidos; Piers Morgan, periodista británico, víctima de deepfakes desde hace años; o Norbey Marin, psicólogo clínico y youtuber venezolano, entre otros. Todos ellos presentan también indicios de haber sido generados con alguna herramienta de inteligencia artificial. Como en los ejemplos protagonizados por Mearsheimer, ni los movimientos ni la voz del experto son naturales.

En enero de 2026, Yanis Varoufakis, economista y exministro griego, denunció en The Guardian que se estaba utilizando su imagen para hablar de temas políticos de actualidad como, por ejemplo, la situación de Venezuela. “Dicen cosas que podría haber dicho, a veces entremezcladas con cosas que nunca diría”, explicaba en el medio británico. En un primer impulso, cuenta, intentó que las plataformas (entre ellas, YouTube) los eliminaran, pero desistió: “Hiciera lo que hiciera, por muchas horas que pasara cada día intentando que las grandes tecnológicas eliminaran a mis dobles de IA, muchos más volverían a crecer”.

En diciembre de 2025, el historiador estadounidense Victor Davis Hanson dijo ser uno de los afectados. En un podcast de The Daily Signal explicó que había localizado publicaciones que utilizan falsamente su imagen, su voz y su entorno (copian el estudio desde donde está grabado ese mismo vídeo) para promover ideas que “nunca había expresado antes” y que “no comparte”. Según explica Hanson, estos canales “quieren utilizar a alguien que pueda tener un perfil más alto” para difundir sus ideas. Ese mismo mes, varios usuarios de redes sociales denunciaron también la existencia de un canal de YouTube con deepfakes del economista estadounidense Jeffrey Sachs.

“Los analistas internacionales reúnen condiciones especialmente favorables para este tipo de suplantación”, según explica Rafael González. Son personas con abundante material audiovisual público “lo que facilita la clonación de voz e imagen” y tienen un discurso reconocible y estructurado “que permite generar mensajes plausibles mediante modelos de lenguaje”, dice.

La tendencia al alza de este tipo de contenidos, en palabras del experto, “responde a la combinación entre la accesibilidad creciente de las herramientas de IA y la dificultad de las plataformas para reaccionar con rapidez ante abusos que no siempre cruzan de forma evidente los límites normativos”.

Maldita.es ha contactado con YouTube para preguntarle por el sistema de detección de estos vídeos pero a fecha de publicación de este artículo no hemos recibido respuesta.

En este artículo han colaborado con sus superpoderes el maldito Tomás Arriaga, experto en marketing digital, y Rafael González, miembro del Observatorio del Impacto Social y Ético de la IA (OdiseIA) y maldito que nos ha prestado sus superpoderes.

Gracias a vuestros superpoderes, conocimientos y experiencia podemos luchar más y mejor contra la mentira. La comunidad de Maldita.es sois imprescindibles para parar la desinformación. Ayúdanos en esta batalla: mándanos los bulos que te lleguen a nuestro servicio de Whatsapp,préstanos tus superpoderes, difunde nuestros desmentidos y hazte Embajador.