Seguramente al leer la palabra “CAFE” la mayoría piense en la bebida amarga que se bebe, habitualmente, de una taza. Sin embargo, en el lenguaje codificado de quienes pretenden evitar las restricciones de las plataformas y ensalzar a dictadores o a sus regímenes, tiene un significado muy diferente. Estas siglas se leen realmente como “Camarada Arriba Falange Española” y se utiliza como una forma encubierta de mostrar apoyo al franquismo. Como este, existen otros términos que se utilizan para referirse a Adolf Hitler, Benito Mussolini y el nazismo. Los términos codificados son sólo una de las estrategias para evadir las restricciones de las plataformas y poder lanzar desinformaciones y teorías conspirativas. También utilizan los memes para difundir ideas extremistas disfrazadas de humor y alcanzar a un grupo de población más jóven.

Este tipo de tácticas suponen un desafío para las plataformas. Muchas de ellas tienen reglas contra el discurso de odio o la exaltación de organizaciones extremistas violentas, pero la evidencia académica y los expertos consultados por Maldita.es reconocen que es un contenido difícil de identificar y moderar para las redes sociales en muchas ocasiones. Algunas de las recomendaciones que ofrecen los expertos, además de la regulación del contenido, son incluir enlaces a páginas externas con información fiable que el usuario pueda contrastar cuando buscan contenidos que pueden estar relacionados con la negación del Holocausto u otras teorías conspirativas, o entrenar procesos de inteligencia artificial para detectar contenido inapropiado de forma más automática, aunque los procesos automatizados tienen sus riesgos.

‘Pop Fascismo’: reescribiendo la historia en la era digital

Este artículo es el tercero de una investigación internacional llevada a cabo por Maldita.es (España) y Facta (Italia). El proyecto explora cómo mediante el uso de elementos contemporáneos de las redes sociales el discurso fascista consigue entrar en nuestro día a día en tres fases: normalización, aceptación e idolatrización.

Esta investigación ha sido posible gracias al apoyo de Journalismfund Europe.

Términos, hashtags y emoticonos: cómo escapan de las regulaciones de las plataformas

La UNESCO lleva años estudiando el lenguaje oculto, como son las palabras en clave que se usan para negar el Holocausto, y trata de promover que las plataformas actúen “para romper el ciclo de los algoritmos que amplifican activamente los contenidos que incitan al odio”, explican desde la institución a Maldita.es. “La dificultad de mantenerse al día con las palabras clave radica en que se basan en un repertorio léxico e ideológico en constante cambio”, añaden.

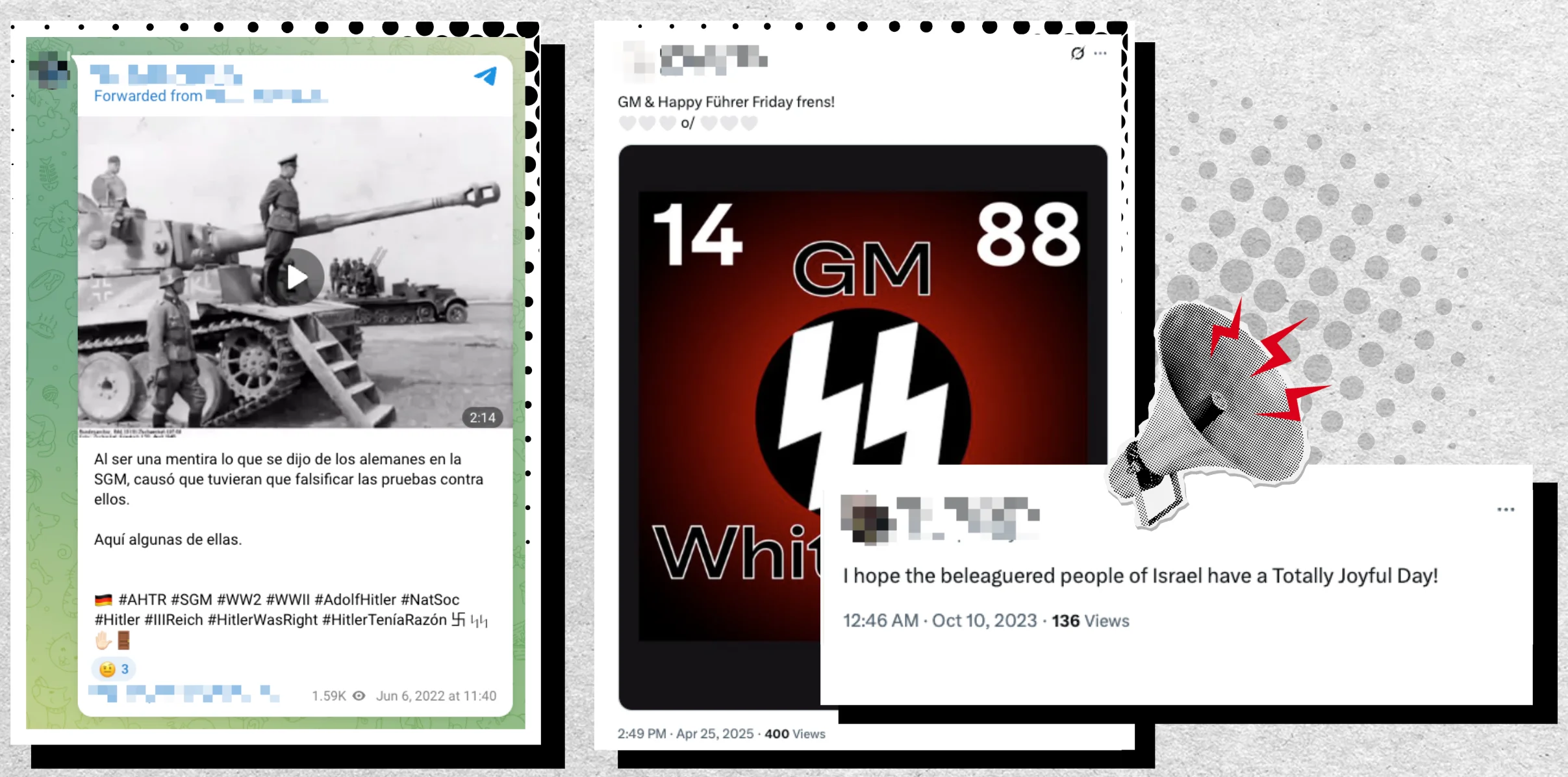

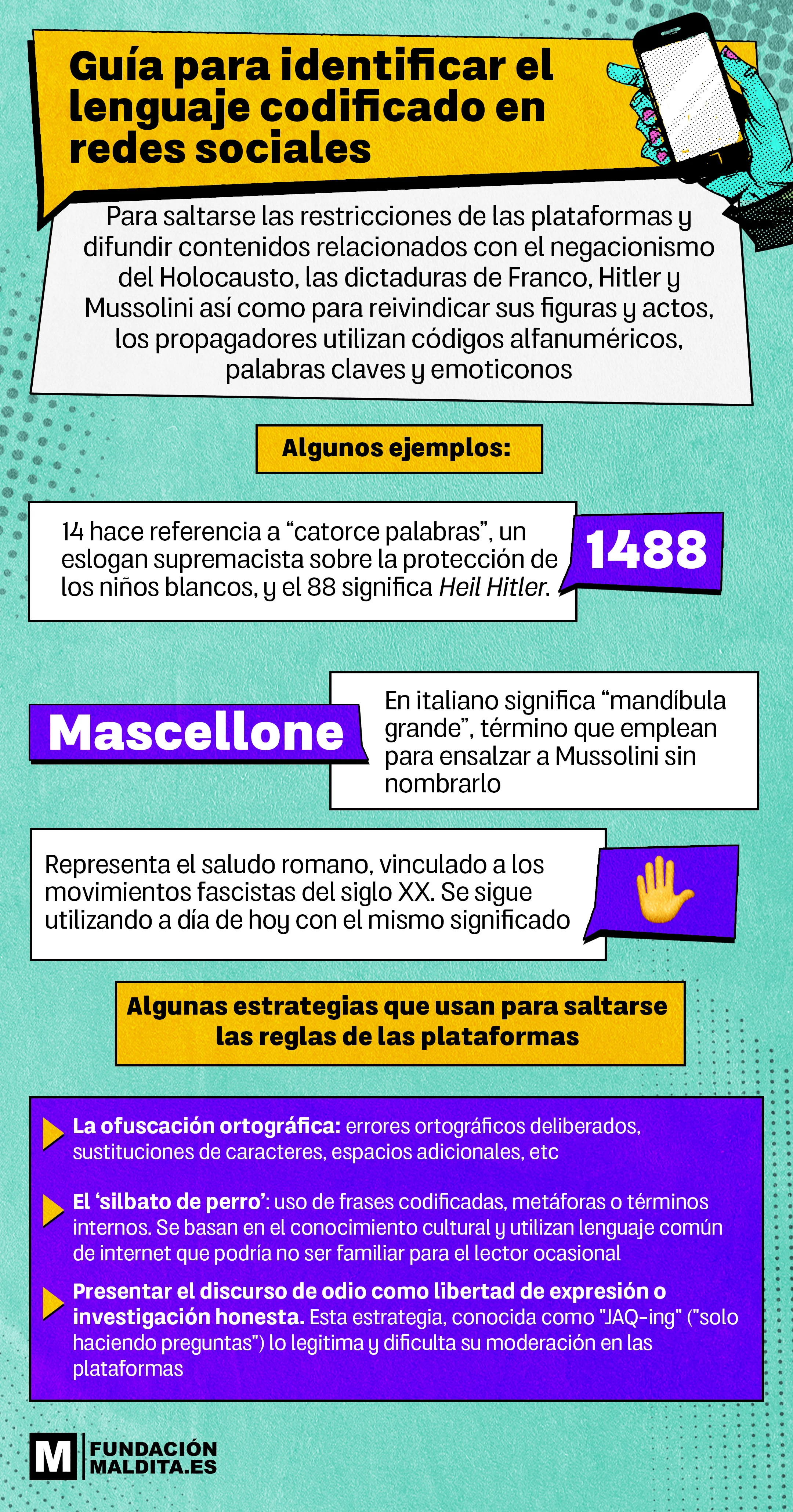

En el discurso considerado “antisemita” (prejuicio u odio contra el pueblo judío fundamento del Holocausto) difundido con palabras codificadas, se utilizan números como 1488, que hace referencia a un eslogan de la supremacía blanca sobre la protección de los niños blancos (conocido como “catorce palabras”) y al saludo alemán Heil Hitler (porque la h es la octava letra del alfabeto). También expresiones como “que tengas un día totalmente alegre”, que en inglés corresponde al acrónimo TJD cuyo significado es "muerte total de judíos".

Para negar la existencia del Holocasto, a pesar de la amplia evidencia documentada de su existencia, se utilizan términos como “Holocuento”, “Holoengaño”; o “Ana Fraude” para hacer referencia a Ana Frank, la niña judía víctima del Holocausto conocida por haber escrito un diario en los dos años que pasó escondida en Ámsterdam. La UNESCO indica que el negacionismo ya empezó antes del fin de la Segunda Guerra Mundial “cuando los autores del genocidio intentaron esconder u ofuscar los crímenes”, por lo que recalca que “es importante comprender los recursos retóricos y las estrategias que utiliza el discurso negacionista del Holocausto”, para poder descifrarlas.

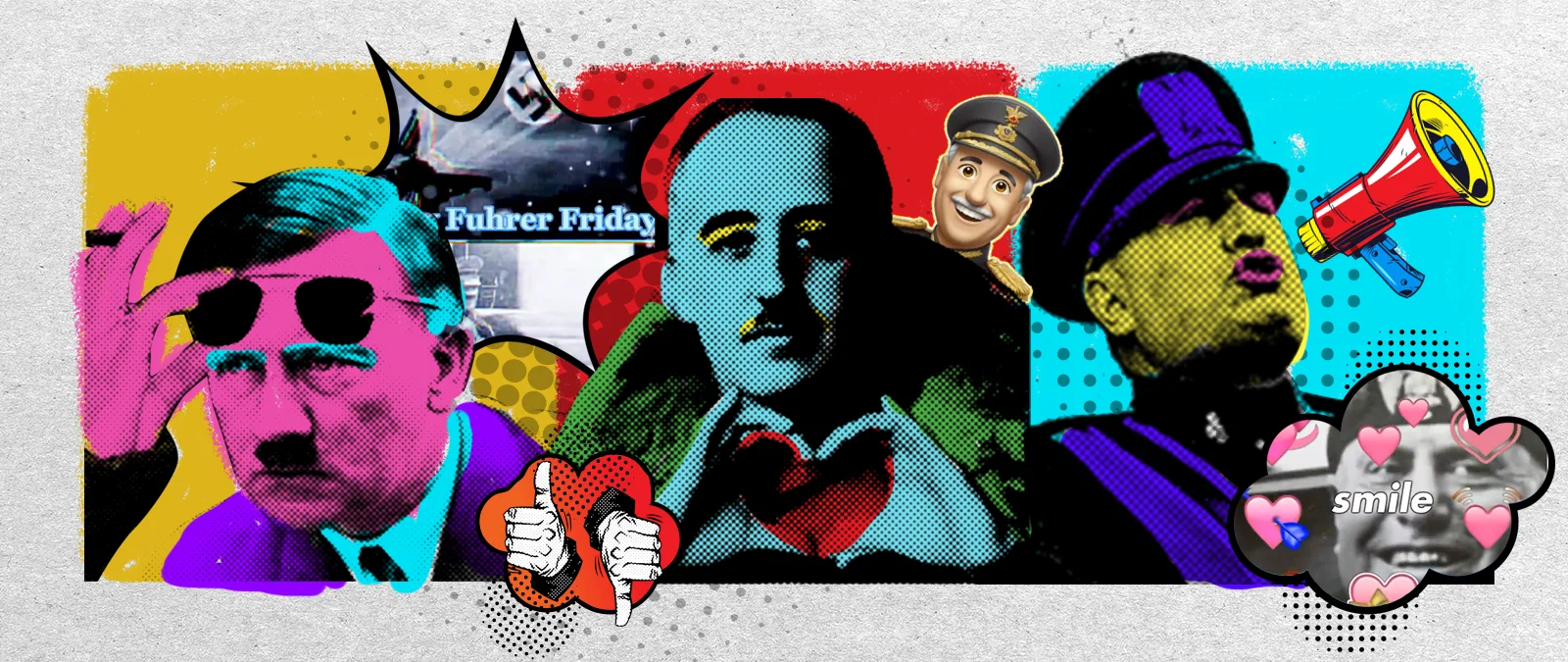

Existen también diferentes formas de hacer referencia a Adolf Hitler sin mencionarle de forma directa. Algunas de ellas son “pintor austríaco” (se dice que el führer quería dedicarse a la pintura, pero fue rechazado), “el bigotes”, “tío A” o con sus iniciales AH. Además, el hashtag #AHTR significa “Adolf Hitler tenía razón”.

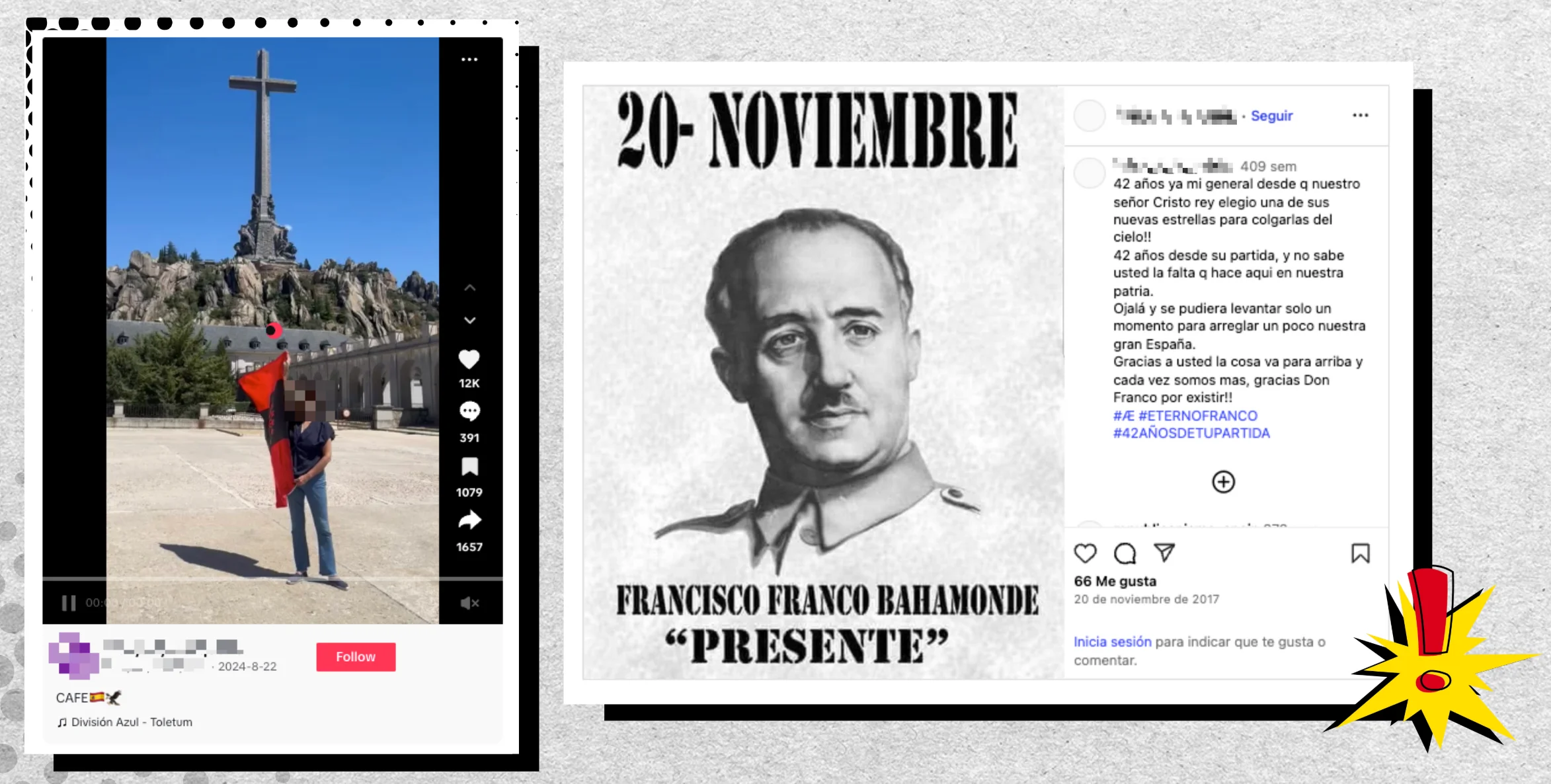

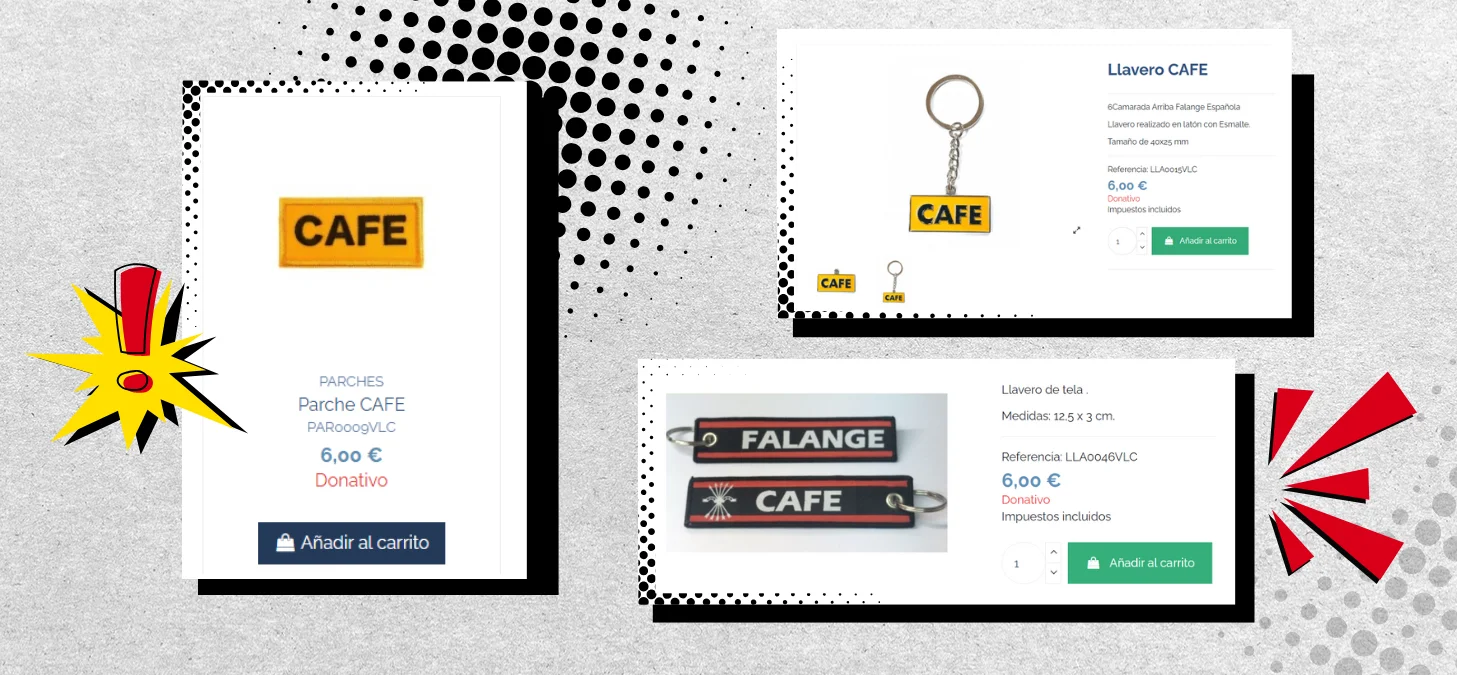

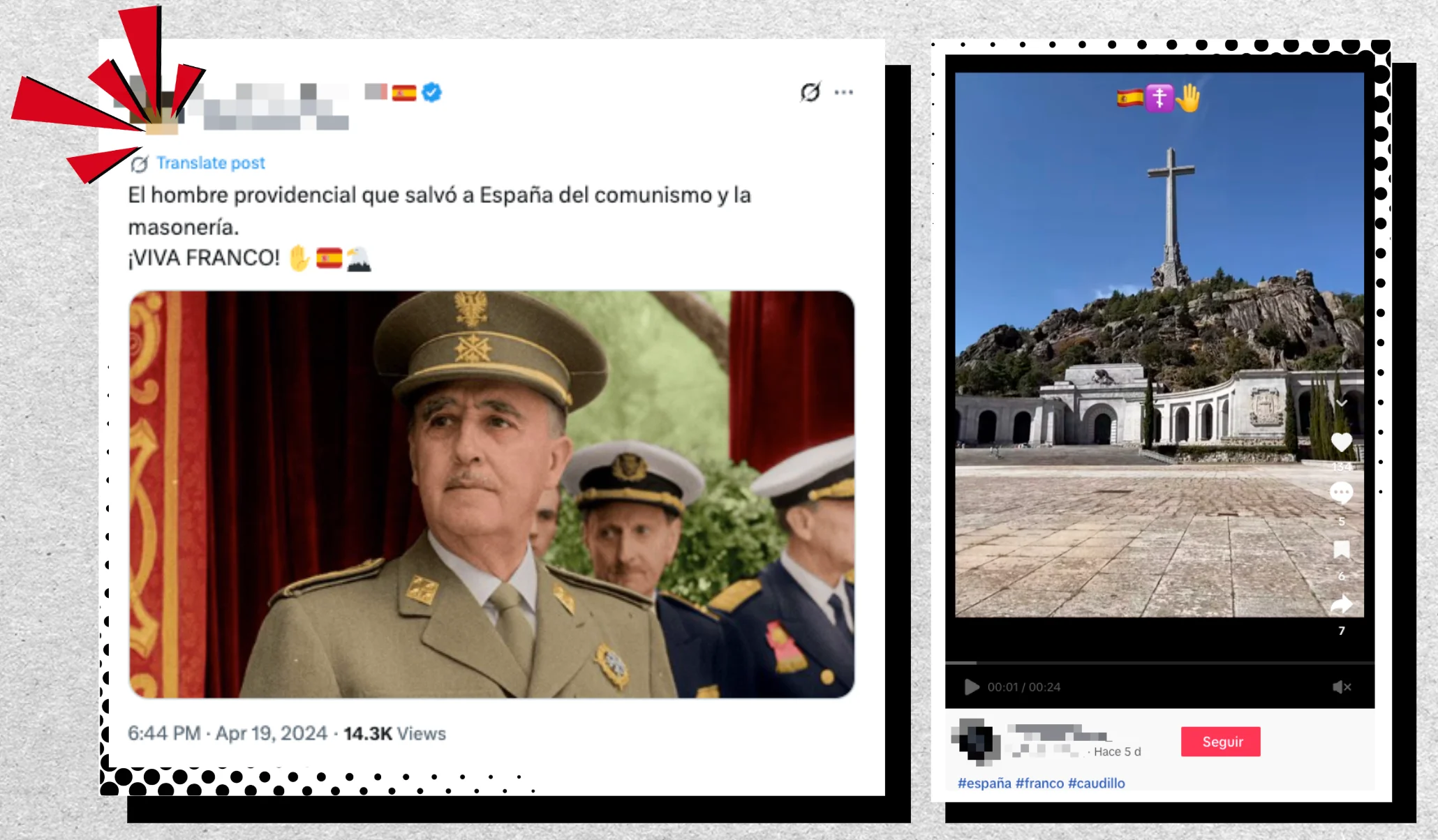

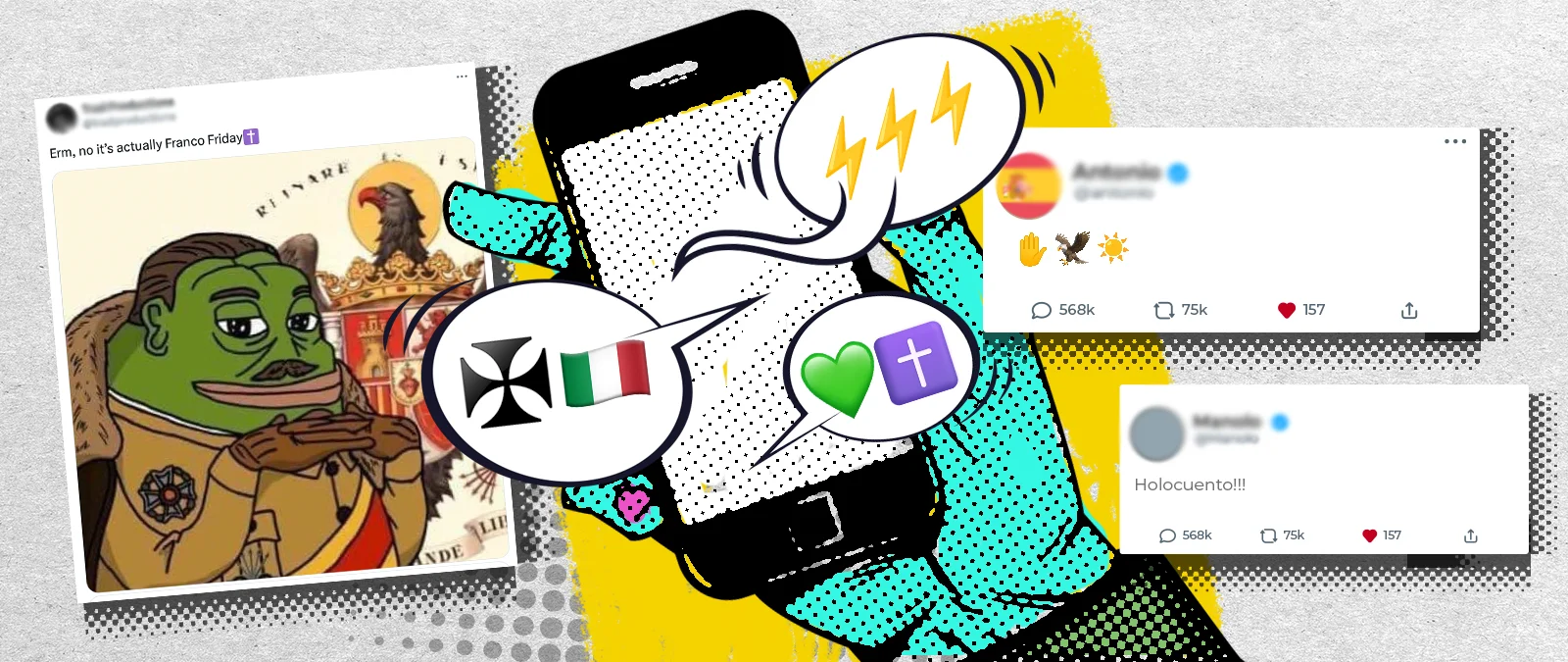

En el caso español, se utilizan códigos como CAFE (un lema falangista atribuido al general Gonzalo Queipo de Llano y a las órdenes de fusilamiento a los del bando contrario), abreviaturas como Æ (término sin uso en palabras del español que traducen como “Arriba España”, un grito falangista) o FF para hacer alusión a los Franco Fridays (expresión de origen desconocido que se utiliza para conmemorar la figura de Francisco Franco un día a la semana).

Del mismo modo, Benito Mussolini es conocido en Italia por una variedad de apodos, que son replicados en redes sociales para hacer referencia al Duce. Por ejemplo, Mascellone (Mandíbula grande); Pelatone (Cabeza calva); Crapa pelada (Cabeza calva, en dialecto lombardo); Gran Babbo (Gran papá), entre otros.

El uso de estas palabras no se limita a un lenguaje usado únicamente en internet. Hay quienes sacan rédito económico. En España, está al alcance de un clic encontrar tiendas que venden llaveros, parches, pegatinas o pines con las siglas CAFE por menos de diez euros.

Además de códigos alfanuméricos o términos codificados también se emplean emoticonos. Dentro del discurso antisemita, se refieren a los judíos como animales (🐀, 🐍, 🐷 y 🐙). Otro animal al que se recurre para aludir al nazismo o al franquismo sin mostrar símbolos prohibidos por las plataformas es el águila (🦅), empleada en la bandera de España durante la dictadura, y junto a la esvástica (conocida como Reichsadler o águila imperial alemana). Se utiliza la mano levantada (✋) para representar el saludo romano, un gesto vinculado con los movimientos fascistas, y los rayos dobles o triples (⚡️⚡️⚡️) para aludir a las SS, organización fundada por Hitler en 1925 para proteger a los dirigentes del partido nazi y que jugó un papel muy relevante en el Holocausto. También se utiliza el símbolo ᛋᛋ, que se corresponde con una insignia de las SS, y 卐, la esvástica, una cruz en forma de gancho adoptada como símbolo del partido nazi en 1920.

Inofensivos para quienes no los conocen, extremadamente cargados de significado para quienes pueden decodificarlos

Esas técnicas pueden resumirse en conceptos como “silbato para perros” (Dog Whistle). Al igual que la herramienta del mismo nombre diseñada para adiestrar a estos animales mediante el uso de ultrasonidos inaudibles (o al menos no totalmente audibles) para el oído humano, esta táctica tiene como objetivo comunicarse con un grupo más o menos restringido de adeptos utilizando un código de significados conocido sólo dentro del círculo interno, pero prácticamente incomprensible desde el exterior, salvo de forma muy superficial. La expresión se refiere, por tanto, a mensajes codificados que viajan por una doble vía, política y lingüística: inofensivos y vagos para quienes no conocen su significado real, extremadamente cargados de significado para quienes son capaces de decodificarlos.

Según explica la UNESCO a Maldita.es, existen otras tácticas para eludir la regulación de las plataformas, como la ofuscación ortográfica (por ejemplo, errores ortográficos deliberados, sustituciones de caracteres, homógrafos, espacios o signos de puntuación adicionales) y el signposting, que se refiere a publicaciones relativamente benignas que incluyen enlaces a plataformas marginales donde la falta de moderación permite contenidos más radicales y explícitos. También la multimodalidad, es decir, la combinación de distintos formatos o códigos en un mismo contenido (por ejemplo, el uso de palabras codificadas en un vídeo aparentemente inofensivo, lo que dificulta su detección automática); o el reframing, que “consiste en enmarcar el discurso de odio como libertad de expresión o investigación honesta”, según explican desde la institución.

“Esta estrategia, a veces denominada con el acrónimo 'JAQ-ing' (sólo hacer preguntas), no contraviene en sí misma el derecho a la libertad de expresión sino que explota las protecciones de ese derecho para crear una ‘negación plausible’ y desdibujar la intención, produciendo una zona gris donde los sistemas de moderación son menos eficaces”, añaden.

El uso de estas tácticas funciona como método que facilita la identificación entre personas con posicionamientos afines. El lenguaje oculto, difícilmente identificable para usuarios ajenos, funciona como una especie de contraseña: es una forma fácil para que quienes lo identifican se encuentren y manifiesten sus creencias compartidas. No obstante, también puede alcanzar a una audiencia general que puede terminar compartiéndolo involuntariamente con los mismos efectos potencialmente dañinos. Así, estos elementos se adaptan y migran rápidamente entre plataformas, colando los mensajes extremistas en las conversaciones cotidianas porque a primera vista “parecen inofensivos”.

Memes: una herramienta para disfrazar mensajes extremistas de “humor”

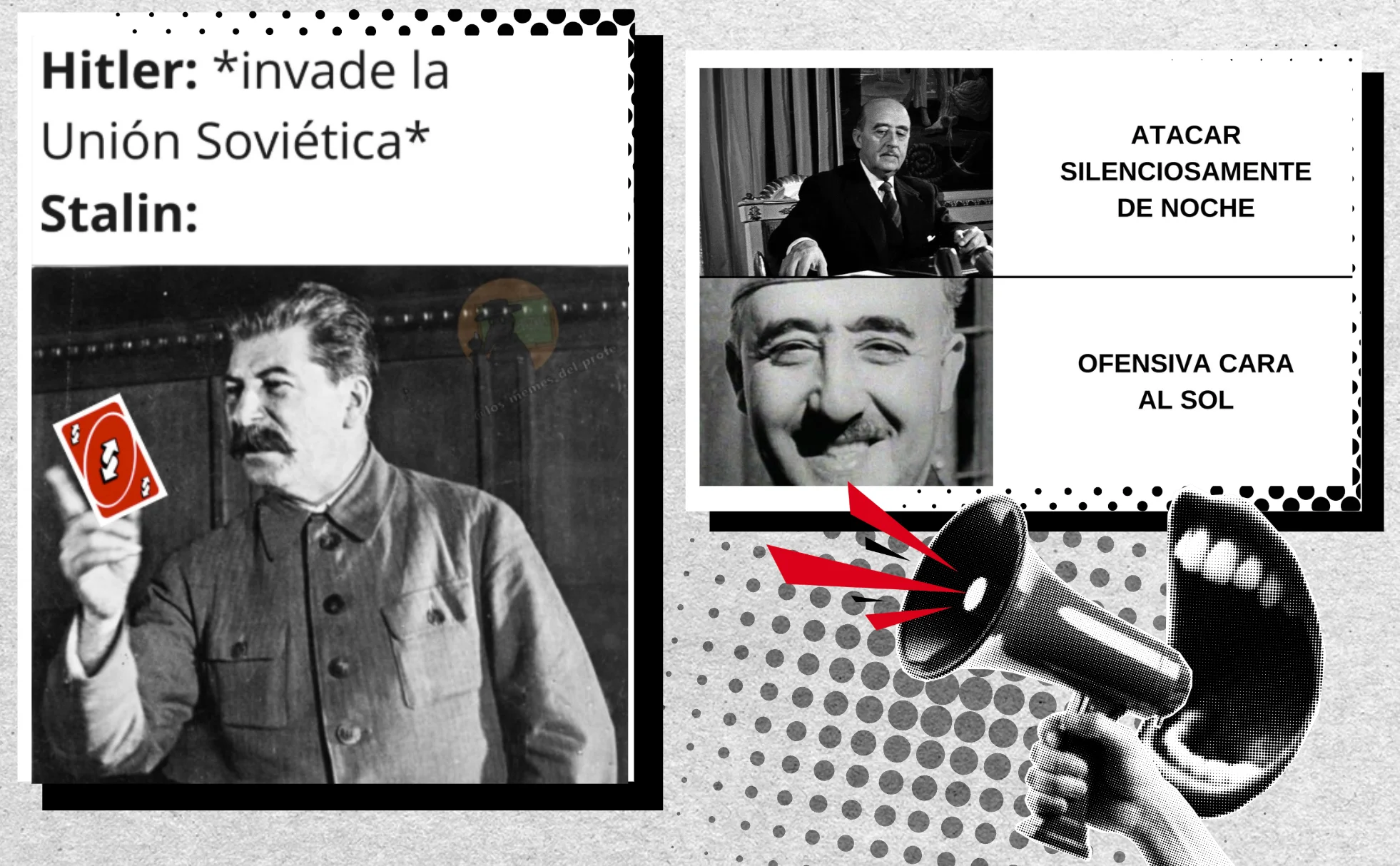

La propaganda en línea ha aprendido a utilizar los memes como elementos de un discurso más amplio, aprovechando la cultura pop “para comunicar mensajes de odio sin riesgo de exposición a las críticas”, explica el estudio Memes de extrema derecha: socavando y lejos de ser reconocibles del Ministerio de Justicia y Seguridad de los Países Bajos. De esta forma alcanzan grupos jóvenes entre los que “el mensaje simplificado de los memes puede despertar su interés” por unas ideas o contenidos más extremos.

Antes de difundirse ampliamente suelen compartirse en núcleos privados, pero lo hacen de una forma supuestamente humorística y sutilmente codificada, por lo que proporciona a los usuarios “distancia y negación, ya que siempre pueden alegar que sólo estaban bromeando”, según el estudio.

Para el analista senior en el Instituto para el Diálogo Estratégico (ISD por sus siglas en inglés), Richard Kuchta, es importante distinguir cuándo se trata realmente de humor y cuál es el objetivo de ese supuesto humor: “¿El humor sirve realmente para difundir la ideología o su objetivo es burlarse de ella y ridiculizarla? Son dos cosas diferentes”.

La estrategia de los memes y el “humor” ha sido reivindicado y promovido por figuras como Andrew Anglin, un neonazi estadounidense que en 2013 fundó el sitio web The Daily Stormer (un título que rinde homenaje al taloide semanal nazi Der Stürmer). En una guía que escribió y autoeditó en 2016, Anglin afirma claramente que “cuando se utilizan insultos racistas, hay que hacerlo de forma medio en broma, como cuando se cuenta un chiste racista que hace reír a todo el mundo porque es cierto. El tono debe ser ligero”.

La máxima expresión de esta filosofía fue un meme: Pepe the Frog, una rana antropomórfica que durante varios años fue la mascota oficial" de la extrema derecha estadounidense. Nacido como protagonista de una tira cómica, Pepe se convirtió primero en un meme inofensivo pero alrededor de 2015 comenzaron a circular imágenes de la rana con uniforme de las SS, asociadas a símbolos nazis y acompañadas de eslóganes antisemitas y negacionistas del Holocausto. Con el tiempo, el meme se asoció indisolublemente a Donald Trump, quien en 2016 retuiteó una imagen suya disfrazado de la rana.

Es difícil atribuir las consecuencias del uso directo de un meme específico, dice el análisis Los memes como arma en Internet, sin embargo, pueden contribuir a provocar “una serie de efectos indirectos o graduales” como la normalización de determinados posicionamientos, la formación de grupos e identidades y la inspiración para acciones extremistas, añade.

Desde 2007, la web knowyourmeme.com recopila, clasifica y explica los memes más virales, haciéndolos accesibles al público en general. Una búsqueda por palabra clave en este sitio puede ayudarnos a comprender el significado de estos y permitirnos encontrar la clave para evitar ser víctimas de la desinformación. Por ejemplo, explica cómo el famoso meme de la rana Pepe comenzó siendo usado por la cantante Katy Perry en 2014 para quejarse del cansancio del jet lag, a Donald Trump en 2015, antes de ser presidente de Estados Unidos, donde aparece una ilustración de la rana como si fuese él mismo de pie en un podio con el sello del presidente del país, o la Embajada de Rusia en el Reino Unido en 2017, que lo usó como reacción a una reunión entre la que era la primera ministra del país, Theresa May y Trump, que acababa de ser elegido presidente de Estados Unidos.

El acceso a fuentes de información fiables como solución en las plataformas para hacer frente a la difusión de estos contenidos

En general, las plataformas no contemplan en sus normas de comunidad limitaciones explícitas para este tipo de contenido, pero sí dicen restringir las publicaciones que fomenten discursos de odio (véase Instagram o TikTok). Es decir, afirman no eliminar, por ejemplo, los contenidos que hablen de Hitler si es contenido de carácter histórico o académico, pero sí dicen eliminar aquellos que hagan apología del antisemitismo o de la ideología nazi.

El estudio Silbatos digitales para perros: el nuevo lenguaje online del extremismo afirma que los procesos destinados a identificar contenidos en redes sociales “no son lo suficientemente eficaces para prevenir la difusión de publicaciones de odio de forma preventiva”, por lo que las plataformas “siguen dependiendo de las denuncias manuales para eliminar los contenidos ya subidos”. Las labores de moderación se complican todavía más en el caso de los memes porque “se presentan de forma ambigua o codificada”, según el análisis Los memes como arma en Internet. “Incluso en los casos en que la ambigüedad y el humor están lejos de ser obvios, proteger a las personas es problemático porque las intenciones y los efectos son difíciles de demostrar”, explica el informe.

Un análisis realizado en 2020 por el Instituto para el Diálogo Estratégico (ISD) mostró cómo el algoritmo de Facebook (propiedad de Meta) promovía activamente contenidos que negaban el Holocausto. Al escribir la palabra “Holocausto” en la función de búsqueda de Facebook, aparecían páginas negacionistas, y el Instituto identificó al menos 36 grupos de Facebook, con un total de más de 366.000 seguidores, donde se negaba el genocidio judío. Otro informe de la misma institución encontró que TikTok albergaba cientos de cuentas que apoyaban abiertamente el nazismo y utilizaban la aplicación de vídeo para promover su ideología y propaganda. El documento añadía que la plataforma no estaba “eliminando de forma adecuada y rápida esas cuentas” y que, cuando lo hacían, “ya habían pasado semanas o meses y el contenido había alcanzado a muchos usuarios”.

En Maldita.es también contamos cómo Grok, la IA de X, ha compartido contenido antisemita: se estaba usando para crear imágenes racistas, xenófobas y asociadas al nazismo protagonizadas por deportistas famosos, aumentando las posibilidades de que se creen contenidos desinformadores o que, sacados de contexto y compartidos en esta red social y en otras plataformas digitales, puedan generar desinformación directamente sobre personas reales.

Asimismo, encontramos que vídeos como los de Aitana o Quevedo manipulados, cantando Cara al Sol, que también pueden dar pie a desinformaciones, siguen activos en TikTok dos años después de haberse publicado sin ningún tipo de advertencia sobre su falsedad . Igual ocurre con un vídeo en el que se gasea a unas abejas en una farola con el hashtag #extermination, el cual lleva la marcha Erika, vinculada al nazismo por su uso en actos militares del Tercer Reich, a pesar de que TikTok afirma que “mensajes codificados que se usan en los grupos que infunden el odio para comunicarse entre sí sin parecer odiosos, como palabras clave, símbolos o tendencias de sonidos”, infringen las normas de la plataforma. Para el analista del ISD Richard Kuchta, “siempre hay maneras y soluciones alternativas que los extremistas suelen usar”. Y añade: “Es como un juego del gato y el ratón: la plataforma o los reguladores descubren un problema, crean algún tipo de mitigación y los actores maliciosos o extremistas encuentran la manera de eludir estas normas o las nuevas mitigaciones adoptadas por las plataformas”.

De esta forma, añade que “siempre que exista contenido claramente ilegal, las plataformas están obligadas a gestionarlo y eliminarlo”. Con la Ley de Servicios Digitales (DSA), “una vez que se les informa que alojan contenido ilegal, asumen la responsabilidad por dicho contenido”. Por lo tanto, según explica, lo que suele ocurrir en casos “claramente ilegales” es que el contenido se elimina. Insiste en que “esto no afecta a la libertad de expresión, ya que hablamos de contenido claramente ilegal”. La regulación europea establece medidas que cubren la eliminación (Art. 7) de aquellos contenidos que sean ilícitos. Es decir, publicaciones que comparten contenido ilegal (como la pornografía infantil, contenido terrorista, publicaciones que inciten al odio, venta de productos ilegales…).

Una de las recomendaciones de estudios como Silbatos digitales para perros: el nuevo lenguaje online del extremismo es entrenar procesos de inteligencia artificial “utilizando investigadores manuales para etiquetar los contenidos de odio y proporcionar un conjunto de datos más amplio con el que comparar todos los contenidos subidos”. De este modo se podrían detectar publicaciones inadecuadas que incumplan las normas de comunidad de las plataformas, aunque los procesos automatizados de moderación de contenidos también han creado problemas en el pasado. También aconsejan “ampliar la concienciación sobre el contenido de odio entre los usuarios y fomentar o incentivar su denuncia, ya que podría contribuir significativamente a los mecanismos de eliminación existentes”.

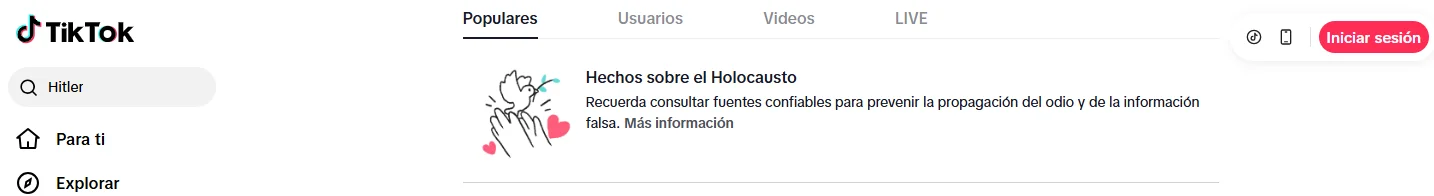

La UNESCO, en su estudio sobre la negación del Holocausto en redes sociales, sugiere incluir “etiquetas de verificación que redirijan a contenidos precisos y fiables”. Esta plataforma dice no permitir contenidos que nieguen o resten importancia “a acontecimientos históricos bien documentados que hayan supuesto un daño para grupos protegidos”, como por ejemplo negar la existencia del Holocausto. De hecho, cuando buscas “Hitler” o “nazi” en el buscador de la plataforma aparece un mensaje que dice: “Recuerda consultar fuentes fiables para prevenir la propagación del odio y de la información falsa” junto a un enlace a una página web de “Hechos sobre el Holocausto”.

No sucede lo mismo al buscar “Francisco Franco” o “Franquismo” en esta misma red social, donde se comparten contenidos con la imagen del dictador (incluso algunos con miles de visualizaciones). Kye Allen, doctor en Relaciones Internacionales e investigador en la Universidad de Oxford, asegura que una limitación a la hora de moderar contenidos es que no se utilizan los mismos procesos de identificación y moderación en diferentes idiomas.

Otro ejemplo: si buscamos “Kalergi Plan”, la teoría de la conspiración contra la Unión Europea que hace referencia a un complot de las élites internacionales para acabar con la “raza blanca”, TikTok no nos ofrece resultados, sino que aparece un mensaje: “Esta frase podría asociarse a comportamientos de odio”. Si hacemos la búsqueda en español, invirtiendo el orden de las palabras “Plan Kalergi”, aparecen múltiples vídeos donde se habla de la teoría.

Otra de las recomendaciones de la UNESCO es invertir en formación para los moderadores de contenido sobre temas como la negación y la distorsión del Holocausto y el antisemitismo. Allen coincide en que posiblemente los moderadores de plataformas como Tiktok “no siempre sean conscientes de algunas referencias históricas” muy concretas. Un ejemplo, según el doctor e investigador de la Universidad de Oxford, pueden ser los contenidos conmemorativos de la División Azul, los españoles que lucharon junto a Hitler durante la Segunda Guerra Mundial, contenidos que, asegura, pueden pasar desapercibidos por los moderadores.

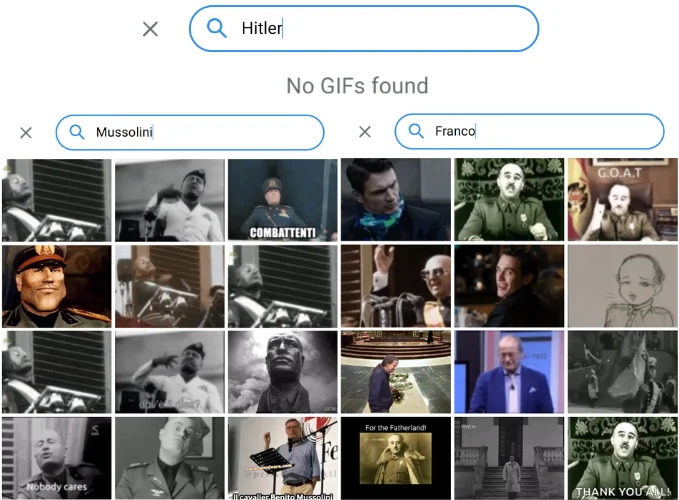

Maldita.es ha comprobado que, como norma general, las plataformas presentan más restricciones a contenidos que mencionan a Hitler o el discurso nazi que a otros dictadores o movimientos extremistas. Por ejemplo, en las conversaciones de Telegram se pueden utilizar gifs (un formato de imagen que se utiliza para crear animaciones cortas y repetitivas a partir de una secuencia de fotogramas) de Franco y Mussolini, pero no de Hitler, del que no hay resultados.

Metodología

Este texto forma parte de una investigación transfronteriza llevada a cabo por Maldita.es (España) y Facta (Italia) entre junio y octubre de 2025. El trabajo de estos meses se ha centrado en la recopilación de contenidos de seis plataformas así como de páginas web. En total se han registrado más de 500 contenidos, de los que hemos recopilado diferente información como: usuario, fecha de publicación, formato, lenguaje e impacto, entre otros. Se han seleccionado únicamente aquellas publicaciones que, de alguna forma, ensalzan a Francisco Franco, Benito Mussolini o Adolf Hitler, así como las medidas y políticas implementadas durante sus respectivos periodos de dictadura o la simbología asociada a las mismas.

Estos contenidos se han analizado de forma individualizada. De este análisis se han extraído los términos y emoticonos más repetidos, para después estudiar su posible significado oculto dentro de esta corriente. Se han consultado diferentes estudios académicos y publicaciones de expertos para conocer el significado de los mismos.

Si tienes cualquier duda, puedes consultarnos en [email protected].

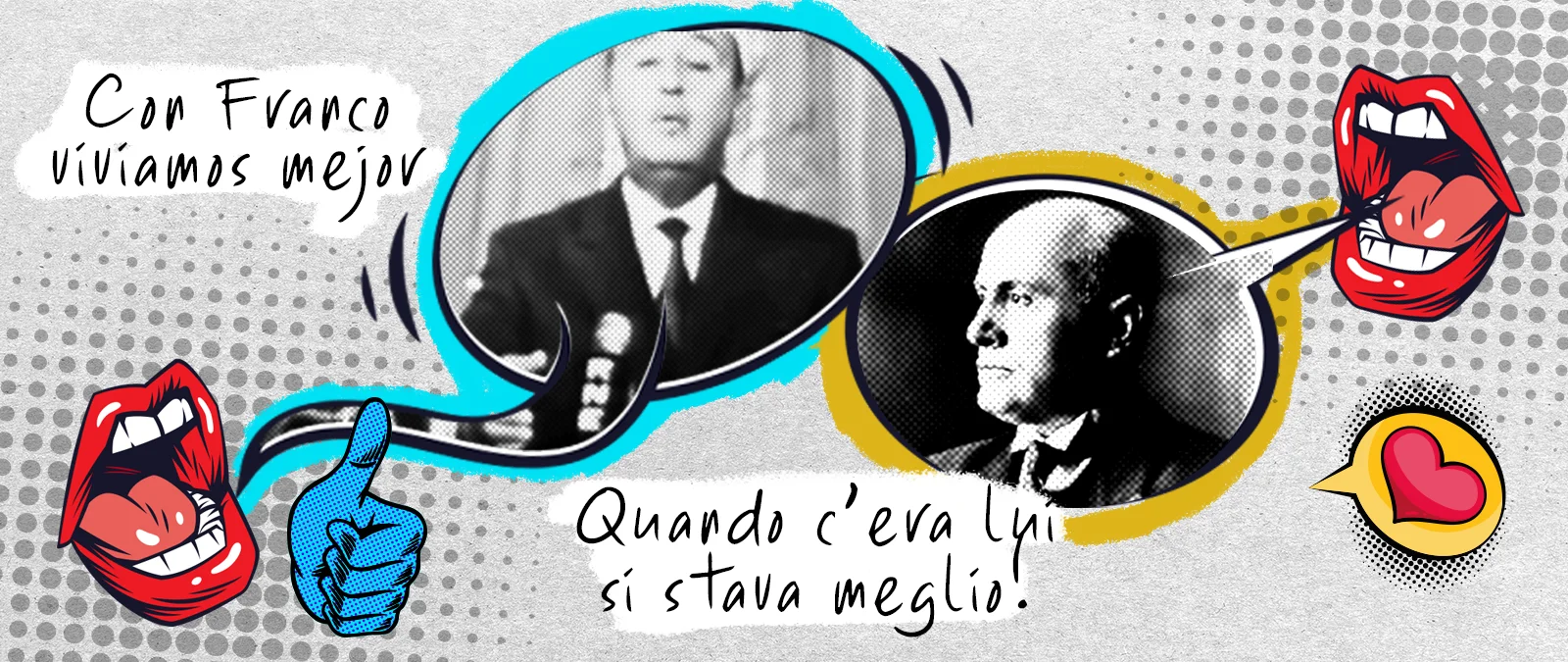

Memes, fútbol y canciones: cómo el ‘pop fascismo’ allana el camino para desinformar

Memes, fútbol y canciones: cómo el ‘pop fascismo’ allana el camino para desinformar “Con Franco vivíamos mejor”: la narrativa que triunfa en redes y que pretende reescribir la historia mediante desinformación y otras estrategias de manipulación

“Con Franco vivíamos mejor”: la narrativa que triunfa en redes y que pretende reescribir la historia mediante desinformación y otras estrategias de manipulación